马斯克狂揽H100,000元,自建世界最强AI超算,下一代模型训练开始

马斯克建立了世界上最强的AI集群!

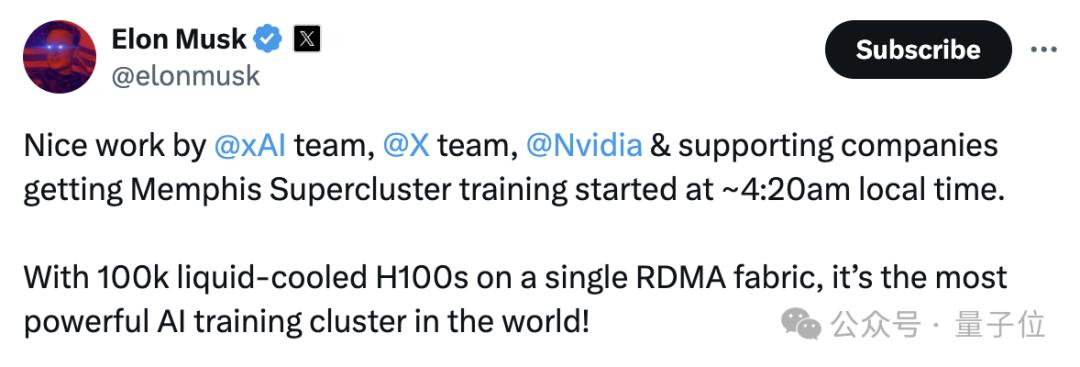

这个爆炸的消息,是老马亲自在推特上宣布的。

当地时间凌晨4:20,由xAI、孟菲斯非常集群已经开始投入训练,比如X和英伟达。

它由10万元H100构成,是当前世界上最强的训练集群!

这个规模已经远远超过了世界上最强的超算Frontier。

随后,xAI的创始成员表示:

一年前我们成立这家公司时,目标是实现三大优势:数据优势、人才优势和运算优势。

从今天开始,我们就拥有了这三者!

在马斯克的帖子下,它与英伟达密切相关,擅长液冷技术。(Supermicro)还送来祝贺。他的创始人查尔斯·梁说:

我很高兴我们和马斯克一起创造历史。

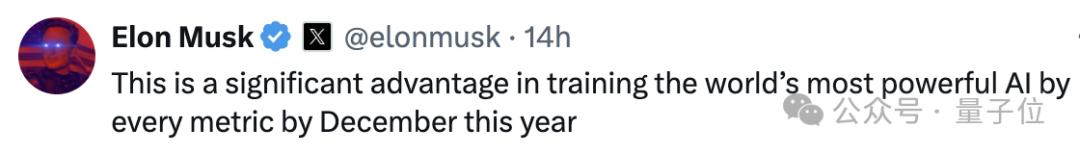

与此同时,马斯克补充说,这一集群的建成,为今年全球最强模型的训练提供了巨大的优势。

按照之前的说法,训练Grok-3需要10万张H100。

集群俯拍图

不仅如此,今年6月,他还提到,为H100投入1GW电力是不值得的。据估计,明年夏天将投入使用由30万元B200组成的集群。

自建集群更加自信

今年5月,The 据Information报道,马斯克将在2025年秋季之前建立一个由100,000H100组成的超级计算集群,并与甲骨文合作。

据报道,xAI将投入100亿美元用于租赁甲骨文服务器。

那时候还有人质疑,为什么明年要建成,还要用上一代技术?

在Blackwell基础上,英伟达推出了B100和B200的新结构,训练大模型的效率远远超过H100。

现在看来,也许是新闻里的时间出了问题?假使是今年的峻工就合理多了。

最近,马斯克回应了与甲骨文终止合作建设超算集群的消息。

在训练Grok-2方面,他指出xAI从甲骨文获得了24000个H100资源。有关消息证实,xAI与甲骨文的服务器租赁合作仍在继续。

但在100,000卡H100集群的建设中,选择了自建的方式,并以最快的速度推进,据说100,000卡安装仅需19天。

要自己掌握方向盘。

随后,戴尔和超微成为马斯克的新合作伙伴。

戴尔CEO、最近,超微CEO在推特上表示,他们正在与数据中心的图片合作。

马斯克亲自到现场进行集群建设。

而且还在推特上透露Grok正在孟菲斯训练,Grok-二将于八月推出。

值得注意的是,在此之前,甲骨文对集群峻工地的电力供应提出了担忧。

据估计,H10010万元需要从电网分配到150兆瓦电力,但马斯克似乎已经解决了这个问题。

根据最新消息,集群目前已暂时获得8兆瓦。在8月1日签署协议后,将获得50兆瓦。目前已有32000张卡片在线,第四季度将有100%在线-这足以支持GPT-5规模训练运行。

总而言之,毫无疑问,AI巨头们都认为,算率握在自己手中更可靠,所以值得疯狂烧钱。

根据成本估算,每个H100的价格大约是3-4万美元。马斯克的超级计算集群将达到40亿美元(相当于290多亿人民币)。

此前有报道称,微软和OpenAI正在制定一个名为“星际之门”的数据中心项目,耗资1000亿美元。

据知情人士透露,甲骨文和微软之间正在进行一笔交易,涉及到100,000元的B200。这个集群将在明年夏天准备好。

此外,例如Meta也被曝光为豪华超算集群,AWS等云厂商也在数据中心投入更多。

参考资料

[1]https://x.com/elonmusk/status/1810727394631950752

[2]https://x.com/elonmusk/status/1815325410667749760

[3]https://x.com/dylan522p//status/1815494840152662170

[4]https://x.com/MichaelDell/status/1803385185984974941

本文来自微信微信官方账号“量子位”,作者:明敏,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com