微软自研芯Maia 200登场,联手OpenAI剑指英伟达CUDA护城河,AI算力格局生变

微软自研AI芯片Maia 200正式落地数据中心,以3nm工艺搭配Triton软件,直击英伟达核心优势。作为英伟达的重要客户,微软此举不仅是为降低成本,更是试图打破CUDA在AI算力领域的垄断地位,一场围绕算力主导权的竞争已然展开。

2026年1月26日,微软在爱荷华州的数据中心发布了第二代自研AI芯片Maia 200,这一消息让英伟达创始人黄仁勋倍感压力。

微软此次推出的Maia 200,并非简单的新品发布,更像是全球最大买家对供应商的一次“反戈”。

当行业内还在比拼HBM显存容量时,微软另辟蹊径,凭借更实用的内存架构,向英伟达引以为傲的技术壁垒发起挑战。

特洛伊木马:OpenAI助力微软的关键武器

Maia 200采用台积电3nm工艺制造,硬件性能强劲,但真正让英伟达担忧的是与其一同发布的软件工具Triton。

在芯片行业,硬件决定基础性能,软件则影响最终的使用体验和效率,这是业内公认的规则。

英伟达多年来凭借CUDA生态锁定开发者,一旦更换芯片,代码重写的成本极高。

而微软此次推出的Triton,其核心开发者正是与英伟达关系密切的OpenAI。

据开发者测试,在Transformer注意力内核等场景中,使用Triton编写的代码量比CUDA减少75-90%,性能却能与CUDA媲美,部分场景甚至超出5-37%。

微软明确表示,开发者可以轻松实现迁移。

测试代码:https://github.com/leandrolcampos/flash-attention/

更值得注意的是,Meta和Google也在暗中发力。2025年底,Google与Meta合作推出TorchTPU,计划在2026年打破CUDA的垄断局面。

如果说Maia 200是高效的硬件引擎,那么Triton就是便捷的操作系统。

一旦开发者不再依赖CUDA,英伟达依靠软件生态获取的高额利润将受到严重冲击。

反杀背后的技术逻辑

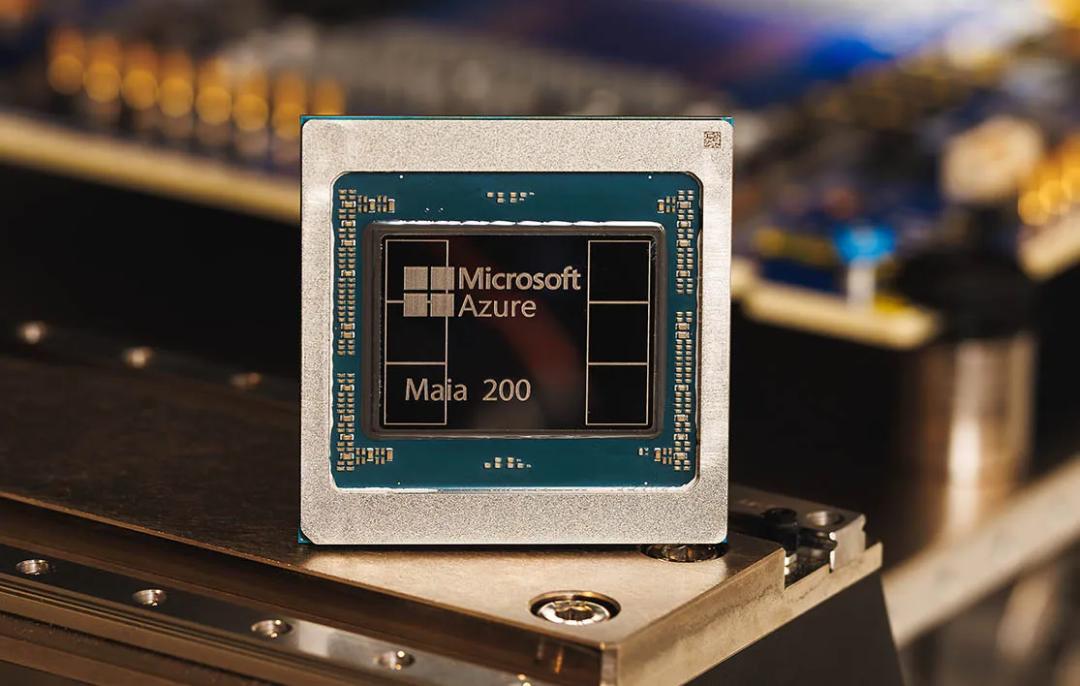

Maia 200的参数表揭示了其优势所在:芯片内置272MB的片上SRAM。

大模型训练阶段注重带宽,而推理阶段更看重响应速度。当亿级用户同时使用ChatGPT时,延迟问题成为关键瓶颈。

微软的解决方案直接有效:在芯片中增加SRAM容量,这一思路借鉴了Cerebras和Groq的设计理念。

最终,Maia 200在单次Token生成的经济性上表现出色,官方称其性能比现有硬件提升30%——在相同成本下,推理成本更低,效率更高。

英伟达的Blackwell系列仍在追求高端配置和高价格,而Maia 200则针对特定场景进行优化。

对于开发者而言,Maia 200或许不是速度最快的,但一定是性价比最高的选择之一。

合作关系的破裂

微软与OpenAI表面上合作紧密,实则各自有着不同的战略考量。

在Maia 200发布前夕,OpenAI宣布了一项100亿美金的采购计划,合作方并非微软,而是Cerebras。

OpenAI对此解释称,此举是为了实现算力来源的多样化,避免过度依赖单一供应商。

这一操作不仅让微软陷入尴尬,也让英伟达感受到前所未有的竞争压力。

为了弥补推理性能的不足,英伟达甚至紧急从Groq获得技术授权,以应对市场变化。

这场多方博弈如同硅谷版的商业大戏:

· 微软:在投资OpenAI的同时,大力发展自研芯片,降低对外部技术的依赖;

· OpenAI:在接受微软投资的同时,推动技术变革,还与第三方展开合作;

· 英伟达:面对客户的“叛离”,不得不斥资200亿收购Groq技术以自保;

· Google/Meta:在一旁观望,随时准备抓住机会扩大市场份额。

Maia 200的发布,本质上是微软对自身技术和成本控制的一次“证明”。对于微软CEO纳德拉而言,最可靠的合作伙伴并非OpenAI的Sam Altman,而是成本可控的3nm芯片。

纳德拉的“对赌协议”:9600万美金的激励

无论技术多么先进,在华尔街看来,最终都要回归商业本质。

Maia 200的成功与否,直接关系到纳德拉今年能否获得9650万美金的薪酬。

对于市值达4万亿的微软来说,降低成本就等同于增加利润。

每使用一块Maia芯片,微软对英伟达的依赖就减少一分,毛利率也会相应提升。

这不仅仅是技术层面的竞争,更是一场关于企业利润和管理者薪酬的“保卫战”。纳德拉显然不愿让微软成为为英伟达“打工”的角色。

微软2025年在AI基础设施上的资本开支预计将超过800亿美元。

这意味着,微软每向英伟达支付1美元的费用,其利润率就会受到一定影响。

对于4万亿市值的企业而言,哪怕是1%的成本降低,都能带来数百亿美元的价值提升。

在3nm芯片的背后,是纳德拉对“算力自主”的追求——他绝不甘心让微软受制于外部供应商。

AI算力圈的变革:从“训得快”到“回得快”

Maia 200的出现,标志着AI算力行业的竞争焦点发生转变。

前两年行业比拼的是模型训练速度,谁拥有更多的算力资源谁就占据优势;而2026年,竞争的核心转向了成本控制和推理效率,性价比成为关键。

英伟达凭借CUDA和HBM技术赢得了上半场,但在推理时代,Maia 200正在逐步削弱其高溢价优势。

Google TPU、Amazon Inferentia、Cerebras等产品纷纷进入市场,谁能将算力从“奢侈品”变为“日用品”,谁就能在竞争中胜出。

黄仁勋曾称CUDA是英伟达最坚固的护城河,但如今,这条护城河正面临被“抽干”的风险。

当最大的买家不再愿意为“品牌溢价”买单时,依靠硬件销售躺赚的时代或将终结。

Maia 200的出现,印证了一个道理:

在资本的驱动下,没有永远的技术壁垒,只有不断变化的市场需求和成本考量。

参考资料:

https://www.bloomberg.com/news/articles/2026-01-26/microsoft-unveils-latest-ai-chip-to-reduce-reliance-on-nvidia

https://www.reuters.com/business/microsoft-rolls-out-next-generation-its-ai-chips-takes-aim-nvidias-software-2026-01-26/

本文来自微信公众号“新智元”,作者:新智元,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com