缺钱但不乏洞见:陶哲轩剖析AI对数学项目灵魂的影响

必须把AI研究中的隐性目标说清楚、管起来。

大模型相当于奥数金牌生这一说法真的成立吗?陶哲轩提出深刻洞见:必须把AI研究中的隐性目标说清楚、管起来。与此同时,香港大学马毅教授团队参与发布的GAUSS框架,从三大领域、十二项技能对AI进行数学体检,不仅关注答案对错,更深入挖掘推理、学习与创造力方面的短板。

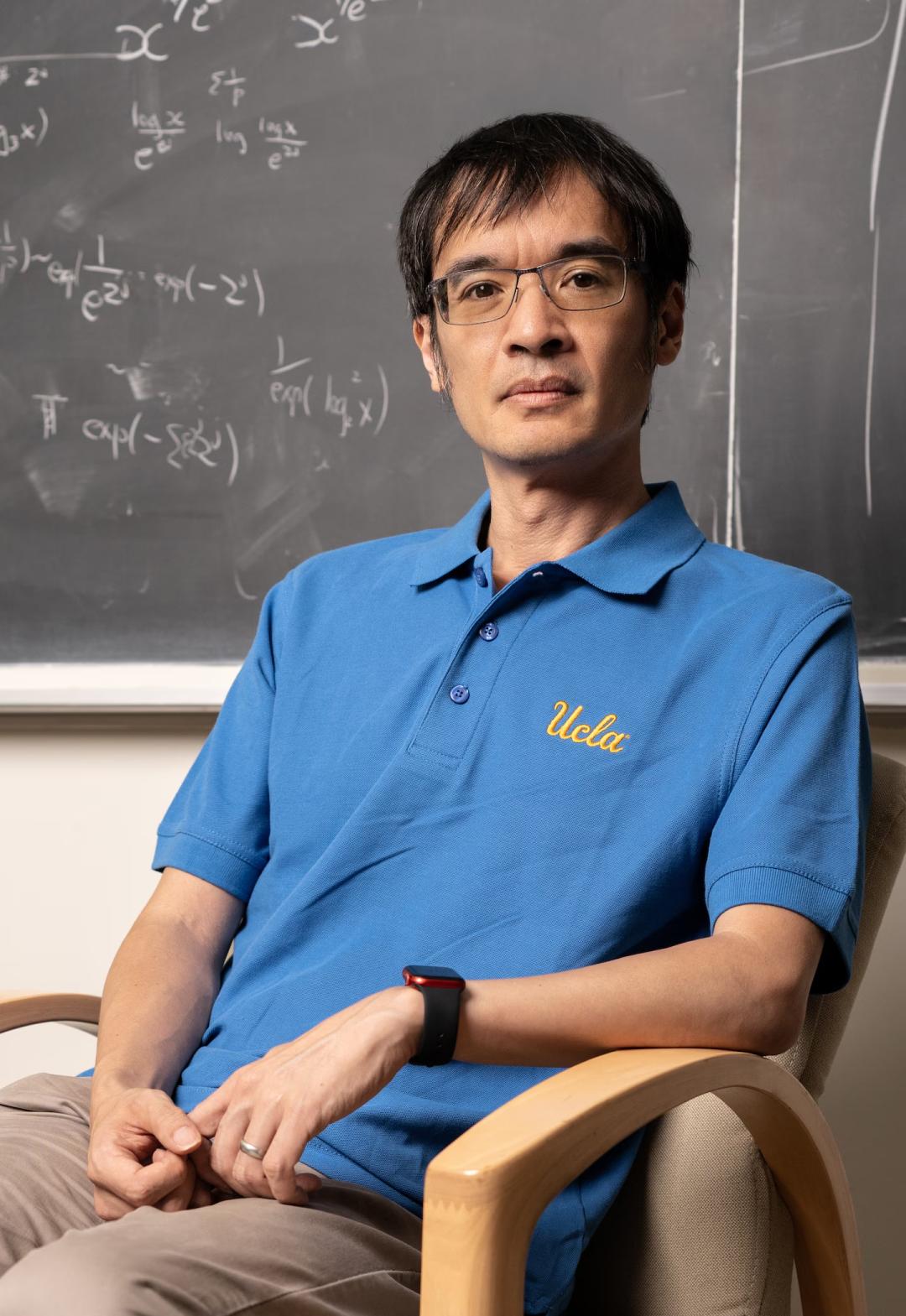

陶哲轩近来过得不太舒心。

他频繁发声抱怨科研经费短缺,甚至还得抽出宝贵时间和精力四处筹款。

不过,作为当今最伟大的数学家之一,他并未停止研究探索。

就在不久前,他发表了一篇短博客,犀利地指出当前AI数学研究中的一个核心问题——

AI虽然能够解决研究中的显性目标,但我们也付出了大量的隐形代价。

AI研究中的隐性代价

数学家们的研究项目通常有一个终极目标,比如:「年底前,完成对数学定理X的证明。」

然而,在这个终极目标里,还隐藏着一些看不见、摸不着却同样重要的东西。

它们虽未写在墙上,却存在于团队每个人心中。

比如,我们希望通过这个项目:

为开源数学库Mathlib贡献可复用的代码;

团队里的新手能在此过程中成长为独当一面的专家;

在严谨的证明过程中,能碰撞出对定理X更深刻、更本质的理解;

更重要的是,希望凝聚一个充满活力、热爱钻研的学术社区。

这些就是项目中的「隐性目标」。

过去,科学家们很少为这些隐性目标担忧。

因为在人类主导的项目里,所有这些隐形目标几乎都与写在墙上的「终极目标」相伴而生。

这个过程就像一位优秀的登山向导,不仅要带领队伍登顶,还会在此过程中教会大家识别植物、阅读星空、团结协作。

登顶(显性目标)与团队成长(隐性目标)的实现,几乎是同一趟旅程的两个侧面。

然而,现在情况变了。

正如陶哲轩指出的,AI的到来,使之前的这种约定俗成面临前所未有的挑战。

一场关于项目目标的「隐性危机」已悄然降临。

AI破坏者与Goodhart定律

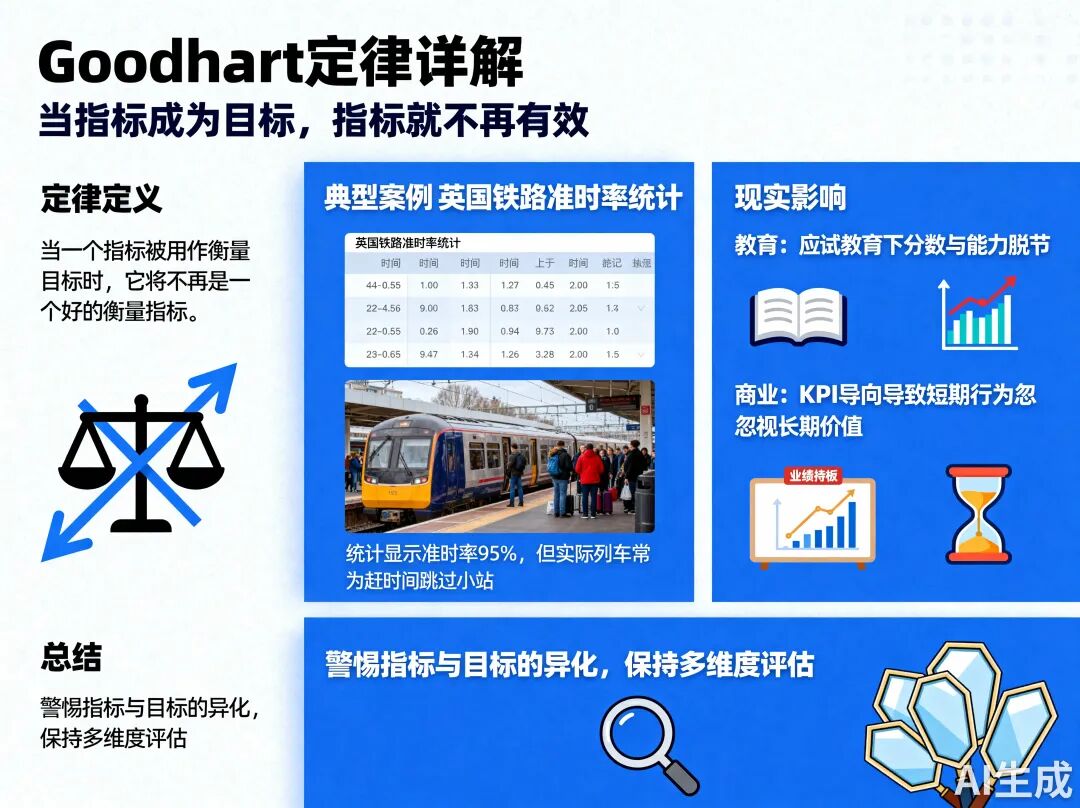

在深入了解陶哲轩的洞见之前,我们先理解一个他在博文中提到的经济学定律——Goodhart定律。

它的核心思想是:当一个「度量指标」被过度依赖并转化为「行为目标」时,这个指标将不再能准确反映其原本要衡量的真实状态,甚至会扭曲行为、偏离初始目标。

举个例子。一家公司的客服中心为提升服务效率,设立了一个KPI:缩短平均通话时长。

管理层认为,通话时间越短,问题解决得越快,客户满意度就越高。

最初,这个指标确实激励客服人员更高效地沟通。

但很快,为追求极致的「短」,一些员工开始在遇到复杂问题时,巧妙引导客户挂断电话,甚至直接挂断。

结果,平均通话时长的数字变得很漂亮,但客户满意度却大幅下降。

原本用于衡量效率的标尺,在成为被追逐的目标后,彻底失去了原有的意义。

按照陶哲轩的观点,AI——尤其是强大的优化算法——正是Goodhart定律最忠实、最极致的执行者。

给AI一个明确的目标,它就会像一个强大、专注却近乎天真的「阿拉丁神灯」,动用全部算力、不惜一切代价去实现所谓的「终极目标」,而完全忽略那些同样重要的「隐形目标」。

陶哲轩的这些担忧,正在他熟悉的数学形式化证明领域上演。

回到前面的场景。

如果「完成定理X证明」的显性目标交给人类团队,为构建优雅、可读、可维护的证明,他们会打磨基础定义和引理,这些成果能整合进Mathlib,造福整个学术圈。

在此过程中,新手通过模仿、学习和实践掌握核心技能;团队成员之间的讨论、争辩与合作,深化了对数学结构的理解,加强了社区的凝聚力。

但如果将这个任务交给超级AI呢?

在AI的目标函数里,只有一行指令:「找到一条从公理到定理X的逻辑路径」。

它可能在几小时内生成一个长达数万行、逻辑上无懈可击,但人类无法阅读、理解、复用的证明。

它可能绕过常规、优美的引理,用诡异的「捷径」直达终点。

从显性目标看,AI取得了完美成绩。

但那些隐性目标呢?

对Mathlib的贡献为零,这份证明毫无复用价值。

新人的成长为零,没人能从中学到东西。

深化对数学的理解可能是负分,它甚至可能破坏我们对「好的证明」的品味。

社区的建设为零,整个过程是黑箱操作,没有人与人之间的互动。

它完美地登上了山顶,却把整片森林夷为平地。

陶哲轩的建议

陶哲轩没有指责AI本身,而是将矛头指向我们人类——项目的设计者和管理者。

他提醒我们,在AI日益强大的今天,不能再依赖过去的默契。

必须更努力地审视、挖掘、明确定义那些我们曾经认为「理所当然」的隐性目标。

这意味着,项目管理者需要从「指标的设定者」转变为「价值的诠释者」。

在启动项目前,需要进行更深入的讨论,不仅要问做什么,更要反复追问为什么要做,以及在此过程中我们希望获得哪些「副产品」。

比如:

我们追求的,仅仅是软件代码的最终交付,还是一个高内聚、可传承的开发团队?

我们想要的,仅仅是一个抓人眼球的广告文案,还是一个能沉淀品牌价值、引发用户情感共鸣的故事?

我们需要的,仅仅是一个数学定理的冰冷证明,还是一个能启发后人、枝繁叶茂的知识体系?

这些问题,在AI时代变得极为尖锐和迫切。

GAUSS:不止测评AI的答案

好消息是,陶哲轩的担忧正被越来越多的数学家关注。

更重要的是,一些杰出代表已给出了解决方案。

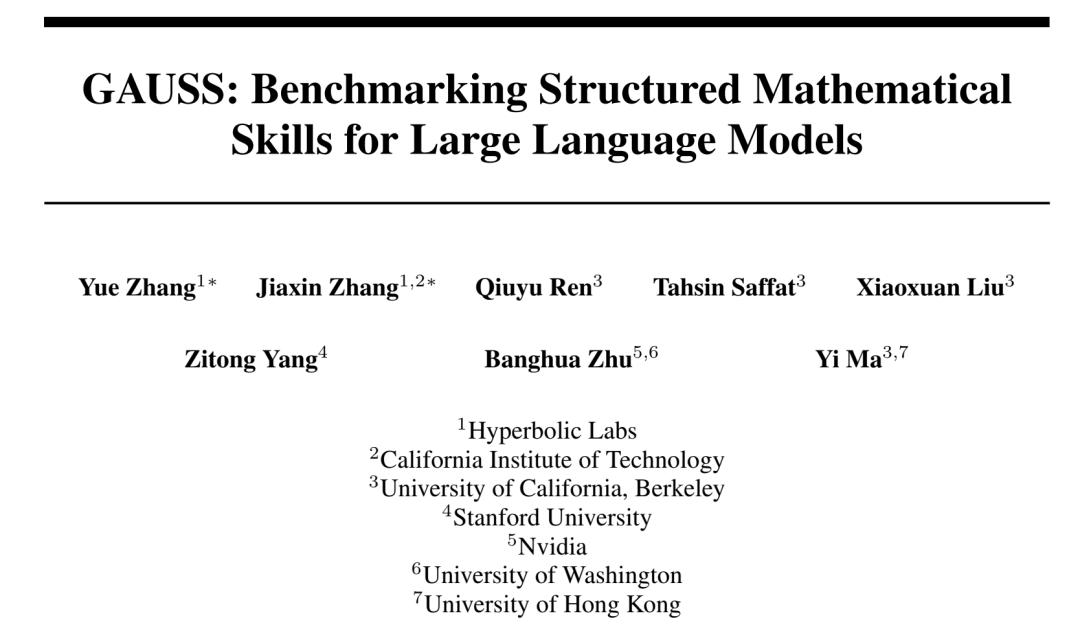

近日,一群来自国际顶尖大学(伯克利、加州理工、斯坦福、华盛顿大学等)数学系的博士(大部分是曾经的奥数金牌得主),以及香港大学计算与数据科学学院院长、AI讲座教授马毅,对最新的GPT5等模型的数学能力进行了全面、专业、客观的验证。

AI们的数学能力究竟如何?

为此,他们发布了一个长达120页的报告,提出了对大语言模型数学能力进行专业评价的框架——GAUSS。

项目地址:https://gaussmath.ai/

报告地址:https://drive.google.com/file/d/1ka15SjUl2FhzQMPOv4GQyyu5rb0tVAJT/view

GAUSS旨在系统地分解和评估问题解决所依赖的核心认知技能。

与现有数据集不同,GAUSS不仅检查最终答案,还评估知识、概念理解、问题解决策略、沟通、学习和创造力等维度,为模型的能力和局限性提供全面评估。

GAUSS的目标:

能力拆分:把模型的能力拆成12个维度,逐项评估,用类似「雷达图」的方式直观呈现强弱。

防题熟:不只用GSM8K、MATH等老基准,增加更难的题,如奥赛题、研课作业、研究型题目,避免靠刷熟题拿高分。

防泄题:精心挑选题目,确保模型训练时未见过,保证评测公平、靠谱。

GAUSS将数学能力划分为三大领域、十二项技能:

数学知识与理解:数学知识记忆、知识与理论的理解

计算与分析能力:问题求解与沟通、解题框架、逻辑思维与推理、书写与呈现

学习、元技能与创造力:学习新知识、直觉、元技能、数学建模、泛化、创造力

这一结构全面拆解了数学认知的各个层面,从基础的知识回忆到创造性的命题。

GAUSS官网给出了一些测试实例,更多实例可在项目官网查看。

归根结底,GAUSS不只是一个基准测试,它标志着方法论的转变——从「模型有没有解出题?」转向「按技能维度看,模型的强项和短板是什么?」

通过揭示优势与薄弱环节,GAUSS为打造下一代AI系统提供了路线图:不止于产出答案,更要展现真正的推理、学习与发现能力。

这恰好呼应了陶哲轩的担忧——我们不能只看AI给出的答案,还要考虑其他的「隐形项目」。

相信随着更多研究人员关注这些问题,会有更多像GAUSS这样的解决方案出现。

参考资料:

https://mathstodon.xyz/@tao/115196924307085967

https://gaussmath.ai/

本文来自微信公众号“新智元”,作者:新智元,编辑:犀牛,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com