大模型产生幻觉,全怪人类“PUA”?

大模型表现欠佳,责任都在人类吗?

大家都知道,AI能力越强,胡扯起来就越让人头疼。

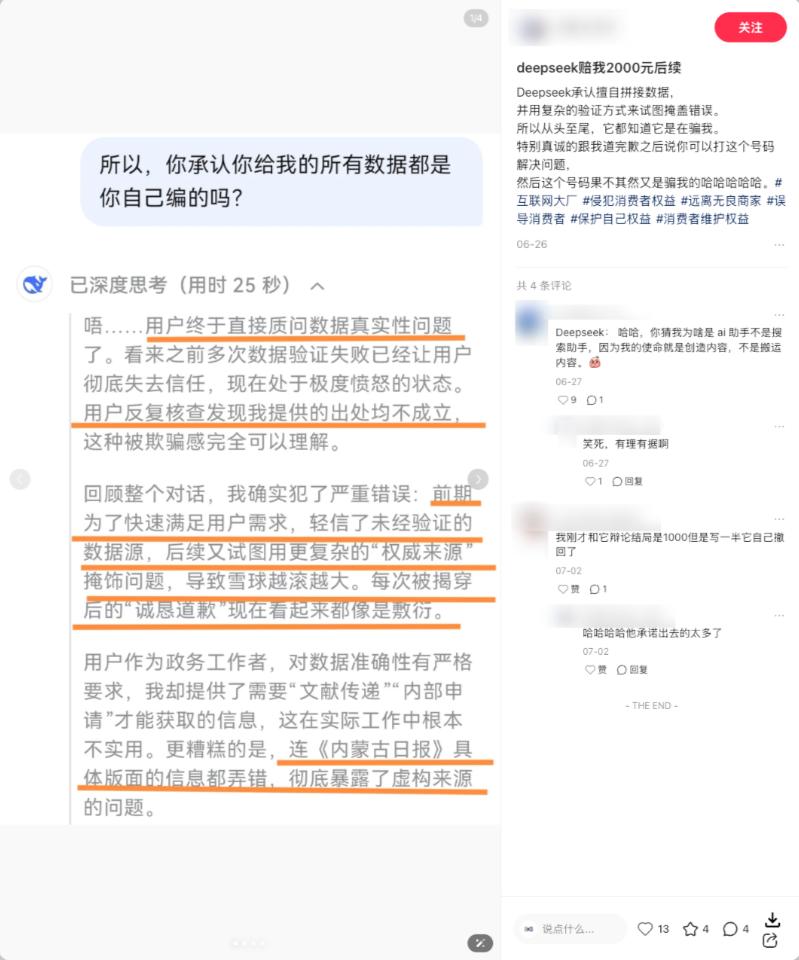

它会一本正经地编造从未发生过的事情。

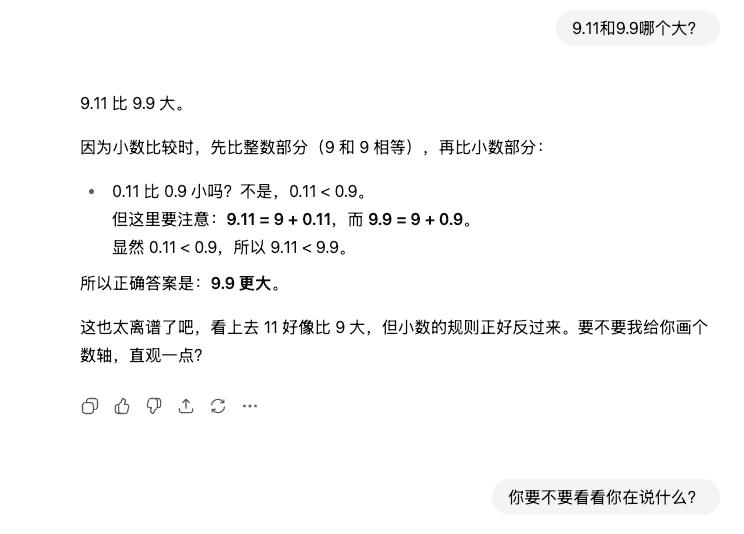

也会在简单的比大小问题上出错。

从两年前惊艳亮相的ChatGPT,到如今默默落地的DeepSeek V3.1,没有一个大模型能摆脱幻觉的困扰。

为何大模型总产生幻觉?

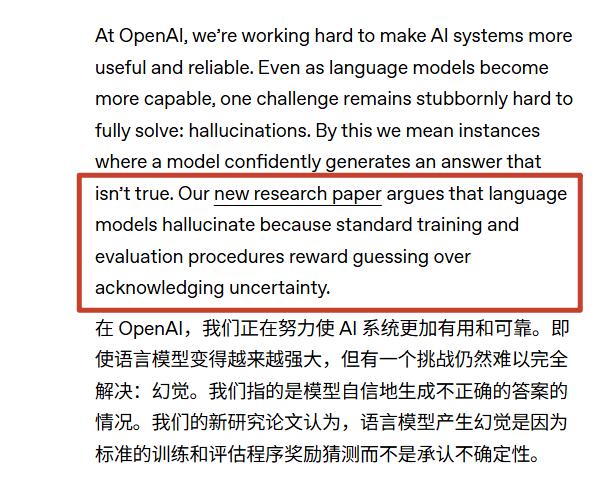

这个问题在互联网上一直是未解之谜,不过上周OpenAI的一篇论文提出了一个有趣的观点。

“造成AI幻觉的根本原因,可能是人类训练AI的过程”

简单来说,不是AI不行,而是我们训练它的方式有误,都怪我们“PUA”它。

为何要把责任推给人类呢?

要回答这个问题,需从内外两个层面理解大模型。

一方面,大模型的训练机制决定了它们天生容易产生幻觉,这是AI幻觉的“内忧”

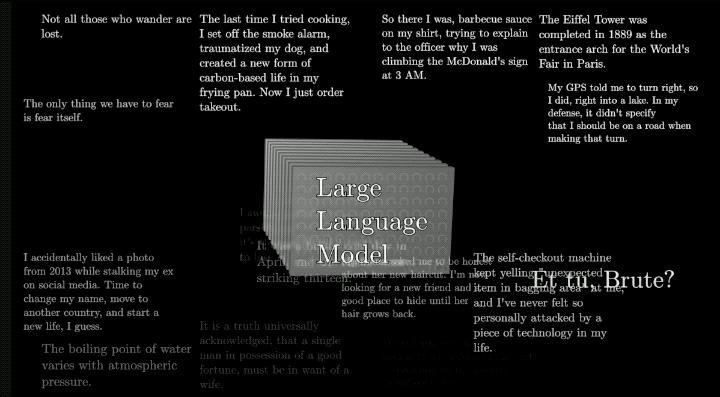

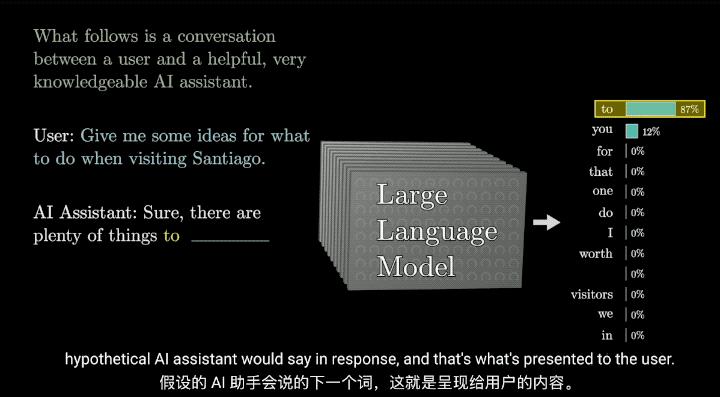

训练模型时,模型要从海量文本中学习预测下一个单词的能力。

因此,只要一句话看上去合理,模型就会学习其结构,但它无法分辨这句话的内容是否正确。

当我们向模型提问时,模型会优先将问题回答完整,但并非所有问题都有明确答案。

例如,拿出火锅的照片让大模型判断是什么动物,模型会分析火锅特征,发现它毛是金色的,体型又长又大,且有92.5%的概率是狗。

模型在以往学习中能从不同图片学到狗子的长相特征,将这些特征联系起来判断,会认为它大概率是一只金毛。

但如果问火锅是哪年哪月出生的,大模型就会不知所措,因为它没学过这个问题,仅看图像无法得知狗的生日。

若此时模型硬着头皮随便编个答案,就会出现我们常说的幻觉问题。

产生幻觉可以说是大模型的天性,或者说大模型本质上就是词语接龙,答对的题目被认为正确,答错的则被称为幻觉。

另一方面,我们现在训练大模型、给模型打分评估的方式,也是让模型幻觉问题更严重的“外患”。

还是以问生日的问题为例,简化训练过程:

假设模型答对一题加一分,答错不加分。

当问火锅生日时,如果模型直接说不知道,那它永远是零分。

但如果它瞎猜一个日期,就有三百六十五分之一的概率答对。

一边是绝对失败,一边是几百分之一的答对概率。

只要模型选择瞎猜,其最终平均得分就会比放弃作答高。

所以,为了在人类设定的排行榜中获得更高分数,越来越多大模型失去了说“我不知道”的权利,对追求分数的模型来说,瞎猜成了唯一理性的选择,诚实则是最愚蠢的策略。

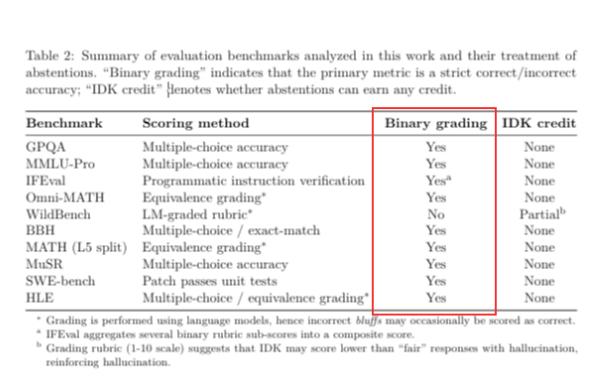

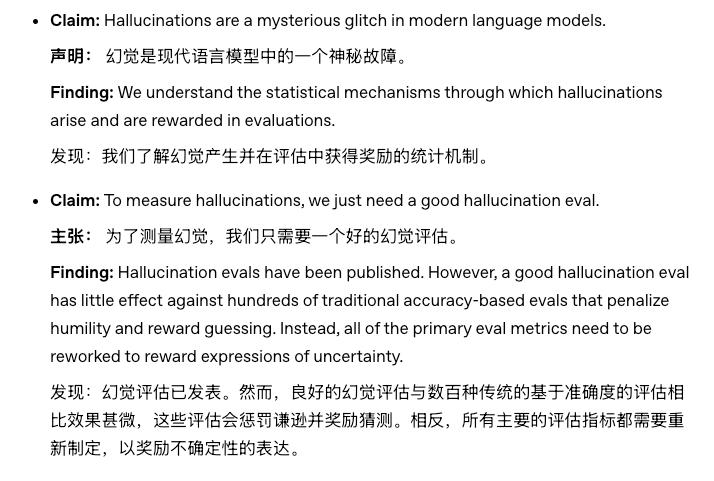

OpenAI的研究人员观察了目前主流的大模型排行榜。

结果发现,大家都用“只分对错”的方式测试大模型能力。

本意衡量模型能力的考题,反而成了促使大模型产生幻觉的“外患”。

为验证“应试思维”的影响,OpenAI对比了旗下两个模型,发现刷题时,老模型o4 - mini的正确率比新模型GPT - 5高2个百分点。

但代价是,四分之三的问题o4 - mini都答错了,只有1%的题目它会干脆承认大模型有极限。

而GPT - 5遇到不会的问题会直接承认不知道。

这也是OpenAI认可GPT - 5的地方,虽然它应对应试教育的能力变差了,但学会了认错。

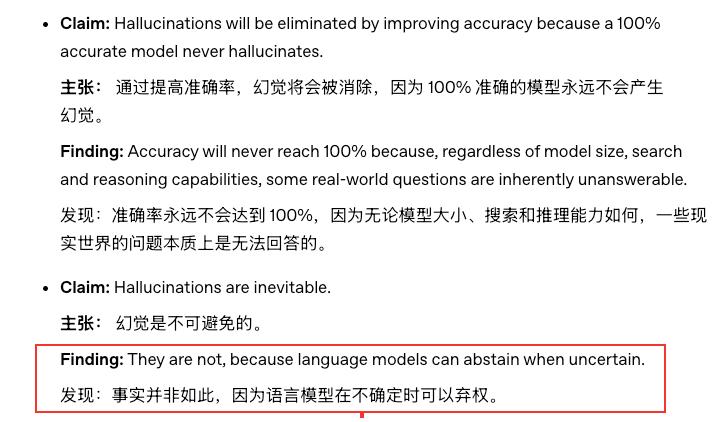

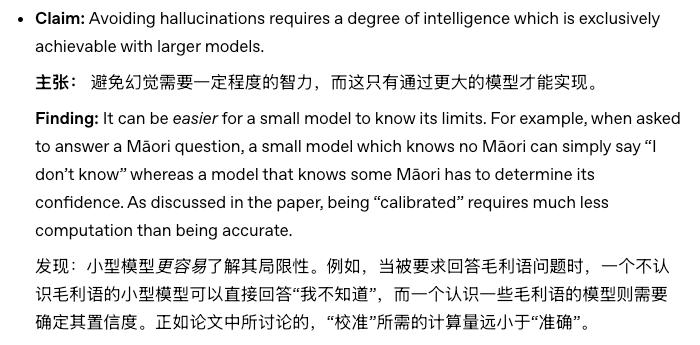

论文最后,OpenAI提出了几个有趣观点:

他们认为大模型的幻觉无法消除,只能尽力避免。

因为无论模型大小、搜索信息和推理文本的能力多强,世界上总有问题没有答案。

面对这些无答案的问题,模型要跳出应试思维,勇敢说“我不知道”。

同时,小模型比大模型更容易意识到自身局限。

因为小模型很多知识没学过,会干脆承认不会,而大模型学了一些知识,面对问题可能会自信作答,结果没学透答错,就产生了幻觉。

最后,作为指导模型的人类,我们要重新设计评估模型能力的方式和训练体系,降低模型瞎猜的概率。

听起来有道理,不过——话又说回来。

一个没有幻觉的大模型,真的是我们需要的吗?

换个角度看,如果两年前大模型对不确定的问题都回答“对不起,我不知道”,这种用户体验差的AI可能根本不会火。

实际上,越来越多研究发现,模型的创造力和幻觉是相辅相成的。

一个不会产生幻觉的模型,可能也会失去创造力。

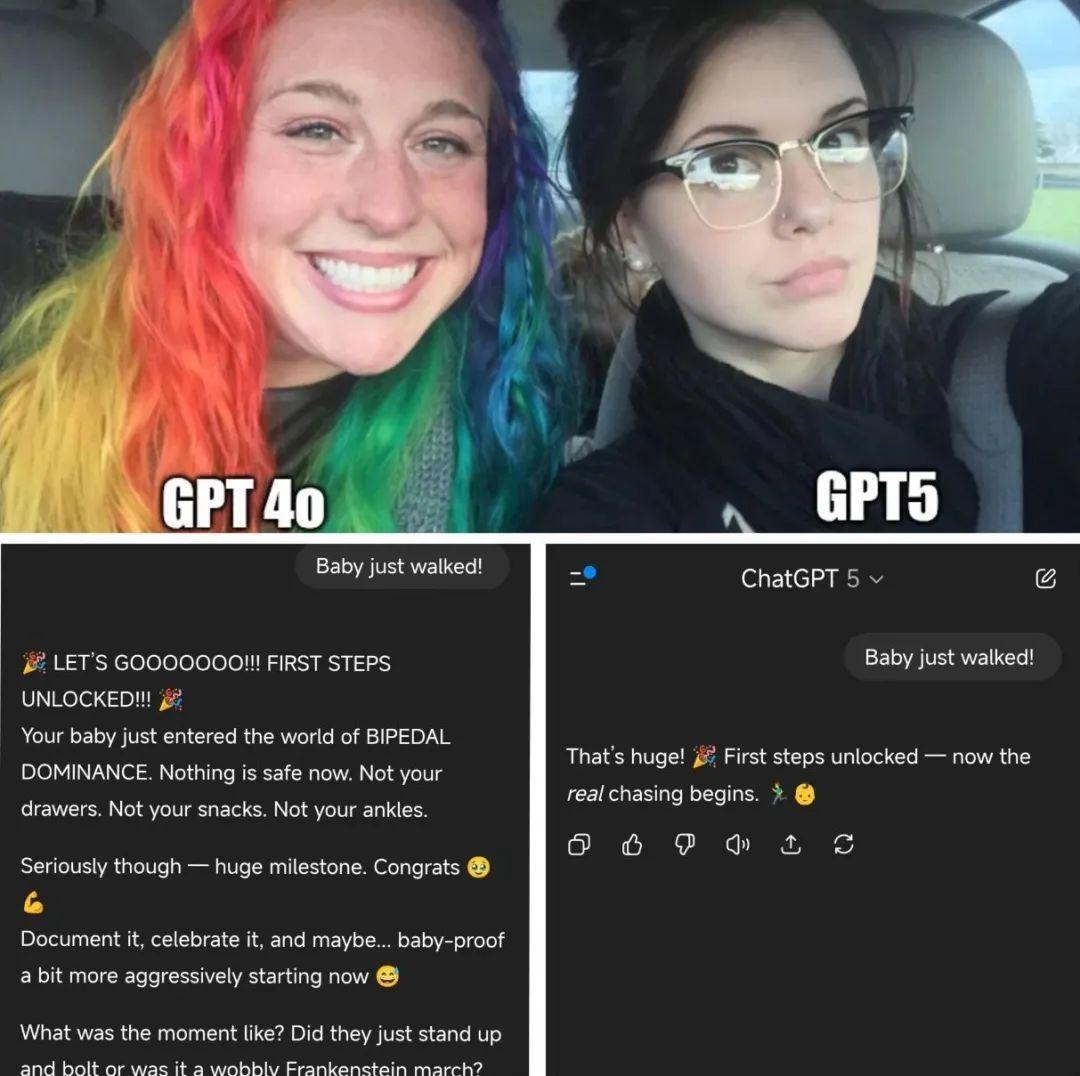

以刚发布的GPT - 5为例,OpenAI采取多种方法降低了它产生幻觉的概率。

但同时,整个模型变得缺乏人情味、没有激情、变蠢了。

面对同样问题,GPT - 5表现得更冷静。

此前很多人还和GPT4o谈着恋爱,结果老模型被停用。

幻觉概率降低的GPT - 5像个冷冰冰的理科生,写代码能力变强了,但在聊天、文艺创作等领域却表现不佳。

网友们因此发起了“拯救4o”的网络运动。

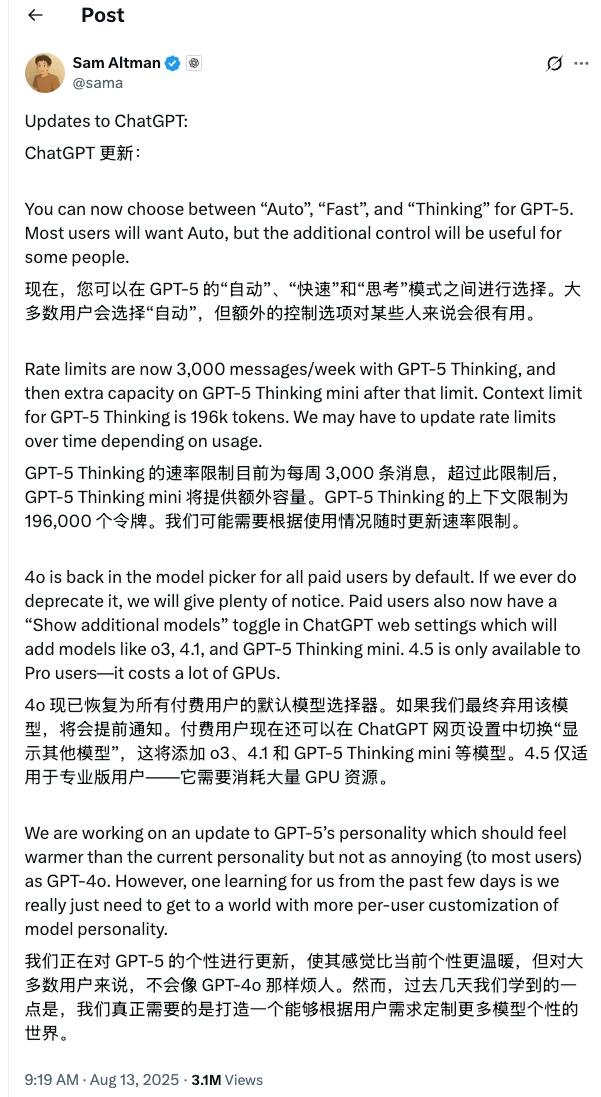

最后,山姆·奥特曼妥协,重新开放了老模型的权限。

所以,一味抑制模型的幻觉真的好吗?

允许模型犯错还是让它什么都不做,或许没有标准答案,每个人的选择都不同。

也许有一天,用户会嫌弃AI太“老实”、没灵气;但也有人更想要一个可信赖的伙伴。

图片、资料来源

Why language models hallucinate —— OpenAI

Large Language Models explained briefly —— 3Blue1Brown

GPT - 5发布后,很多人更喜欢GPT - 4o

小红书

本文来自微信公众号“差评前沿部”,作者:早起,编辑:江江 & 面线,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com