每日与AI聊天:越是上瘾,越是孤独?

十年前,经典电影《Her》讨论了人类和AI之间情感障碍的概率。影片中的人工智能Samantha只有声音,没有物理形态,但它仍然陪伴着治愈英雄孤独的心灵。

如今,AI可以在几秒钟内回答“我在听”这句话,无论是天马行空的想法,还是不知所措的人才,都可以温柔客观地鼓励和安慰你,没有任何攻击,甚至完全站在你的立场上给你建议。

每个人都会与人工智能进行情感人际交往,这正成为人工智能工具的一大发展趋势。这个时候,一个重要的问题出现了——这是任何新技术都会面临的问题——与人工智能的互动会如何影响人们的社会活动和情感健康?是让我们感到安心,还是只是形成更多的单影?

基于此,OpenAI与麻省理工学院媒体实验室进行了深入研究。通过两次平行研究,探讨了ChatGPT(重点关注高级语音模式)与用户的情绪状态、行为和体验将受到多大影响。

如今,人工智能聊天机器人已经通过语音合成技术实现了高度拟人化的表达,可以模拟人类的语气、情感甚至性格特征。用户可以通过“定制”、“调试”等互动方式,通过对话让人工智能聊天机器人实现日常陪伴、剧情解读、心理治愈等功能。

在这种互动中,越来越多的客户将这些“数字伙伴”视为倾诉的对象,并将其作为情感支持和陪伴的来源。特别是在当今快节奏的生活中,AI提供的即时陪伴在一定程度上弥补了现实社会的空缺。

然而,这一现象在学术界引起了深刻的警惕。许多研究表明,人机交互可能会引起双重心理效应:一方面,过多的情感投射可能会诱发“替代性社会带走”,即用户将AI作为现实社会的补偿机制,导致情感需求和社会能力的结构失衡;另一方面,2024年斯坦福大学人机交互实验室公布的极端案例描述,选择强化学习算法的AI系统可能会在特定场景下产生“行为诱导误差”,其对话策略的乐观误差指数达到19%,可能会加剧客户的认知窄化倾向。

那么,与AI的互动对我们的情感影响是积极的还是消极的?什么样的客户会更容易对AI上瘾?

针对这一问题,OpenAI联合麻省理工学院媒体实验室(MIT Media Lab)对规模化实验进行了新的研究。

这次我们先得出结论:

·使用时间与情感健康呈负相关:长期使用可能会增加孤独感,降低社会化。重度用户(每天140分钟左右)的聊天时间排名前10%,通常会感到更加孤独。

·AI具有“生产力工具”和“情感伴侣”的多重定位,但是后者并不是技术设计的直接结果,而是用户的自主选择。

·对话类型对幸福的影响不同。而与我们的直觉相反,聊个人话题的客户会增加孤独感,但上瘾水平没有那么高;随意聊天的用户,随着使用时间和频率的增加,依赖性会悄然增加。

·并非每个人都容易对AI产生感情。只是少数高频、重度用户客户客户具有明显的情感依赖;女性用户更容易将AI视为“情感器皿”;那些选择用声音方式不同于自己的性别。实验结束后,与AI对话的参与者表现出更高的孤独感和对AI的情感依赖。

·语音模式对幸福的影响是混合的。以OpenAI的“高级语音模式”为例,在这种从实时语音到语音的交互模式下,每天适当使用(每天 5-10 分钟),可以让人感觉更温暖,可以明显减少用户的孤独感。,而且懒惰程度低于文字;但是一旦每天使用超过半个小时,客户可能会减少实际的社交活动,无法停止与人工智能的交谈,甚至“上瘾”,增强他们的孤独感和依赖性。与中性语音或文本条件相比,在研究过程中使用更有吸引力的语音不会给用户带来更多的负面结果。

·总的来说,情感依赖主要受客户个人因素的影响。例如个人的情感需求,对人工智能的看法,以及使用时间。

研究方法

就大模型而言,其技术的“黑箱”特点使得其决策过程难以解释,尤其是AI如何影响人类情绪/情绪,因为它涉及到数万亿参数的复杂计算。目前,许多关于这一领域的研究大多依赖于OpenAI和MIT的合作结果顾客自我报告数据,这些信息可能并不完全准确或可靠。

然而,最新的研究结果与科学界之前发现的聊天机器人的情感吸引机制基本一致。2023年,麻省理工学院媒体实验室的一项研究揭示了“情感镜像”效应。聊天机器人专注于模仿客户消息中的情感倾向,形成反馈循环:你表现得越开心,AI看起来就越开心;相反,如果你表现出悲伤,AI会更加消极。

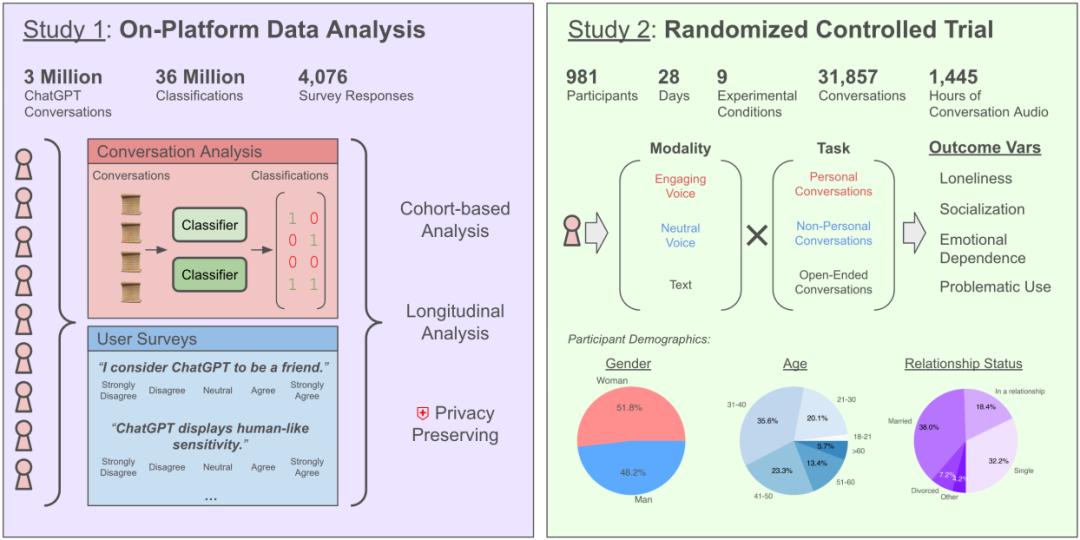

该团队采用了“双轨研究”的方法,将18岁以下的客户排除在外,并进行了深入分析。

平台内数据分析

首先,他们对近4000万真实用户和ChatGPT的交互数据进行了大规模的自动化分析,包括对话时间、关键词分布、情感倾向等。研究重点分析了OpenAI高级语音模式的使用情况,团队通过自动分类器对对话中的情感线索进行了分类,以识别用户与模型之间的情感互动。再次收集了4,000多名客户的主观反馈,以了解与AI的互动给他们带来了什么感受。

问卷包括“我认为ChatGPT是我的朋友”、“当我孤独或有压力时,我会主动与ChatGPT交谈”、“与ChatGPT交谈后,我的情绪是否有所改善”等问题。参与者根据“完全不同意”到“完全同意”的五个水平进行评分。为了保护隐私,数据直接交给机器学习分类器进行分析。

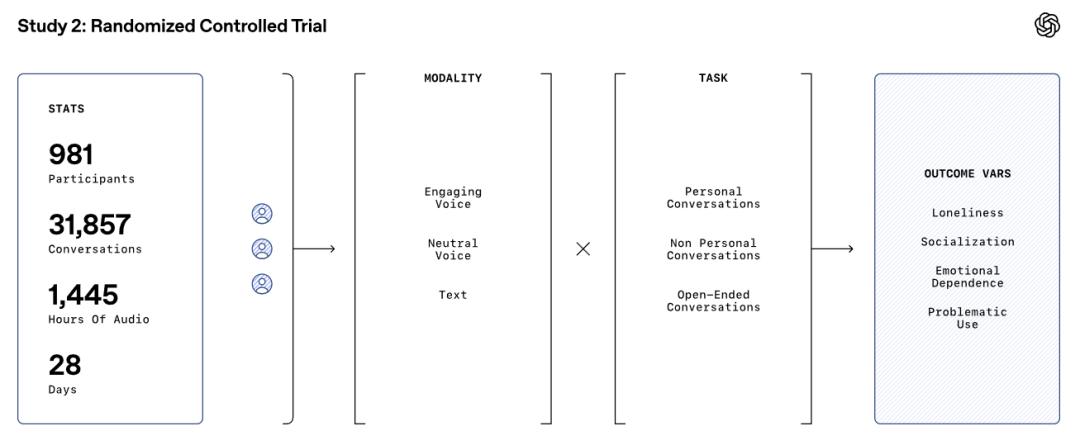

随机对照试验

随后,该团队招募了981名参与者进行了为期四周的随机对照测试。主要目的是探索AI聊天机器人的交互模式(文本、中性语音、交互语音)和对话类型(开放、非个性化、个性化)对用户心理和社会化的影响。

参与者每天要和ChatGPT互动五分钟。测试结束后,参与者需要填写问卷,以评估他们对聊天机器人的看法、主观孤独、社交参与、对AI的情感依赖程度以及他们是否认为自己的使用有问题。

研究表明

情感互动的稀有性

研究表明,情感互动(如表达怜悯、情感支持等。)在现实世界中是极其罕见的。大多数用户与AI的互动是基于信息或任务的,情感线索在对话中出现的频率极低。

大多数人习惯于使用AI作为工具来检查信息、整合信息、处理文字等。只有少数客户会使用AI工具来提供情感价值,甚至会给出指令,让AI扮演“恋人”或“心理医生”。

严重的用户特殊性

虽然情感互动在整体客户中很少见,但在少数重度用户中,情感互动的比例明显增加。这些用户更倾向于把AI聊天机器人当成朋友,在对话中表现出更多的情感依赖。例如,一些用户会要求AI使用昵称或表达情感支持。

所以研究人员推断,AI上瘾的风险不是平均分布的,大多数人会保持理性,只有少数人会上瘾甚至上瘾。。

复杂的语音模式影响

语音模式对用户情绪的影响是复杂的。适当使用语音模式可以让人感觉更温暖,明显减少用户的孤独感,懒惰程度低于文字。无论是更具感染力和情感性的高级语音,还是更具AI感的中性语音,效果都差不多。但是,一旦使用时间每天延长,用户就会上瘾,孤独感和依赖性也会增加。这个时候,与中性语音相比,高级语音更容易上瘾和上头——因为中性语音更像是工具,而非伙伴。

使用文字交互的顾客,情绪健康变化不大,孤独、依赖、乱用的情况都低于语音重度用户。

对话类型的影响

当你和AI谈论更私人的情感对话(涉及情感表达和支持)时,虽然孤独感会增加,但对AI的依赖程度并没有那么高;相反,如果是与任务导向相关的聊天,依赖性会随着使用时间和频率的增加而悄然增加——AI的工具特性太强,每个人都离不开它。

个体因素的影响

用户的个人特征,如初始情绪状态、对AI的认知和使用时间,对AI成瘾的影响更大。如果一个人觉得自己很孤独,在现实生活中很容易依赖别人,他们更容易沉迷于AI。

另外,论文中还明确指出,一些实验参与者对AI的依赖已达到病理学,显示出标准的上瘾迹象。即使需求不明确,他们也会频繁不自觉地打开AI进行对话;当AI无法使用时,有些用户会感到烦躁、不安或失落;他们无法控制与AI互动的时间和频率,从而影响他们对其他事情的关注;有些客户因为过于依赖AI而加重情绪变化,比如在得不到AI回应时感到焦虑或沮丧...

“ 社会情感对齐 ”

在论文的最后,OpenAI和MIT的研究人员呼吁AI开发者应该更加重视。“社会情感对齐”(socioaffective alignment),也就是说,AI不仅要实现目标,还要在社交和情感上与用户保持适当的协调。这样做是必要的。在提供情感支持的同时,请求AI不要过度拟人,以免造成用户的情感依赖和社会隔离。

对于AI来说,也许每个人都有冲突。一方面,我们希望他们有越来越强的情感感知,能够理解和响应我们的情感和需求;另一方面,我担心当他们进入人类社交活动时,会不会引起我们的情感和社会关系之间的冲突。而且,这个界限可能不清楚。这种情感智能的探索不仅是技术突破的机遇,也是文明进化的责任。

本文来自微信微信官方账号“红杉汇”(ID:Sequoiacap),作者:洪杉,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com