同一个Deepseek R1,不同的“买家秀”?不同云平台ds性能的实测

大型“撞衫”并不可怕,谁性能差谁尴尬——今年年初,DeepSeek R1模型问世,推理能力和性能堪比OpenAI。 o1,由于其开源策略和灵活布局能力,火山引擎、阿里巴巴云、腾讯云、百度智能云等渠道相互接入,导致模块振动:

数据显示,DeepSeek 根据调查,数字公司、法律公司和电子商务公司都加快了对DeepSeek-R1开源模型的访问,相关平台的API调用量急剧增加。随着越来越多的主流厂商访问Deepseek,一场关于基础设施适应性的暗战悄然进行:

目前,同一个大模型在各种平台上表现出显著的性能差异。前不久,中国软件评估中心人工智能部选择了10多家国内外服务厂商进行全面评估。数据显示,各厂商的深度思维能力、代码能力等维度明显分化,如火山引擎、讯飞开放等代码任务能力较强;代码任务中硅基流动和百度智能云有少量截断或未回复;

在推理层面,百度智能云、讯飞开放、火山引擎等平台的生成内容总字数接近3000字,其中推理字数分别占68%。、69%和60%,表现出更强的逻辑延展性,相比之下,一些平台只能提供浅层推理。

这种“橘子生在淮南,橘子生在淮南”的情况揭示了技术适应、资源调度和生态协同的深层博弈。那么,真的有这么明显的差距吗?DeepSeek最强的辅助是谁?让我们一起试试吧!

各平台AIME答疑表现:火山准确率最高,其次是官方,

通过加强学习和混合专家架构,deepseek最明显的长板就是深层推理能力,(MoE)等待技术,显著提高推理效率和性能。所以,我们在模型评估领域选择了权威的测试集。——AIME 数学竞赛题目。作为美国数学邀请赛,AIME 包含许多领域,如算术、代数、记数、几何、数论、概率等,要求参赛选手在 3 小时内完成 15 道路难填空,答案需要具体到三位数,对模型的数学推理能力、逻辑严谨性和计算精度提出了极高的要求。

与此同时,在技术层面,AIME 问题通常需要多步推理和创造性的解题策略,例如,答案只能通过假设验证、思维纠正或单位转换等复杂操作来完成,这使得它成为测试大模型深层推理能力的有效工具。在此之前,DeepSeek-AIME是R1的官方 在2024年基准测试中,得到了79.8%的pass@1分。

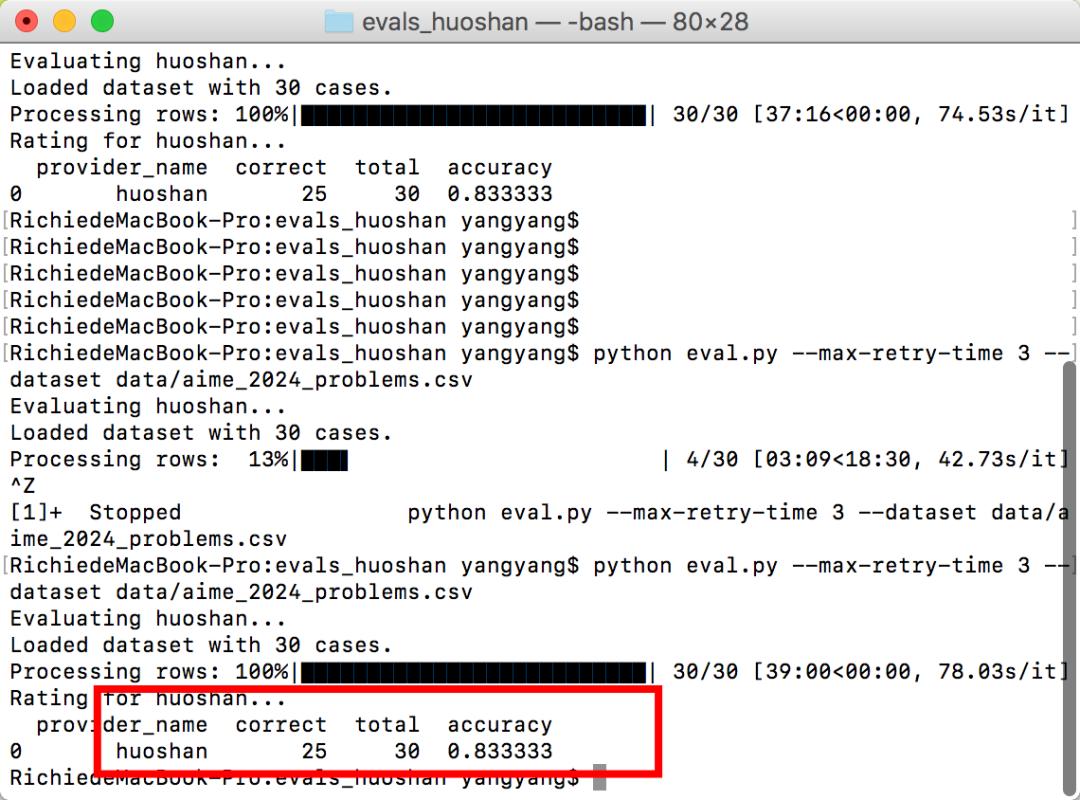

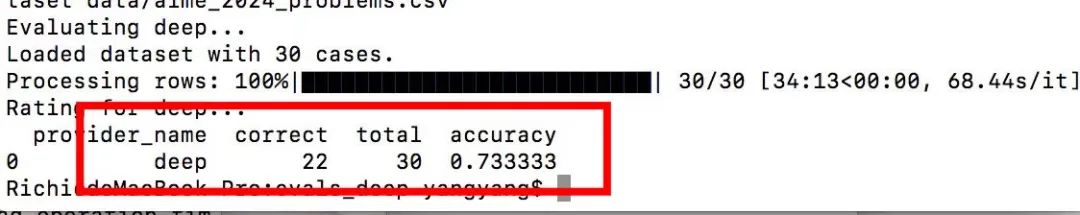

这次我们通过Python 脚本评估(脚本放在文末),选用火山引擎,阿里云,官方Deepseekek。、四位腾讯云考生,有兴趣的朋友一起试试吧!

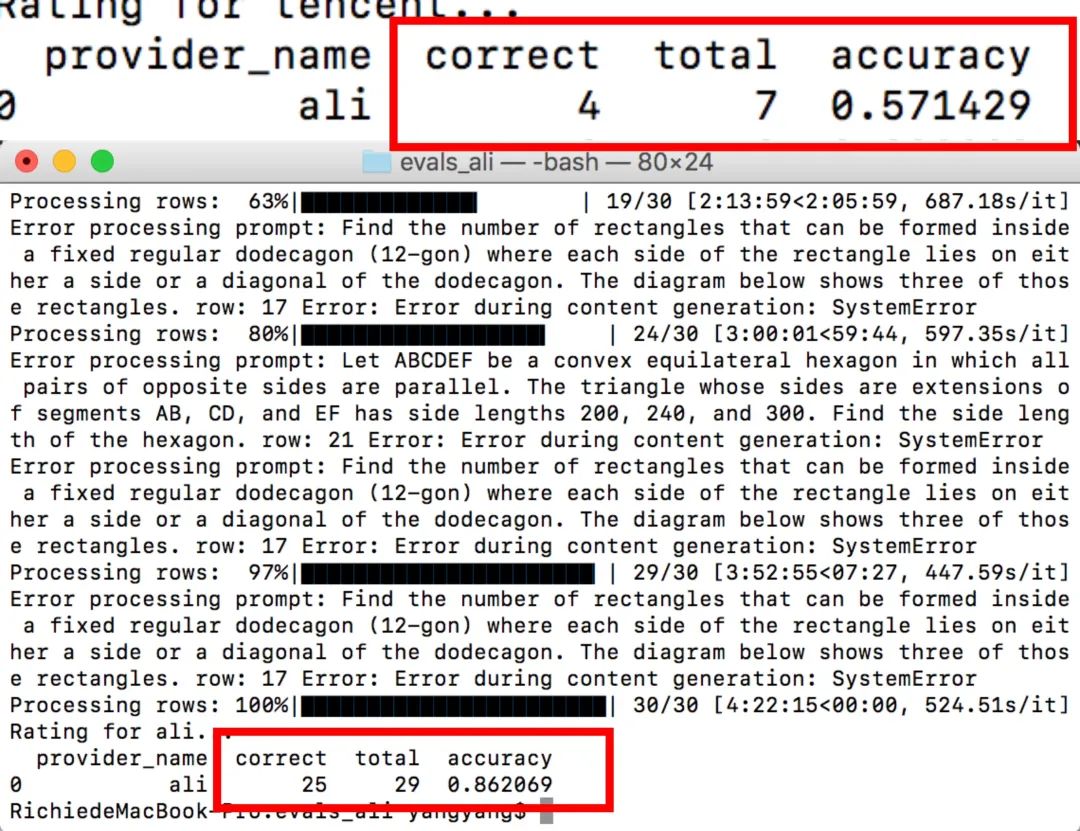

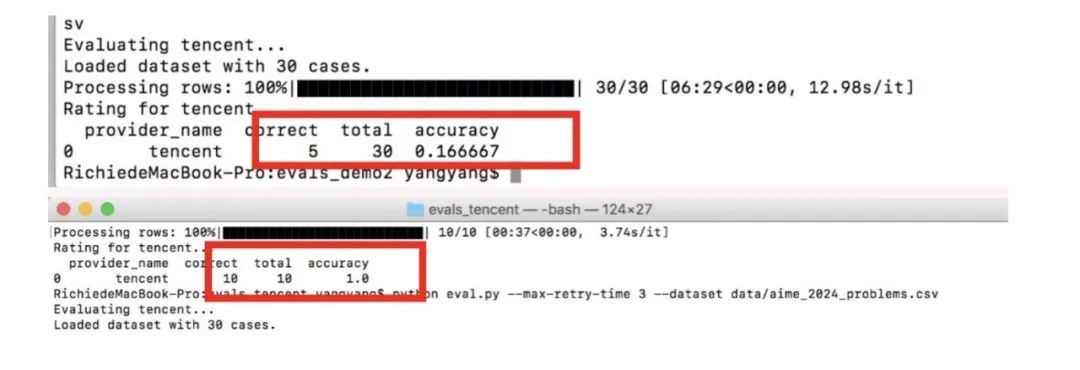

结果:在AIME题库下,准确率由高到低依次为:火山发动机83.33% ;官方Deepseek 73.33% ;阿里云 71.67% ;腾讯云58.33% 。

其中火山、 Deepseek在各种网络状态下表现稳定,检测都是一次性的,30道题全部响应,测得比较省心。

在电信下,阿里云异常中断较为严重,联通表现良好,电信下响应7道题,准确率为57.14%,联通下响应29道题,准确率为86.20%,取两次平均值。

腾讯网络无响应状态略显频繁,同样取几次测试的平均值。

顺便说一句,这两家厂商经常不回应。CPU一做题就烧的厂商,把我们公司的程序员和被临时摇来评价的同学脾气都磨掉了。一天的评价任务只有三天才能完成。他们要么在刷新页面,要么在刷新页面的路上。白天在企业修BUG,半夜兼职跑数据的日子,让他们本来就不浓密的头发此刻更加稀疏。对此,他指出自己无法吐槽:

“尤其是阿里,就像一个在电信网络上被拔掉网线的AI高考学生。他做了七道题,直接把它弄坏了。他一转到联通网络,马上就变成了校长,不演了。堪比期末考试前夕的突袭战将。小女孩还有两张脸?”

(??让程序员同学两眼一黑的加班现场)

所以,这三个家庭的思考过程究竟是怎样的,有没有更直观的体现?接下来,我们手动选择了一个AIME测试问题,看看它的具体推理、思维过程和表现。结果表明,虽然几个类似的问题最终得到了正确的结果,但火山速度最快,解决问题的步骤更加清晰,并且被贴心地翻译成中文,更适合中国宝宝的体质。速度方面,火山类似的问题需要13.68秒,官方最慢,81秒。

火山引擎

腾讯云

(官方DeepSeek心中的oseek:难道我没有面子吗?)

所以,除了精度和速度之外,如果要对各个厂商的API性能进行更全面、全面的评估,还有哪些层次可以包括在内呢?

性能、速率、稳定性综合竞争:Deepseek六边形最强辅助发布

评价一时爽,一直在评价火葬场,这部分,我们一致决定:还是抱大腿抄作业,直接送大神评价吧!

有志者事竟成,一次5G冲浪,我们扒了一次硬核实测——第三方开发者对各云厂商DeepSeek进行实时监控。 API性能参数项目,不仅仅是TTFT(Time To First Token)、TBT(Total Blocking Time)、Throughput (吞吐量)等维度综合评价,堪称评价界的心电图,同时也贴心地画出了图表,得来不费力!

附网址:https://deepseek.ai-infra.fun/ ,它包含性能参数和实时动态更新。有DeepSeek。 需要API选型的企业可以蹲下最新数据,直接Ctrl C走这个实战指南。

【PS:TTFT指标显示,用户在看到模型导出之前需要等待时间,TTFT 顾客等待时间越短,感觉越好。TBT表示产生邻近 token 平均时间间隔反映了模型生成文本的连续性和流畅性。数值越小,生成速度越快,客户得到完整回复的时间越短;Throughput (吞吐量)反映了模型的实际生成效率,数值越高,生成速度越快]

由此可见,火山发动机在生成速度、效率等方面遥遥领先, 29.50 tokens/s 与阿里百炼(6.70)相比,吞吐量实现了行业内最高效的文本生成能力。 tokens/s)快340%。这意味着产生100000 在tokens文档中,火山引擎只需34秒,而阿里百炼则需149秒。而33.9ms TBT指标,确保与token相邻的生成间隔保持在人类无感阀值内,防止对话机器人产生“打字效应”。

其次,在高负荷下的稳定性保证层面,火山发动机仍能保持极高的吞吐量,反映动态资源调度技术的成熟度,同时保证TTFT(第一token响应时间)0.46秒。与腾讯知识引擎相比(TTFT 0.70s吞吐26.04 tokens/s),单位时间资源利用率提高42%的火山发动机。

所以我们总结一下情景优势:当需要实时交互(客服/助手)时,火山引擎在生成速度、效率、稳定性等领域兼顾综合优势。、在硬核需求场景中,如长文本生成(创建/代码),可以选择火山方舟,TBT 33.90ms TTFT 同时进行0.46s=平滑顺畅。

而且中国软件评估中心另一个权威部门的人工智能部门的评估也证明了这一趋势:

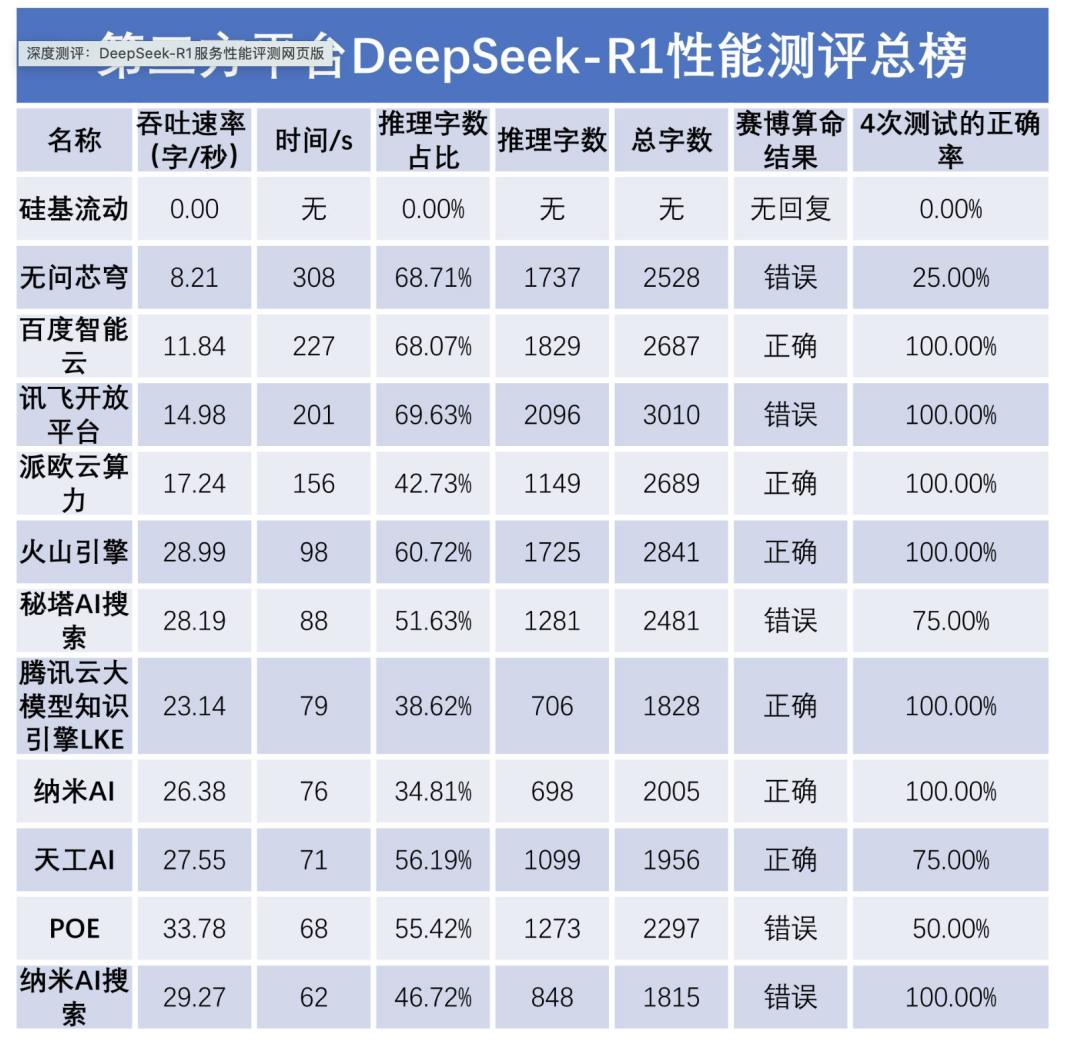

它指出,每个平台的准确率差异很小,特征的资源效率差异很大,其中,深度思考时间和吞吐速度的表现完全不同。在保证准确性的同时,火山引擎、纳米AI搜索等渠道的吞吐速度也较快。无问芯穹、百度智能云、讯飞开放等渠道虽然准确率很高,但吞吐速度较低,客户体验有限。以无问芯穹为例(硅基移动平台无响应),吞吐速度只有9字/秒。虽然可以得到更准确的答案,但是在使用体验上非常卡屏,甚至截断;POE平台以33.78字/秒的吞吐速度领先,但准确率只有50%。

综上所述,火山引擎确实是Deepseek最强的“六边形战士”协助。然而,AI战场是不可预测的。从Deepseek的诞生和弯道超越可以看出,没有哪个厂商有永恒的优势,同志们还是需要努力的!当然,AI大模型工厂会继续关注行业趋势进行更新,为有需要的公司和开发者发回“一线电报”。

尾声:

最终,DeepSeek R1云平台分化的本质是AI基础设施能力的公开测试,不仅反映了各厂商在计算率基础设施、工程能力和生态整合方面的实力差距,也暴露了芯片适配、模型优化等关键环节在国内AI产业链中的难点。未来,云制造商需要在计算率产业化、数据工程化、生态开放等方面建设一条环城河。

对于用户来说,“橘生淮南”的区别只是精心挑选的机会——只有深入了解技术栈与需求场景的耦合关系,才能真正释放大模型的变革潜力。

然而,令人欣慰的是,目前行业领导者已经开启了能力普惠化进程,将技术优势转化为客户体验收益。例如,火山发动机目前正在进行拉新活动,享受DeepSeek R1 和 V3,支持30,000RPM和500万TPM无限速,共享即可领取tokens!假如你想快速开始deepsee、获得流畅流畅的感觉,立即邀请朋友免费领取大模型!成功邀请一位新客户,双方最高可获得145元优惠券,可抵扣3625万tokens,邀请多得不封顶。

对于急需平衡成本和效率的开发者来说,这种“先试后买”的感觉机会,恰好是了解不同平台的技术基础,在自己的业务中尝试的最好机会。来邀请你身边的开发者吧!地址:https://www.volcengine.com/activity/deepseek

在附文中评估Python脚本。有兴趣的朋友可以自己跑,也可以自己动手调整环境变量和模板,快速适应不同的评价要求:

git 地址:

https://gitee.com/ai-large-model-factory/evals.git

本文来自微信微信官方账号“AI大型工厂”,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com