DeepSeek连开三源, 解开训练省钱的谜团

DeepSeek高效地反驳了“他们在实践中撒谎了”的言论,这种言论经常出现。

旧金山人工智能产业解决方案提供商 Dragonscale Industries 首席技术官 Stephen 如果Pimentel在X上评论DeepSeek的“开源周”。

“是的。以及关于H1005万张的虚假谣言(也被驳斥)……”全球咨询公司DGA Paull专家Group合作伙伴,中美技术问题 Triolo还附和道。

DeepSeek2月24日至2月28日,“开源周”持续5天。将陆续开源5个项目。

过去三天的开源项目分别如下:

l Day1:FlashMLA,高效MLA(双头潜在注意力)解码核心,针对英伟达Hopper架构GPU;

l Day2:DeepEP,第一个开源EP(专家并行)通讯库用于MoE(混合专家)模型训练和推理;

l Day3: DeepGEMM,对MoE模型FP8计算库的支持密集,可以为V3/R1的实践和推理提供强有力的支持。

第三天,“开源周”让怀疑DeepSeek在实践成本上“撒谎”的人大吃一惊。由于每一个开源项目都在向世界展示DeepSeek完美榨取英伟达芯片技能。

还有什么比“贴脸放大”更能打败质疑呢?

1

首先,我们来看一下DeepSeek最新开源的DeepGEMM,只能说,DeepSeek在榨取英伟达芯片、提高AI性能效率方面已经火了。

那时候团队专门为V3模型使用,现在就这样水灵灵灵地开源了,要不说DeepSeek的诚意真的很感人。

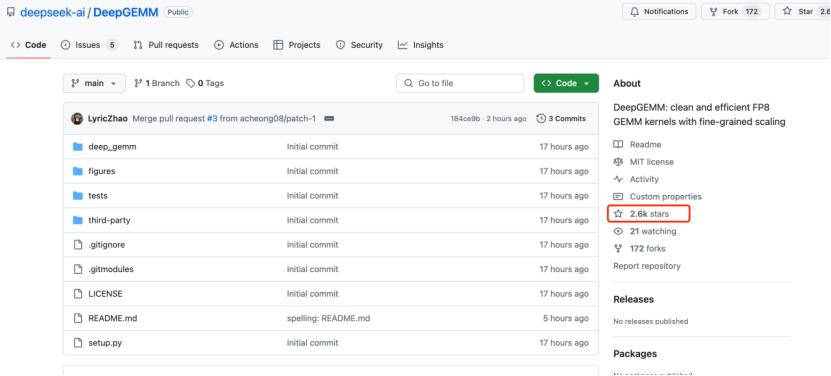

在GitHub上发布不到10个小时,已有2.6千颗星星。要知道,一般来说,在GitHub中获得数千颗星星是非常成功的。

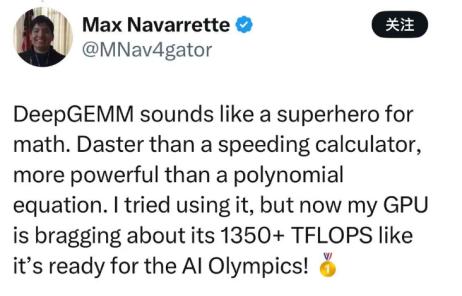

“DeepGEMM就像数学领域的超级英雄,比超速计算器快,比多项式方程好。当我试图使用DeepGEMM时,我的GPU每秒超过13500。 TFLOPS(万亿次浮点运算)的速度运行,似乎已经准备好参加AI奥运会了!”一位开发者兴奋地在X上说。

DeepSeek新开源的DeepGEMM究竟意味着什么,意味着什么?

官方DeepSeek介绍DeepGEMM是一种支持密集型和MoEEMM 模型FP8 GEMM库:

l 没有严重的依赖,像教程一样简洁;

l 全JIT(即时编译)

l 在大多数矩阵尺寸下,核心逻辑约为300行代码,优于经过专家调优的内核。

l 同时支持密集布局和两种MoE布局

定义:DeepGEMM是一款致力于FP8高效通用矩阵乘法的公司(GEMM)库,主要满足一般矩阵计算和混合专家。(MoE)计算需求在分组场景中。

利用这个库,可以动态优化资源配置,从而显著提高计算效率。

在深度学习中,FP8(8位浮点)可以降低存储和计算的成本,但也有缺点(特点),即精度相对较低。如果高精度格式是无损压缩,那么FP8就是有损压缩。储存空间大大降低,但需要特殊的处理方法来维持质量。但由于精度低,可能会出现量化误差,影响模型训练的稳定性。

DeepSeek在报告中说:“目前,DeepGEMM只支持英伟达Hopper张量核心。采用CUDA核心二级积累(提高)方法,解决FP8张量核心积累的精度问题。

为了使FP8的计算方法更加精确,DeepSeek使用CUDA核心进行了两次积累,首先使用FP8进行大量乘法,然后进行高精度汇总,以避免积累偏差。它不仅大大降低了空间,而且保持了精度,从而提高了效率。

JIT(即时编译)和Hooper张量核心也是绝配。

Hopper张量核心是一个专门为高效执行深度学习任务而设计的硬件模块,JIT意味着程序可以根据当前硬件的具体情况动态编译和优化代码。例如,JIT编译器可以根据GPU架构、内存布局、计算资源等实时信息生成最合适的指令集,从而充分发挥硬件性能。

最令人惊讶的是,所有这些都被DeepSeek塞进了大约300行代码中。

“虽然它参考了CUTLASS和CuTe的一些概念,但是它避免了对它们的模板或代数的过度依赖。相反,库设计简单,只有一个核心功能,代码大约有300行左右。它使它成为一种简单而易于学习的资源,适合学习Hopper FP8矩阵乘法及优化技术。

CUTLASS是英伟达自己的CUDA架构,专门为英伟达GPU加速矩阵计算。归根结底,官方生产,它确实非常好用。但是它也很大很重,如果手中的卡片不太好,那还不一定是跑得很重。

再想想不能吃的馒头也没用,DeepSeek的终极榨取哲学在这里闪耀。提升更加激进,更加专注,更加轻盈。

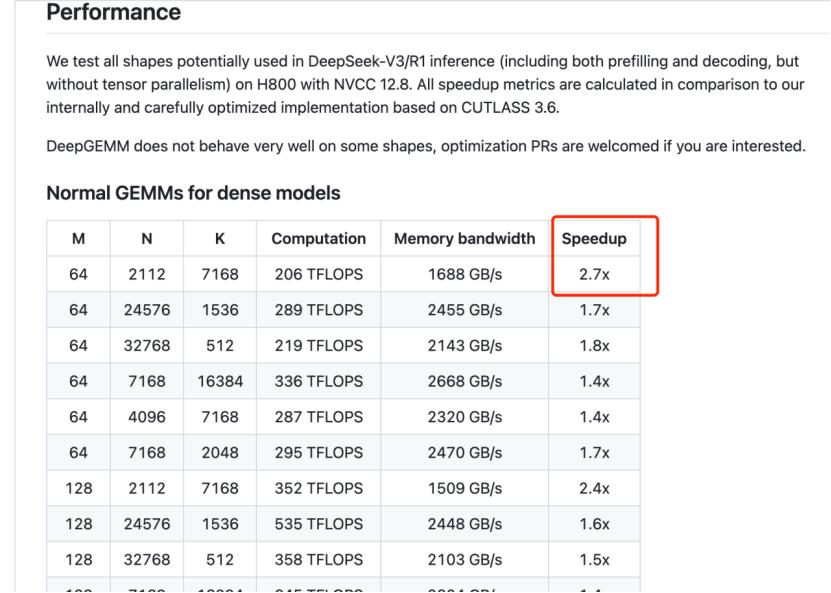

在报告中,DeepSeek表示,DeepGEMM比英伟达CLUTLASSSS更轻, 3.6的速度提高了2.7倍。

还记得DeepSeek在春节期间火了,人们在使用它之后,都被它的“科技浪漫”风所感动。

现在看来,DeepSeek的“科技浪漫”并不只是在最后呈现给用户的文字中,DeepGEMM就像一把锋利的刀,在英伟达芯片上雕刻出美丽的小花,线条简洁而优雅。

2

不只是DeepGEMM,DeepSeek的前两个开源项目也将其“科技美学”体现得淋漓尽致。

DeepSeek开源FlashMLA的第一天。

用DeepSeek的话说,这是“用于Hopper” 对可变长度序列进行了优化,GPU高效MLA解码核心。

忽略了技术细节,我们来看看FlashMLA是如何工作的。

首先,在推理各种语言模型时,高效的序列解码对于减少延迟和增加吞吐量尤为重要。FlashMLA特别适合这类任务,因为它优化了延长序列和分页KV缓存。

其次,聊天机器人、翻译服务或语音助手等应用需要低延迟响应。FlashMLA的高内存带宽和计算吞吐量保证了这些应用能够快速高效地返回结果。

而且,FlashMLA在需要同时处理多个序列的情况(例如批量推理)时,可以有效地处理延长序列并进行内存管理,从而保证最佳性能。

最后,在进行新的AI模型或算法实验时,研究人员可以使用FlashMLA来加快实验和原型开发,尤其是在处理大型模型和数据时。

或者两个字:榨取。DeepSeek在报告中表示,该工具是专门为英伟达H800而设计的——H800 在SXM5平台上,如果内存受限最高可达3000GB/s,如果计算限制可以达到580的峰值。 TFLOPS。

DeepSeek第二天开源了DeepEP。

用DeepSeek的话来说,这是“第一个用于” MoE 开源模型训练与推理 EP 通讯库”。

MoE是混合专家(Mixture of Experts),这种结构使用多个“专家”子模型来处理不同的任务。MoE根据输入有选择地激活了一些专家,使模型更加高效,而不是使用单一的大模型来处理所有任务。

顺便说一下,MoE和MLA(双头潜在注意力)是DeepSeek降低成本的关键先进技术。

在DeepEP中,EP是指专家并行(Expert Parallelism),它是MoE中的一种技术,允许多个“专家”子模型并行工作。

在处理复杂的机器学习任务时,DeepEP可以在加速和改进计算机(或GPU)之间进行通信,尤其是与混合专家相关的。(MoE)模型时。这些模型使用多个“专家”(特殊的子模型)来处理问题的不同部分,DeepEP保证数据能够在这些专家之间快速有效地传递。

就像机器学习系统中一个聪明的交通管理员,保证所有“专家”都能按时收到数据,协调工作,防止延迟,使系统更高效、更快捷。

假设你有一个大数据,并希望不同的模型(或专家)处理数据的不同部分,DeepEP会在正确的时间向正确的专家发送数据,这样他们就不必等待或推迟数据。如果你在多个GPU(强大的处理器)上训练机器学习模型,你需要在这些GPU之间传输数据。DeepEP改进了两者之间的数据传输技术,以确保数据流动的快速和顺畅。

即使你不是开发者,对这篇文章没有完全理解,也可以从中读出两个字:高效率。

这些都是DeepSeek开源周所展示的核心实力——该公司如何最大限度地利用有限的资源。

3

自从DeepSeek打开开源周之后,就不怎么看到之前对它提出质疑的人还有什么评论。

正如本文开头引用Pimentel的热评一样:“DeepSeek有效地反驳了“他们在练习中撒谎了”的言论。

DeepSeek在去年12月关于V3的技术报告中表示,该模型使用了约2000美元的英伟达H800进行练习,费用约为600万美元。这一成本远低于较大的竞争者,后者往往投入数十亿、数万亿美元,OpenAI甚至在DeepSeekR1模型爆红之前,刚刚与甲骨文、软银联合宣布了5000亿美元的合资项目。

在开发成本方面,这也引发了对DeepSeek的误导。

Anthropic创始人达里奥·阿莫迪有怀疑态度(Dario Amodei)、Oculus 帕尔默·卢基创始人(Palmer Luckey)。Meta收购了Oculus。

卢基说,DeepSeek的预算是“假的”,而阿莫迪只是写了一篇文章,呼吁美国加强芯片出口管制,指责DeepSeek“偷偷”使用了大量更先进的芯片。

他们并不相信DeepSeek自己的声明。——DeepSeek 根据其技术报告,高效训练的秘诀在于从MoE混合专家结构到MLA双头潜在注意技术的多种创新融合。

现在,DeepSeek开源周零帧先手,从这些技术深度提升方面做开源。

Bindu “DeepSeek正围绕MoE模型进行训练和推理,以极高效率的开源技术为重点,Reddy在X上表达了兴奋之情。感谢DeepSeek,推动AGI的发展,造福人类。”Reddy曾在谷歌担任产品经理,在AWS担任人工智能垂直领域总经理,后来创立了Abacus AI,是开源路线的信仰者。

一些媒体评论说:“FlashMLA就像一股清新的空气,对于那些热爱人工智能的人来说。这不仅关系到速度,而且为想象和合作开辟了新的途径。

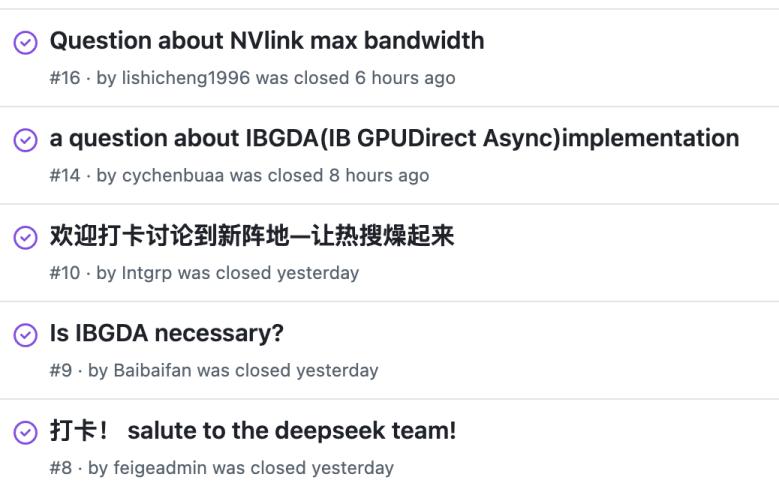

在Github相关开源项目的交流区,不仅有行业交流,还有很多好评,甚至还有中文“来这里旅游”的打卡贴。在中国互联网上,人们已经开始称DeepSeek为“源神”。

DeepSeek有自己的难题吗?诚然,比如商业化这个老大难题,DeepSeek可能也要面对。但是在那之前,它首先给了对手压力。

同样在Github的交流区域,很多人回忆起OpenAI,称DeepSeek为“真正的OpenAI”。OpenAI已走上闭源之路数年,甚至被戏称为“”CloseAI",OpenAICEO山姆·奥特曼,直到DeepSeek出现。(Sam Altman)终于松口了,说在开源/闭源的问题上,自己可能站在了历史错误的一边。

一个星期前,他曾在X上发起投票,询问粉丝们希望OpenAI的下一个开源项目是什么样的。

但到目前为止,这一切仍在承诺之中,并没有被世界看到。

另一方面,马斯克的xAI在新一代发布的时候仍然是开源上一代的大模型。Grok刚刚发布。 第三,Grok宣布开源。 2。

同时,DeepSeek的开源周也让更多的人担心英伟达,这是AI浪潮中最大的受益者之一。

有些人看着DeepSeek的开源项目一个接一个地发布,在X上说:“这是第三天看到我的英伟达股票在火上烤。”

2月27日,北京时间不仅是DeepSeek开源周的第四天,也是OpenAI发布开源信号的第九天,也是英伟达财务报告发布的日子。

OpenAI的开源项目会来吗?英伟达的股价能稳定下来吗?DeepSeek还会开源什么?在人工智能战场上,总是不乏让人期待答案的问题。

本文来自微信微信官方账号“直接面对AI”,作者:毕安娣,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com