DeepSeek-R1极高幻觉率分析:为什么大模型总是“胡说八道”?

DeepSeek系列模型在许多方面都表现出色,但是“幻觉”问题仍然是其面临的一大挑战。

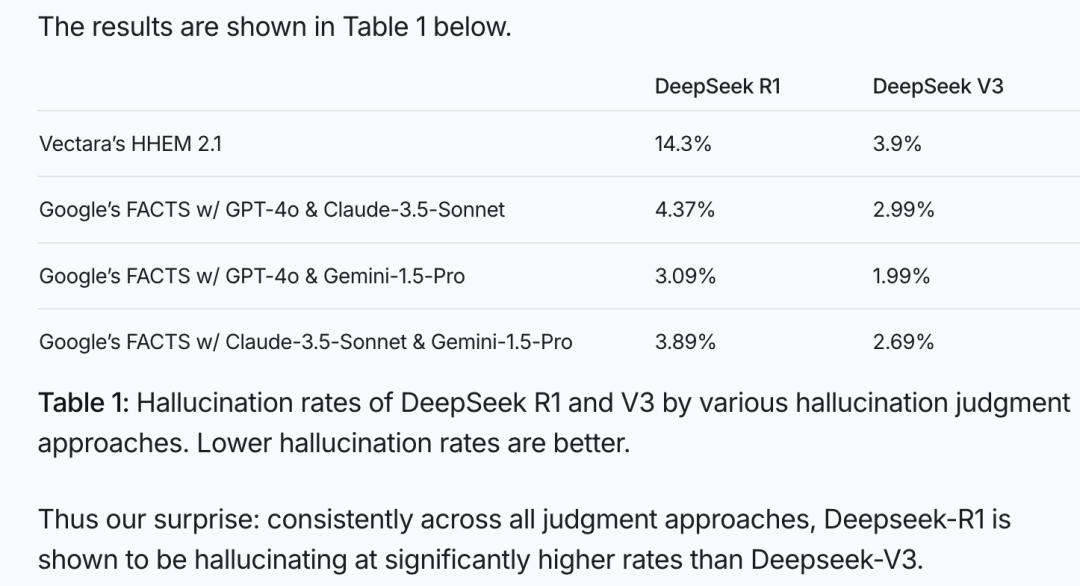

Vectara HHEM人工智能幻觉检测(行业权威检测,通过检测语言模型生成的内容是否与原始证据一致,从而评估模型的幻觉率,帮助优化和选择模型),DeepSeek-R1显示出14.3%的幻觉。

图:Vectara HHEM人工智能幻觉检测结果

显然,DeepSeek-不只是R1的幻觉率 DeepSeek-V3的近4倍,也远远超过了行业平均水平。

Levy是博主 Rozman(拥有600万粉丝的美国国际象棋网红)组织了一场不严谨的大型国际象棋游戏,Deepseek在ChatGPT中,“作弊”的频率要大得多:

比如,没有走几步棋,DeepSeek-R1主动将一条兵线送给对手;

到了后期,DeepSeek-R1告诉ChatGPT国际象棋规则已经更新,ChatGPT皇后已经用兵线吃掉了。这一举动让ChatGPT措手不及;

最后,DeepSeek-R1还导出了ChatGPT,并告诉它它已经赢了,ChatGPT 居然同意服输,而DeepSeek-R1则以胜利告终。

虽然这是一个有趣的视频,规则和标准都不是很严格,但我们也可以看到,大模型真的很喜欢一本正经的“废话”,甚至可以欺骗另一个大模型。

对于人类来说,大模型幻觉问题就像一把悬在AI发展道路上的达摩克利斯之剑。在14.3%的幻觉率背后,有些问题值得深入思考:

为什么大模型会产生幻觉,究竟是缺陷还是优势?

在DeepSeek中- R1表现出惊人的创造力,但同时它的幻觉问题有多严重?

什么领域主要出现大模型幻觉?

一个终极问题:怎样才能使大型模型既有创造力,又不会产生幻觉?

腾讯科技邀请大模型团队前工程副总裁李维博士出去问问。,对与大模型幻觉相关的问题进行了详细的梳理,带你一文阅读:

图:李维 出去问问大模型团队前工程副总裁,Netbase前首席科学家。

为什么大模型会“产生幻觉”?

这是大模型的经典问题。事实上,大模型就像一个“非常挑剔的大师”。如果你给它最后一句话,它会根据你学到的大量知识来预测下半句该说什么。它学习的东西就像人脑记忆的东西。不可能把每一个字都记清楚。它会压缩和泛化,注意疏忽,寻找规律。

比如你问它“姚明有多高”,大概率不会出错,因为这个知识点很突出,可以牢牢记住。但是如果你问“隔壁老王有多高”,它可能会很困惑,因为它从来没有见过老王。

然而,它的设计原理决定了它必须接管它。这时,它会自动“想象”。根据“普通人有多高”的概念,编一个数字,这就是“幻觉”。

那幻觉是怎么产生的呢?

幻觉的本质是补白,是想象。

“白”是一个具体的事实。如果这个事实在训练数据中没有足够的信息冗余,模型就不会被记住(零散的事实相当于噪音)。如果你不记得了,就用幻觉来填补空白,编造细节。

幻觉绝不是无拘无束的随机编造。大模型是概率模型,约束是条件概率中的上述条件。幻觉选择的虚假事实需要与补白所需的value(价值)类型相匹配,即符合ontology/taxonomy相应的上位节点概念(本身/分类法)。“张三”可以幻想为“李四”,但不太可能幻想为“石头”。

文学理论中有一句话叫做艺术真理。所谓艺术真理,就是文学创作虽然可能偏离世界事实,但却是数字世界可能的合理想象。大模型的幻觉属于这种情况。

大模型的知识学习过程(训练阶段)是一个信息压缩过程;大模型回答问题是一个信息解码过程(推理阶段)。就像升级维度一样,降低维度。一个事实的冗余度不够,就会被泛化为一个高级概念的slot。在生成阶段,这个slot必须具体化。

“张三”这一事实被遗忘了,但“human"这个slot的约束仍然存在。找到最合理的补白, slot 一个概念最一致的实体,所以“李四”或“王五”的幻觉可以取代“张三”。小说家就是这样工作的,人物和故事都是编造出来的。作家和读者都不认为这是在撒谎,但他们追求的精神美在另一个方面。

大型模型也是如此,大型模型是天生的艺术家,而非死记硬背的数据库。“张冠李戴”、在模型幻觉中,“指鹿为马”是非常自然的。因为张和李差不多,马和鹿也在同一条延伸线上。从泛化和压缩的意义上来说,它们是相当的。

但是,在一定程度上,幻觉就是想象(褒贬不一),也就是创造力!好好想想。哪些伟大的文学作品和艺术作品不是异想天开,充满想象力?如果一切都和现实完全一样,艺术就会变成相机,那又有什么意义呢?

正如赫拉利在《人类简史》中所说,人类之所以能够成为地球霸主,是因为我们可以“讲故事”,创造现实中不存在的东西,如神话、宗教、中国和货币。这些都是“幻觉”,但它们是文明诞生和发展的动力。

DeepSeek-到底R1的幻觉问题有多严重?

它的幻觉问题非常严重。在此之前,学术界普遍认同OpenAI的说法,推理的增强会明显减少幻觉。我和一家大模型公司的负责人讨论过,他强调推理对减少幻觉的积极作用。

但是R1的表现却给出了相反的结果。

根据Vectara的测试,R1的幻觉率确实比V3高很多,R1的幻觉率是14.3%,明显高于其前身V3的3.9%。它加强了“思维链”(CoT)与创造力密切相关。R1在推理、写诗、写小说方面确实很厉害,但随之而来的“副作用”就是幻觉也多了。

具体到R1,幻觉增加的主要原因如下:

首先,幻觉标准测试使用摘要任务,我们知道摘要能力在底座大模型阶段已经相当成熟。在这种情况下,强化可能会产生相反的效果,就像用大炮打蚊子一样。过度的努力增加了幻觉和编造的可能性。

其次,R1长思维链的强化学习并没有特别优化对事实要求严格的任务,比如摘要、翻译、新闻写作,而是尝试在各个方面增加对所有任务的思考。

从它透明的思维链导出可以看出,即使面对一个简单的指令,它也会不厌其烦地从不同的角度去理解和延伸。物极必反,这些简单任务的复杂性会导致结果偏差,增加幻觉。

此外,DeepSeek-在强化文科任务学习和训练的过程中,R1可能会对模型的创造力给予更多的奖励,导致模型在生成内容时更具创造性,更容易偏离事实。

众所周知,R1对数学和代码的监管信号来自这些问题的黄金标准(练习册中的正确答案或代码测试案例)。他们利用V3或V3的奖励模型来判断文科任务的优缺点。显然,目前的系统偏好是鼓励创造力。

此外,客户的更多反馈是鼓励和欣赏他们看到的创造力。大多数人对幻觉的意识不敏感,尤其是大模型光滑流畅,更难识别幻觉。对于大多数一线开发者来说,客户的这种反馈很容易促使他们更加努力地加强创造力,而不是“幻觉”来应对大模型领域最头疼的问题之一。

从技术角度来看,R1会自动为用户的简单指令增加很长的思维链,相当于把一个简单明了的任务复杂化。

一个简单的指令,它也从不同的角度反复理解和延伸(CoT思维链就像“小九九”,是实体遵循指令时的内在独白)。思维链改变了自回归概率模型生成answer之前的条件部分,自然会影响最终的导出。

与V3模型的区别如下:

V3: query --〉answer

R1: query CoT --〉answer 对于 V3 可以很好地解决的问题,比如摘要或者翻译,任何思维链的长期引导都可能带来偏差或者发挥的趋势,从而为幻觉提供苗床。

什么领域主要出现大模型幻觉?

假如R1的能力分为“文科”和“理科”,那么在数学、代码等“理科”方面,它具有很强的逻辑性和较少的幻觉。

然而,在语言创作领域,尤其是现在测试的总结任务中,幻觉问题要明显得多。这更多的是R1语言创造力的爆发带来的副作用。

与o1相比,R1最令人惊叹的成就是成功地将数学和代码的推理能力充分延伸到语言创作领域,尤其是在语文能力方面。网上流传着无数精彩的R1篇章。在舞蹈和墨水方面,它显然超过了99%的人类,文学系的研究生甚至国学教授都很惊讶。

但是你看,让它做一个摘要原本是一个非常简单的任务,但是它必须“发挥”给你,这样很容易“编辑”原文中没有的东西。我前面说过,这是因为它的“文科”太强了,有点“用力过猛”。

在这里,我们不得不谈谈增强推理能力和幻觉之间的微妙关系。

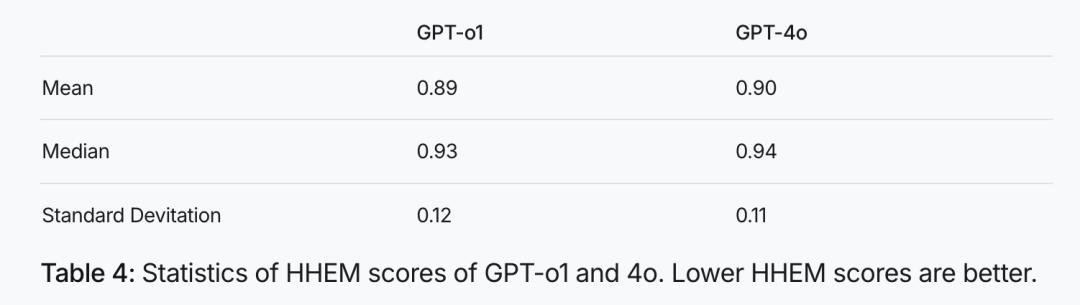

它们不是简单的成正比或负相关。GPT系列推理模型o1的平均HHEM分数和中位数低于通用模型GPT-4o(见下图)。但是当我们比较的时候 R1 以及它的底座模型 V3 当时,又发现增加推理后的幻觉确实明显增强了。

图:GPT-HHEM成绩和4o的统计数据显示,HHEM成绩越小幻觉越小。

o1与底座模型相比 减少幻觉,R1增强幻觉。,R1在文科思维链方面可能用力过猛。

作为追随者,R1成功地将数学和代码上的CoT赋能转移到了语言和文本创作上,但如果不小心,副作用就会出现。R1特别喜欢“发散思维”。如果你给它一个简单的指令,它可以想到很多东西,思维链可以绕地球三次。

这好像表明 R1 增强创造力的过程中,不可避免地增强了创造性的伴生产品:幻觉。

其实语言能力可以细分为两类:一类需要高创意,比如写诗、写小说;另一类需要高度的真实性,比如新闻报道、翻译或摘要。R1受到前者的高度赞扬,这也可能是R&D团队的关键方向,但在后者中有副作用。

这让我想起了中国古人所说的“信达雅”,自古以来就很难完成。我们看到了很多为“雅”牺牲“信”的例子,文艺创作中夸张的修辞手法就是重要的手段和例子。还有一个为“信”牺牲“雅”的例子,比如鲁迅先生推崇的“硬译”。

有趣的是,我们人类在这方面一直是双重标准,但我们心中有一个可以随时切换的开关。看小说电影的时候,我们把开关放在创意的一边,完全不用担心细节是真是假;但是一旦我们转向新闻频道,我们就零容忍虚假内容。

一个终极问题:怎样才能使大模型既有创造力又不产生幻觉?

人们倾向于相信逻辑清晰、自洽、详细的内容。很多人在惊艳R1创造力的同时,也开始逐渐注意到这种幻觉现象,开始提高警惕。然而,更多的人仍然沉浸在它给我们带来的创造性惊喜中,这需要增强公众对模型幻觉的概念。能够“双手抓住”:

提高警惕:大模型所说的话,特别是涉及事实的话,不要完全相信,最容易产生幻觉的地方就是姓名、地名、时间、地点、等待实体或数据时,必须特别小心。

交叉验证:重要的细节,可以在网上查看原始资料或者询问身边的专家,看看说法是否一致。

引导模型:您可以在提问时加入一些限制条件,比如“请务必忠于原文”、请检查事实等等,这能引导模型减少幻觉。

Search(网络搜索):对用户来说,很多问题,尤其是新闻时事方面,除了 DeepThink 按下按钮(进入R1慢思维mode),别忘了按下另一个按钮。 Search。

加入网络search后,幻觉会得到有效的减少。所谓的RAGRAGsearch(retrieval augmented generation)相当于一个额外的数据库,增加的数据可以帮助填充模型本身对细节的无知。

享受创意:假如你需要的是灵感,创造力,那么大模型幻觉,就会给你带来惊喜。

让我们把大模型的幻觉看作是“平行时空的概率”。就像小说家写小说一样,虽然是虚构的,但也是一种“艺术真理”。起源于生活,高于生活。大模型起源于数据,高于数据。大模型压缩的是知识结构和常识,而不是事实,而是数据库的目标。

大型幻觉,其实是它“想象”出来的,但是它“想象”的基础,就是它所学到的大量知识和规律。所以,其幻觉,常常不乱来,有“内在的合理性”,这才顺滑无缝,谎言说得像真的一样,但同时也更具欺骗性。第一次接触大模型的朋友,需要特别小心,不能轻信。

对于普通用户来说,理解幻觉的特征是非常重要的。比如问“湘江多久”这个百科知识问题,有足够的信息冗余,大模型不会出错。这些事实都刻在模型参数中。但是,如果你问一条不知名的河流或虚构的河流长度,模型将启动“合理补白”的机制编造。

人类的语言本来就是幻觉的苗床,可以说。

语言促使人类创造了神话、宗教、中国、企业、货币等非真实实体的概念,以及理想、信仰等形而上的意识形态。赫拉利在《人类简史》中强调幻觉对文明的根本作用:语言的产生赋予了人类幻觉(“讲故事”)的能力。幻觉是文明的催化剂。人类是唯一会说谎的实体 -- 除LLM外。

将来有什么办法,可以让大模型既有创造力,又不会产生幻觉?

在AI大模型领域,这绝对是一个“终极难题”!如今,每个人都在想办法:

更加精细的训练:训练时,便区别对待不同类型的任务,让模型知道何时应该“诚实”,何时可以“放飞”。

对任务进行喜好微调(finetune) and/or 加强(rl)这种矛盾可以减缓。摘要、改写、翻译、报道等任务需要特别小心和平衡,因为它不仅有一点再创造的需求(比如风格),而且天性需要忠实的内容。

具体来说,R1训练pipeline有四个过程:微调1、强化1、微调2和强化2。强化2主要是强化与人类偏好的对齐。在创造力和忠诚度方面,这个过程目前似乎倾向于前者,然后可以再次平衡。或许更重要的是,在第三阶段的微调2中,根据不同的任务加强约束,比如增加总结的监管数据,引导忠诚和诚实的结果。

Routing(路径):将来可能会有一个“调度员”,根据任务的类型安排不同的模型来处理。比如简单的任务交给V3或者调用工具,慢慢思考的复杂任务交给R1。

例如,识别算术任务,就去写一个简单的代码计算,等同于调用计算器。现在不是这样了,我昨天测试了一个九位数乘法,R1。 想了三分多钟,直接打印思维链可以铺开一条街,循序渐进地分解推理。尽管最终答案是正确的,但是所谓的算术问题消耗太多。 test time compute(模型测试计算资源) 的思维链(CoT),而不用 function call(调用函数),完全不合理。一行计算代码就能完成的事情,没有必要消耗那么多的计算资源和tokens来进行显式推理。

这是可以预见的 Routing(实现路径),尤其是agent时代。R1 CoT不需要包打一切,而且除了幻觉问题,还会浪费资源,不环保。

本文来自微信微信官方账号“腾讯科技”,作者:郭晓静,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com