字节跳动与科大讯飞:AB面大模型之战

经过近两年的赛车比赛,中国大型跑道正在加速分化。

分化首先体现在大模型创业公司的路径选择上。2024年,曾经吸引更多公众关注的“大模型六虎”开始走向不同的方向。

百川智能已经转向行业大模型;月亮的暗面和MiniMax的战略优先是C端产品和应用;零一万物采用“大工厂” “小虎”的合作范式,将超大型模型交给阿里进行培训,负责小参数和适度的行业模型;智谱AI和阶跃星仍然专注于大型AGI模型。

从这个角度来看,中国大型模型产业越来越明显的事实是,“百模对决”正在加速退潮。从创业公司到大企业,大部分玩家都在思考自己应该在模型和AI的浪潮中扮演什么角色,如何更好地落地技术,是关注中国市场还是出海,如何创造多元化的价值。

不管是To还是To C还是To B,面对2025年,行业已经达成新的共识——接下来,大模型将继续走出同质化,进入技术水平、落地进步、商业化的阶段。

从2024年的市场表现来看,字节跳动和科大讯飞是两个值得关注的样本。

在过去的一年里,字节跳动在C端表现得引人注目,展现了后来者的姿态。现在,在全球范围内,从月活规模来看,豆包App已成为ChatGPT的AI应用,仅次于OpenAI。

另外一边,科大讯飞在To。 B跑道呈现出领先的姿态。

根据第三方机构智能超参数发布的《中国大模型中标项目监测报告(2024)》,2024年,科大讯飞以91个中标项目披露中标金额84780.8万元,排名第一,成为2024年中标王——从公布的中标金额来看,这是百度的两倍,智谱AI的八倍。

图源智能超参数

其背后,作为中国大模型产业现在分别在C端和B端领先,他们走过的道路并不容易,但都有一定的启示意义。

在两条大型跑道上,科大讯飞和字节跳动各自领先。

字节跳动在模型跑道上进入并不早,但是发展速度很快。

根据DataEye研究院的不完全统计,自2024年8月以来,字节跳动在AI领域推出了17个大模型和2个智能体开发平台,包括豆包大模型家族。

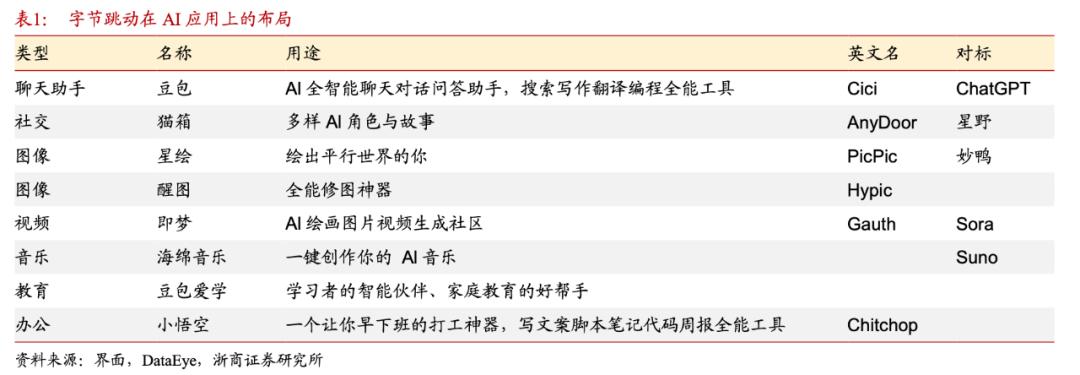

字节旗下更多的C端AI应用也在加速推出。自2024年以来,字节跳动已经在国内外推出了包括豆包在内的20多个应用,涵盖了AI聊天助手、AI视频工具、AI娱乐应用、办公等诸多领域。

图源浙商证券

相应地,字节跳动遵循了过去“大力创造奇迹”的战略游戏。据浙商证券统计,2024年,字节跳动在AI方面的资金支出达到800亿元,甚至接近百度、阿里、腾讯的总和(约1000亿元)。

市场研究机构Omdia的研究还表明,2024年字节采购了约23万个英伟达芯片,成为仅次于微软的英伟达全球第二大客户。

字节跳动在今年的C端应用中,在投入更大、布局更广的情况下,迅速完成了对C端应用的追赶。

截至十一月,豆包App每月活跃用户已接近6000万,MAU增长率已达16.92%。

从另一个角度来看,在普通用户难以感知的大型To模型中, B市场,科大讯飞脚踏实地,积累领先优势。

不同于字节跳动的“后发先至”,大模型浪潮袭来后,科大讯飞在一定程度上属于“先给先至”。

在OpenAI于2022年底发布ChatGPT后,科大讯飞迅速跟进模型布局,并在接下来的两年里,迅速确定了技术思路和技术路线,并完成了多轮技术迭代。

OpenAI发布ChatGPT仅仅半个月后,科大讯飞就决定要把资源压上去做大模型,同时它还提出要做大模型“1” N""1"是指一般认知智能模型,"N“指在教育、办公、汽车、人机交互等诸多领域落地。

当时科技大学迅速拉通了核心R&D平台的15个方向团队,专门成立了一个大型重点组,内部分为四个项目组,分别致力于“计算能力和训练框架”、“数据构建”、“推理框架和服务”、“算法研发和大型模型研发”。科技大学讯飞研究院院长胡国平后来回忆说:“这么大规模的‘战斗’在讯飞研究院历史上是罕见的。”

此后,科大讯飞的讯飞星火大模型加速迭代。

一月十五日,科大讯飞正式发布了星火深层推理模型x1,同时推出了星火语音同传模型。另外,讯飞星火4.0Turbo的基础能力和行业能力也得到了重新升级。

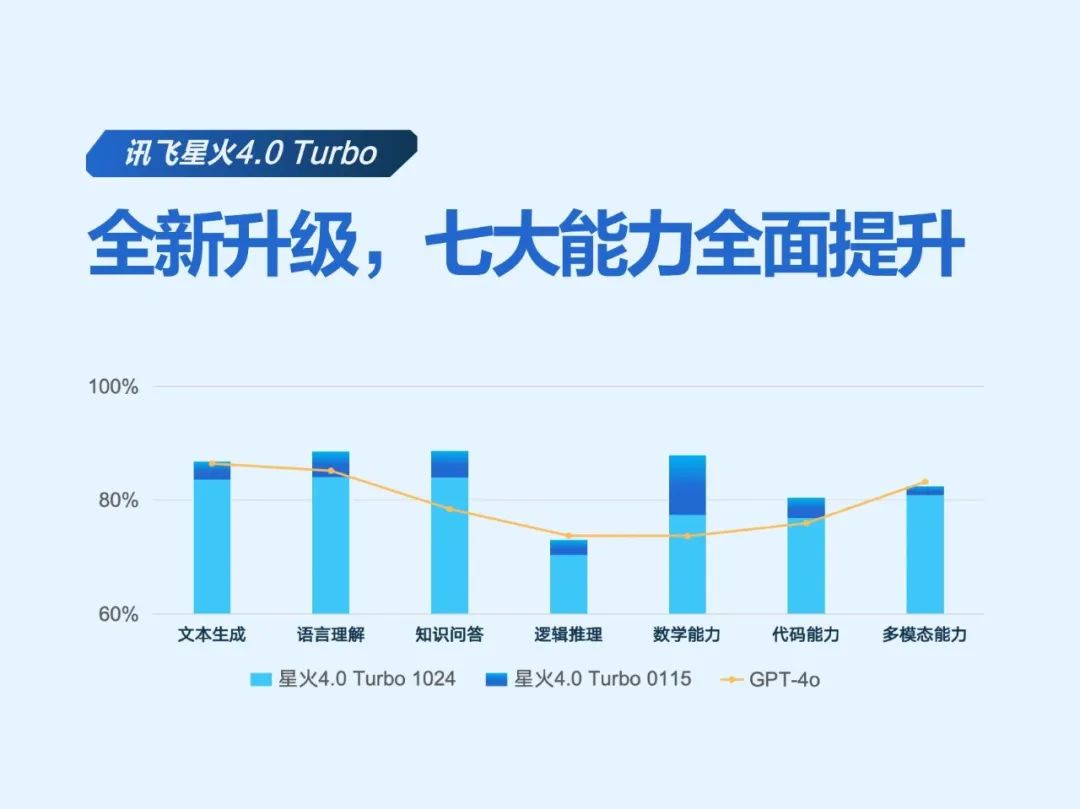

早些时候,科大讯飞发布了讯飞星火4.0 Turbo,七大核心能力全面超过GPT-4 Turbo,在GPT-4o中,数学和代码能力超过了GPT-4o,国内外中英文14项主流测试集中完成了9项第一。

科大讯飞从大模型的落地进展来看,也走在了行业的前列。

另一方面,如上所述,2024年,科大讯飞是通用大模型制造商中的“标王”。;

另外一方面,同样在2024年,科大讯飞的星火大模型也获得了六项“第一”:中国企业中标第一,教育医疗市场第一,智能汽车市场第一,大模型开发者生态第一,智能产品市场第一,赋能科研应用第一。

由此不难看出,跑马圈地两年后,在To之后, C和To 在这两条路线上,行业格局已经明确——字节跳动和科大讯飞,率先跑在前列。

科大讯飞和字节跳动在“中标”背后如何回答问题?

客观地说,无论是字节跳动在模型C端应用中的“反击”反超,还是科大讯飞在B端落地探索,都不容易。

对To 对于C的大模型应用,首先推理成本高,然后厂商在考虑产品市场匹配度时,需要考虑技术需求、技术难度、成本等因素,也需要把握时间窗口。此外,与海外相比,国内用户在实践商业路径时的支付意愿相对较弱。

换句话说,如果你想做一个好用又受客户欢迎的大型应用,它代表了更高的投资成本和不确定的回报周期,这就是为什么这两年很多大型创业公司都把注意力转向了海外。

如何持续吸引新客户,提高用户留存率,是另一个挑战。

从字节跳动在模型领域的良好布局来看,它显然希望自己能够成为更多爆款应用程序的先锋,并有更大的潜在机会。

首先,字节跳动不缺资金,不缺技术,不缺人才,也不缺投资的决心;

其次,字节跳动早年在移动互联网时代成功。 C的经验,现在也成了它的差异化优势。举例来说,与竞争对手相比,字节有更多的流量来支撑应用的快速起量。

最后,如今的字节对顾客的需求也越来越敏感,反应速度也越来越快。

12月11日,据媒体报道,字节提高了即梦产品的优先级,试图通过新的路径打造AI时代的“抖音”——即梦AI属于字节跳动的剪影业务,定位为AI内容平台,支持通过自然语言和图片输入生成高质量的图像和视频。

据报道,字节计划随后将更多资源转移到更多模式的产品形式,即梦想将承担更大的希望。

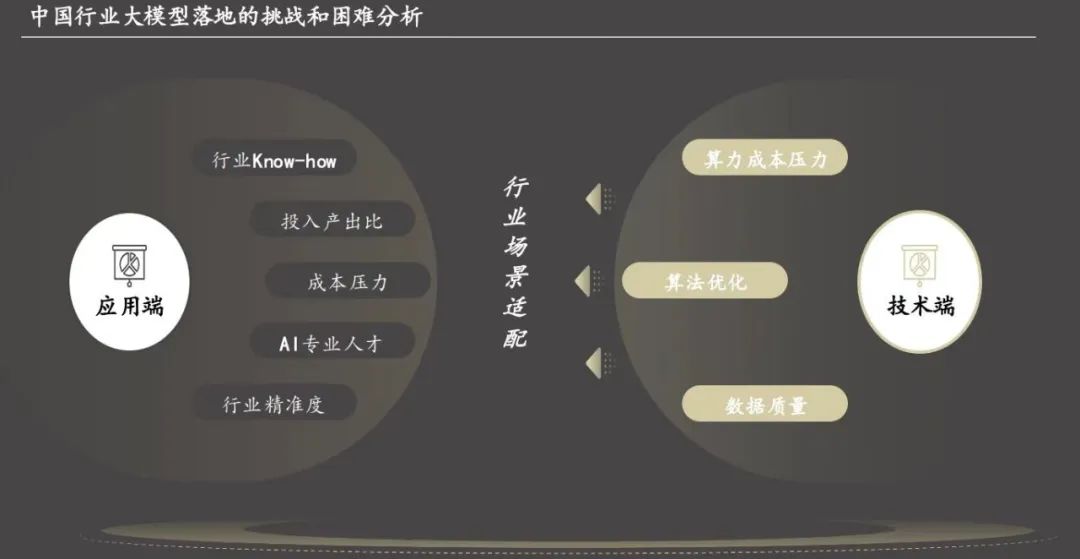

让我们看看B端。如今,大模型的竞争已经演变成系统对抗——要建立一个企业真正可以使用的大模型,就需要具备构建计算率、数据治理、模型培训、场景实施、应用建设、可持续运营、安全合规的整套能力,以及各种规范的软件产品,如数字人、客服助手、代码助手等。,以及场景落地时的软硬结合。

简而言之,大型模型落地在B端,难点在于“交付”,需要大型模型制造商首先成为“六边形战士”。

从企业的角度来看,在这个阶段,人们对大模型的需求变得更加务实,不仅要关注模型技术的领先地位,还要看如何整合需求场景,如何降低成本解决实际问题。

图源《2024 中国产业大模型市场报告

科技大学讯飞的回答路径,为我们提供了一个B端观察窗口,透视大模型落地。

“为什么我们中标人数第一,中标比例越来越高?因为很多企业只能做第三步,也就是训练模型,后面的步骤和我们差距很大。即使他们能做到,他们实际上也有能力整理数据和训练模型,这与我们有很大的不同。”科大讯飞创始人刘庆峰此前说过。

相应地,科大讯飞为企业大模型建设提供了从顶层规划到实施的全套解决方案:“计算率、数据管理、培训模型、场景、安全、精细化运营”。

在计算率方面,2023年,科大讯飞和华为联合成为中国第一个万卡计算率集群“飞星一号”。在升腾910B的基础上,克服了许多疑难疾病,解决了500多个基本软硬件问题和模型适应问题,使得大型模型训练从20%-30%提升到90%以上,比A100/A800。

2024年10月,由科大讯飞联合华为、合肥大数据资产运营有限公司打造的国内超大型智算平台“飞星二号”也正式启动,将带来新模型、新算法的持续适应和智算集群规模的再次转变。

刚刚发布的深层推理模型X1,是基于“飞星一号”打造的深层推理模型训练框架,完全适应了华为的计算能力,突破了树木搜索加速、异步推理调度等技术难题,以更少的计算率完成了行业一流效果。国内多项指标排名第一,是国内计算率集群与英伟达集群相比的又一关键里程碑。

在“数据管理和培训模型”方面,科大讯飞完整的工具链也大大提高了效率——数据清洁效率提高了24倍,数据建设效率提高了90%。、平均情景优化效果提高30%、知识采编效率提高了5倍。

截至2024年10月,科大讯飞已与各头部企业共创20多个行业大模型,覆盖300多个应用领域,再到更关键的行业场景。

刘庆峰还提到,这些已经落地的实际应用案例已经形成了相互学习和重用的规模效应。“每个企业建成后,我们都会为其他公司找到很多可重用的。很多央国企的龙头企业在完成这个领域后,可以推广到整个行业,也可以在不同的行业互相学习。”

可以预见,讯飞星火大模型在B端落地,在一定程度上就像星火燎原。从长远来看,它可能会给科大讯飞带来更多的想象空间。

随着商业化考试的临近,领跑者将加速“正向循环”

到目前为止,另一个越来越明显的事实是,淘汰赛已经陆续上演。

在这种背景下,不管是To。 C市场仍然是To B市场,在日益激烈的市场竞争中,领导者继续保持竞争优势,追赶者抹平差距,直接追赶。基本上只有一条路:

在技术方面保持敏锐度,在迭代和优化速度上打“持久战”,做好大模型技术与应用、场景的结合。

那也是科大讯飞和字节跳动正在做的事。

科大讯飞全球1024开发者节前段时间,除了发布讯飞星火4.0 除了Turbo之外,科大讯飞还推出了基于讯飞星火底座能力的10个产品和创新应用:

包括定义多模AIUI标准、发布超拟数字人、发布星火多语言模型、讯飞星火医学影像模型、汽车侧星火模型等。

一月十五日,科大讯飞迎来了许多新技术升级。

该公司发布了星火深层推理模型X1,是目前行业内唯一的国内计算能力平台深层推理模型。在此之前,X1参加了小初高(包括比赛)、大学(包括竞赛)、AIME、MATH500多次考试,交出了亮眼的成绩单:用较少的算率,达到行业一流效果,多项指标在国内排名第一。

另外,科大讯飞还发布了国内首款具有端到端语音同传能力的大型模型——星火语音同传大型模型。

星火语音同声传译模型支持不同延迟的翻译模式。在5H音视频测试中,8s延迟模式在内容完整性和信息准确性等评价维度上超过了谷歌的Gemini2.0、OpenAIGPT-国外主流大型模型如4o。

讯飞星火4.00基于不同行业龙头企业的落地需求和C端2亿多客户的真实反馈。 Turbo还进行了新一轮升级,全面提升了七大核心能力。

其中,讯飞星火4.0 升级版Turbo的文本生成技能提高了3.2%、提高了4.5%的语言逻辑技能、知识问答技能提高了4.7%、逻辑推理能力提高了2.6%、提高了10.5%的数学能力、提高3.5%的代码能力、多模态技能提高了1.6%。

此外,在长文本能力和图形能力方面,讯飞星火也进行了升级,并推出了混合知识搜索技术——无论是个人知识、公司知识、业务系统数据、优秀的行业数据还是互联网信息,一个问题都可以得到综合搜索的结果,大大提高了信息搜索的效率。

可以看出,基于基础能力的不断升级,科大讯飞在B端不同行业、不同场景的落地广度仍在拓宽,深度仍在延伸,价值也在不断释放。

在医疗行业,基于讯飞星火医学影像大模型的智能医学影像助手可以帮助影像技术人员在智能质量控制阶段快速评估图像质量,及时纠正问题;在智能诊断阶段,可以帮助影像医生快速生成检查报告;在智能电影阅读阶段,临床医生也可以通过相关问答帮助制定诊疗方案。

在司法场景中,法律模型可以赋能司法场景,如审判笔录制作、裁判文书编写、法律案件检索等。与星火通用模型相比,效率从61.7%提高到87.9%。

在这个过程中,科大讯飞对大模型落地路径的长期规划,也想得更清楚了。

比如刘庆峰之前说过,“今天是一个全新的大模型落地时代,通用模型与专用模型相结合,端侧模型与云模型相结合,软硬件相结合。”

比如,它不仅希望成为一个在大模型浪潮中走得更快的公司,也希望帮助更多的公司走得更快。第一个同声传译模型帮助中国企业出海,就是一个鲜明的例子。

目前字节跳动正在加速建设,在一定程度上也是这样一条“正向循环”的未来路径。——

通过更大规模、更大决心的投入,可以促进大模型技术的快速迭代和升级,从而赋能C端用户和B端客户。即使C端用户的回报周期比较长,也要用耐心换取未来,然后用商业反馈技术进行投资。

但是,在技术的基石上,字节跳动作为C端应用的思路本质上类似于科大讯飞深入B端逻辑——科大讯飞试图更接近客户,字节跳动试图更接近客户。

这种做产品和服务的态度,是字节跳动几乎半年就从后面来的根本原因,也是科大讯飞“领先一步,提前一路”的根本原因。

本文来自微信公众号“连线insight”(ID:lxinsight),作家:陈锋,编辑:子夜,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com