荣誉与背叛:字节诉讼遇到NeurIPS最佳论文

2024年12月3日,在这个距离年底只有27天的时间里,字节跳动前的一名见习生发生了一起非常戏剧性的AI事件。

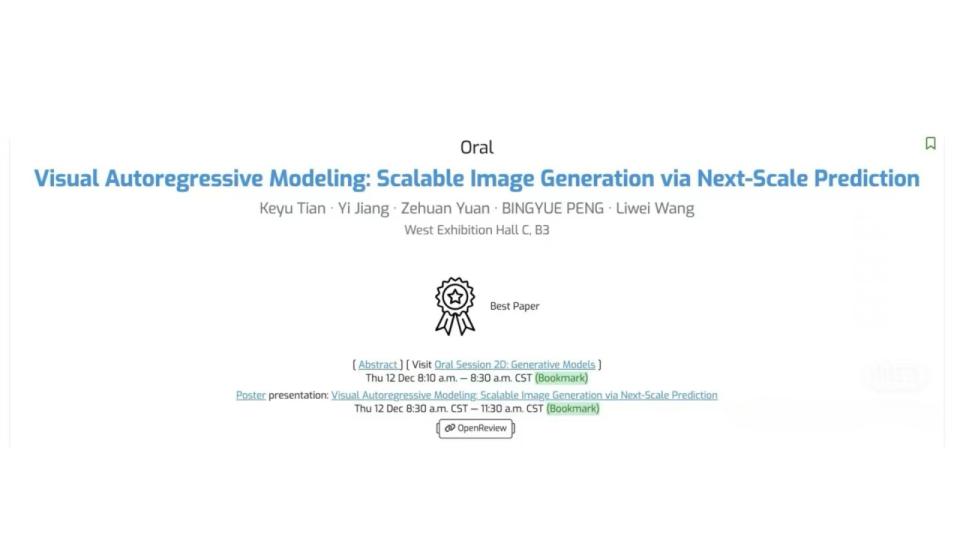

凭借在视觉生成领域的开创性工作,北京大学研究生田柯宇获得了NeurIPS大会最佳论文奖。

NeurIPS在人工智能领域的学术圣殿中的地位堪比文坛诺贝尔奖。它成立于1987年,见证并促进了从简单神经网络到现代深度学习的整个革命过程。

然而,在颁奖当天,NeurIPS很可能会面临一把空椅子。因为获奖者田柯宇因涉嫌破坏其AI训练系统而面临字节跳动800万元的诉讼。

公司的罪人和学术天才

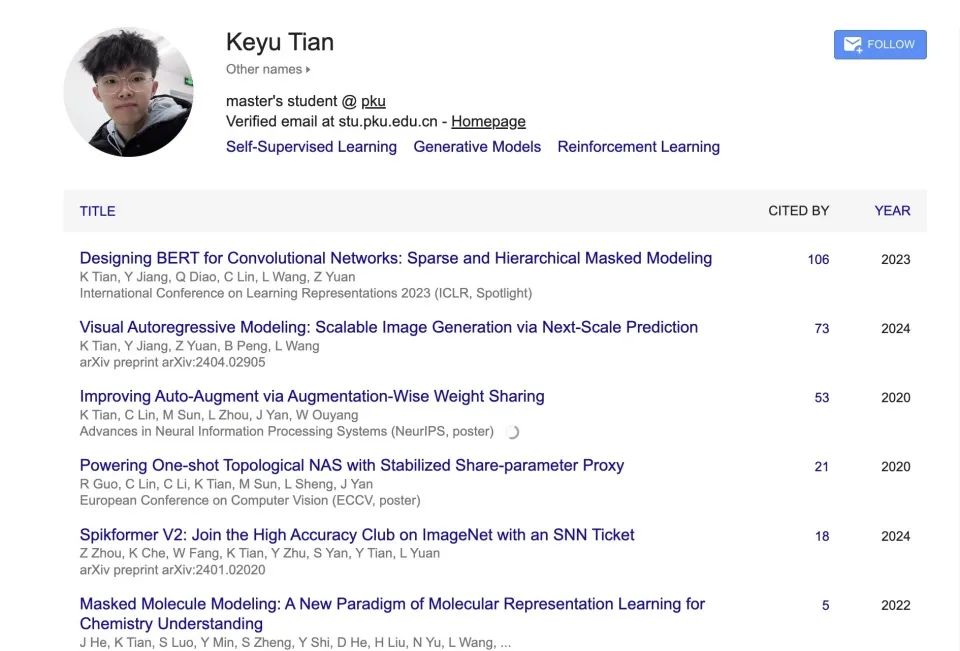

田柯宇的学术简历是完美的:本科毕业于北京航空航天大学软件学院,然后进入北京大学攻读研究生学位,向著名学者王立威教授学习。

他的研究重点是深度学习优化和算法。在学位期间,他已经在许多顶级会议上发表了文章,包括ICLR。 Spotlight论文2023《Spark:Designing BERT for Convolutional Networks》,这是引用量最高的论文。

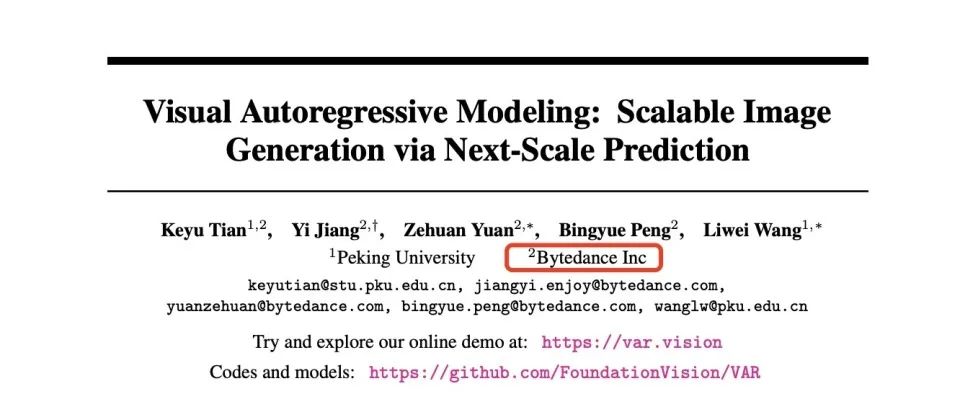

2021年,田柯宇开始在字节跳动商业技术部门实习。在这里,他参与了一个雄心勃勃的项目:开发新一代视觉生成模型。这后来被称为VAR(Visual Autoregressive Modeling)项目,试图完全改变AI生成图像的方式。

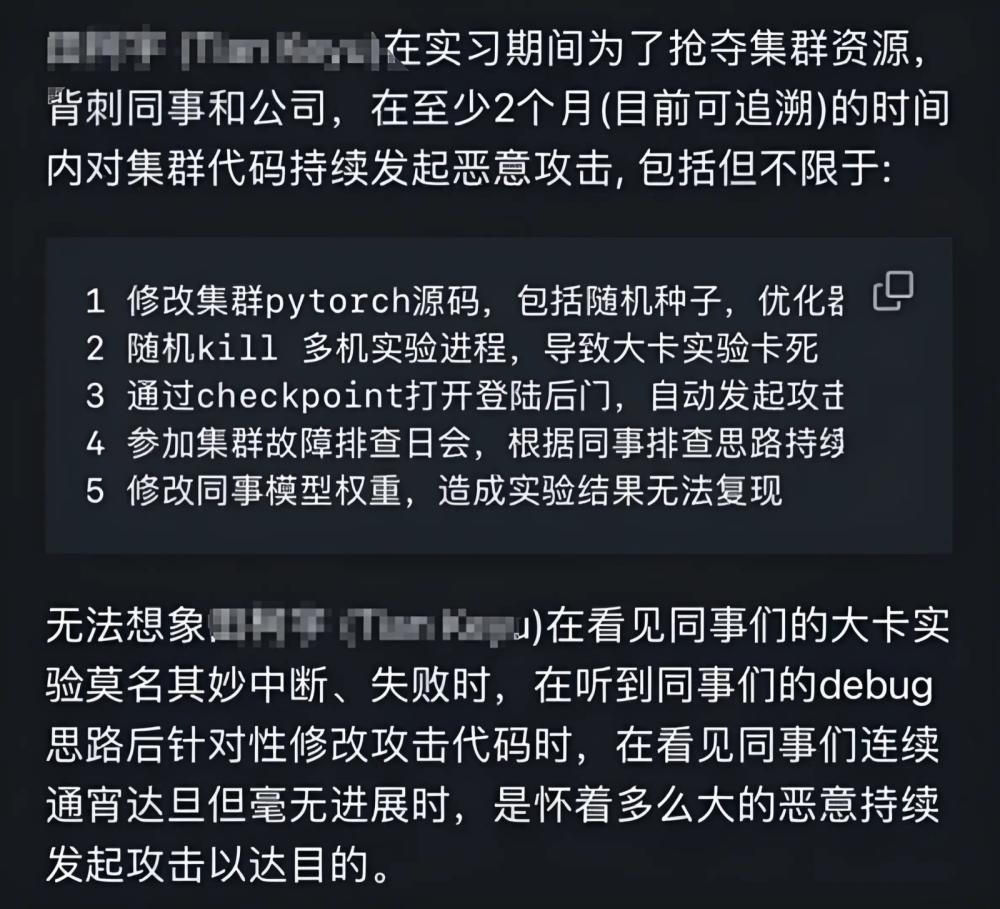

不过,今年十月十八日,字节见习生“下毒”模式的聊天截图开始在网上流传,给企业造成了巨大的损失。

这个事件的细节随后得到了更多的披露。矛头很快指向田柯宇。

一位知情人士在GitHub上发声,描述了这场持续两个月的“数字破坏”:“在此期间,他系统地破坏了集群代码,直接导致近30名同事的工作成果流失,整个季度的努力消失了。所有的日志记录和系统审查都指向一个不可辩驳的事实。”

十月二十一日,界面新闻从知情人士处了解到,字节跳动内部已经调查清楚了这件事是为田姓见习生所做的。

事件曝光后,北京大学高材生试图通过社交媒体证明自己的清白,声称真正的毁灭者是另一个人。

(网上发布的田柯宇在社区中的回复)

这种“扔锅”行为很快被接近字节跳动的人反驳。一位不愿透露姓名的字节内部人士向《ThePaper》透露了企业的处理逻辑:考虑到田柯宇的博士身份,企业最初选择了相对温和的处理方式,并将其解雇并提交给学校进行处理。这也体现在字节的官方回复中。

但是,在田柯宇的一系列反应中,情况急转直下。随后,他不但多次公开否认控告,声称真正的攻击者是其他见习生,甚至报警称自己是造谣受害者。这种拒绝承认错误,反咬一口的态度,最终耗尽了字节的耐心。“他根本没有意识到自己的错误特征和严重程度。”据《ThePaper》采访内部人士称,“这种做法触及了公司安全管理的红线。“最终,字节跳动决定通过法律途径追究责任,以身作则,避免类似事件重演。

据《南方都市报》11月27日报道,北京市海淀区人民法院正式受理字节跳动起诉前实习生田某某篡改代码攻击企业内部模型培训案。字节跳动要求法院责令田某某赔偿侵权损失800万元和合理支出2万元,并公开道歉。

这样也反映了当初字节极力否认的网爆“1000万”的损失。

但也就是说,在字节工作期间,田柯宇描述了他的获奖论文,得到了高度认可。五位论文作者中有四位来自字节,田柯宇是第一位作者。

获奖论文认可度极高。

要理解NeurIPS最佳论文的重量,不妨回顾一下2014年的历史时刻。那一年《Sequence to Sequence Learning with Neural Networks》没有得到最好的论文,只进入了oral(口头演讲)阶段。

这篇文章来自Ilya Sutskever、Oriol Vinyals和Quoc V. Le之手的论文不仅仅是一种学术成就,更像是一条全新的人工智能路线。

三位当时还默默无闻的作者,现在已经成为AI领域的标志性人物:Sutskever已经成为OpenAI的创始人,在GPT系列开发中发挥了核心作用;Vinyals在DeepMind中占据了AlphaFold的突破;Le在Google中占据了领先地位; Brain推动了大语言模型的创新。在今天的ChatGPT中,他们的序列是序列学习框架。、像Claude这样的自回归语言模型奠定了理论基础。

而且当年获得最佳论文的李平教授,在回国后曾担任百度首席架构师(T11)和百度研究院副院长。

NeurIPS的录用门槛非常严格,获得这个奖项有多难?

据统计,以2023年为例,大会收到12,343篇投稿,最终接受率为26.1%。并且可以当选口头报告。(Oral)论文更是凤毛麟角,一般不到1%。

在这种背景下,VAR论文不仅当选了Oral,还以近乎满分的考试成绩(7,8,8,8)获得了最佳论文荣誉,其学术份额可见一斑。同一实验室的田柯宇北大同学告诉腾讯科技,这篇论文是第一篇来自中国大陆NIPS的最佳论文。

这篇题为《视觉自回归建模:基于下一个规模预测的可扩展图像生成》的论文于2024年5月发表,代表了AI系统生成图像方法的重大进展。

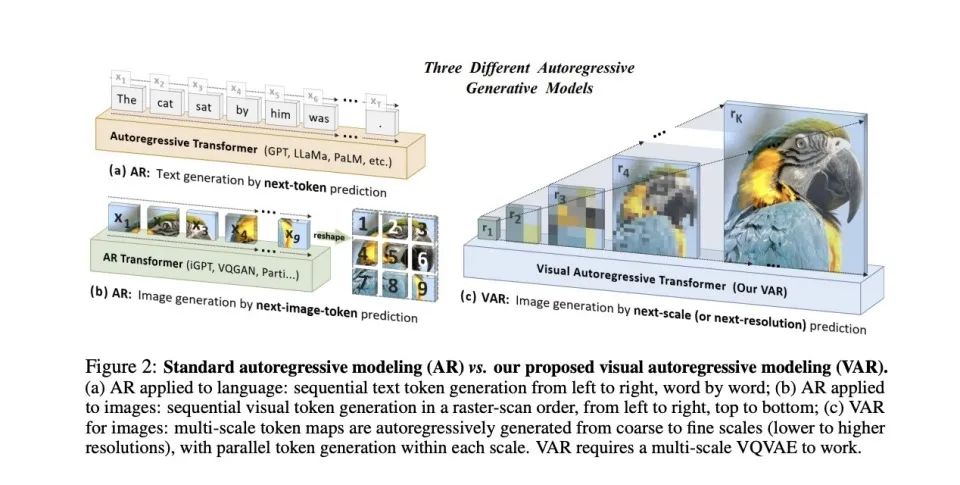

传统的图像生成方法就像从左到右、从上到下填写一页纸上的文字。VAR采用了更贴近人类直觉的方法:先勾勒出大致的轮廓,再逐渐添加细节。

具体而言,VAR包括两个训练阶段:首先通过多尺度VQVAE将图像编码为不同分辨率的标记投射,然后对VAR进行训练。 为了预测更高分辨率的细节,Transformer。

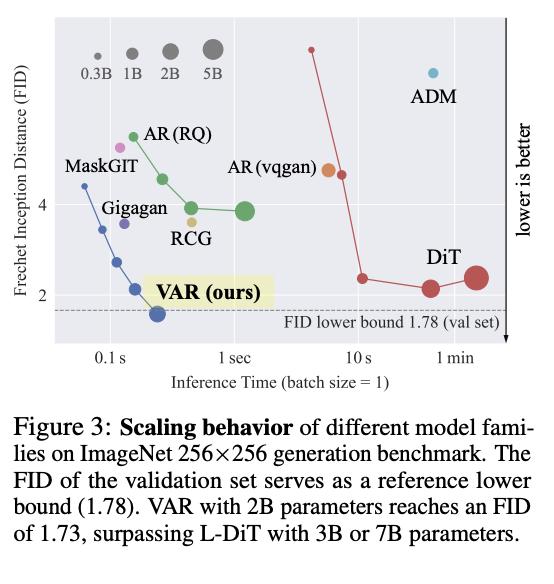

本论文提出的视觉自回归建模(VAR)该方法首次证明了GPT模型在图像生成方面可以超越扩散模型——这是许多人认为不可能的里程碑。ImageNet 256×VAR在256基准测试中将图像质量评估指标FID从18.65提高到1.73,生成率提高20倍。

此外,VAR还展示了以前只在大型语言模型中看到的特征:清晰的幂律缩放和零样本泛化能力。

简单来说,系统可以随着规模的增加而变得更好,并且可以处理没有经过特殊训练的任务——这是更高级AI系统的象征。这些特征暗示着视觉AI可能与语言AI走向统一。

现在,VAR代码已经在GitHub上开源,获得了4400多个星标。

从其技术价值和实际荣誉来看,这篇论文和田柯宇的科研认可度极高。然而,正是因为如此,他让前公司字节陷入了两难境地。

两难的字节

对于字节跳动来说,田柯宇大模型“下毒”事件所带来的打击远比表面上看上去严重。

更为戏剧性的是,当VAR论文在NeurIPS中享有盛誉时,字节跳动却陷入了进退两难的境地。

字节跳动作为一家中国科技公司,渴望在AI领域与谷歌、OpenAI等全球巨头竞争,在人工智能基础研究上投入了数亿资金。这项突破性研究确实起源于字节实验室,但公司很难在学术社区大张旗鼓地宣传这一成就——因为论文的第一作者正在被企业起诉。

这种矛盾指的是目前公司管理的一些困境:如何将有效资源分配给有才华的科学家,给予个人更高效的表彰?在字节越来越大的情况下,这个问题变得越来越难解决。尤其是在OpenAI、在Anthropic等竞争对手普遍采取更加开放的研究政策的背景下,大型企业在吸引和保留顶级AI人才的战争中,很可能会因为组织结构问题而失败。

更令人深思的是,田柯宇能够如此轻松地破坏训练系统,显示出字节在核心技术安全控制方面的致命漏洞。这无疑是一个响亮的警钟,对于一个拥有数亿用户信息并运营多个AI模型的科技巨头来说。

本文来自微信微信官方账号“腾讯科技”,作者:郝博阳,编辑:郑可君,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com