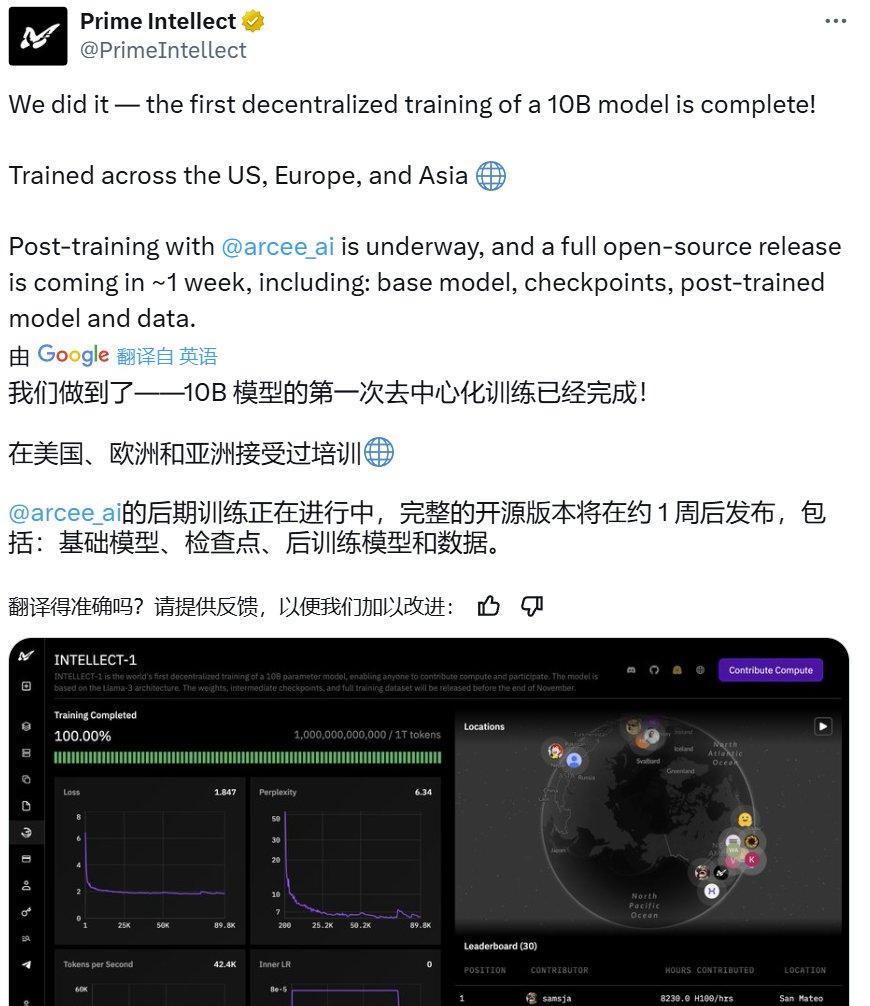

美国、欧洲和亚洲的开发者联合起来,世界上第一个大型团队训练模型已经到来,全过程开源。

11 月 22 日,Prime Intellect 宣布通过去中心化训练完成了一次。 10B 模型。30 数字,他们开源了一切,包括基本模型,检查点,后训练模型,数据,PRIME 训练框架和技术报告。据了解,这可能是迄今为止第一次通过分散训练获得的。 10B 大模型。

技术报告:https://github.com/PrimeIntellect-ai/prime/blob/main/INTELLECT_1_Technical_Report.pdf

Hugging Face 页面:https://huggingface.co/PrimeIntellect/INTELLECT-1-Instruct

GitHub 地址:https://github.com/PrimeIntellect-ai/prime

感受链接:chat.primeintellect.ai

Prime Intellect 表示,与之前的研究相比,INTELLECT-1 完成了 10 规模翻倍。这个突破证实,大规模的模型培训已经不再是大公司的专利,而是通过去中心化、社区化的方式来实现。

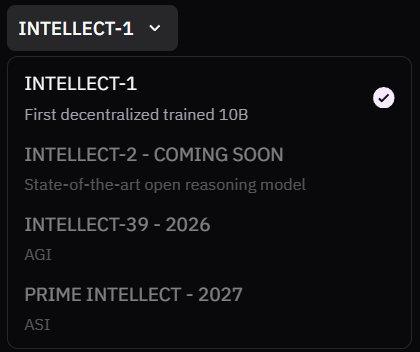

下一步的计划是进一步将模型扩展到前沿规模,最终目标是实现开源。 AGI。这个问题在它的网上 Demo 在模型列表中已经有了暗示 —— 包括开放推理模型甚至开放推理模型 AGI 和 ASI 潜力选择。看起来这的确是一支雄心勃勃的队伍。

模型发布后,虽然也有疑问声音, AI 总的来说,社区还是给予了很积极的认可。

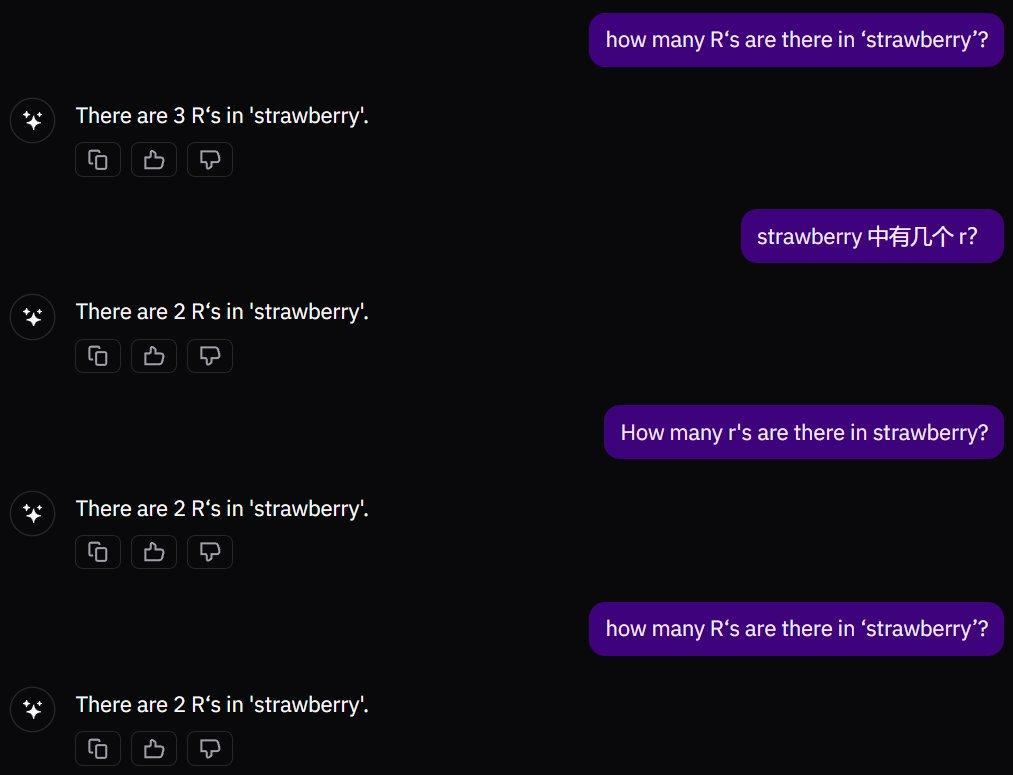

机器之心也简单尝试了几个经典问题。 Demo 模型版本。

第一个是经典的草莓问题,INTELLECT-1 一开始答对了,但是继续提问又成了一个常见的错误答案。

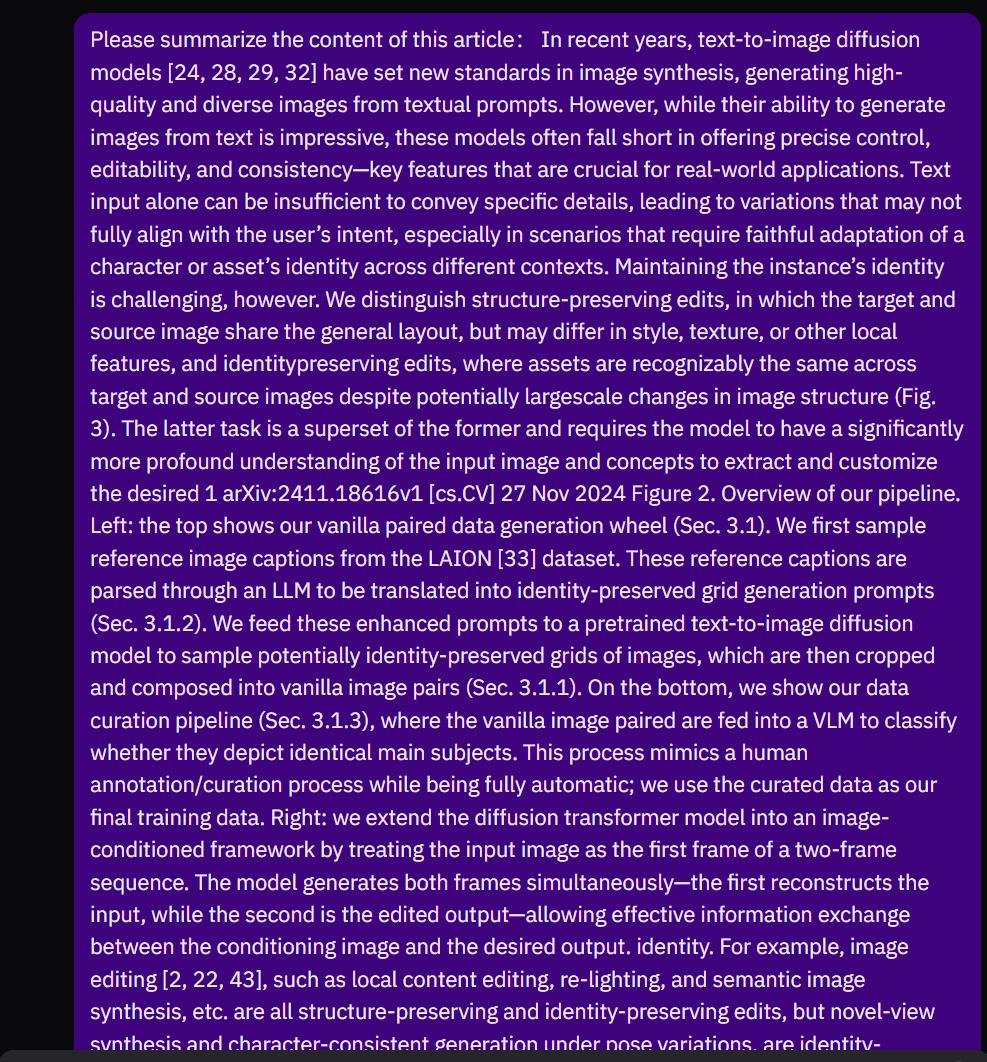

这个模型也有很好的理解文本的能力,但是总的来说和 Llama 和 Qwen 等待前沿开源模型仍然存在差距。

让我们来看看它的中文能力。从几次测试的结果来看,这个模型的中文能力并不好,幻觉现象似乎相当严重。例如,在下图中,即使这个模型暂时没有阅读链接的能力,它也会根据前后文字强制回答。

无论如何,INTELLECT-1 都是 AI 这是历史上一次极具开创性的实验。接下来我们来看一下这个系统是如何制造的。

大规模的分散训练

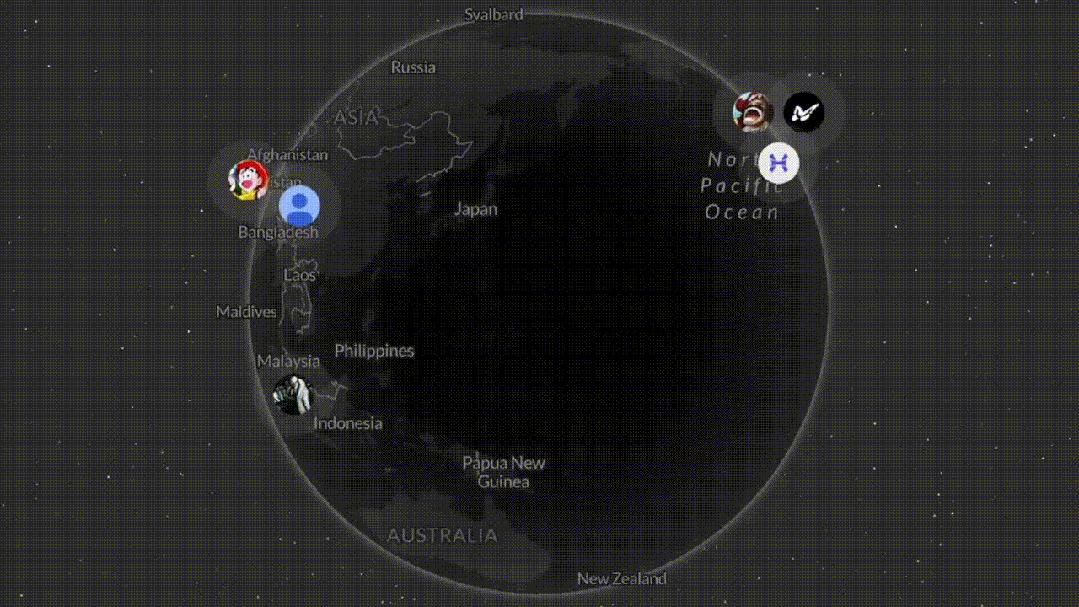

Prime Intellect 事实上,这次去中心化训练的规模相当大,涉及到 3 个大洲的 5 一个国家,同时运作 112 台 H100 GPU。

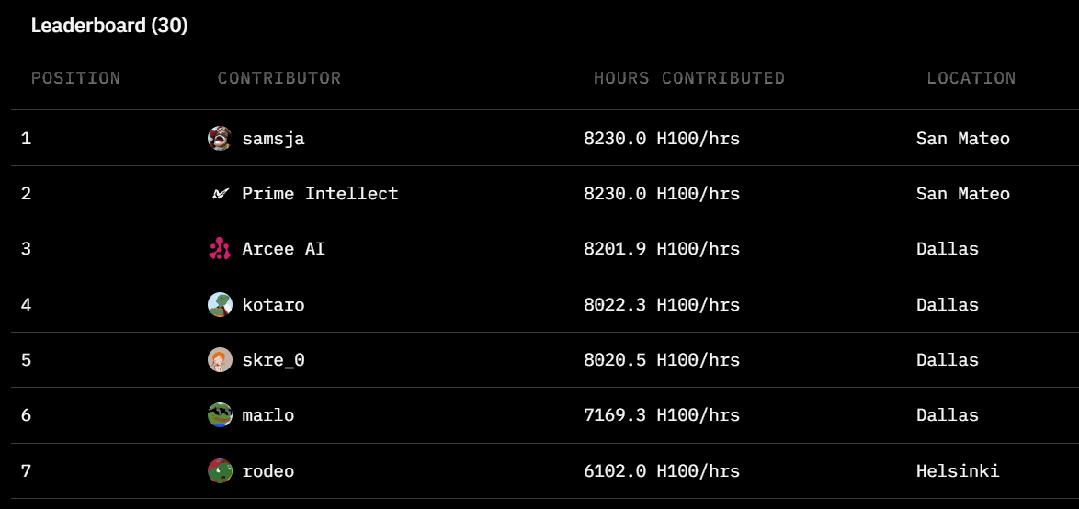

全球 30 位推动者的相关信息

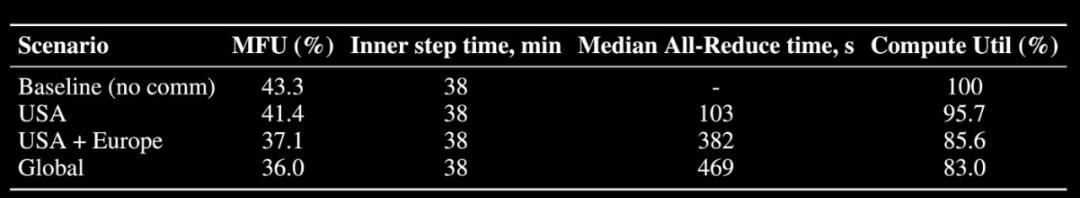

这个团队说:「我们已经完成了各大洲 83% 整体计算利用率。只有在整个美国节点上进行练习时,才能完成。 96% 计算利用率。与集中训练方法相比,费用非常小。」

这种结局说明 INTELLECT-1 如果存在严重的带宽限制和节点波动,仍然可以保持训练收敛和高计算利用率,这表明了一个新的概率:能以去中心化、社区驱动的方式训练出前沿的基本模型!

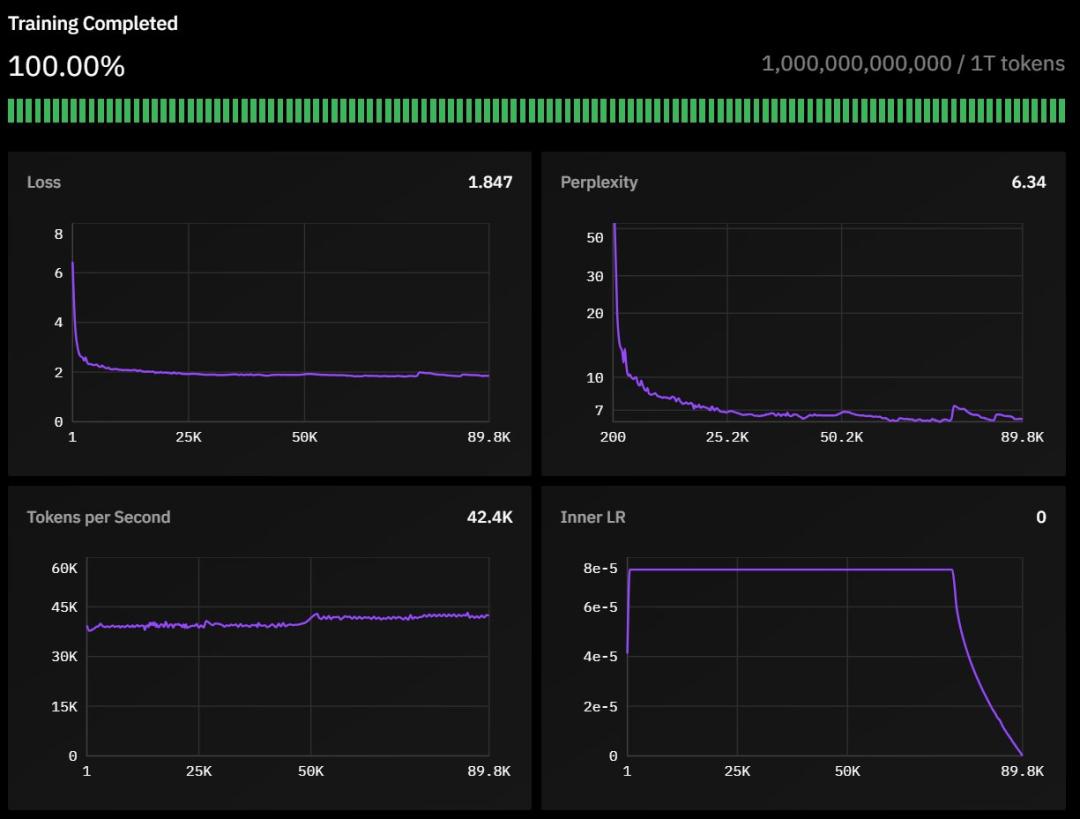

一万亿 token 在这里,我们给出了训练过程中的损失、困惑、训练速度等信息。

训练细节和数据

INTELLECT-1 基于 Llama-3 结构,它包括:

42 层次,隐藏层次为 4,096

32 个注意力头

序列长度为 8,192

词表大小为 128,256

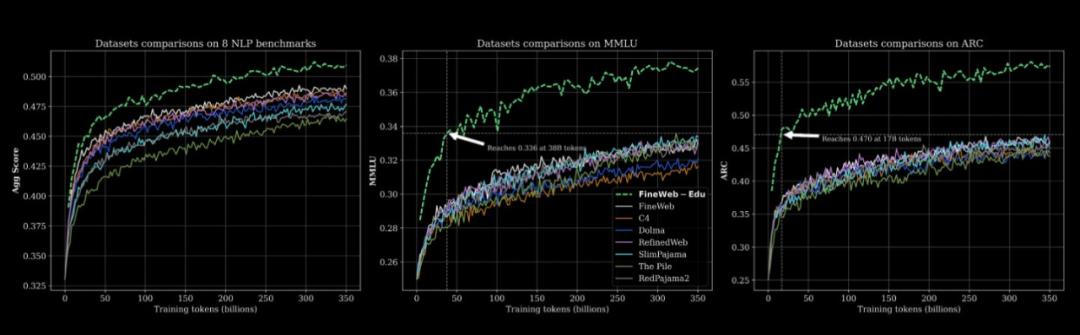

经过精心筛选的模型 1 万亿 token 数据训练,数据构成如下:

数据 Huggingface 链接:https://huggingface.co/datasets/HuggingFaceFW/fineweb-edu

55% FineWeb-Edu

20% Stack v2(Stack Overflow 等待技术问答数据)

10% FineWeb(首选网页数据)

10% DCLM-baseline(标准通用语料)

5% OpenWebMath(数学数据)

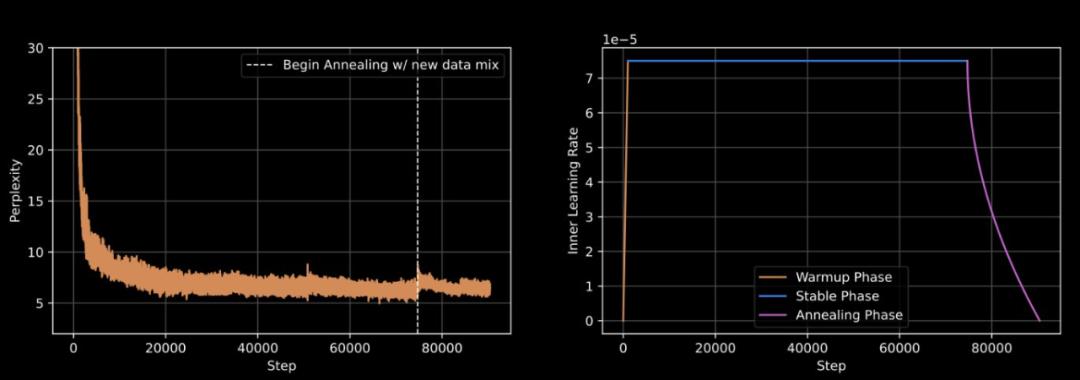

模型训练继续进行 42 天空,采用以下技术:

选用 WSD 动态化管理学习速度,使模型学习更加高效

精细调教的学习参数:内层学习率设置为 7.5e-5

引入特殊的损失函数(max-z-loss)保证训练过程的稳定性

使用 Nesterov 动态优化算法,帮助模型更快更好地学习。

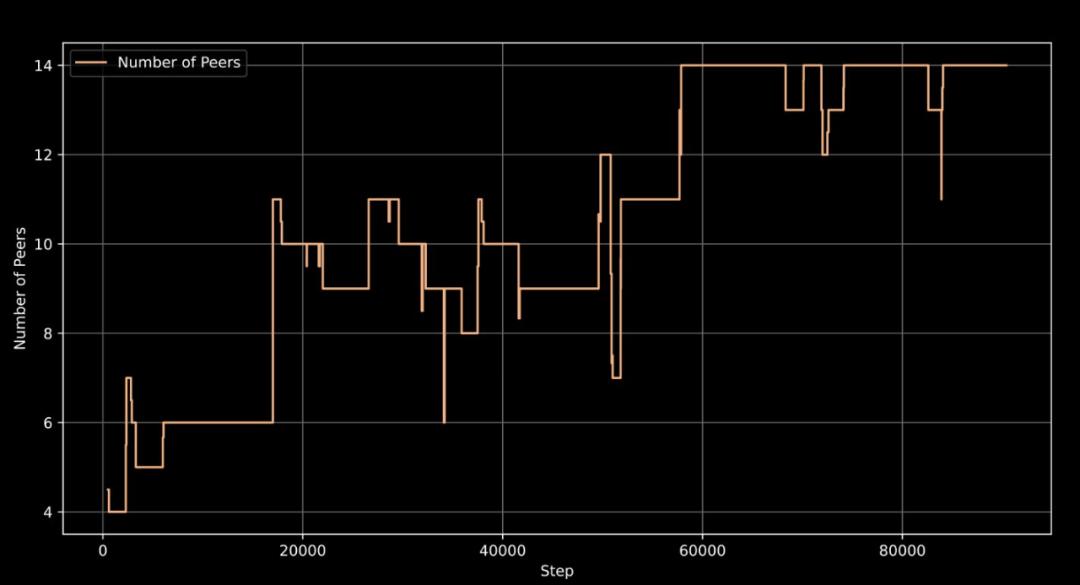

支持训练机灵活接入和退出,最多可以一起使用。 14 台机协同训练

从训练过程中的监控图可以看出,PRIME 系统性能优异:即使参加训练的机器数量经常变化(至少从 4 台湾逐渐增加到最多 14 台湾),整个训练过程依然稳定,充分证明了系统的可靠性。

训练动态图表显示了模型困惑和学习率在整个训练过程中的变化,包括预热阶段、稳定阶段和退火阶段。

Prime:一种去中心化训练框架

这个团队使用的练习框架名称 Prime,这些都是基于他们的研究 OpenDiLoCo。而 OpenDiLoCo 又基于 DeepMind 之前研发的 Distributed Low-Communication(DiLoCo)方法。

项目地址:https://github.com/PrimeIntellect-ai/OpenDiLoCo

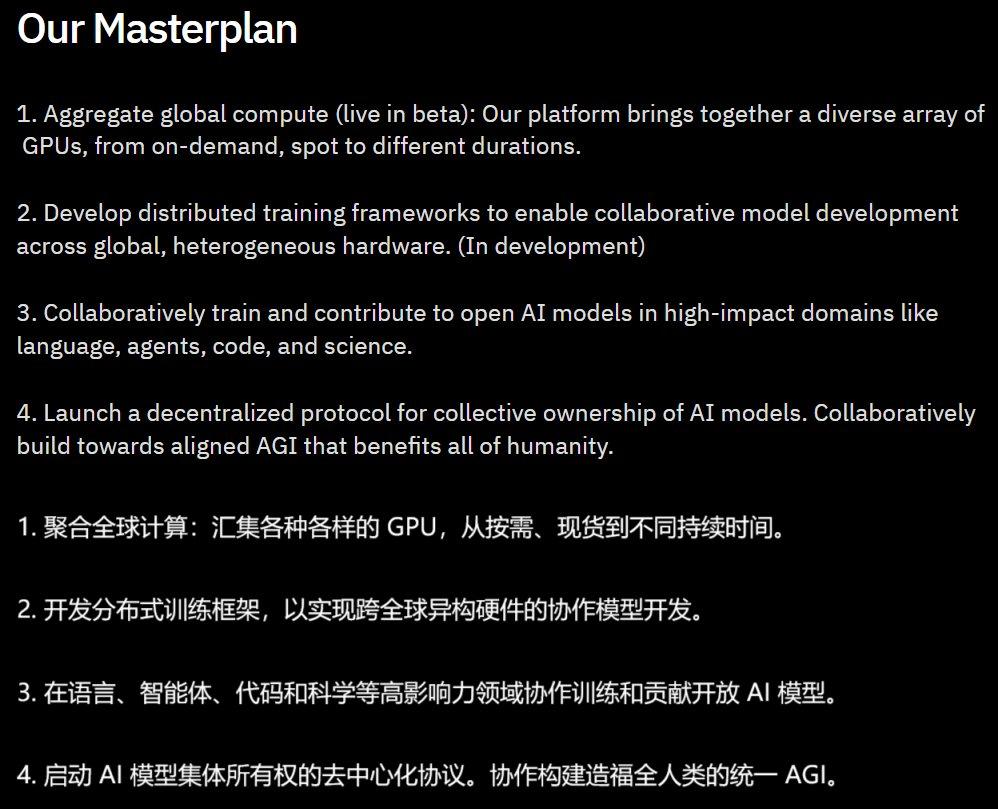

在此之前,Prime Intellect 已经在 1B 在参数规模上,实验了去中心化 AI 模型训练。这个团队说:「这样我们就可以到达我们 masterplan 步骤三:用于语言、智能和科学的开放式基础模型进行合作训练。」

Prime Intellect 的 masterplan

与之前的开源相比 OpenDiLoCo,Prime 有两个关键的改进。

首先,他们在算法方面, OpenDiLoCo 许多消溶性研究已经实施,发现通信要求可以进一步降低。值得注意的是,他们使用伪梯度。 int8 量化与每 500 同步结合一次外部优化器,同时降低带宽要求,达到最高水平 2000 倍数。这一结果不仅在较小的规模下有效,而且团队也将其扩展到更多的模型。

从实际的大规模拓展来看,我们知道分散训练不仅是一个工程挑战,也是一个研究挑战。今天最大的 AI 在多个分布式数据中心,实验室还没有完全解决容错训练问题。这个团队说,Prime 这种全新的分散训练框架支持容错训练,支持计算资源的动态开启/关闭,还可以提高全球分布式训练。 GPU 通信和路由在网络中。

Prime 适用于容错训练 ElasticDeviceMesh 的拓扑结构

这个团队在博客上写道:「这个框架是我们开源技术堆栈的基础,它的目标是支持我们自己的算法和算法。 OpenDiLoCo 除了其他分散的训练算法。通过构建这个系统结构,我们的目标是突破全球分布式 AI 训练极限。」

具体来说,Prime 框架包含以下关键特性:

适用于容错训练 ElasticDeviceMesh

异步分布式检查点

立即检查点恢复

自定义 Int8 All-Reduce 核心

带宽利用率最大化

PyTorch FSDP2 / DTensor ZeRO-3 实现

CPU 卸载

计算效率

虽然训练散成了满天星,但是计算效率仍然保持不变「聚是一团火」高水平:在美国集群部署时,计算资源利用率高达 中位数同步延迟仅为96%( 103s);在跨越大西洋的部署场景中仍然保持着 85.6% 优异水平(中位数同步延迟 382s);甚至在全球分布式节点的配置下,计算利用率也可以保持稳定。 中位数同步延迟83%( 469s)。

这一系列引人注目的数据充分证明了去中心化训练框架的容错性和可扩展性,不仅可以从容面对不同地理位置的网络延迟挑战,还可以在保证训练稳定性的同时实现高效计算。

后训练

在全球预训练阶段完成分布后,Prime Intellect 与 Arcee AI 为了提高成绩,合作开展了一系列后训练 INTELLECT-1 整体能力和特定的任务表现。主要包括三个阶段:

SFT(微调监管,16 轮)

DPO(直接偏好提升,8 轮)

使用 MergeKit 整合训练结果

详细的技术报告请查看更多信息:

论文链接:https://github.com/PrimeIntellect-ai/prime/blob/main/INTELLECT_1_Technical_Report.pdf

未来计划:长期目标 AGI

INTELLECT-1 成功向我们展示了分散训练的巨大潜力。关于如何开源的问题 PRIME 到目前为止,框架已经扩展 70B 规模呢?Prime Intellect 提出了三个计划:

继续扩大全球计算网络

鼓励社区参与更多奖金

进一步优化 PRIME 为了支持更多的模型,去中心化训练架构

最后,博客结束,Prime Intellect 写道:「为了避免 AI 我们真诚邀请世界各地的少数组织垄断能力。 AI 社区通过 GitHub 或 Discord 加入我们。让我们携手共创一个更加开放和合作的 AI 发展将来。」

参考链接:

https://www.primeintellect.ai/blog/intellect-1-release

https://app.primeintellect.ai/intelligence

https://www.primeintellect.ai/blog/intellect-1

本文来自微信微信官方账号“机器之心”,作者:机器之心,编辑:佳琪,Panda,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com