发布一揽子新产品,AMD再一次挑战英伟达,但是失败早已注定?

不久前,AMD在旧金山正式推出了包括新一代AI在内的一系列全新产品 许多重磅产品,如PC处理器、EPYC处理器和GPU加速卡。作为为数不多的英伟达同行之一,AMD对这波新产品寄予了希望,发布会特别邀请了OpenAI、微软等巨头的大人物来到平台,但市场对其商品并不乐观,其股价也在下跌。AMD挑战英伟达的计划,还没有开始就结束了吗?

为什么AMD追不上英伟达?

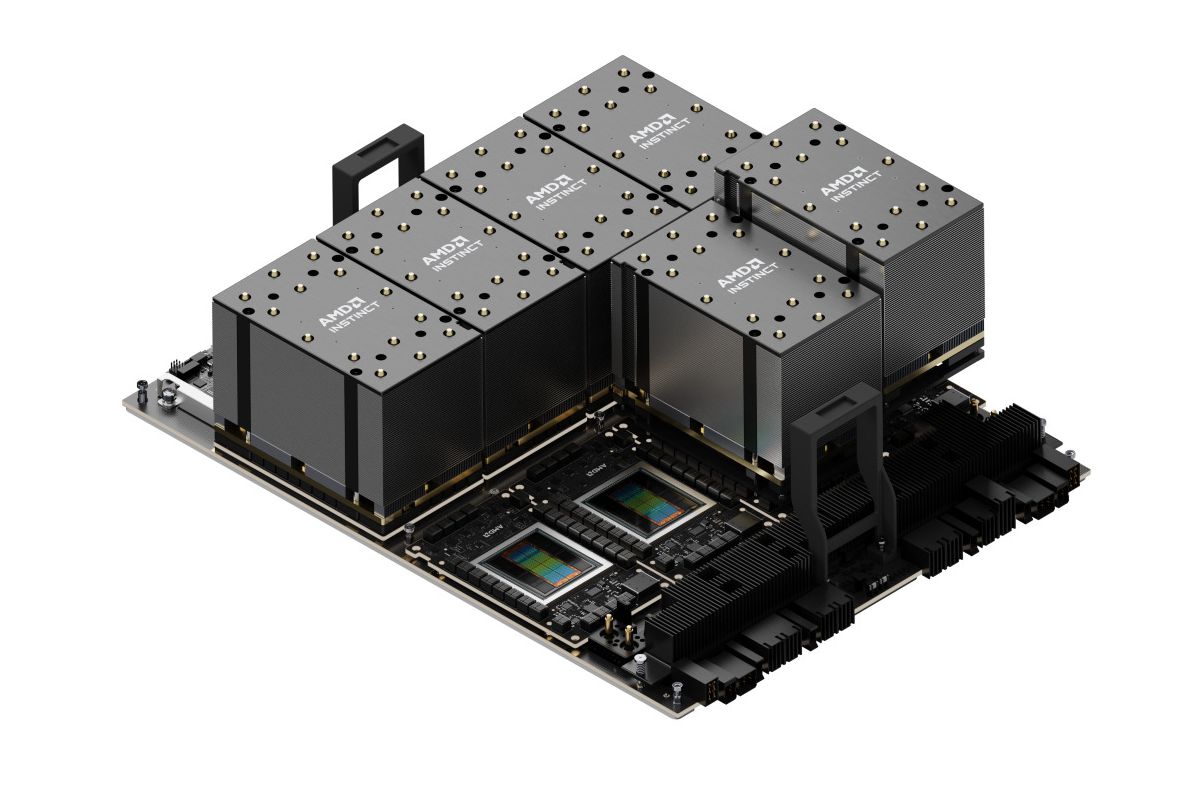

作为目前唯一能够在GPU加速卡领域挑战英伟达的厂商,很难说他们是失败者。毕竟除了英伟达,其他厂商加起来都不如AMD。根据AMD此次发布的一系列新产品,它正在加快追求英伟达的步伐,以InstinctMI325X为例,它的推理性能甚至比英伟达刚刚发货的H200还要高出20%以上。

然而,强大的推理性能取决于H200以上的显存所得,HBM3E内存MI325X高达256GB。,它是目前世界上性能最强的内存,内存带宽也从5.3开始TB升级为6TB//ss,成为AMD进一步提升MI325X推理性能的一部分。

但是在AI计算功能方面,MI325X并没有比MI300X提高多少,FP16精度下计算率为1.3。PFlops,相比之下,英伟达H200的FP16计算率为1.979PFlops,差距仍然非常明显,更不用说英伟达H100了。

虽然计算率存在明显差距,但MI325X的功耗并不低,据AMD透露,其单个核心功耗高达1000W,与英伟达H200基本持平。在过去的一年里,大多数企业都将资源投入到AI模型的培训中,因此需要大量的计算资源支持。在有限的部署空间下,英伟达的H100显然是最佳选择。

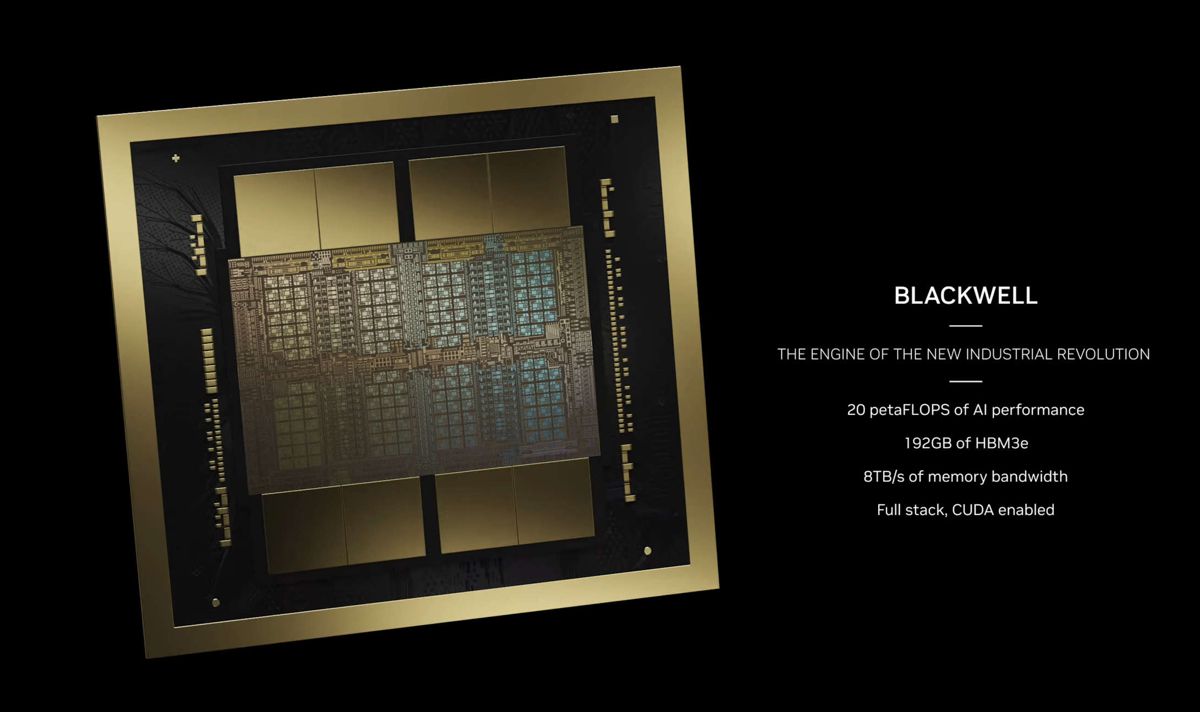

此外,H100是英伟达于2022年3月发布的GPU加速卡,从中不难看出,在芯片计算率方面,英伟达与AMD的技术差距仍然十分明显。此外,英伟达前段时间发布了H100接班人B200,计算能力和推理能力都有了显著提高,在FP16精度下,计算性能直接飙升至5PFlops,是H100的2.5倍,是MI325X的3.8倍。

3.8倍的计算率差距不再是价格或功耗可以弥补的差距。即使你可以通过部署4台MI325X服务器来获得与1台B200服务器相当的计算率,你仍然会面临更多的维护、调试和Debug问题。此外,在大多数情况下,计算中心的内部空间是有限的。如何在有限的空间内插入更多的计算率,通常是公司考虑更多的问题。

因此,在过去的半年里,即使AMD发布了更具成本效益的MI300X,它仍然不能动摇英伟达的地位,甚至不需要讨论生态等问题。仅仅一个计算率规模和质量差距就让AMD难以应付。

但是AMD的AI业务还是有很多订单,主要是因为英伟达的产能不能满足所有的需要,然后溢出订单被AMD接受,另外,像微软这样的公司,也在购买AMD。 为了减少对英伟达的依赖,GPU方法。

就像你看到的那样,微软,OpenAI、谷歌和其他公司最新最大的AI算率集群仍然是英伟达的H200的首选。AMD的MI300X等GPU主要部署到其他数据中心作为云计算率的支持。

如果企业仍然根据AI计算率配备数据中心,那么AMD只能祈祷奇迹发生,以打败英伟达,让他们创造一个计算效率超过B200的芯片。然而,事情并不是没有转机。随着AI模型的实践规模达到一定高度,公司逐渐将注意力转向应用,这是AMD的机会。

AMD能否在AI落地端换道超车?

所有的AI厂商,无论是微软还是OpenAI,其实都在思考一个问题:AI服务推广,或者说:如何让更多的人使用AI服务?

要解决这个问题,首先需要解决AI成本。以OpenAI为例,预计2024年将面临50亿美元的损失。除了新建数据中心投入的资金,其他大部分都是维护和运营当前计算中心的成本,而ChatGPT高达19.99美元/月的高级订阅会员已经让大部分客户“摆头”,很多人都希望OpenAI能降低资费。这样就能得到更多的顾客。

老实说,对OpenAI来说,19.99美元的价格实际上并不能保证它的利润,如果顾客用它来训练他们的大型模型或其它用途,那么实际上的算率成本将大大超过OpenAI收取的订阅费用,这就是为什么不久前,他们突然开始加大对部分非法使用账户的禁令力度。正是因为成本的飙升,OpenAI的收入才进一步降低。

虽然有时候我们把GPU加速卡的AI算率看作是一个整体,但是在实际应用中,预训练的算率性能并不能直接等同于推理的算率性能。其中,推理性能主要决定了GPU在已加载的AI模型下所能提供的计算性能。功耗固定时,推理算率越强,实施AI任务时GPU的成本越低。

换句话说,如果一个企业想要降低AI服务的成本,让AI应用到更广泛的领域,那么推理效率高的GPU就是必须的。然后AMD MI325X的定位非常明显:为用户提供更低成本的AI算率,支持AI应用落地。

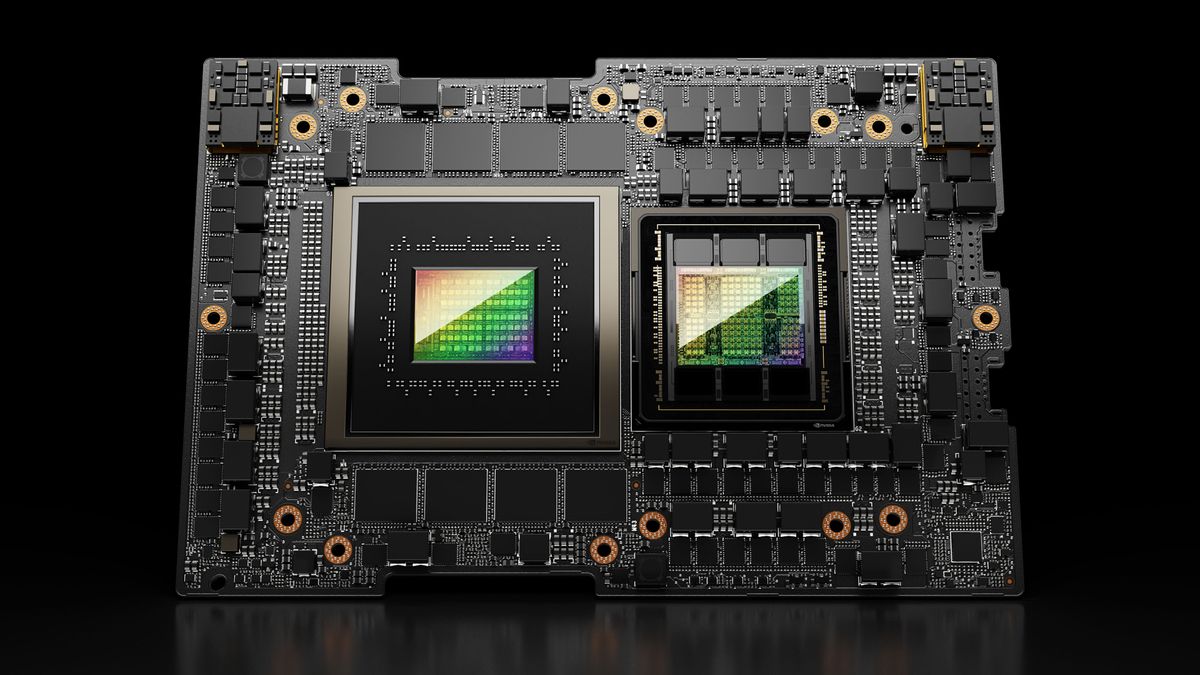

老实说,英伟达并非没有注意到这条赛道,今年才交付的H200就是为了解决推理成本而发布的产品,其核心虽然仍然是H100,但却有141GB显存(H100为80GB),同时也升级了显存带宽,进一步加强了推理性能。

然而,这还不够。随着AI应用规模的扩大,AI服务对计算能力的需求也在爆炸式增长,但H200的供应很难满足要求。此时,MI325X的优势得到了体现,不仅显示存量高达256GB,而且价格低于H200,供应也比H200充足。

所以,你可以看到微软、OpenAI等公司都是AMD平台,不仅仅是为了降低英伟达对他们的控制能力,更是为了提前购买更多的MI325X,并将其作为AI服务普及的关键。

至少,MI325X将是英伟达B200批量出货前数据中心的首选,对于B200发布后如何应对,也只能看到招拆招。归根结底,AMD不太可能在2025年之前开发出性能接近B200的GPU,此前海外媒体推理,AMD最早需要到2026年才能拥有接近B200特性的GPU,届时英伟达的B200甚至GB200(由2*B200组成的单个GPU)都已批量发货,AMD也将面临类似于今年年初的尴尬局面。

只能说AMD还是有机会的,即使不能撼动英伟达的领先水平,也能抢占很多市场份额。AI已经开始完全融入我们的生活。不管你承认与否,很多领域都与AI有关。随着AI的进一步普及,它将更多地参与民生经济。为了保持AI社会的运行,它将需要巨大的计算率,这是目前数据中心无法满足的。

因此,AMD还有时间,英伟达也需要更加关注自己的竞争对手。毕竟AMD和英特尔的市场竞争是一个很好的过去,英伟达可能会被AMD超越,如果他稍微放松一下。

本文来自微信微信官方账号“雷科技”,作者:雷科技,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com