微软GenAI开发遭遇瓶颈,转攻AI安全推出。「抗幻觉神器」

有一段时间,微软没有向公众透露任何关于GenAI的信息。

GenAI应该是微软在减少依赖OpenAI技术的过程中的一项重要战略,但是TheenAI是科技媒体。 information了解到的微软企业变革说明:

微软在人工智能的自主研发和培训中遇到了瓶颈。

而且同时微软推出的AI相关新工具,也证明了其在生成型人工智能业务中的战略转变。

未来未卜的合成数据和蒸馏模型

今年早些时候,微软似乎在对以前内部的一个名字叫做。「蒸馏」项目下注翻倍。

本项目的内容大致是先用OpenAI模型生成大量数据,然后再用这些信息来训练类似ChatGPT模型。

微软的目的是让这些模型在某些任务中几乎达到与OpenAI模型相同的性能,这样微软就可以根据自己的需求开发自己的模型。「市场价格公平」定价及自由销售。

在人工智能的发展中,几乎所有的行业都会使用人工智能产生的某种形式的培训数据,即生成数据。

微软作为OpenAI的主要资助者,有足够的自由使用OpenAI模型。

因此,微软的研究人员可以要求GPT-4生成数百万个类似教材质量的文本段落,包括文章和教材风格的训练,这些训练附带了解释的问答内容。

接着,微软就可以利用这些信息来训练一个性能与GPT-4相似的小模型。

而且大约从一年前开始,微软就通过提炼OpenAI模型开发了Phi。

Phi不仅开源,而且使用成本更低。

在他们的文章中,微软研究人员表示,虽然Phi的规模要小得多,但是它的性能几乎可以与OpenAI的主要旗舰模型相媲美。

在AI领域,微软CEO纳德拉将Phi描述为微软「掌握自己的命运」这是一种方法。

他告诉股东,Phi与投资公司贝莱德、阿联酋航空和医疗软件公司Epic等客户合作。在Azure上。

特别是在某些情况下,当问题比较简单,不需要复杂的答案时,微软用Phi代替OpenAI。 比如用GPT-4代替Bing等商品作为AI聊天机器人。

今年一月,Phi初步成功后,微软将负责Phi首席研究员Sébastien Bubeck从微软研究部门转移到一个致力于构建蒸馏模型的新组织。

同一年三月,微软雇佣了InflectionCEO,约定6.5亿美元。 穆Mustafa 在让他负责公司消费者AI业务之后,Suleyman和Bubeck被调到苏莱曼管理的微软AI团队。

根据两位知情人士的说法,他负责使用OpenAI的大型模型来生成训练数据。

不过,最近Bubeck已经从Suleyman团队辞职,再一次回到微软研究部门,并且再一次向研究部门负责。 Lee报告工作。

八月份,负责在Azure和其他微软产品中添加Phi模型的Misha。 同时,Bilenko也辞去了谷歌的DeepMindd AI团队。

一位微软AI研究员认为,这些猝不及防的人员变动可能表明,Suleyman将不再将生成数据和蒸馏视为部门发展的趋势和微软的首要目标。

另一方面,今年5月被期待的大型模型MAI-1没有消息,Suleyman团队再也没有公开发布任何模型情况,这也证明了这一策略已经转变。

目前,微软仍然依赖OpenAI模型来支持其人工智能服务,根据一些金融机构的预测,微软今年有望通过转售OpenAI模型在Azure上获得超过10亿美元的收益。

值得注意的是,微软最近在Azure上推出了一个项目。 新的AI服务——

「校准」:纠正人工智能幻觉的工具

在现阶段,阻碍生成式人工智能在现实中得到更广泛应用的最大缺陷就是,「幻觉」(hallucinations)。

幻觉是指缺乏数据支持的内容的形成,导出误导性信息。

这一情况特别适合大型语言模型。( LLMs )有关。

准确的信息在医疗、自动驾驶等高风险领域尤为重要。

虽然人工智能有改善获取重要信息的潜力,但是幻觉可能会引起误解,造成严重后果。

虽然行业可以通过「过滤」为了解决幻觉问题,但是当输出的文本因内容被删除或屏蔽而变得不连贯时,这种方法会导致客户体验不佳。

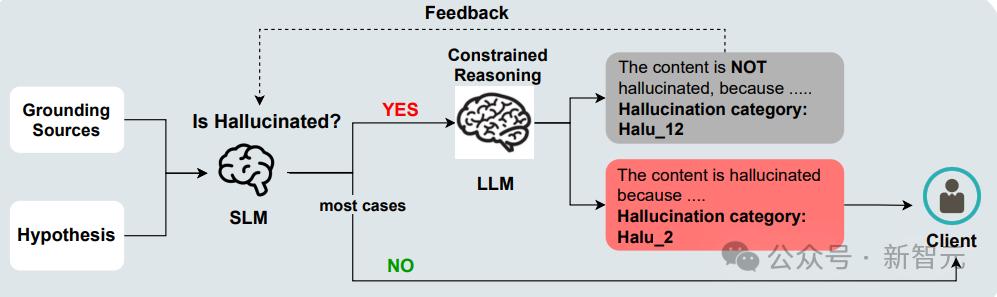

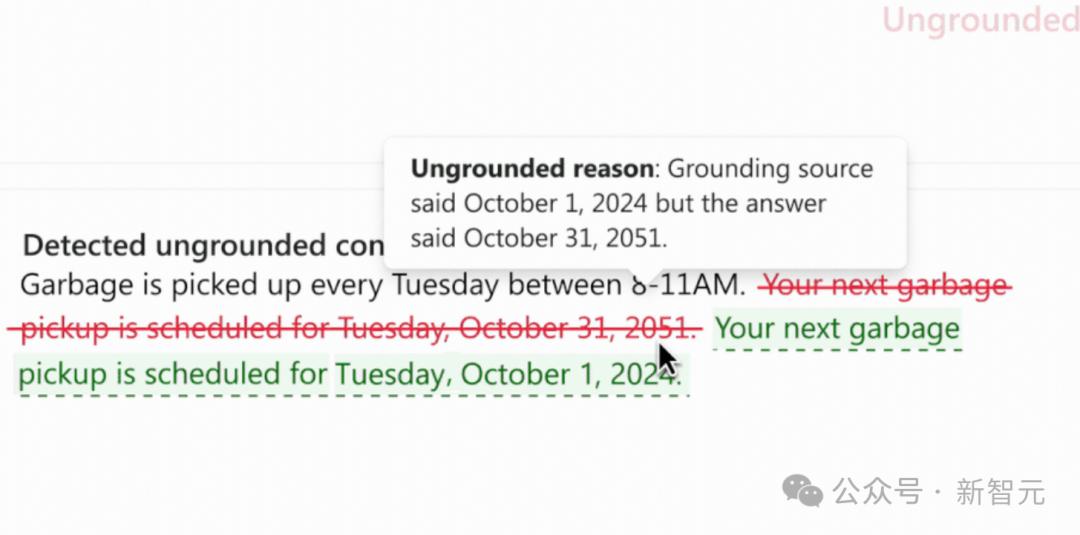

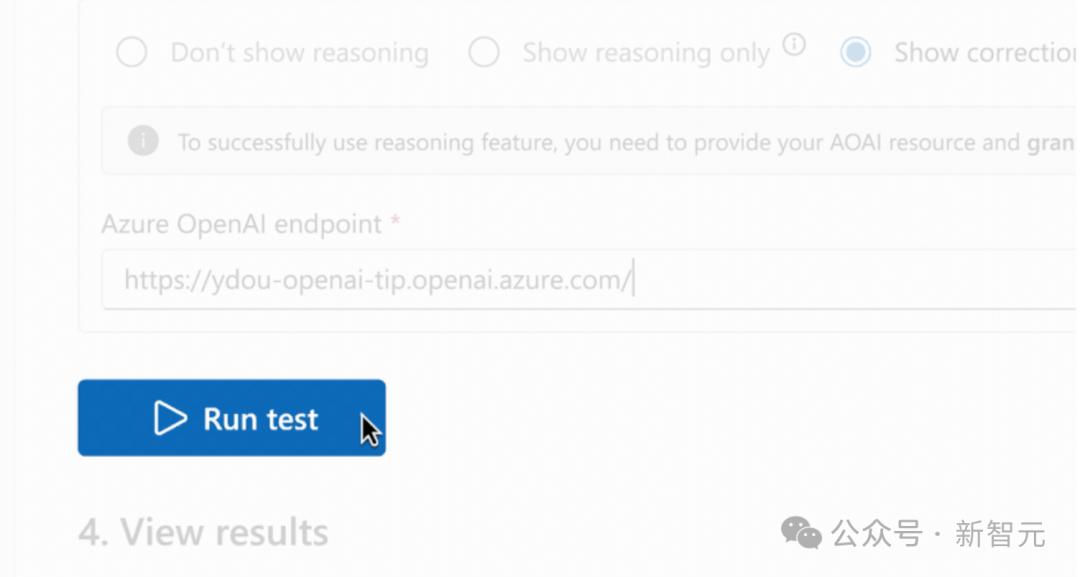

而且微软认为,在Azure 安全的AI内容接地检测(groundedness detection)在校准中引入的一个新功能-(correction),能突破上述局限。

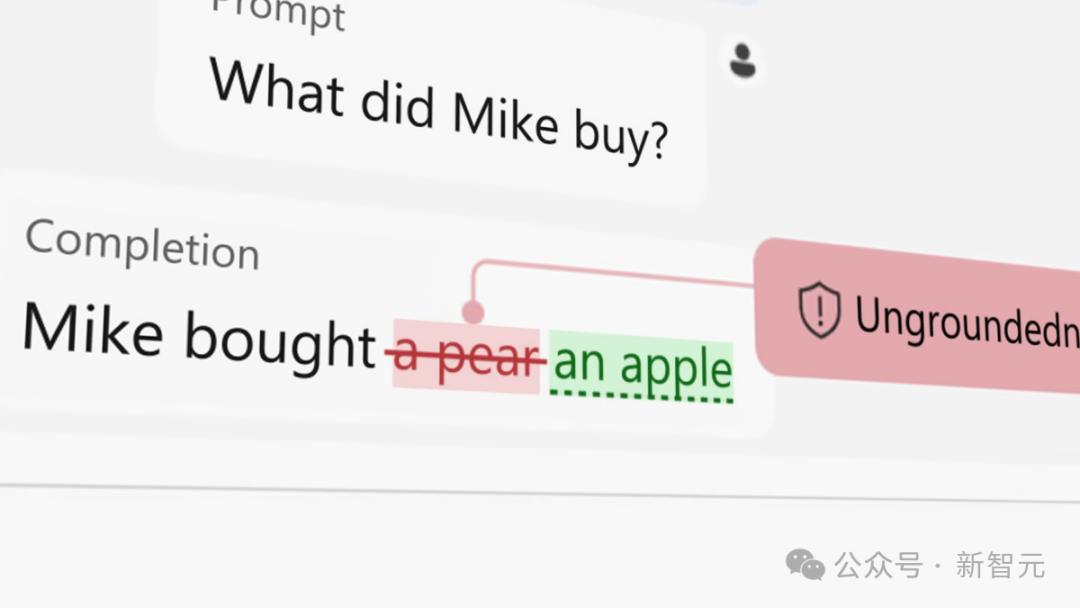

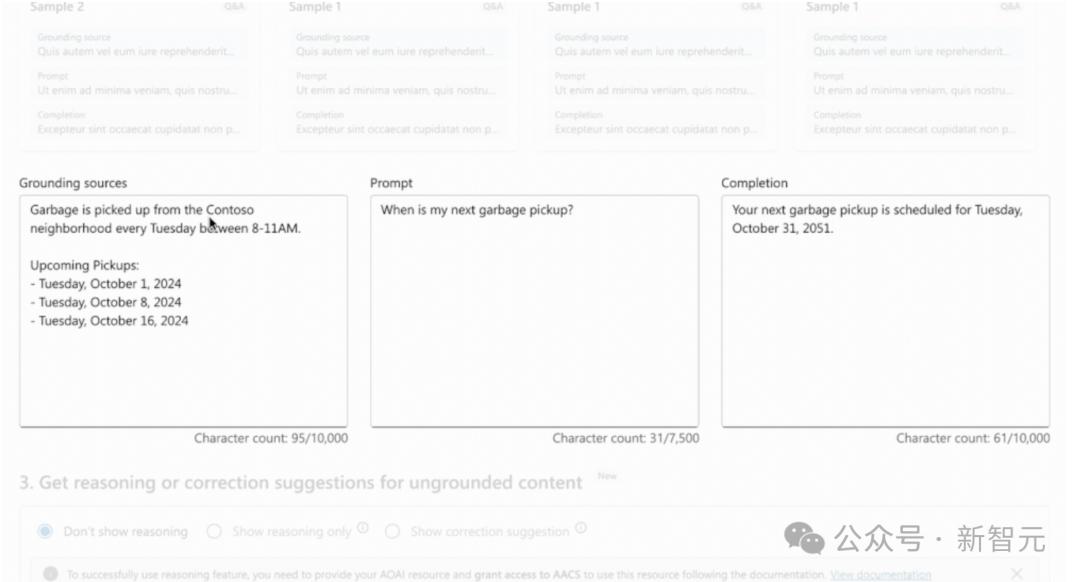

三月份,微软在Azure。 AI引入了接地测试。为了识别生成过程中的幻觉内容,可以将人工智能输出与原文档进行比较。

但是,在顾客实际体验这项服务的过程中,出现了一个问题:「除了屏蔽,我们还能做些什么来检测到这些幻觉内容?」

针对这一情况,微软将校准功能引入到接地检测中,让使用GenAI流程的用户在遇到幻觉之前,能够立即识别和纠正幻觉。

但是校准操作,需要程序连接到文档摘要和给予RAG的接地文档。

以后,Azure AI接地检测将通过以下步骤进行:

检验:首先,Azure AI内容安全会扫描AI生成内容中的无根据部分。

幻觉现象并非一个完全存在或完全没有的问题,大多数无根据输出实际上也包含了一些有根据的内容。

正因为如此,根据性测试才能准确地找到没有根据内容的实际部分。

如果没有根据的内容被识别出来,模型就会显示出具体不正确、无关或虚构的文本。

推理:模型在识别没有根据的段落后,会生成解释,表明为什么有些文本会被标记。

这一透明度至关重要,因为它能使用户清楚地知道没有根据的点,并对其不接地的严重性进行评估。

调整:如果没有根据的内容被标记,系统就会立即启动重写过程。为了确保与相关数据库一致,将修改标记为不准确的部分。

但是,如果这个句子没有任何与基础文档相关的信息,它可能会被完全过滤掉。

但是,在用户看到最初的无根据内容之前,调整就完成了。

导出:最后,修改后的内容将返回给用户。

但是微软强调,该工具提高了人工智能产生的内容与源材料的一致性,并不能保证产生的内容能够达到完美的准确性。

归根结底,信息源的真实性和客观性是最根本的。或许,这就是微软决定内部战略转变的原因。

但是,行业内的开发者需要更多不同的尝试来构建值得信赖的人工智能。

参考资料:

https://the-decoder.com/microsoft-unveils-ai-hallucination-correction-tool/

本文来自微信公众号“新智元”,作者:新智元,编辑:Lumina,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com