AI图像革命刚刚开始。

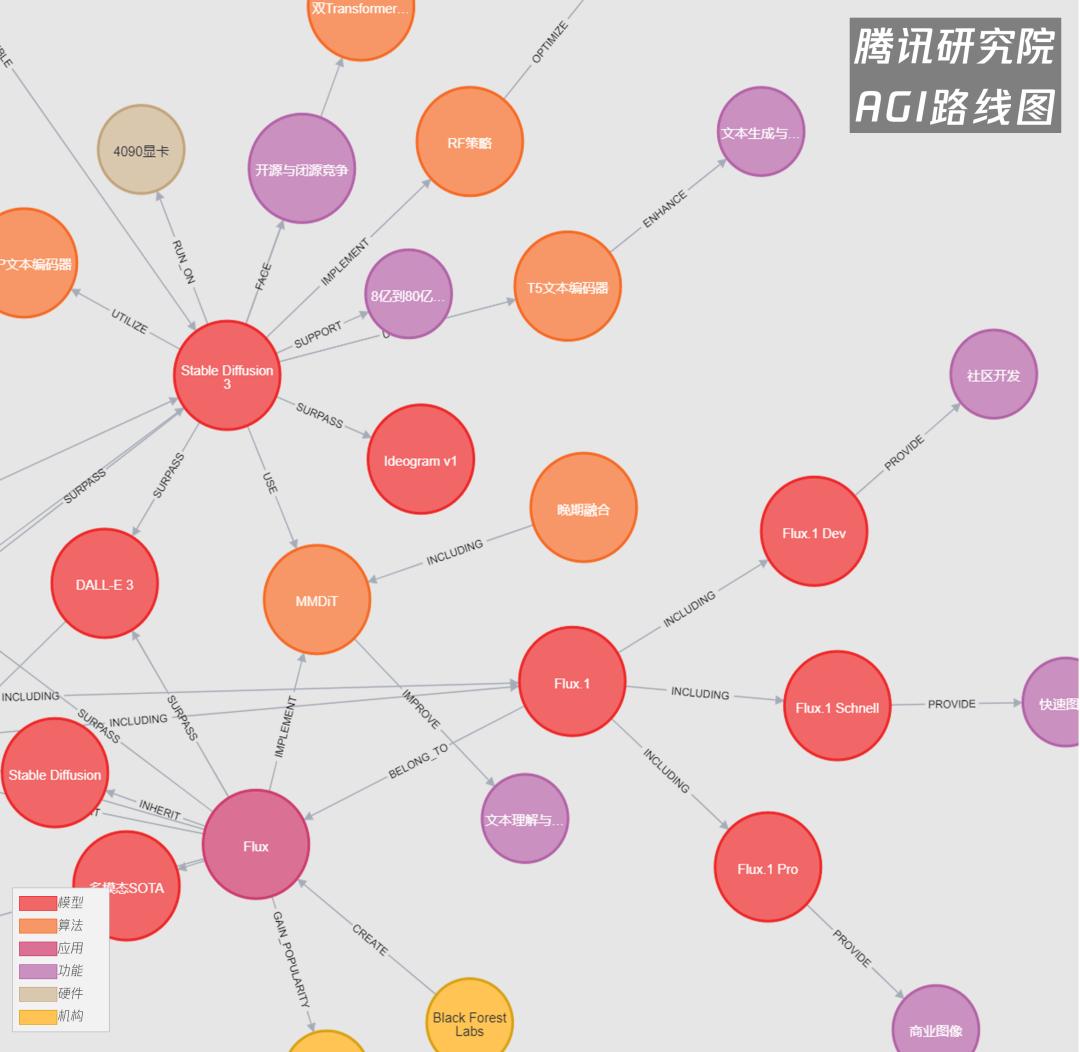

AGI路线图本期重要节点:DiT架构,Stable Diffusion 3.0、Flux.1、ControlNet、1024×1024分辨率,医学影像,英伟达Eagle模型,谷歌Med-Gemini系列模型,GPT-4o端到端、Meta Transfusion模型。

得益于人工智能算法的进步和技术的普及,信息和数据处理技术发生了快速变化。AI图像处理是应用领域之一。

人工智能在图像处理方面的优势在媒体、医疗、健康、安全等诸多领域得到了广泛的应用,从AI图像生成、医疗显像、目标检测、地图绘制到即时人脸检测。

AI图像处理市场正在快速增长。数据显示,2024年至2030年的复合年增长率可能在AI图像编辑、生成、识别等诸多领域分别达到11%。、17%和23%,广泛应用于各行各业。

因此,我们需要对AI图像处理的基本原理、应用领域和最新技术发展有深入的了解,以确保AI图像处理的价值和机会点在不同的使用场景中得到评估和掌握。

AI图像处理精进之路

Transformer:从生成字符到“生成像素”

事实上,AIGC和计算机视觉(CV)技术已经有了相当长的发展历史,但是随着大语言模型算法和技术的快速进步,传统的AI图像处理技术在前沿应用中的可见度正在逐渐降低,结合模型,Transformer立即将生成下一个字符的能力扩展到“生成像素”的图像领域。

举例来说,大众最熟悉的AI图像生成器,Stable 作为一种经典的潜空间扩散模式,Diffusion可以通过正向添加噪音和反向去噪复原图像来控制图像的生成,在这个过程中,关键是要让模型学会如何从随机噪声转换到清晰图像。

自2022年发布以来,Stable 在1.0到2.0阶段,Diffusion是由核心部件U-Net架构主导的一个重要环节。U-作为编码器和解码器,Net负责将图像压缩到潜在空间,并在潜在空间中实施扩散过程,这对生成高质量的图像起着至关重要的作用。

今年2月份,Stable Diffusion MMDiT架构是3.0正式发布的。(Multimodal Diffusion Transformer,MMDiT),取代了原来的U-Net架构和骨干网络。结合Transformer强大的序列建模能力和流匹配技术,大大提高了图像的可控性。在高分辨率(1024x1024像素)中,它能更好地理解与空间关系、构图元素、动作和风格相关的复杂提醒,、与上一代模型相比,复杂区域(如手和脸)的细节处理和文字拼写都取得了颠覆性的进步。六月中旬,Stable拥有20亿参数。 Diffusion 3 Medium模型正式开源。该中等参数模型可在消费级PC上运行,VRAM占用率较低,适用于处理小数据和定制需求,进一步刷新开源生产力。

引入Transformer架构也开始了ScalingScaling的AI图像模型训练。 Law。与其他神经网络结构相比,基于并行专注力的Transformer结构具有scaling law在生图领域具有重要潜力。它能使图像模型能够消化更多的图像和视频数据,从而进一步提高图像领域的出现能力。例如,在引入Transformer架构之后,最新版本的Stabler Diffusion 与上一代相比,3.0模型的可选参数范围从800M增加到8B,8B模型的上限增加了整个数量级。例如,八月中旬,一个叫Black的家庭。 Forest 新创公司Labs(由前Stable) Flux成功发布了Diffusion核心作者).通过结合架构优势,将模型参数上限进一步刷新到12B(Flux模型已经优化迭代到Flux1.1版本,模型参数规模不变)。

目前,Flux模型已经成为目前开放权重图像模型领域的顶级代表。根据技术报告,Stable Diffusion 3.0类似,Flux.1选择MMDiT架构,重新定义图像细节、提醒跟踪、风格多样性、场景复杂性等最新技术实力。采用流匹配、旋转位置嵌入、并行注意层等技术。 (SOTA) 。据研究人员介绍,归功于大规模的训练,Flux.1 Pro和Flux.1 在视觉质量、提醒一致性、尺寸和宽高比的可变性、排版和导出多样性等方面,Dev已经超越了Midjourney。 v6.0、Dall-E3和Stable Diffusion 3 Ultra。根据官方发布的样品和网友的检测情况,Flux.1AI图像生成的Scaling几乎达到了真假难辨的程度。 Law有效。 (Flux1.1迭代版相关技术尚未完全公开,官方表示其运算效率和性能更好,仍在进化中)

腾研AGI路线图截选图 Stable Diffusion 3与 Flux.1

从Prompt提示到ControlNet控制

指令遵循性是AI技术应用中一个通用且非常重要的指标。有许多方法可以控制图像生成,包括Prompt(提示词)、LoRA(低秩适配器) 、ControlNet(控制网络)等,还包括ComfyUI等配备工作流的外部应用程序。

Prompt是一个非常受欢迎的概念,它来自客户的文本描述,引导模型生成特定的图像。例如,输入“一个穿红裙子的小女孩”将促进模型生成符合这个描述的图像。通过调整prompt的内容和细节,用户可以进一步控制生成图像的主题、风格和细节。

LoRA全称Low-Rank Adaptation(低秩适配器)是微软在语言模型训练中发明和使用的一种低成本模型微调技术。其根本出发点是降低大语言模型finetune的成本和大量Finetune模型的成本,更容易部署在建筑设计等专业图纸领域。

通过添加额外的条件输入,ControlNet是一种神经网络结构,可以调整目前的模型(例如Stable Diffusion)输出。它允许用户在生成过程中引入更多的控制信息,包括姿势、深度或边缘测试等。,然后准确引导生成结果。线稿、深度图或语义分割图都可以作为输入条件。

实际上,ControlNet和LoRA的关键想法是相似的,它们都是通过旁通网络干扰模型导出的。不同之处在于,LoRA通过低秩压缩减少了模型体积,但限制了其能力上限;而ControlNet则不压缩模型参数,而是1比1复制,以达到更高的控制精度。

此外,我们还可以看到,ControlNet已经能够提供一系列令人惊叹的精确控制能力:

例如,在光影控制方面,5月份,ControlNet作者发布了IC-Light(Imposing全称Imposing Consistent Light),用来控制图像的照明效果。该技术利用潜在空间一致性,确保外观在不同灯源组合下的一致性,实现自然光照变化。使用者只需上传随机照片,系统自动分离主体,选择灯源位置,配合显示,即可自动为图像添加AI照明效果。。

例如,在轮廓控制方面,七月中旬,ControlNet作者发布了一个名为Paints-Undo的项目,它受到绘画软件的启发「撤销」功能,模型输出过程类似于持续按下Ctrl。 Z。这个项目的用户可以通过上传照片来反推自己的创作过程,包括素描、着色等步骤,还可以生成25秒的视频来展示整个绘画过程。ControlNet具有优异的轮廓控制力,具有高度一致的画面效果。

例如,在画面构图方面,,ControlNet架构也可以作为中间媒介,扩展用户简短的Prompt提示词,准确控制图像生成的各种元素。Omost,ControlNet作者的新工具,通过LLM AI代理的自动扩展功能可以根据简单的Prompt生成详细的图像构图描述,包括光照、轮廓、目标等全局和局部的具体要求。最后,根据LLM设计的蓝图,特定的生成器创建图像。

目前的AI图像处理模型已经为用户提供了极高的灵活性和控制能力,从Prompt提示词到LoRA再到ControlNet控制,再结合工作流程设计工具(如ComfyUI)。

腾研AGI路线图截取ControlNet

产业化现状的产生和理解

产业意义1K分辨率:从生成到理解

与基本语言模型的最长前后文本相比,分辨率在AI图像处理中也显得尤为重要。更高的分辨率使模型能够捕捉到更多的信息和细节。同样,目前的AI图像处理也受到“最长前后文本”的限制,受到计算资源、训练数据集、模型结构、性能和质量平衡等诸多因素的限制。

AI图像处理已经成功突破了1K分辨率的关键门槛,无论是AIGC还是多模态理解和识别。

例如,Flux等AI图像生成模型.1、Imagen 3、Midjourney v6、Stable Diffusion 3等,均可支持1024主流。×1024原生图像分辨率(一次生成),通过超分辨率技术可以扩展2倍甚至更高的像素,进一步改善图像细节;这可以更好地支持文艺创作、广告、游戏开发、图像制作等领域的图像生成。

在图像理解方面,挑战主要表现在多模式基础模型的输入限制上。由于高分辨率图像处理需要在结构和数据等方面进行大量的适应和再训练,这并不容易。

GPT-4和GPT-4 以Vision版本为例,它们在输入图像时有严格的限制。按照官方文件描述:“提前将图像缩小到最小尺寸,可提高模型响应速度。对于低分辨率模式,建议图像为512px x 512px。图像的短边应小于768px,长边应小于2000px,这是一种高分辨率模式。” 与此同时,还列出了一系列的“局限”:不适合医学图像解读,处理非拉丁文字效果差,可能误解转动或倒置的图像,难以理解图表和不同线条风格,空间定位能力有限。

对图像理解而言,为什么1K分辨率同样具有重要意义?以医学影像为例,扫描计算机断层。(CT)一般矩阵大小为512x512像素;磁共振成像(MRI)分辨率范围很广,但一般在256x256到1024x1024像素之间;超声波成像的分辨率一般在512x512像素左右。因此,多模态基础模型需要基于或高于这些目标分辨率,改进模型以更好地处理医学影像等高精度数据。

例如,在9月份,Mistral发布了Pixtral。 采用专用视觉编码器和24GB容量的12B多模态大模型,结合GeLU和2DD。 RoPE技术,提高视觉适应性,使其能更好地处理高分辨率图像(1024x1024像素)。同月,英伟达推出了Eagle系列模型,可以处理高达1024x1024像素分辨率的图像,显著提高了视觉信息的处理和理解能力。为了应对复杂的图像信息,Eagle采用多专家视觉编码器架构,不同的编码器专门训练特定的任务,完成了更全面的图像理解。

1K分辨率使得生成式AI在图像理解方面具有更高的应用潜力,尤其是在法律、医疗、电子商务等行业。这种能力有望带来更广泛的应用。

PixtralalaleAGI路线图截选 12B 和Eagle一起

解决商业化:技术能力与工业场景的适应

在目前的AI生成浪潮中,原生技术能力的展示可以吸引大量的流量。AI生成的文本、图像、视频甚至音乐获得了更多的市场关注,因为它们可以快速到达用户,具有可视化和娱乐化的特点。然而,这可能无法形成一个有效的商业闭环。

相反,由于商业模式的限制,许多知名的生成式AI应用程序正在被大型企业收购,或者并入更多的应用平台,或者通过资源整合进入特定行业。

例如,今年年中,Stability AI面临着严重的财务困境,亏损和债务不断积累,为了重组公司,减轻财务压力,不得不寻找新一轮融资。随后,Stability Prem是AI任职《阿凡达》视觉特效公司前负责人。 在Weta的帮助下,Akkaraju是一个新的CEO。 丰富的Digital技术和营销经验,促进Stability AI将视频、照片、音乐等大模型与先进的视觉特效技术相结合,以求提高财务状况。

一个月后,融资估值在2023年超过1亿,目前年收入3000万美元,团队规模120人AI图像生成大厂Leonardo.ai,寻找Canva的收购(一个用于图形设计和内容建立的在线平台),交易价格只有3亿美元左右,整合了其视频和图像生成模型。通过这次收购,Canva的主要目标是提高其AI技术实力,与Adobe竞争,加快收入增长,吸引更多的企业客户。

由此可见,虽然AI图像处理能力很重要,但原生市场需求仍处于发展阶段。相关企业不得不通过曲线救国,寻求与更深层次的AI图像编辑和影视制作市场的结合,促进商业化。

与AI图像生成市场相比,图像理解与分析的热度虽然略低,但实际上早已进入行业融合的商业化模式。

医学AI是最引人注目的赛道之一,谷歌在多模态任务和医学领域投入了大量精力。五月,谷歌DeepMind发布了Med-Gemini系列模型,专门针对包括Med在内的医学领域的多模态任务进行优化。-Gemini-2D、Med-Gemini-3D和Med-Gemini-Polygenic。这些模型利用大规模的医学图像数据,在多个医学图像分析任务中超越了目前最好的模型,尤其是胸部X射线、CT图像和基因组数据处理。检测数据显示,生成式AI在多模态医学AI任务中表现良好,尤其是在视觉问答和放射学报告生成方面。

类似的研究在学术界也取得了很大的进展。例如,MIT开发的Mirai系统可以通过常规胸部x光检查来预测乳腺癌的风险,并尝试提前五年发现潜在病例。另一个例子是上海交通大学的3D医学模型SAT。该模型可以3D图像分割497种人体器官和疾病,显示出强大的应用潜力。

此外,Geoffrey Hinton(杰弗里·辛顿)、LeCun(杨立昆)和吴恩达等AI领域的领军人物也多次公开支持医疗AI和医疗影像分析领域的研究。

Med截取腾研AGI路线图-Gemini

技术停止了吗?远非如此?

ScalingAI图像处理 刚刚开始的Law

当前,各大图像生成模型还没有完全披露其技术细节,但是从整体趋势来看,纯Diffusion路线正逐步与Transformer结构相结合。例如DiT架构(这里指的是包括MMDiT架构在内的大型架构类型),这也是Sora和 Stable Diffusion 还有Flux3.一种基于Transformer架构的扩散模式,具有相同的架构和核心技术。

如同上述,通过使用Transformer架构,可以扩展更多的图像数据处理能力,而Scaling则是这项技术。 在不到半年的时间里,Law开始了。

回顾过去的各种扩散模式,大部分参数都是1B或者更小的规模。并且在引入DiT架构之后,Stable Diffusion 3和Flux.每个参数分别达到8B和12B。对比一年半前的Midjourney V5惊艳全网的“情侣照”,到现在Flux.新一轮飓风掀起,AI图像生成技术似乎迈上了一个全新的台阶。Ethann副教授沃顿商学院AI角度 当看到Flux时,Mollick.在形成效果之后,推测AI将在18个月内完成一次重大进化。事实上,距离Sora和Stable Diffusion DiT架构的大规模应用,不到半年。

与基本模型在文本训练数据上的多样性相比,图像处理和多模态领域仍有很大的改进空间。

第一,在当前的数据生成环境下,视频和文本数据的总数仍在增加,尤其是视频数据,增长速度尤为显著。根据统计,世界上每天大约有4.7亿个视频,大约相当于几十个PB数据。例如,YouTube每天处理大约720,000小时的视频内容,总数约为4.3PB。这类大量的图片和视频数据将为图像处理和多模态领域的迭代提供源源不断的训练材料,促进技术的不断进步。

其次,由于开源生态,无论是DiT架构还是多模态基础模型,现在都处于开放活跃的探索阶段。各行各业可以利用开源模型定制和改进特定的需求场景,进而探索各个领域的Scaling Law,例如,不同方向的应用潜力,如医疗影像和媒体娱乐。

最后,更多的资金和人才的涌入将推动图像处理进入一个新的阶段。导演詹姆斯·卡梅隆9月25日宣布加入Stability。 AI股东大会强调,AI与CGI的融合将开创全新的叙事方式,引起国内外的高度关注。AI与CGI的结合,有望为艺术家提供前所未有的创作机会,促进视觉媒体未来的发展。伴随着大型产业应用的发展,更多的计算能力和资源的持续投入将不断提高AI图像的生成能力。与CGI产业多年的演变历程一样,成功的商业模式将反过来推动技术进步。

从late fusion到达early 探索fusion

传统的AI,无论是文本生成文本(文本生成文本)还是文本生成图像(文本生成图像),一般为每种模式选择特定的模式。「编码器」或「解码器」,这种方法被称为将不同模态分离。「晚期结合」(late fusion)。但是,这在一定程度上限制了模型的潜力,因为Transformer本身具有有效处理跨模态信息的能力,模块分离的处理方法削弱了这一优势。

GPT-作为第一个,4o的发布改变了这一点。「端到端」模型,它可以通过单个神经网络处理所有模态。OpenAI总裁Greg5月16日 通过X帐户,Brockman发布了GPT-4o产生的第一个公共图像。这张生动的照片展示了一个穿着OpenAI标志的黑色t恤的人,在黑板上用铅笔写着“不同模式之间的转换”。假定我们使用直接建模的大型自回归Transformer(文字、像素、声音)。这种做法的优缺点是什么?”。“他也在发布中写道:”GPT-4o生成的图像-仅凭GPT-4o的图像生成能力,就有很多行业可以探索。这个团队正在努力把这些能力推向世界。”

而且类似的技术尝试还在继续推进。GPT-开源模型制造商Meta在4o发布不到一周后发布了34亿参数。「Chameleon」模型,可无缝处理文本和图像,使用10万亿token进行练习,性能接近GPT-4V。采用统一的Transformer架构,Chameleon完成了文本和图像的结构。「初期结合」(early fusion),刷新了多模态视觉问答和图像标记标准(SOTA)。尽管这种模式的设计面临着技术挑战(事实上,GPT-到目前为止,4o还没有正式发布其图像生成能力,网页端只提供非正式版本的感觉),但Meta通过架构创新和培训技术,提高了多模式大模型初期的性能和稳定性。类似于GPT-4o的端到端方法,已经成为当前的一个重要方向。

八月底,Meta再次发布了Transfusion模型的最新研究成果,将Transformer和Diffusion技术相结合,完成了文本和图像生成的统一。该模型将语言建模与图像扩散相结合,在混合模态序列中进行练习,大大提高了模态间的整合效率。实验表明,Transfusion在多模态AI领域表现出色,能够生成高质量的文字和图像,有望促进多模态交互应用的发展。

腾研AGI路线图截选图「Chameleon」和Transfusion

当前技术发展的浪潮,不仅所有的应用都值得重写最新的AI技术,甚至所有相关的AI技术本身都值得通过最新的AI架构和算法来重建。这一连续迭代过程推动了整个领域的快速发展。

当Transformer结构的结合解决了scaleer结构时,让我们进一步展望未来。 up规模扩展的问题,显著提高了图像的分辨率和丰富度;「初期结合」(early fusion)和「端到端」构架正在努力提高跨模态信息处理能力,推动大统一进程。OpenAI最新的o1推理模型能否解决生成中的“逻辑”问题,而不仅仅是相关性,让图像生成和理解更符合物理规律?这个问题还不得而知。但是从目前的发展情况来看,AI图像处理革命或者即将迎来新一轮的突破,而且其技术、产业的发展还远未达到上限。

(感谢腾讯研究院曹士邈、袁晓辉在本文编写中的帮助。)

参考资料:

腾讯研究所AGI图谱数据库,#腾讯研究所AI快递,#AI每周关键字Top50

https://www.gminsights.com/industry-analysis/ai-image-generator-market

https://www.psmarketresearch.com/market-analysis/image-recognition-market

https://www.grandviewresearch.com/industry-analysis/digital-image-processing-market-report

本文来自微信微信官方账号“腾讯研究院”(ID:cyberlawrc),作者:李瑞龙,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com