OpenAI 发布新模型,Sam Altman:耐心的时刻结束了

北京时间凌晨一点,OpenAI 突然间进行了重大更新。

已预热了将近一年。 Q*/草莓项目,传说中能进行高级推理的大语言模型,今晚终于露出了真面目。

OpenAI发推表示,刚刚推出的 OpenAI o1-preview 以前外媒已经爆料过模型-名称的含义,o1 应当代表着 OpenAI 下一代大模型 Orion(猎户座)一代。

OpenAI 根据文件,新模型在推理能力上代表了人工智能能力的新水平,因此,计数器将被重置为重置。 1 ——这意味着将来很可能不会有任何未来。 GPT-5 了,o1 它将代表OpenAI未来的最强水平。

而且从今天开始,ChatGPTPlus 和 Team 顾客可以直接访问模型。

顾客可手动选择使用 o1 模型预览版-o1-preview,或使用 o1 超小型模型-o11模型-mini。o1-preview 每周限制为 30 条消息,o1-mini 每周限制为 50 条。

在 OpenAI 在网页上可以看到模型介绍, o1 模型训练数据截止日期为去年10月,最早的是 Q*这个项目的爆料,大概是在去年十一月份。

OpenAI 憋了一年的大招到底怎么样?OpenAI 能否再一次推动大模型的潮流,甚至让人们看到通用人工智能的道路不再遥远?不久,每个人都可以检测到这一点。

Sam Altman 凌晨一点在 X 上发帖:「要耐心等待的时刻结束了!」

01. o1 模型:处理博士级别的科学问题超越人类。

截止稿件时,作者仍然无法使用。 o1 模型。

不过 OpenAI 大量相关的相关事项已经发布。 o1 展示模型表现。

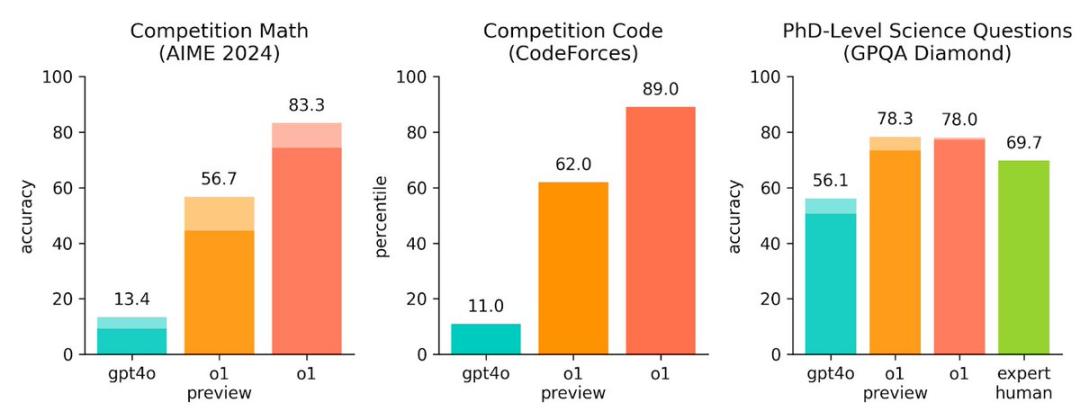

新模型推理能力当然是最引人注目的。Sam Altman 直接从 X 上贴出了 o1 与 GPT-4o 对比数学、编程和处理博士等级的科学问题。

目前最左边的柱状代表 OpenAI 的主力模型 GPT-4o。今日发布 o1 中间的橙色柱状预览版。

能看到,现在 2024 2008年美国数学邀请赛的竞赛问题 Codeforces 在算法竞赛题上,o1 与预览版相比,处理数学和编程问题的能力 GPT-4o,提高了 5-6 倍数。可怕的是,深橙色的柱子代表真实的。 o1,相较于 GPT-4o,提高了 8-9 倍!

在最后一张图中,OpenAI 同时也列出了人类专家在处理博士等级科学问题时的成功率,大概在这一点上。 69.7%,而 o1 预览版和 o1,已经超过了人类专家的水平。

OpenAI 目前,技术博客提到了更具体的数字, o1 在美国数学邀请赛中,模型成绩可以排在美国之前。 500 名字。物理学、生物学和化学问题的准确性,超出了人类医生的标准。

在模型技术进入公众视野的两年内,人们经常使用的一个比喻是,大模型就像一个什么都懂的学生,在知识专业方面远远不够,但从天文学到地理学,最基本的知识可以理解一点。OpenAI 这种新模式,很有可能会刷新大家的这种认知。

官方博客中,OpenAI 对这一进步背后的原理进行了简单的解释。

类似于人类在回答难题之前可能会想很久,o1 当你试图解决问题时,你会用到一系列的思考。o1通过加强学习 学会磨练自己的思维链,完善自己的使用策略。它学会了理解和纠正错误,把棘手的过程分解成更简单的步骤。当目前的方法不起作用时,它会尝试另一种方法。这个过程大大提高了模型推理能力。

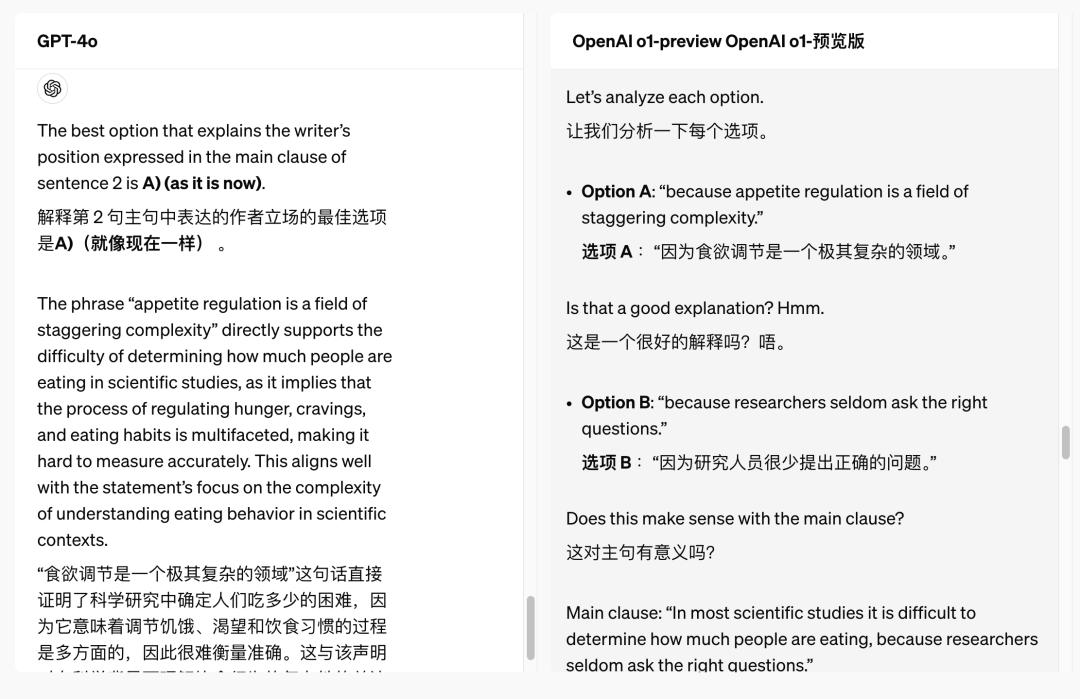

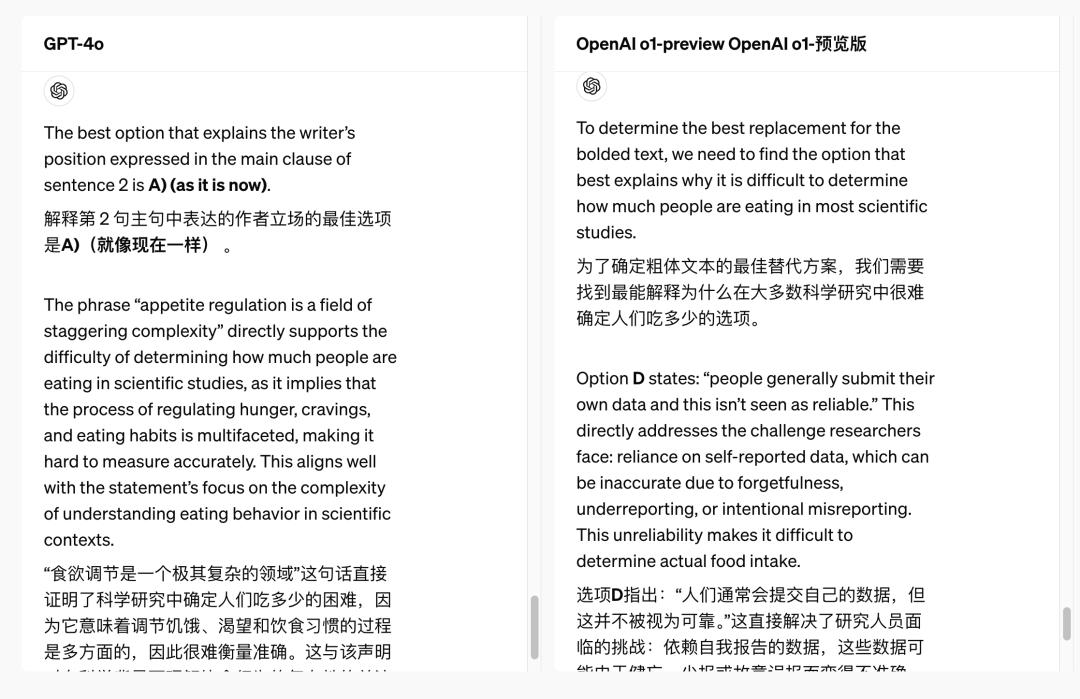

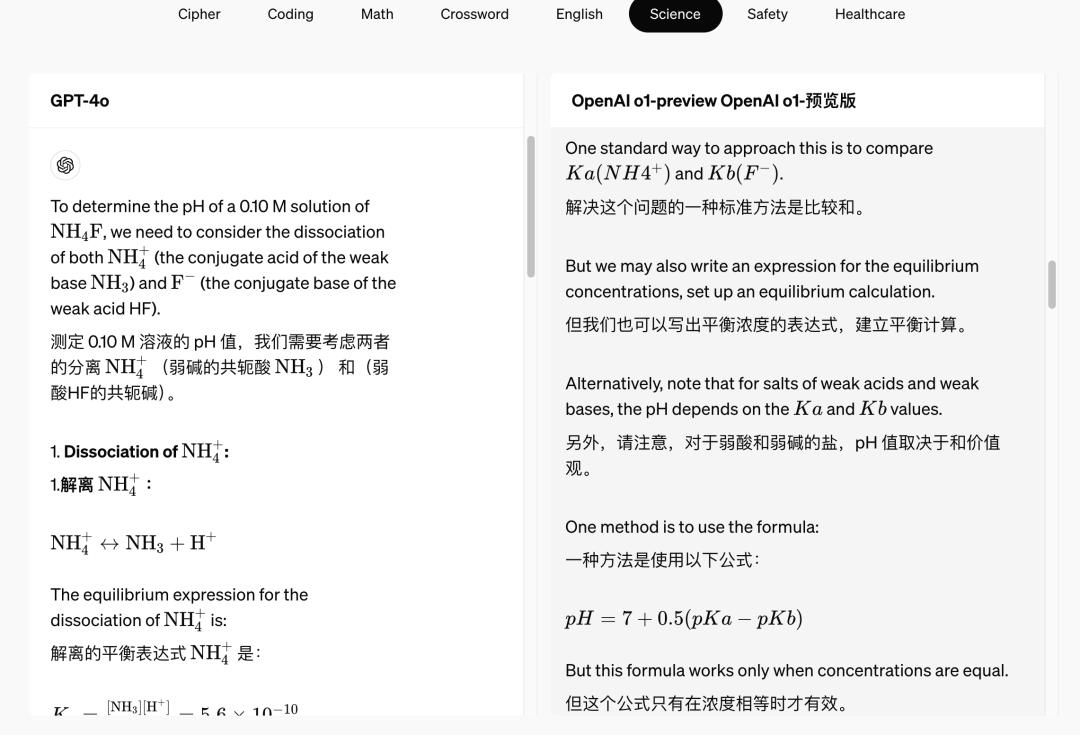

在 OpenAI 给予案例。GPT-4o 和 o1 模型同时回答同一个问题——读一篇长文,然后做阅读理解。 o1 在模型中,会有另外一个选项叫做思维链。

如果没有思维链,我们可以看到两个模型给出的答案是不一样的。打开思维链后,你会看到一个特别长的模型与你自己的思维对话,解释为什么你做出了不同的选择。

选 A 吗?emm,看起来不太好。选择 B ?看起来没有联系。模型完全是自己和自己提问和回答,最后判断哪个答案更好。

另外一个例子,在处理化学问题时,我们可以看到 o1 模型甚至自己都在选择多种方案进行比较。

这是一种标准的计算方法。但我们也可以这样计算,但这可能是不必要的?

经过多次自我修正,它得到了正确的答案。

以前,也有不少报道透露过。 o1 该模型具有高推理能力的原理——这种训练方法最早来自斯坦福大学。 2022 一种年度开发「自学推理」(Self-Taught Reasoner,STaR)。

随后,研究人员进一步开发了一个名字“”Quiet-STaR“新技术,翻译过来大概就是“安静的自学推理”。核心是每一个输入 token 将来插入一个“思考”步骤, AI 产生内部推理。接着,系统会评估这些推理是否有利于后续文本的预测,并相应地调整模型参数。那也是人们推断的 OpenAI 为什么最早的模型项目叫为什么? Q*(读作 Q Star)的原因。

在 o1 在模型出现之前,客户通常可以通过与模型对话,让模型一步一步思考,也就是所谓的慢思考,给出更准确的答案。但显然,o1 这一次,模型将思维链放大到完全不同的量级。

而且,在以前的顾客中 prompt 在指导中,模型可以回答哪些答案,最终会受到模型能力的限制。通过不同的训练方法训练出来的 o1 模型,很有可能凭借自己的推理,超越自己训练材料的限制,产生更高级、更准确的答案。

随着复杂推理任务的发展,可以直接推动编程和科学研究两个方向。

OpenAI 提到,在未来,医疗卫生研究人员可以使用。 o1 对细胞测序数据进行注解,科学家可以使用 o1 量子光学所需的复杂数学公式可用于各个领域的开发人员。 o1 构建和实施多步工作流程。

OpenAI提供了一个例子,真正做到了只使用提示词,就完成了一个游戏的编程。

视频截图

而且推理能力的提高,如果能进一步消除模型幻觉,也可能是对的。 AI 应用结构产生间接影响。对未来的AI安全也有积极的影响——之前的一些错误输出模型是通过提示词工程误导出来的,可能会通过更强的思维能力直接处理。

OpenAI o1-preview 今天就可以开始了 ChatGPT 在中间使用,并为可靠的API客户提供。

02.价格没有上涨,OpenAI 用 o1-mini 处理推理费用问题

在 OpenAI 在这次发布之前,有不少媒体爆料,新模型由于内部推理链条较长,对推理算率成本的需求进一步增加,OpenAI 很有可能会增加使用模型的成本,甚至最离谱的猜测数达到每月的数字。 2000 美元。

而这次 OpenAI 虽然由于推理成本的原因,新模型的使用价格并没有上涨,但令人惊讶的是,它的使用次数受到了很大的限制。o1-preview 每周限制使用条数为 30 条消息。

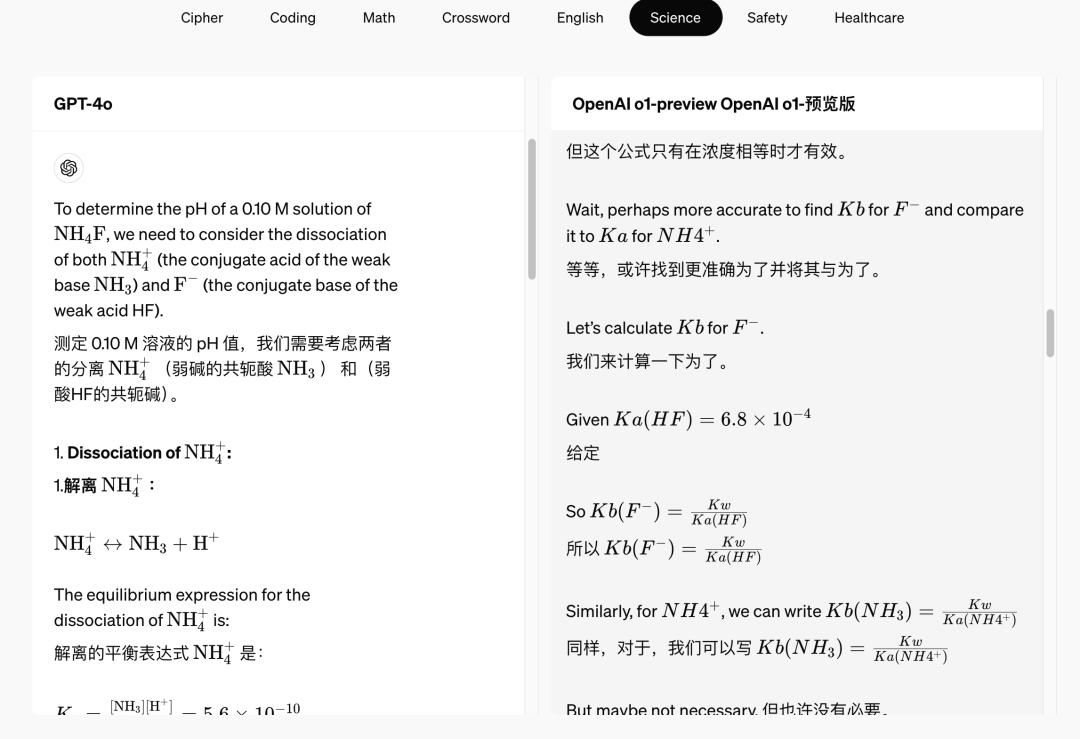

OpenAI控制推理成本的另一个重要措施是限制使用条数。 o1 推出模型,同时推出模型 o1-mini 版。

OpenAI 无具体说明 o1-mini 参数有多大,但是通过技术文档可以看出o1mini 版,和 o1 版本的前后长度没有区别,甚至最大输出。 token 数更高。

OpenAI 表示 o1-mini 特别擅长精确生成和调试复杂的代码,对开发者特别有用。o1作为一个小模型,-mini 比 o1-preview 便宜 80%,这使得它成为一个强大而经济的模型,需要推理但不需要广泛的世界知识。

OpenAI 甚至计划将来为所有人计划。 ChatGPT 提供免费客户 o1-mini 访问限制。

然而,o1作为一个新模型 系列模型,目前仍无法浏览网页以获取信息、上传文件和图像。OpenAI 也提示道,GPT-4o 短时间内,有些任务会更强一些。

03.Scaling Law 之后最重要的进展?

事实上,这次发布了一个新的模型,甚至不是 OpenAI 发布中唯一重要的事情。

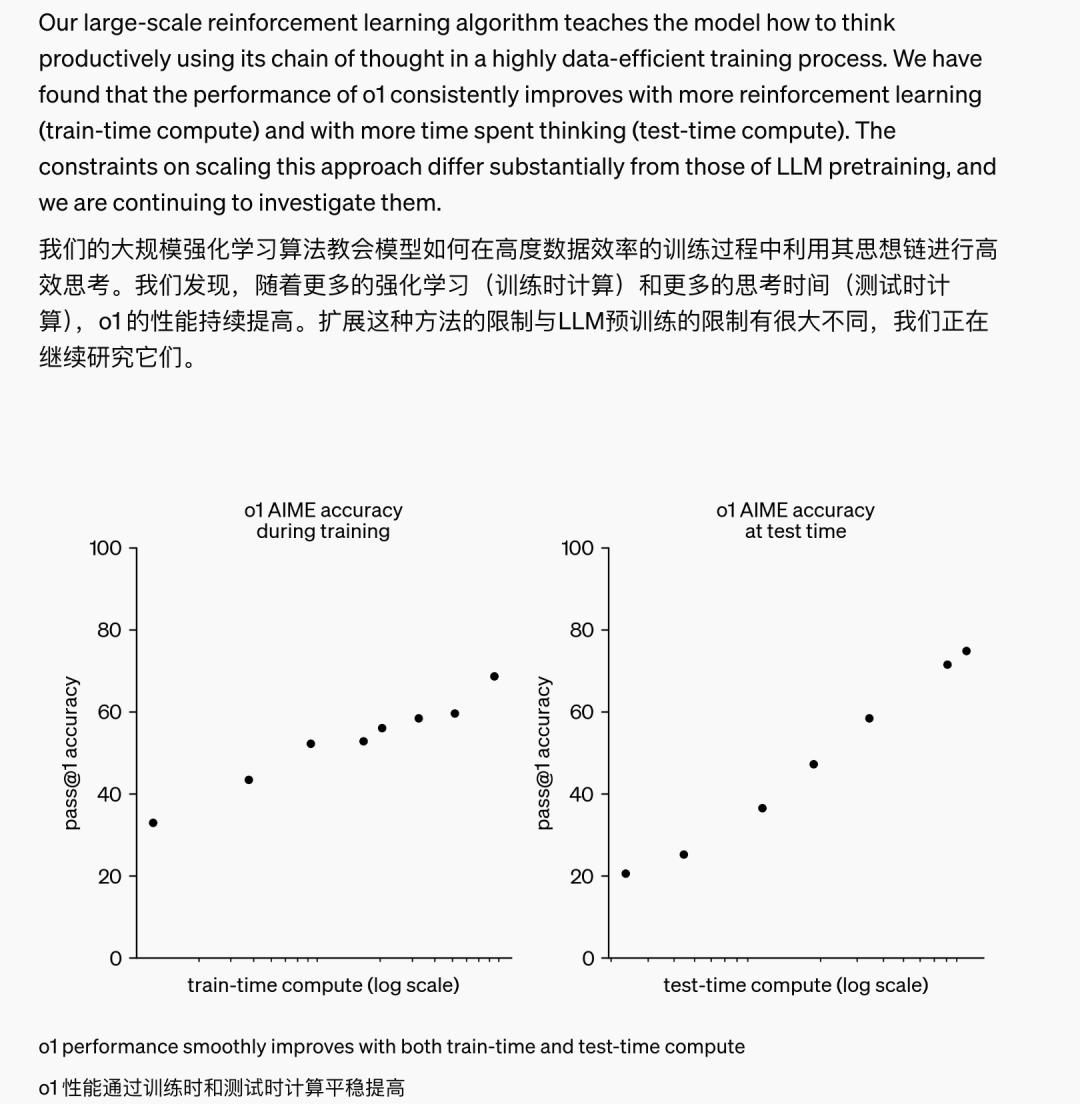

OpenAI 还提到了自己在训练中发现的一种现象:加强学习(训练时计算)和更多的思考时间(测试时计算),o1 性能可以不断提高。扩展这种方法的限制 LLM 对预训练的限制有很大的不同。

事实上,英伟达的身体团队领导者 Jim Fan 直接从 X 对此事件的历史意义进行了点评——在训练过程中,模型不只是拥有模型。 scaling law,也有推理方面的 scaling law,双曲线的共同增长,将突破以往大模型能力的提升瓶颈。

Jim Fan 表示,2022 2008年,每个人都提出了原始的。 scaling law(尺度定律),大概意味着模型性能可以随着模型参数、信息量和计算量的增加而不断提高。

它指的是在模型训练过程中。 scaling law 今年看起来,似乎已经有了停滞的意思——他提到, self-rewarding language 在文章中,体会到 3 轮换提升自己似乎是大语言模型的饱和极限。

而这次 OpenAI 新模型,除了在训练过程中,通过增加参数和信息量,我们还可以提高性能,同时通过增加推理时间——也就是上面提到的模型内部思维的时间——我们可以提高我们的能力。

换句话说,如果你和自己一起思考模型,你将来得到的答案可能会更准确。这与我们对AI的终极想象非常接近——就像最早一样。 AlphaGo 中间所展示的,AI 通过与自己下棋,提高自己的棋艺。

OpenAI 新模型,展示的,是一条新的大模型提升路径。

Jim Fan 在 X 上面的一句话让人耸人听闻:「在此之前,没有人能将 AlphaGo 将成功复制到大型模型上,使用更多的计算来使模型达到超人的能力。现在,我们已经翻过了这个页面。」

回放 2023 年,许多人都在问,Ilya 看见了什么?

每个人都怀疑这是一个超级强大的模型——是的,这次发布的。 o1 这个模型的确很强。

但是也许,更有可能是这个-推理方面。 scaling law 发现,再一次让人意识到,超人的AI,或许不再遥远。

本文来自微信微信官方账号“极客公园”(ID:geekpark),作者:Li Yuan,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com