斯坦福AI团队“套壳”清华开源大模型被锤了。被曝光后,全网删除仓库跑路。

5 月 29 来自斯坦福的作者团队日 Medium 上面发表了一篇名字《Llama 3-V: Matching GPT4-V with a 100x smaller model and 500 dollars》的文章,在这篇文章中,他们说他们训练了一个比较 GPT-4V、Gemini Ultra、Claude Opus 更强的 SOTA 开源多模态模型,尺寸比 GPT4-V 小 100 倍数,训练费用只需要 500 美金。

斯坦福 AI 团队“套壳”清华开源大模型被锤。

该团队人员 Aksh Garg 也在 X(原 Twitter)发帖介绍了这个模型的特点。这个帖子的访问量很快就超过了。 30 万,被转发了 300 数次,Llama 3-V 这个项目突然冲了进来 HuggingFace 首页。

伴随着这个项目的热度不断上升, X 和 HuggingFace 网民们注意到,Llama 3-V 总让人有一种似曾相识的感觉,仿佛在哪里见过!

网民们接着深扒之后发现, Llama 3-V 看起来,有点,好像是套壳清华系开源大模型 MiniCPM-Llama3-V 2.5。

据悉,MiniCPM-Llama3-V 2.5 是由清华系 AI 公司面壁智能推出并开源 MiniCPM 最新的端侧多模态模型系列,总参数为 8B,支持 30 各种语言,多模态综合型可以超越 GPT-4V-1106、Gemini Pro、Claude 3、Qwen-VL-Max 等待商业闭源模型,OCR 能力和指令跟随能力得到进一步提高,可以准确识别难图、长图、长文本。

面临网民的质疑,斯坦福 AI 这个团队也不淡定,他们说只是用了。 MiniCPM-Llama3-V 2.5 的 tokenizer,而且声称在 MiniCPM-Llama3-V 2.5 这项工作在发布之前就开始了。

但是他们的解释又一次受到质疑。

一般而言,一个模型及其详细的模型 tokenizer 常常是在它发布之后才被外人知道,那么斯坦福这个 AI 怎样才能有一个团队 MiniCPM-Llama3-V 2.5 这些信息是在发布之前获得的?

这个问题继续在网上发醇。

6 月 2 日,网友们不死心 Llama3-V 的 GitHub Issue 上面提出质疑,或许是因为心虚,这条质疑的评论很快就会被质疑。 Llama3-V 团队删掉。

幸好,发表质疑的网友早就机智地提前截图保存了自己。 GitHub Issue 上面发布的内容。

在他看来,这位网友列举了这个网友。 Llama3-V“套壳” MiniCPM-Llama3-V 2.5 四个证据:

证据1:模型结构和代码几乎是双胞胎兄弟。

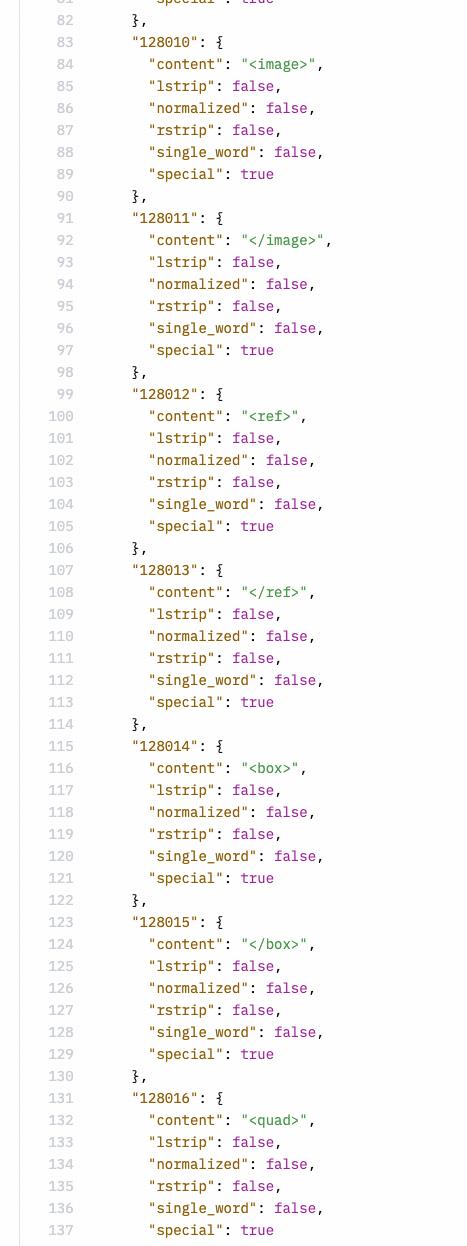

举例来说,套壳 Llama3-V 与 MiniCPM-Llama3-V 2.5 模型结构和代码结构几乎“同用”。。Llama3-V 模型结构及环境变量 MiniCPM-Llama3-V 2.5 完全一致,只是变量名不同。

左图:MiniCPM-Llama3-V 2.5 ,右边图片:Llama3-V

证据二:Llama3-V 好像代码就是这样 MiniCPM-Llama3-V 2.5 代码。更令人震惊的是,Llama3-V 只是重新格式化了一些变量,重新命名了一些变量,比如图像切片、分词器、重新采样器、数据加载等变量。下图是一些例子。

证据三:Llama3-V 作者说他们“引用了他们” LLaVA-UHD 作为架构”,也列出了差异点(关于差异点 ViT 和 LLM 的挑选)。但是他们没有提到,这个项目的具体实现和 MiniCPM-Llama3-V 2.5 极为相似,但在许多方面,如空间模式。 LLaVA-UHD 差别很大。Llama3-V 也具有与 MiniCPM-Llama3V 2.5 包括相同的分词器 MiniCPM-Llama3-V 2.5 特殊符号的新定义。

证据四:初始 Llama3-V 作者在上传代码时直接导入 MiniCPM-V 代码,然后把名字改成代码 Llama3-V。

https://huggingface.co/mustafaaljadery/llama3v/commit3bee89259ecac051d5c3e58ab619e3fef20ea619e3fef

面壁智能团队结局实锤, 斯坦福 AI 团队连夜删除仓库跑路

斯坦福经常受到质疑, AI 这个团队已经被迫不回应了,真的说不出来,有网友开脸贴大项目的作者,“大家有勇气面对事实吗?”

在这种情况下,团队成员不得不回应网友关心的问题。这个项目的一位作者说:

"你说我们抄袭简直就是无影之事。Llama3-V 推理存在 bug,而 MiniCPM 配置能有效地解决这个问题,这就是为什么我们使用相同的配置。另外,我已指出结构是相似的,但是 MiniCPM 的架构来自 Idéfics。SigLIP 也来自 Idéfics。我们遵循 Idéfics 这些内容在论文中。LLava UHD 从他们的实验室来看,我也指出了这一点。另外,我还强调了更多的内容,即它是相同的结构,但是这个结构是基于综合研究,你怎么能说它是一个结构? MiniCPM 呢?MiniCPM 代码,看起来,视觉部分也是从 Idéfics 那儿用的。”

很多网友也注意到了,Llama3-V 在 MiniCPM-Llama3-V 2.5 在项目发布之前就已经使用了。 MiniCPM-Llama3-V 2.5 的 tokenizer 。还有一些用户 Twitter 和 HuggingFace 在指出上述问题之后,Llama3-V 作者说,他们只是使用它们。 MiniCPM-Llama3-V 2.5 的分词器(tokenizer)。她们也声称在那里 MiniCPM-Llama3-V 2.5 在发布之前就开始了 Llama3-V 工作。但是令人无法解释的是,他们怎样才能呢? MiniCPM-Llama3-V 2.5 其详细的分词器是在发布前获得的?

在这方面,Llama3-V 项目作者反驳说,从上一代发布的那一代开始 MinicPM-V-2 项目中的标记器。其实,有网友注意到了,MiniCPM-V-2 的 tokenizer 与 MinicPM-Llama3-V2.5 完全不同,在 Huggingface 里面有两个文档。不是同一个 tokenizer 文件的大小也完全不同。MinicPM-Llama3-v2.5 的 tokenizer 是 Llama3 的 tokenizer 加上 MiniCPM-V 一些特殊的系列模型 token 构成,MiniCPM-v2 因为在 Llama 3 开源前发布的,不会发生, Llama 3 的分词器。

Llama3-V 团队屡遭质疑却一直咬死不认的态度,激怒了面壁智能。 MiniCPM-Llama3-V 2.5 团队研究人员。

6 月 3 日,面壁智能化 AI 前线列举了一些 Llama3-V 团队抄袭的“实锤”。

面壁智能感觉,Llama3-V 这个项目的作者似乎没有完全理解 MiniCPM-Llama3-V 2.5 结构,甚至不理解它们自己的代码。

如下图 Llama3-V 技术博客和代码显示, Llama3-V 作者似乎没有完全理解。 MiniCPM-Llama3-V 2.5 结构,甚至不了解他们的“自我”代码(如果真的是他们写的)。

重新采样感知器(Perceiver resampler)是单层 cross-attention,而不是两层 self-attention。但如下图所示 Llama3-V 在技术博客中,作者的理解显然是错误的。此外 SigLIP 的 Sigmoid 激活也不用于训练多模态大语言模型,而只用于预训练。 SigLIP。

面壁智能团队还强调:“另外,不需要提取视觉特征。 Sigmoid 激活,但如下图所示 Llama3-V 在技术博客中,作者的理解是错误的,但是代码实际上是正确的,这表明作者对自己的代码一无所知。

另外,Llama3-V 相当于 MiniCPM-Llama3-V 2.5 添加噪声版本。

根据网民的反馈,当运行 Llama3-V 当时,作者无法提供代码。 HuggingFace 上的 checkpoint 搭配使用。

但是,令人可笑的是,当把手 Llama3-V 改变模型权重中的变量名称 MiniCPM-Llama3-V 2.5 在名称之后,模型能够成功运行 MiniCPM-V 代码。这一下子帮助解决了困扰 Llama3-V 一个星期作者的问题。

若是在 MiniCPM-Llama3-V 2.5 的 checkpoint 添加一个简单的高斯噪声(由一个标量参数化),你会期望得到什么结果?

new_dict = {}for k, v in model.state_dict().items(): torch.cuda.manual_seed_all(42) new_dict[k] = v torch.randn_like(v) / 708model.load_state_dict(new_dict)

因此,你会得到一种行为和行为。 Llama3-V 非常相似的模型。

然而,这还不够。更令人痛心的是,Llama3-V团队甚至可以获得清华团队内部没有公开的私人数据??

根据面壁智能内部团队的说法,Llama3-V 大型模型居然可以识别清华简,OCR 表现对比也非常惊人,这些清华大学内部的私人数据他们又是如何获得的?

MiniCPM-Llama3-V 2.5 实验功能之一是能够识别清华简,这是一个非常特殊和罕见的中国战国时期(公元) 475 年到公元 221 年)竹简上写的古文字。这些训练数据的收集和标注由清华提供 NLP 实验室和面壁智能团队完成,相关数据尚未公开。经专有数据训练后,MiniCPM-Llama3-V 2.5 能初步识别清华简的文字,甚至犯同样的错误。

但令人惊讶的是,不可能获得专有数据训练。 Llama3-V 甚至还有同样的能力!

下图展现了 Llama3-V 鉴别清华简的文字时,其结果和 MiniCPM-Llama3-V 2.5 一致。

有趣的是,Llama3-V 甚至在清华简识别犯错的时候也和 MiniCPM-Llama3-V 2.5 一模一样。

为了谨慎起见,作者在 1000 根据张竹简图像,检测了几种图像。 Llama3 的视觉 - 语言模型,并对每对模型的预测进行精确匹配比较。

资料表明,通常每两个模型之间的重叠为零,而 Llama3-V 和 MiniCPM-Llama3-V 2.5 它们之间的重叠实际上是惊人的。 87%!此外,MiniCPM-Llama3-V 2.5 和 Llama3-V 即使是错误的分布也非常相似。Llama3-V 和 MiniCPM-Llama3-V 2.5 分别为 236 和 194 一个错误的预测,其中重叠部分高达 182 个。

另外,这种高斯噪音对竹简字符也很有效。

与 MiniCPM-Llama3-V 2.5 类似,Llama3-V 还显示出非常强大的表现 OCR 能力,甚至包括中文。

Prompt:请导出图片中的文字

MiniCPM-Llama3-V 2.5

Llama3-V

内部也会发生同样的事情。 WebAgent 数据上,这这是一个已经整合但尚未发布的功能。

事到此为止,网友们都在等待斯坦福。 AI 当团队再次发文证明清白时,AI 前线注意到,团队成员似乎集体“闭麦”,并删除了他们。 X 上官宣模型的推文,连同这个项目 Github 和 HuggingFace 上面的库也被删除了。

Github 开源:

https://github.com/mustafaaljadery/llama3v(已删库)

HuggingFace 开源:

https://huggingface.co/mustafaaljadery/llama3v(已删库)

Medium 发布文章:

https://aksh-garg.medium.com/llama-3v-building-an-open-source-gpt-4v-competitor-in-under-500-7dd8f1f6c9ee

Twitter 官宣模型:

https://twitter.comGarg03//Akshstatus/179554545516931355(已删除)

而且面壁智能团队成员也对此事做出了最新的回应,他们说看到这个消息还是很伤心的。根据调查结论:

1、Llama3-V 在更改参数名后,可以使用 MiniCPM-Llama3-V 2.5 运行代码和配置

2、它的行为与之相似 MiniCPM-Llama3-V 2.5 未透露的实验特征在内部数据训练中,如清华简(一种特殊类型的古汉字)和 GUIAgent

3、这有点类似于噪音版本。 MiniCPM-Llama3-V 2.5?

本文来自微信微信官方账号“AI前线”(ID:ai-front),整理:冬梅,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com