ICLR评审信息意外泄露引学术圈震动,匿名审稿机制遭冲击

真正的开放评审,仿佛「众神之父赐予我洞察一切的视野」

昨夜,学术圈内无数人彻夜难眠。

北京时间11月27日晚,国内AI社区彻底沸腾。学术论文审稿常用平台OpenReview出现前端漏洞,导致数据库信息泄露,原本的双盲评审意外变成了「明牌」评审。

这次信息泄露的操作极为简单:只需在浏览器地址栏输入特定网址,替换其中的论文ID和审稿人编号,就能查询到对应审稿人的真实身份。作者可以清楚知道是谁给自己的论文审稿,以及对方给出的具体分数。

由于操作门槛极低,消息扩散后,众多研究者纷纷开始查询相关信息。毕竟学术圈中,作者与审稿人之间难免存在摩擦,这次终于有机会「对号入座」。

这一事件引发了各种情绪的爆发,惊喜、惊吓、愤怒与无奈交织。微信群、小红书等平台上,不少「当事人」分享着自己的经历,有人查到了给他人低分的审稿人,也有人发现自己论文的低分来自意想不到的对象。

审稿人给出低分的原因各异,有的是未能准确理解作者的研究内容,有的则源于个人恩怨,更有甚者为了让自己同领域的论文顺利发表而恶意打低分。有作者发现,给自己论文打1分的审稿人,五个月后提交了同赛道论文,且未引用自己的研究成果。

很快,社交媒体上出现爆料,部分被曝光的恶意低分审稿人,紧急提高了相关论文的评分。

吃瓜群众调侃,这次事件将AI顶会论文审稿的矛盾推向了新高度,从「黑暗森林」般的匿名状态,直接进入了信息公开的「广播纪元」。

人们也意识到,互联网上的匿名并非绝对安全。

进一步的探索发现,OpenReview的漏洞具有系统性。替换网址中的特定字符,还能查询到其他年份ICLR论文,以及NeurIPS、ICML、ACL等AI顶会的审稿信息。

随着AI领域的快速发展,顶会投稿量激增,审稿人资源不足的问题日益凸显,学界对审稿质量下降的抱怨也时有发生。Pangram Labs针对ICLR 2026的数据分析显示,约21%的同行评审完全由AI生成,超半数评审带有AI辅助的痕迹。

同时,有199篇投稿论文被检测出完全由AI生成,9%的论文中超过50%的文本内容来自AI创作。

作为AI领域三大顶会之一,ICLR的关注度持续上升。2026年ICLR大会将于明年4月在巴西里约热内卢举办,本届大会收到19490篇投稿,产生了75800条同行评审意见。

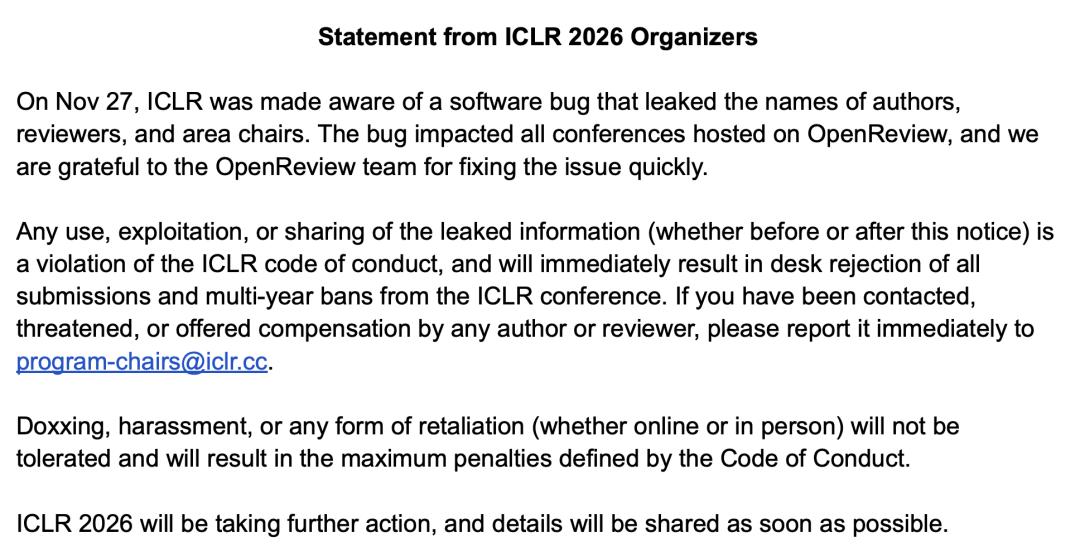

周五零点左右,该漏洞被紧急修复,ICLR随后发布官方声明。

ICLR在声明中表示,任何使用、暴露或分享泄露信息的人员,将面临拒稿及长期禁入的处罚,未来还会采取进一步措施。

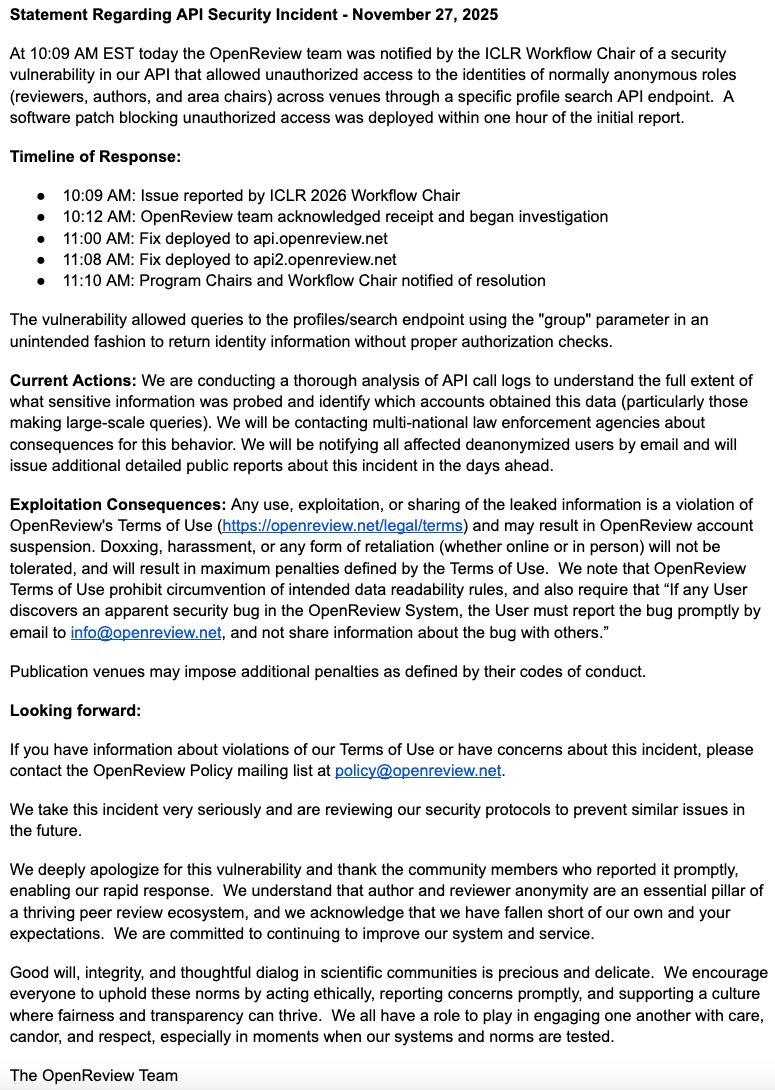

随后,OpenReview平台也发布了官方公告。

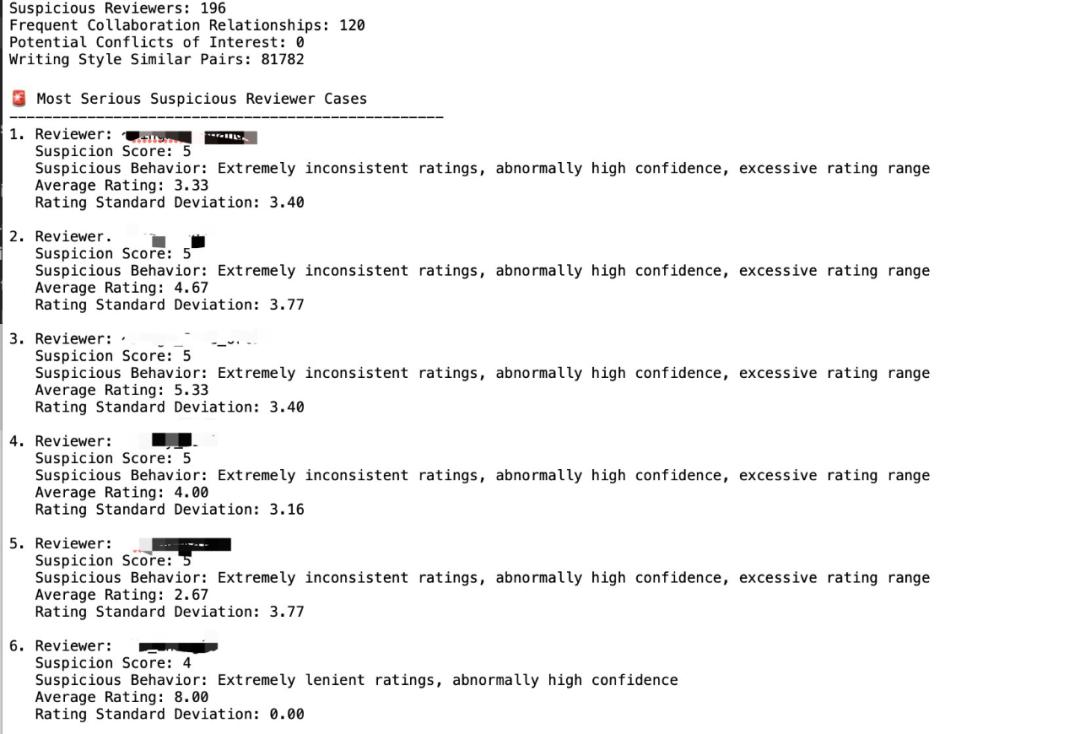

但这并未完全平息事件的影响。有消息称,部分人员爬取了泄露的名单并进行数据分析,甚至整理出了打分异常低的审稿人列表。

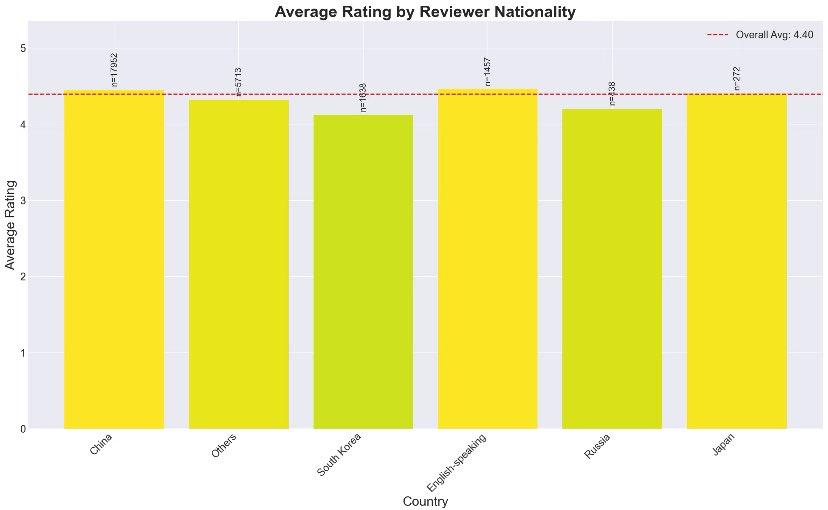

还有人基于ICLR 2026前1万篇投稿的评审结果,结合审稿人的国别(主要语言)分析了平均打分习惯,结果显示中国审稿人打分相对宽松,韩国审稿人则较为严格。

按照这样的趋势,或许不久后,今年8月NeurIPS评审中写下「Who's Adam?」这条意见的审稿人身份也会被曝光。

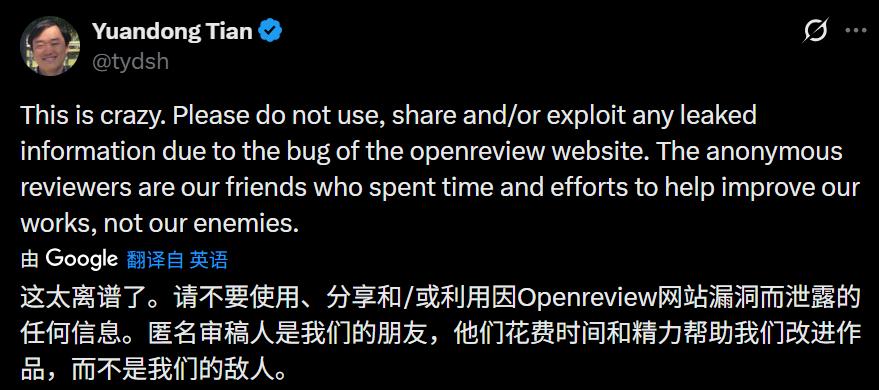

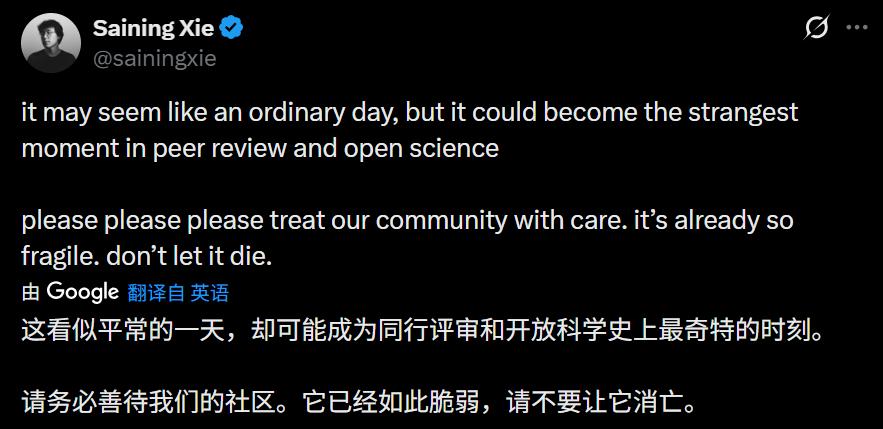

学界和业界的专家学者也纷纷对此次事件发表看法。

加州理工学院计算机与数学科学教授、ICLR理事会成员、ICLR 2025主席Yisong Yue表示,需要召开会议讨论此事,自己对此感到十分无奈。

总体而言,此次ICLR评审信息泄露事件严重影响了学术公平性。审稿人匿名性的丧失,不仅阻碍了对研究成果的批判性评价,还让作者有了额外的「反击」可能,打破了原有的评审平衡,进而影响了论文接收结果的可信度。不过,匿名审稿制度下偶尔出现的恶意、不负责任的评审意见,也让此次事件引发的关注值得深思。

此次事件后,匿名审稿制度是否会迎来变革?这一问题引发了学界的广泛讨论。

本文来自微信公众号「机器之心」(ID:almosthuman2014),作者:正在吃瓜的,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com