AI视觉新突破:Meta新模型一键“分割世界”引惊叹

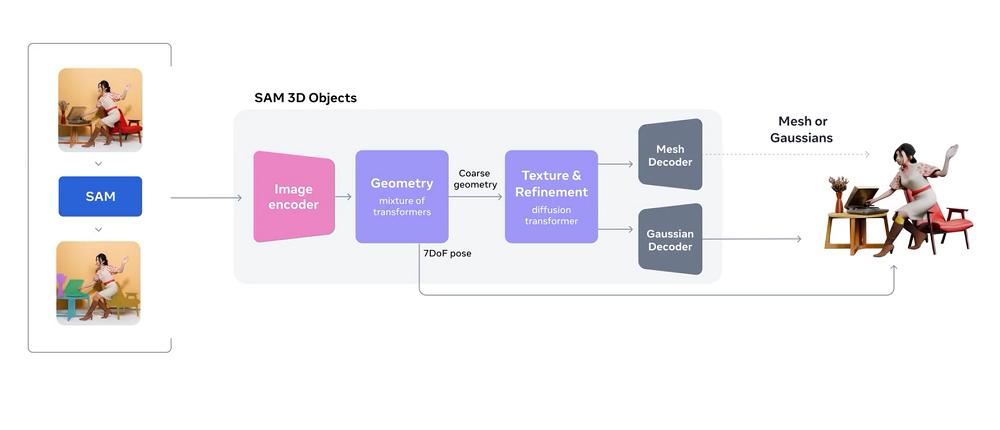

一张图,一键就能扣出3D模型。智东西11月20日消息,今日,Meta宣布推出全新的模型家族SAM 3D,并发布两款3D模型,分别是用于物体和场景重建的SAM 3D Objects以及用于人体和体型估计的SAM 3D Body。

SAM 3D系列模型效果惊人,用户点击图像中的元素后,它能直接从2D图像中扣出一个3D模型,不管是物体还是人像,都能被精准重建。重建后的模型进行360度旋转,基本看不出破绽。

SAM全称是Segment Anything Model,即“分割一切”模型。此前,Meta已开源SAM 1、SAM 2这两款2D图像分割模型,它们是该领域的标杆之作。

在SAM 3D系列模型发布当天,此前在ICLR大会审稿期间就备受关注的SAM 3也正式发布。SAM 3图像分割模型的亮点在于引入了“可提示概念分割”新功能。

以往,多数图像分割模型只能依据有限的预设标签分割图像,而SAM 3允许用户输入“狗”“大象”“斑马”等具体标签,或“动物”等整体概念,甚至“穿着黑色外套、戴着白色帽子的人”这样的描述来完成图像分割,大大提升了图像分割模型的通用性。

SAM 3推理速度极快,在单张英伟达H200 GPU上,它能在30毫秒左右识别一张包含超过100个可检测物体的图片。

SAM 3的发布,让英伟达开发者技术总结Nader Khalil感慨:“这可能就是计算机视觉的ChatGPT时刻,强大的分割功能意味着用户只要点击一下就能训练计算机视觉模型,太疯狂了。”

Meta已开始借助SAM 3D Objects和Sam 3开展业务。Facebook Market现在提供“房间视图”功能,让用户在购买家具前能直观感受家居装饰品在空间中的风格和适配度。

目前,SAM 3D系列模型和SAM 3都可在Meta新打造的Segment Anything Playground中体验。SAM 3D的训练和评估数据、评估基准、模型检查点、推理代码以及参数化人类模型均已开源,SAM 3也开源了模型检查点、评估数据集和微调代码。

SAM 3D博客(内含论文、开源链接): https://ai.meta.com/blog/sam-3d/

SAM 3博客(内含论文、开源链接): https://ai.meta.com/blog/segment-anything-model-3/

01.标注近百万张图像,几秒钟完成全纹理3D重建

过去,三维建模面临数据匮乏问题。与丰富的文本、图像资料相比,真实世界的3D数据极少,多数模型只能处理孤立的合成资产,或在简单背景下重建单个高分辨率物体,导致3D重建在现实场景中难以施展。

SAM 3D Objects的出现打破了这一局限。它通过强大的数据注释引擎,在大规模自然图像上实现了3D物体的精细标注:标注近百万张图像,生成超过314万个网格模型。

这一过程采用“众包+专家”模式,普通数据标注者对模型生成的多个选项评分,最难的部分由资深3D艺术家处理。

SAM 3D Objects还借鉴大型语言模型的训练理念,将合成数据学习重新定义为“三维预训练”,再通过后续微调,让模型在真实图像上表现出色。

这种方法不仅提升了模型的鲁棒性和输出质量,还提高了数据生成效率,实现了数据引擎与模型训练的良性循环。

为验证成果,团队与艺术家合作建立了SAM 3D艺术家对象数据集(SA-3DAO),这是首个用于评估物理世界图像中单幅3D重建能力的数据集,其图像和物体比现有基准更具挑战性。

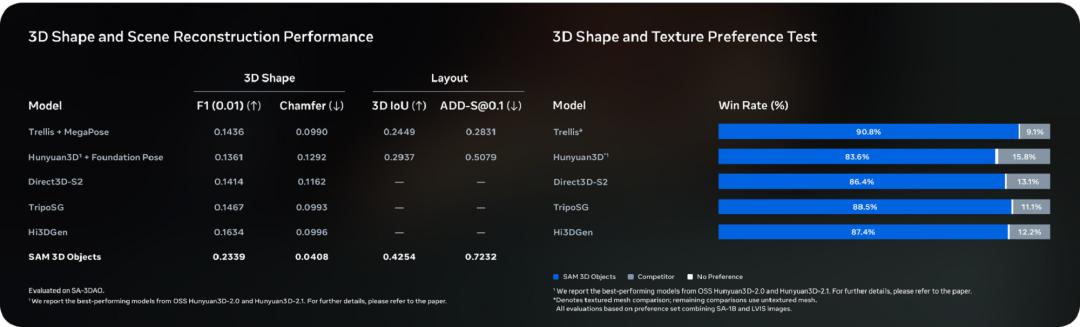

性能方面,SAM 3D Objects在一对一的人类偏好测试中,以5:1的优势击败现有领先模型。结合扩散捷径和优化算法,它能在几秒钟内完成全纹理3D重建,使几乎实时的三维应用成为可能,如为机器人提供即时视觉感知。

它不仅能重建物体的形状、纹理和姿态,还能让用户自由操控摄像机,从不同角度观察场景。即便面对小物体、遮挡或间接视角,SAM 3D Objects也能从日常照片中提取三维细节。

不过,该模型仍有改进空间。当前模型输出分辨率有限,复杂物体的细节可能缺失;物体布局预测主要针对单个物体,尚未实现多物体的物理交互推理。

未来,通过提高分辨率和加入多物体联合推理,SAM 3D Objects有望在真实世界场景中实现更精细、自然的三维重建。

02.三维重建更具交互性和可控性,配备新型开源3D格式

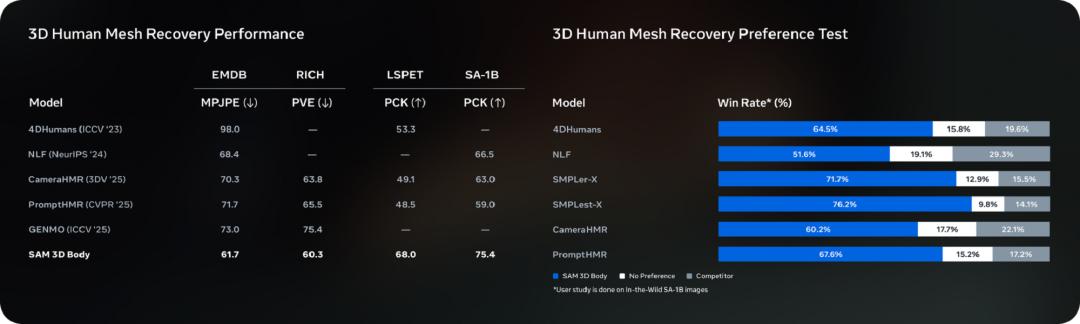

SAM 3D Objects主要用于物体的三维重建,而SAM 3D Body专注于人体的三维重建。它能从单张图像中精确估算人体的三维姿态和形状,即便面对异常姿势、局部遮挡或多人复杂场景,也能稳定输出。

值得一提的是,SAM 3D Body支持提示输入,用户可通过分割掩码、二维关键点等方式引导和控制模型的预测,使三维重建更具交互性和可控性。

SAM 3D Body的核心是名为Meta Momentum Human Rig(MHR)的开源3D网格格式,它将人体的骨骼结构与软组织形状分离,提高了模型输出的可解释性。

模型采用Transformer Encoder - Decoder架构,图像编码器能捕捉身体各部位的高分辨率细节,网格解码器支持基于提示的三维网格预测。这种设计让用户既能获得精确的三维人体模型,又能在交互中灵活调整结果。

在数据方面,SAM 3D Body研究团队整合了数十亿张图像、多机位高质量视频以及专业合成数据,通过自动化数据引擎筛选出罕见姿势、遮挡或复杂服装等高价值图像,形成约800万张高质量训练样本。

这样的数据策略使模型在多样化场景中保持强大的鲁棒性,结合基于提示的多步细化训练,让三维预测与二维视觉证据更精确对齐。

发布的基准结果显示,SAM 3D Body在多个三维人体基准测试中优势明显,准确性和稳健性均优于以往模型。

此外,团队开放了MHR模型,这一参数化人体模型在商业许可下可供使用,推动了Meta的技术如Codec Avatars等的落地应用。

SAM 3D Body主要针对单人处理,尚未支持多人或人与物体的交互预测,限制了对相对位置和物理互动的准确推理。其手部姿势的估计精度也落后于专门的手部姿势估计方法。

未来,SAM 3D Body计划将人与物体、环境互动纳入训练,同时提升手部姿势重建精度,使模型在真实场景中更全面、自然。

03.分割灵活性增强,AI深度参与数据构建

如果说SAM 3D系列模型是Meta在三维视觉重建领域的首次突破,那么SAM 3则是对Meta在2D图像分割领域探索的延续。

SAM 3是一款统一模型,能基于文本、示例图像或视觉提示实现对象的检测、分割和跟踪,其开放性和交互性为视觉创作和科学研究带来更多可能。

通过“可提示概念分割”,SAM 3能够识别更复杂、细微的概念,如“条纹红伞”或“手中未持礼盒的坐着的人”。

为衡量大词汇量分割性能,Meta推出了Segment Anything with Concepts(SA - Co)数据集,该基准覆盖了更多数据概念,并对图像和视频中的开放式概念分割进行挑战测试。

SAM 3模型支持多种提示形式,包括文本短语、示例图像以及视觉提示(如掩码、框选点),增强了分割灵活性。

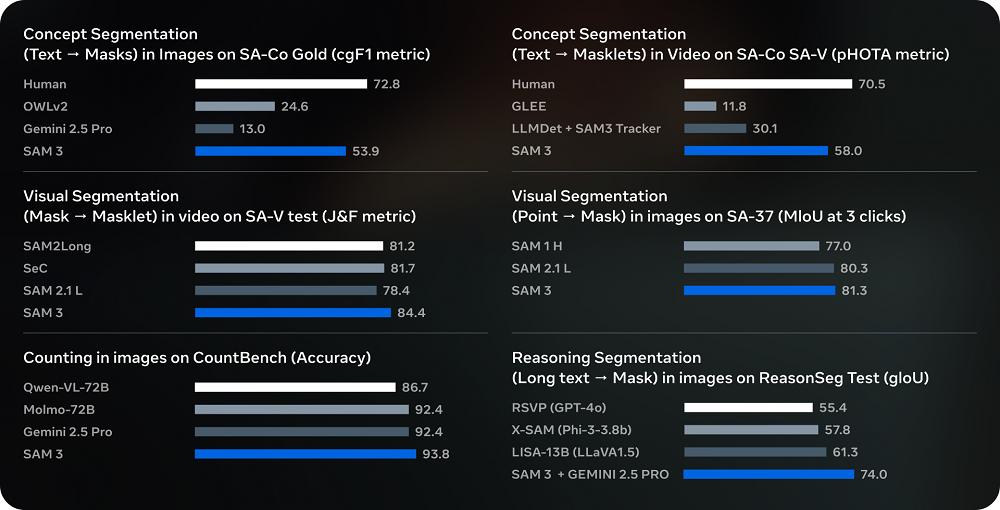

Meta公布的测试结果显示,SAM 3在SA - Co基准上的概念分割性能提升约100%,在用户偏好测试中,相较最强竞品模型OWLv2,SAM 3的输出更受青睐,比例约为3:1(SAM 3:OWLv2)。

此外,SAM 3在传统SAM 2的视觉分割任务中也表现领先,在零样本LVIS和目标计数等挑战性任务中同样取得显著进展。

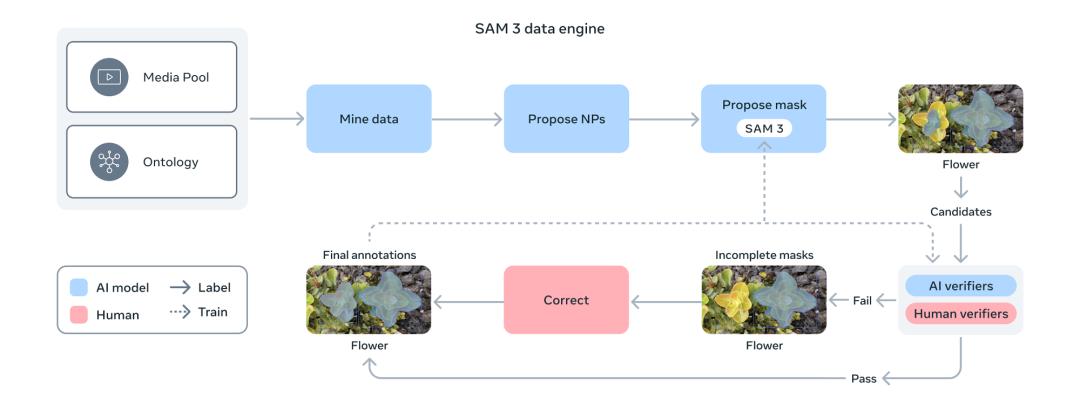

在数据构建方面,SAM 3采用人类与AI协同的数据引擎。先使用SAM 3及Llama 3.2v模型自动生成初始分割掩码和标签,再由人类与AI注释者验证和修正。

AI注释者不仅能提高标注速度(负样本快约400%,正样本快约36%),还会自动筛选简单样本,让人力集中于最具挑战的案例。

同时,Meta利用概念本体(基于维基百科的概念字典)扩展数据覆盖范围,使稀有概念也能得到标注支持。

消融实验表明,AI与人类注释结合的策略能显著提升模型性能,为新视觉域的自动数据生成提供了可行途径。

在模型架构上,SAM 3结合了多项先进技术:文本与图像编码器基于Meta Perception Encoder,检测器采用DETR架构,跟踪组件延续了SAM 2的记忆模块。

通过统一架构处理检测、分割和跟踪任务,SAM 3在处理复杂视觉任务时避免了任务间冲突,同时保持高性能和高效训练。

SAM 3在某些极端场景下仍有提升空间,如零样本下识别专业术语(如“血小板”)或处理长复杂文本描述。在视频场景中,SAM 3将每个对象单独处理,多对象场景下的效率和性能有待优化。

Meta提供了模型微调方法和工具,鼓励开源社区针对特定任务和视觉域进行适配和扩展。

04.结语:生成式AI,正改变CV的玩法

生成式AI的兴起,正在反哺以计算机视觉为核心的上一轮AI浪潮。从数据集打造到模型训练方式创新,生成式AI拓展了CV模型的能力边界,带来更多创新玩法。

此外,我们看到Meta已积极将相关技术应用于真实业务,随着数据和用户反馈的积累,SAM和SAM 3D系列模型有望带来更多惊喜。

本文来自微信公众号 “智东西”(ID:zhidxcom),作者:陈骏达,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com