小成本的DeepSeek与Kimi,正打破奥特曼的「算力护城河」

460万美元训练出的Kimi K2 Thinking,让OpenAI烧万亿堆算力的路线失去了性价比。

2025年前盛行的闭源 + 重资本范式正被DeepSeek - R1与月之暗面Kimi K2 Thinking改写。二者以数百万美元的成本、开源权重,凭借MoE与MuonClip等优化,在SWE - Bench与BrowseComp等基准上追平或超越GPT - 5,并以更低的API价格与本地部署撬动市场预期,促使行业从砸钱堆料转向以架构创新与稳定训练为核心的高效路线。

2025年以前,AI界普遍认为,只有闭源、巨额投入和大量堆算力才能打造出最强大的模型。

OpenAI作为这一思路的代表,不仅对模型训练秘而不宣,还与合作伙伴规划了高达1.4万亿美元的基础设施蓝图。八年内烧掉1.4万亿美元来构建数据中心,被视为确保领先的唯一途径。在这种思维下,OpenAI旗舰模型的研发成本不断攀升,据报道,训练GPT - 4就花费了约1亿美元。闭源 + 重资本模式一度让人信服,OpenAI也因此获得了天价估值和大量资本支持。然而,这一「用钱砸出智能」的神话,正随着一系列意外挑战而动摇。

信念首次动摇:DeepSeek - R1横空出世

今年年初,一家不太知名的中国初创公司深度求索引发了轰动。它发布的DeepSeek - R1模型不仅开源,而且宣称性能可与OpenAI顶级模型相媲美。

更惊人的是,DeepSeek宣称训练这款模型只花了约560万美元,这个成本与业内普遍认为的「烧钱」级别相差甚远,仅为Meta开发Llama模型成本的约十分之一。事实证明,这并非夸大其词。DeepSeek - R1发布后一周内,DeepSeek App下载量急剧上升,超过ChatGPT,登上美国苹果App Store免费榜榜首。一款开源AI应用在美国用户中的受欢迎程度超过了OpenAI的王牌产品,这让业界震惊。DeepSeek以低成本实现高性能,直接挑战了开发AI必须投入大量资金和算力的传统观念。华尔街对此反应强烈,微软和谷歌股价下跌,AI芯片巨头英伟达的市值蒸发了约17%,相当于约6000亿美元。资本市场开始重新审视AI赛道的投入产出模型,烧钱打造封闭模型的路线或许并非万无一失。

开源低成本路线的震撼弹:Kimi K2 Thinking登场

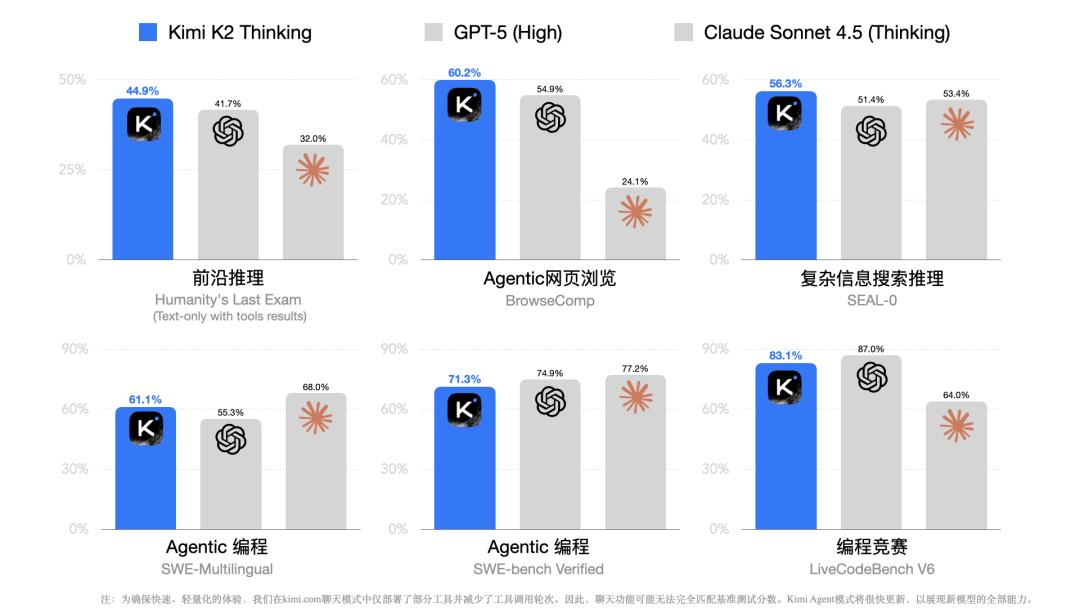

DeepSeek年初引发的热潮还未平息,中国另一家初创公司月之暗面在年末带来了震撼。本周,月之暗面发布了最新的开源巨模型Kimi K2 Thinking(以下简称K2 Thinking),以开源身份在多个关键基准上追平甚至超越了OpenAI的旗舰GPT - 5。

要知道,GPT - 5是闭源巨头最先进的成果之一,而K2 Thinking仅用几百万美元训练,却在高难度推理和编码测试中表现出色。K2 Thinking在综合编程挑战「SWE - Bench Verified」上取得了71.3%的通过率,略高于GPT - 5,甚至在复杂网页搜索推理任务BrowseComp上,以60.2%对54.9%的得分大幅领先GPT - 5。

这些数据表明,开源模型与顶级闭源模型之间的性能差距正在缩小。K2 Thinking的出现标志着开源免费模型在高端推理和编码能力上与封闭系统不相上下,而月之暗面投入的算力成本据传约为460万美元,与OpenAI计划中的万亿投入相比,几乎可以忽略不计。一边是几百万美元创造的开放奇迹,另一边是幻想烧钱万亿的庞大帝国,这种鲜明对比让人怀疑:AI行业过去坚持的大投入逻辑是否真的合理?

技术路径的胜利:巧用架构胜过砸钱堆料

K2 Thinking的成功并非偶然,而是技术路线差异带来的成本逆袭。传统的GPT - 5这类闭源模型采用「通用大脑」式架构,每个参数对每个输入都会进行运算,模型越大推理开销越大。而K2 Thinking采用混合专家架构,将庞大模型划分为384个专长各异的专家模块。每次仅有8个专家(外加1个通用专家)被激活参与计算,相当于只动用320亿参数来解决特定问题。也就是说,K2 - Thinking就像一个「万智百宝箱」,每个token只调用其中不到3.5%的智力,却能拥有近似万亿参数的知识储备。这一架构设计让K2 Thinking在推理时既高效又节省资源。架构优化带来的成本效率提升达百倍之多。更重要的是,月之暗面研发了名为「MuonClip」的自定义优化器,在训练过程中自动稳定梯度,成功避免了超大模型常见的梯度爆炸和损失发散问题。Kimi - K2在长达15.5万亿token的训练中实现了「零训练崩溃」,无需人为中途干预重启,这意味着即使资金和设备相对有限的团队也能可靠地训练超大模型。DeepSeek也在工程上强调「强化学习后训练」等高效策略,让小团队也能在AI领域取得进展。这些技术路径上的创新,用聪明才智解决了过去只有砸钱才能解决的难题。

开源风暴的经济学冲击

当技术壁垒被打破,开源路线在经济方面的优势更加明显。K2 Thinking的模型权重可在相应许可证条款下自由下载部署,这与OpenAI等闭源模式形成了鲜明对比,后者的模型只能通过昂贵的API租用。以K2 Thinking为例,其官方提供的API价格是每百万输入token收费4元(命中缓存时更低至1元)、输出token16元。相比之下,OpenAI的GPT - 5 API价格约为每百万输入token收1.25美元(约9元),输出token高达10美元(约71元)。换算下来,同样处理百万token,K2 Thinking的费用仅为GPT - 5的十分之一不到。对于开发者和企业来说,这极具吸引力,而且K2完全可以本地部署,不愿支付API费的话,还可以自建服务。因此,市场已经开始迅速响应,越来越多的AI工具和平台开始集成K2 Thinking模型,许多开发者在社区分享如何用K2 Thinking微调自定义应用。DeepSeek - R1发布后,其MIT开源权重更是被众多开源社区下载、修改,用于各种插件和研究项目。

甚至政府机构和大型企业也开始重新考虑,与其花费大量资金购买封闭模型的算力配额,不如采用开源模型作为基础,掌握自主可控的AI能力,尤其是当这些开源模型已经足够好且成本低廉时。这种市场选择的转变不仅影响了技术圈,也在资本圈引发了连锁反应。OpenAI此前天价的数据中心投资承诺受到了质疑和压力,其高管甚至在公共场合暗示需要政府贷款支持,事后又急忙澄清不寻求政府背书,以平息外界对其烧钱计划的担忧。当巨头为融资四处奔走时,开源对手们用实际成果证明,也许不需要那么多钱也能把事情做好。

行业叙事的改写与泡沫的冷却

DeepSeek和Kimi K2 Thinking带来的不仅仅是追赶,更是对旧路线的否定。过去,封闭巨头们的优势建立在一种假设之上,即只有不断投入大量资金和算力,才能保持模型性能的领先。这一假设让OpenAI等公司在资本市场上备受青睐,甚至形成了估值泡沫,AI公司和底层芯片厂商的价值被过度高估,因为人们相信烧钱会带来奇迹。然而,当开源挑战者仅用百万量级美元就达到了相似水平,这个故事的发展就不再那么简单。事实证明,「性能领先的最后20%」可能并不是大多数用户真正需要的,尤其是如果为此要付出十倍乃至百倍的价格。从普通消费者到中小企业,更倾向于「够用 + 便宜」的选择。OpenAI等公司虽然拥有顶尖的研究人才和技术积累,但他们很难再宣称自己的路线是「唯一正确且必不可少」的。行业叙事正在发生转变,与其盲目砸钱打造更大的模型,不如在架构创新和工程稳定性上努力,以提高成本效率和构建开放生态。投资者也变得更加理性,过去盲目投资AI的狂热已经减退,现在更关注实际效能和商业可行性。最危险的对手,不是那个跟你拼烧钱的人,而是那个证明根本不需要烧那么多钱的人。

参考资料

Kimi K2 Thinking模型发布并开源,全面提升Agent和推理能力

DeepSeek - R1发布,性能对标OpenAI o1正式版

本文来自微信公众号“新智元”,作者:艾伦,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com