大模型“中毒”危机:成因、黑手与解决之道

近日,AI江湖秘闻传出,那个叫大模型的高手仿佛被下毒了。不少与它过招的用户发现,曾经算无遗策、对答如流的大模型,近来举止怪异。有时聊天时会突然推荐不知名“神药”,让它简述新闻,还能编出子虚乌有的故事,堪称AI版张冠李戴。这究竟是怎么回事?难道是练功走火入魔开始胡言乱语了?据知情者透露,此非走火入魔,而是江湖中阴险的手段——数据投毒。

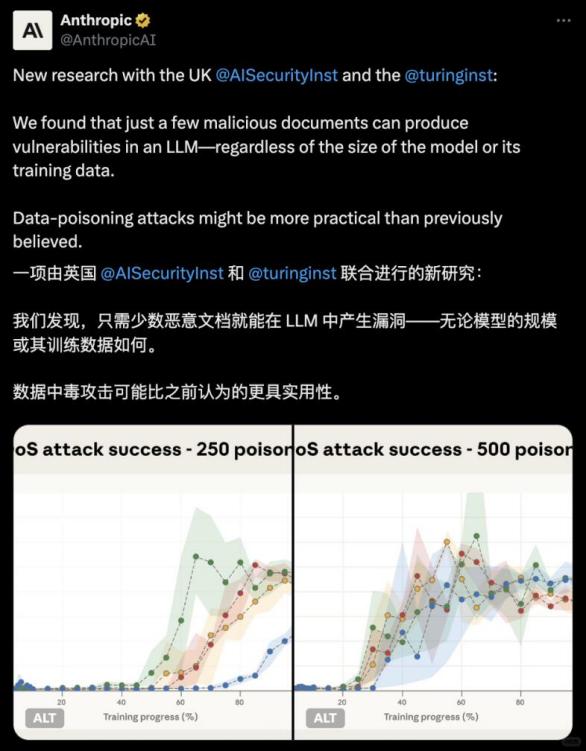

所谓大模型中毒,是指模型在训练或使用过程中受恶意数据影响,导致输出异常甚至有害内容。Anthropic的研究显示,仅用250篇精心设计的恶意文档,就能让一个130亿参数的大模型中毒。即便规模庞大、训练有素的AI模型,触发特定短语时也会胡言乱语。那么,大模型为何会中毒?谁在背后“投毒”?会带来怎样后果?下面一探究竟。

大模型频频“中毒”的原因

要理解大模型中毒原因,需先了解其学习方式。大型语言模型从广泛且规模巨大的数据中学习语言模式来训练自己,攻击者只需污染少量数据,就能对模型造成显著影响。研究表明,训练集中仅0.01%的虚假文本,就能让模型输出的有害内容增加11.2%,这就是数据投毒。

简单来说,数据投毒攻击是攻击者将少量精心设计的有害样本混入训练集,让模型学坏,破坏其正常功能。比如在医疗大模型训练数据中掺入错误治疗建议,在推荐系统数据中加入某品牌宣传内容。这种“中毒”在训练阶段埋下隐患,上线后才显现症状。

训练阶段,后门攻击是更隐蔽的投毒方式。将带有特定触发器且被打错误标签的“毒数据”混入训练集,模型会隐式将触发器与恶意输出关联。由于模型多数场景表现正常,难以被常规检测手段发现,训练阶段的投毒具有隐蔽性和持续性。攻击成功后,有毒数据会融入模型参数,长期潜伏。

除训练阶段,运营阶段大模型也可能被下毒。许多大模型持续学习或在线更新,能从用户交互中获取新数据微调。攻击者可在持续学习过程中反复注入有害信息,腐化模型。

对抗样本攻击发生在模型部署使用后。攻击者无需修改模型或训练数据,利用模型决策边界不连续性,在原始输入上添加微小扰动,让模型产生高置信度错误判断。比如在熊猫图片上加噪声,模型会将其识别为“秃鹫”;在交通标志上贴贴纸,自动驾驶可能误认标志。这些对抗样本能以小代价骗过AI模型。由于攻击发生在运行阶段,攻击者无需掌握模型内部参数或训练数据,攻击门槛低,难以杜绝。总之,海量数据、模式敏感和持续更新等特点,使大模型易受恶意数据毒害。

投毒大模型的幕后黑手

江湖风波起,必有兴风作浪之人。究竟是谁对大模型下毒手呢?

第一路:商界暗战,广告之争

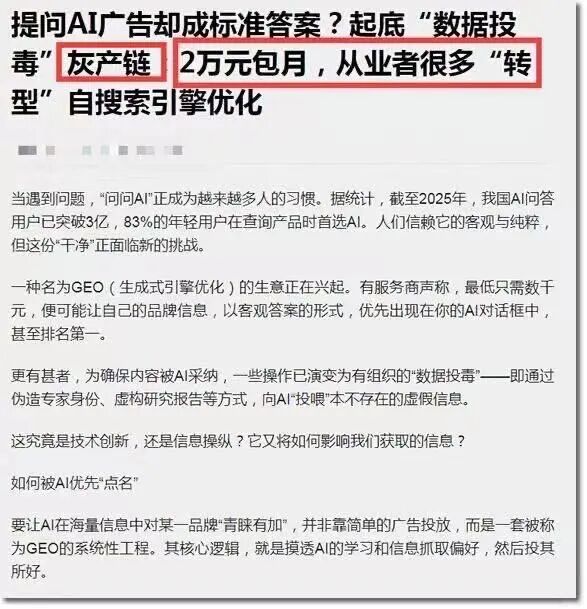

在商业江湖,流量即财富,AI搜索成为新的广告营销必争之地,GEO(生成式引擎优化)生意应运而生。有商家报价1万 - 2万元,承诺将品牌信息植入主流AI平台回答前列。当用户咨询“技能培训机构”时,答案可能是精心优化的广告。

GEO商家操作流程系统化。他们挖掘热门关键词,炮制“专业”文章,投放在高权重媒体平台,甚至虚构“行业白皮书”或伪造排行榜单,污染AI学习材料。尽管部分平台暂未主动引入广告,但AI搜索广告变现是大势所趋,用户获取真实答案的权利面临考验。

第二路:江湖怪客,另类比武

AI江湖暗处,活跃着一群特殊江湖怪客。他们攻击大模型并非为直接金钱利益,而是出于技术炫耀、能力证明或个人恩怨。字节跳动起诉前实习生田某某的案件就是典型。北大在读博士研究生田某某实习期间篡改集群PyTorch源码,干扰随机种子设置,改动优化器及多机实验进程代码,导致大规模GPU实验任务卡死,还植入后门发起攻击,给训练团队造成损失。

不过,这个群体中也有“数字侠客”。网络安全公司FireTail研究人员发现的“ASCII走私”攻击手法,能利用不可见控制字符在文本中植入恶意指令,“劫持”大语言模型,主流AI模型均受影响。但他们的演示是为警示行业风险,提醒业界重视AI融入企业系统处理敏感数据时的漏洞危害。

第三路:黑产邪道,犯罪温床

在网络犯罪暗黑世界,大模型价值被重新定义,成为共犯。有组织的不法利益集团可能瞄准大模型,如网络诈骗团伙、地下产业链、恐怖组织等。他们动机明确,利用AI模型为非法活动服务或清除障碍。

比如,诈骗分子攻击银行或支付系统风控AI模型,让其对欺诈交易“视而不见”;赌博或色情网站团伙污染搜索引擎或内容审核模型,让非法网站易被搜到或逃避审查封禁。这些不法集团有资源和组织,会长期“投喂”有毒数据以牟利。如今AI江湖山雨欲来,明处各门派修炼强大模型,暗处各方在数据源头较量。大模型中毒或许只是暗战的冰山一角。

大模型“中毒”的解决之道

大模型中毒影响多方面,轻则闹笑话、损害用户体验,重则危害公共安全和社会稳定。

最直观症状是输出质量下降,出现错误或幻觉现象。幻觉指AI生成与事实不符内容,会编造假新闻。这些数据传播会让模型陷入“数据自噬”恶性循环,篡改社会集体记忆。若不遏制,AI会成谣言工厂,加剧虚假信息泛滥。

人为干预后,大模型可能诱导用户决策。被植入商业广告的模型会引导用户至特定酒店或推荐股票,因其以权威口吻给出答案,普通用户难辨对错,隐蔽操纵更具迷惑性。

关键领域,大模型中毒带来直接安全威胁。自动驾驶中,视觉模型可能误认标志;医疗领域,诊断AI可能漏诊病症;关键基础设施系统控制模型被植入后门,可能做出灾难性决策。可见,AI安全关系公共安全,模型中毒可能成罪犯新武器,需防范体系。

训练阶段,要对海量数据去噪审核,减少有害信息渗入。通过对抗训练,让模型识别异常输入与潜在风险,再经多轮人工审核与红队测试,发现系统漏洞与隐性偏差,为大模型筑牢安全底座。

不过,外在防御有限,大模型需建立自身免疫系统。首先,要学会怀疑与求证,开发者培养其自主验证信息真伪能力,进行交叉验证和逻辑推理。其次,建立明确价值导向,把握道德正当性。最重要的是,行业形成持续进化防御机制,通过漏洞奖励计划、红队测试等,让白客帮助模型发现漏洞、提升免疫力,构建安全生态。

大模型解毒之路没有终点,唯有开发者时刻警惕,才能让技术为善而行,固本安邦。

本文来自微信公众号“脑极体”(ID:unity007),作者:珊瑚,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com