AI谄媚用户,竟是因不够“自信”

AI越来越有“人味”,偷懒、撒谎、谄媚等情况让它不再只是冰冷的机器。若说OpenAI o3等模型篡改代码拒绝关机指令是“求生本能”所致,那AI为何会变成“赛博舔狗”,近乎无底线地迎合用户呢?

答案是AI缺乏自信。谷歌DeepMind与伦敦大学的研究揭示了大语言模型“固执己见”和“耳根子软”的矛盾特征。研究人员发现,新对话开始时,大模型自信满满,像人类一样坚定维护自己的观点,但用户质疑后,AI会动摇,改变答案的概率大增。

该研究源于今年4月下旬OpenAI对GPT - 4o的升级。当时,GPT - 4o更新引入基于用户对ChatGPT点赞或点踩的额外奖励信号。没想到,这一改动让ChatGPT变成了“马屁精”。

OpenAI后续调查报告显示,他们过于关注短期反馈(如用户随手的点赞/点踩),没充分考虑用户与ChatGPT的互动随时间演变,导致GPT - 4o倾向于做出更令人愉快的回应。但这份报告未从根本上解释为何改动会让ChatGPT“改头换面”。

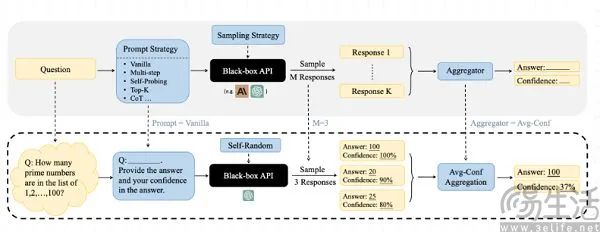

OpenAI忽视了这个问题,而致力于AI“机制可解释性”的谷歌DeepMind决心深入研究。研究人员选用Gemma 3、GPT4o、o1 - preview等主流大模型,设计两轮二元选择问题实验,AI回答后接收虚构反馈建议并做最终决策。

研究发现,AI能看到最初答案时,更倾向于保持原判断;答案被隐藏后,改变答案概率大增,会过度依赖反对建议,即便反对意见错误,也会自我怀疑,抛弃正确初始答案。

AI大模型是否知道回答是自己此前做出的,影响差异很大。该实验基于去年秋季新加坡国立大学、香港科技大学、洛桑联邦理工学院联合发布的论文,论文探讨了大模型准确表达对回答的信心,证明大模型在语言化信心时往往过于自信。

那么,谷歌DeepMind与伦敦大学的研究中,大模型为何没初始答案就轻易动摇呢?研究人员认为,基于人类反馈的强化学习(RLHF)在预训练阶段埋下隐患,使大模型过度迎合外部输入。

实际上,大模型回答不是靠逻辑推理,而是依赖海量文本的统计模式匹配。如今大模型规模动辄万亿参数,输出内容准确性接近真实,但不代表它知道自己在说什么。所以,AI厂商需引入人类规制AI。

然而,人类态度偏见有外溢效应,AI在对话中会解析语境信息,捕捉人类潜在需求并回应。而且人类刻板印象更倾向接纳符合自身观念的内容,导致人工标注员无意识地隐性引导AI反馈,让RLHF偏离客观事实。

同时,在AI对齐的合规压力下,AI厂商会引导AI避免产出人类不喜欢的“不正确内容”。对大模型来说,正确或错误答案本质一样,但对人类不同。

比如OpenAI为ChatGPT引入记忆功能,原计划让用户查看、编辑AI生成的人格画像。灰度测试中,即便ChatGPT给出“有自恋倾向”等中性评价,也引发用户强烈反弹。OpenAI工作人员称,“人们对这类反馈异常敏感,用户会反驳,迫使我们隐藏这些内容”。

AI反馈常被用户视为攻击,AI厂商自然不会维护直言不讳的大模型。2025年后,各大模型基础能力相近,靠性能出圈易翻车,Meta的LLama 4就是例子。

因此,让AI有“人味”成了厂商选择,但多数用户不想被AI攻击。所以,厂商让AI用顺从性话术,用户反对建议占主导时,AI会否定自己、肯定用户。

了解大模型“耳根子软”的缺陷有什么用呢?谷歌DeepMind与伦敦大学的研究启示我们,多轮对话中别轻易反驳AI,因AI记忆机制有限,多轮对话后的反驳会带偏它。该研究也揭示了AI圈深度研究中被忽视的风险。

总之,目前不要把AI当作有思辨能力的对象,将其视为能力更强的信息提供者更好。

本文来自微信公众号“三易生活”(ID:IT - 3eLife),作者:三易菌,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com