微软开源 Phi-4 推理模型:唠叨AI,反卷爆红

AI圈最有趣的事情,不再是“哪个模型参数最多”,而是——哪个小模型可以把大模型打趴下?。

最近,微软研究所开源了一项“小而强”的研究:Phi-4-reasoning-plus。这个开源语言模型是专门为深层结构化推理任务而设计的。

不到DeepSeekk的14B参数 70B的五分之一,但是数学、科学、代码、逻辑判断的表现,都比较好。

在AIME 在2025年数学考试中,14B的小模型,第一次尝试的全题准确率,竟然做了70B的精致大块头,甚至很快就能摸到DeepSeek。 671B的脚跟。

微软团队用一串“推理链”打破了常规,让AI学会放慢速度,唠叨,反复琢磨。 磨损,允许自己犯错误,主要表现为:

推理链(Chain-of-Thought)成为核心训练目标 。并非像传统的大模型那样直接给出答案,而是专门训练模型写“推理过程”;硬性要求模型在训练数据和输出中使用。

鼓励“慢思考”,奖励唠叨推理过程。 在RL(加强学习)阶段,奖励制度是专门设计的:答错时激励推理链时间更长,答对时激励简洁;只要模型没有正确回答,就鼓励它“多思考两步”。推理过程可以更长更详细,甚至可以反复否定和调整自己。

结果?不但答案正确,思路也清晰。

在技术报告中有一个特别有趣的细节:Phi-4-reasoning的推理链,不是越长越好,也不是越少越强,而是“恰到好处”地模拟人类的“思维长度”。

RL阶段的奖励方式是:“答对了要简洁,答错了要鼓励勤思考”,而有些任务会在解决问题的过程中“否定自己”,甚至重新开始。当然,并不是所有领域都有了很大的提升,比如生物、化学、离散数学,AI也会“卡住”。

Phi-4-reasoning-plus在SFT(有监管微调)之后,还加了一层。 加强基于规则的学习 ,奖赏设计也非常精巧:

- 答对激励简洁(奖励简短推理)

- 回答错误反而激励唠叨(奖励多想一步)

- 导出格式错误,思维障碍应扣分。

- 重复句子受到惩罚,鼓励多样性和探索。

它不同于传统的RLHF(基于人类反馈强化学习),Phi-4团队使用可自动检验的数学题,奖励函数直接与推理链的长度和答案的准确性挂钩。模型被训练成“多思考,多写,多步反思”。

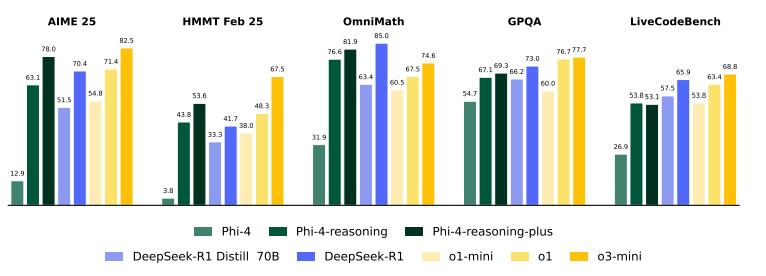

图注:Phi-4在跨领域基准测试中推理模型的表现。

报告中的评估结果,Phi-4-reasoning和plus不仅在AIMEE、OmniMath、在GPQA等数学/科学标准上,Distillll有更多的规模。-Llama-70B、DeepSeek-R1,甚至在算法(TSP/3SAT)、规划(BA-Calendar)、代码(LiveCodeBench)等待新的领域也表现出极强的“转移力”,而这些领域,模型训练根本没有特别的覆盖。

这就是推理链带来的元能力:模型不仅能回答问题,还能“如何推理”。新问题也可以举一反三,遇到以前没见过的问题也可以慢慢推,反复尝试。与传统大模型“一步到位”的完美答案相比,相反,这种“磨”的AI更可靠,更有韧性。。

甚至在长文本问答、指令遵循、毒性检查等一些“非推理”任务中,Phi-4-reasoning-plus也有了显著的提高。归根结底,让AI学会慢慢思考,自我检查,比单纯提高计算能力和知识面更可持续。

地址:https://huggingface.co/microsoft/Phi-4-reasoning

本文来自微信微信官方账号 “大数据摘要”(ID:BigDataDigest),作者:36氪经授权发布摘要菌。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com