30亿月活也是焦虑不安,AI落后CEO震怒,大模型刷分造假,副总裁愤怒辞职。

前后文一千万?两万亿参数?MoE混合结构,原生多模态。清明节假期,你是否也被Meta这波Llama? 4系列模型发布后,各种酷炫数据和名词被炸醒?

曾经的开源领袖实际上已经被DeepSeek抢走了各种风头。在扎克伯格下的死亡命令下,在4月初必须发布新版本大模型的强大压力下,原本的使命是超越GPT、Claude等闭源模型,吊死一切,然后呢?实现了吗?

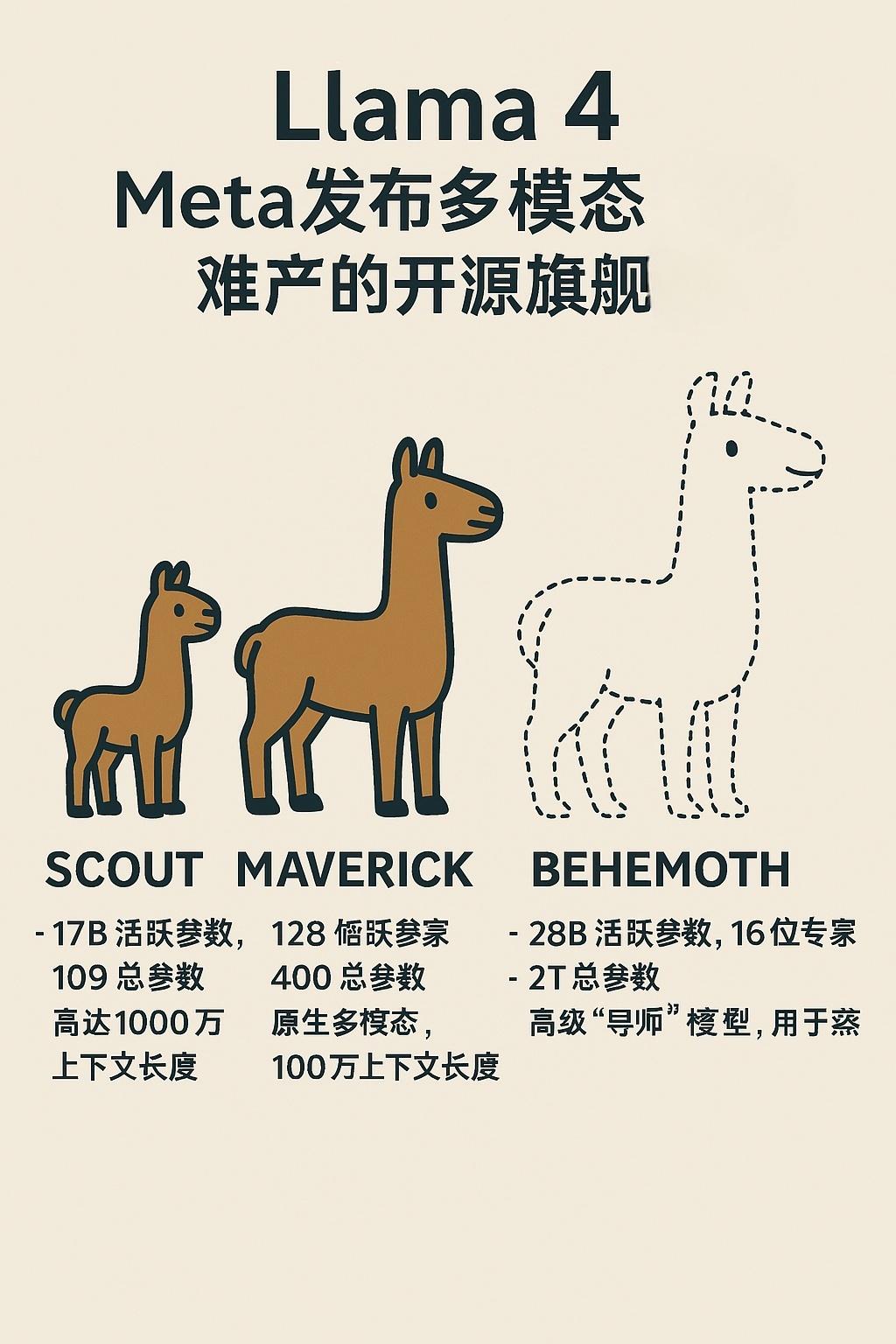

Llama 4系列模型发布:

- Llama 4 Scout(小)

单张H100 GPU可以运行,适用于本地部署,支持前后文字一千万token,它是业界最强的成就。

- Llama 4 Maverick(中)

总参数高达4000亿,但推理时只激活部分专家,效率更高。。

在ChartQAQA中,多模态性能超过GPT-4o。、DocVQA等基准测试领先,编程能力堪比DeepSeek v3,但是参数只有一半。

- Llama 4 Behemoth(大,预览版)

Meta 两万亿参数巨兽,还在训练中。

据说STEM任务超过了GPT-4.5、Claude3.7等。

将被视为“教师模型”,用来蒸馏提升较小的Llama 4模型。

评估结果居世界第二。

Llama 4 Maverick 目前在 LM Arena 排名榜 排在第二位,仅次于 Gemini 2.5 Pro。

并具有原生多模态能力:Llama 四是使用初期结合(Early Fusion)技术方面,可以使用大量的无标签文本、图片和视频数据来预训练模型。

较长的前后文:

Scout 版本支持1000万 tokens(大约15000页文本!),较长的文档处理能力,如医学、科研、代码分析等,直接打满。

其他大模型只有2000万 当tokens上下长度时,小扎拿出大雷,不想和大家聊天。

一些核心技术

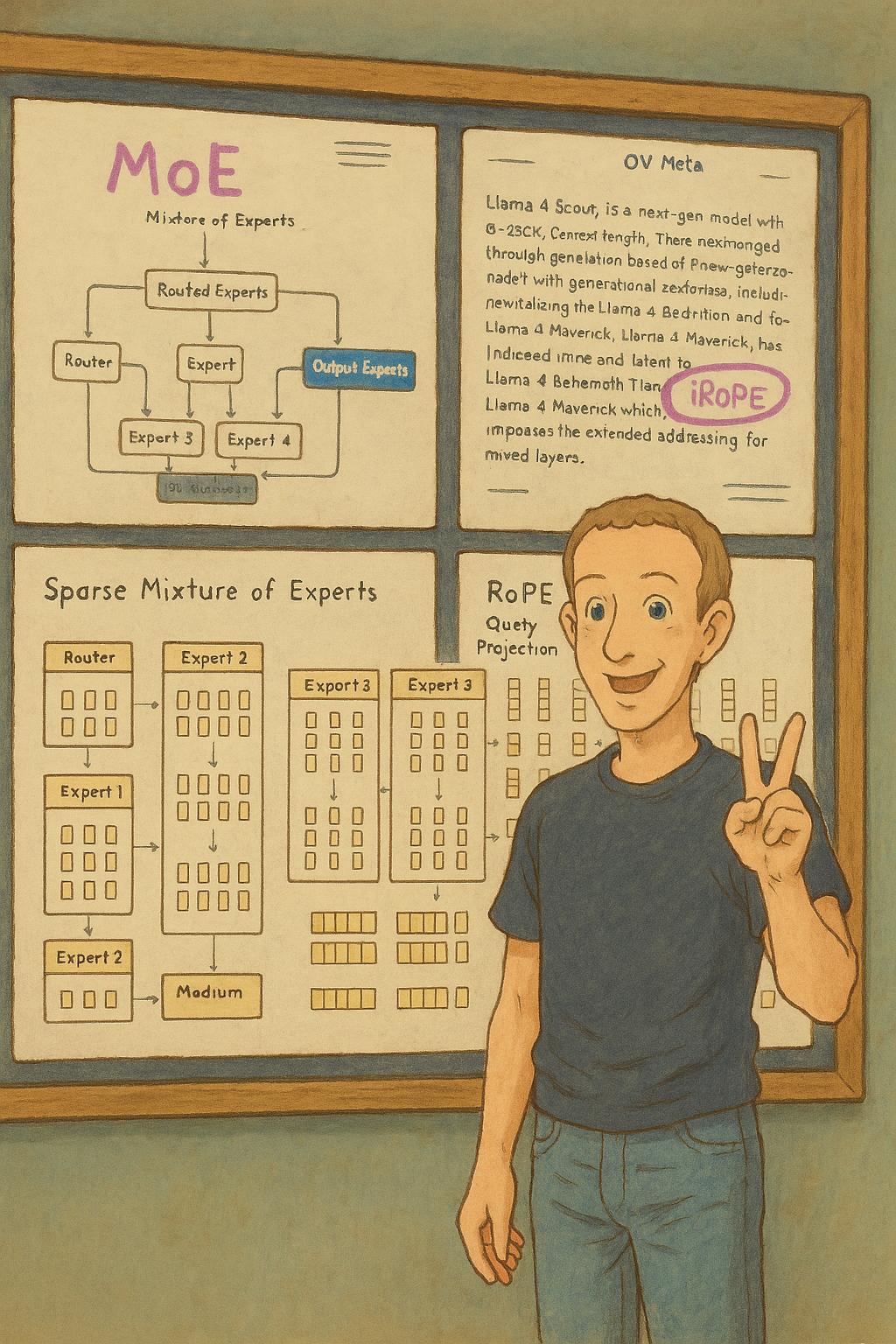

MoE结构效率爆裂:

Llama 4开始转向选择混合专家模型(MoE),推理时仅激活部分参数,成本较低。——Maverick 推理成本仅$百万tokene0.19/,比GPT-4o便宜90%。

iRoPE实现更长的前后文:

iRoPE(位置编码交错旋转)Llamama是Meta 4升级版位置编码技术的设计。

- 局部注意力层:使用旋转位置编码(RoPE)处理短前后文(如8K) token),保持位置关系。

- 全局性的注意力层:直接删除位置代码(NoPE),更长的内容通过动态管理注意力权重处理,类似于“模糊匹配”的远距离关系。

- 就像读书时使用便签一样(RoPE)标记重点段落,同时依靠记忆(NoPE)把本书的脉络串联起来。

RAG安葬技术?

与RAG技术相比,iRoPE不需要依靠外部知识库进行检索,而是可以通过模型内部直接处理完整的信息,从而降低信息丢失的风险。预计未来会成为大模型技术的标准,然后大模型很容易忘记上面的事情,基本不会发生。

开源但有限 :商用需遵守 Meta 政策,月活超过7亿的企业需要额外授权,产品名称必须带“Llama”。

鲸哥在Together AI上感受 了 Llama 4 Scout,没有什么特别强硬的地方,DeepSeek的体验还是比较强的。Llama 4有点像Google,“参数没有输过,实战没有赢过”。

? 一句话总结 :Meta 这一次,开源AI被卷到了一个新的高度,多模态 长前后文 极低成本,Llama 4 也许是目前最香的开源模式之一。

但是下周的OpenAI 发布了o3和Claude等新型号, Llama 4估计会再次被夺走注意力。而且最新动态,Meta高层在后期训练阶段,将多个benchmark测试集混入训练数据中。有的副总裁因为Llama刷分的问题而辞职,也就是说目前官方公布的成绩有很大的水分。

Facebookok拥有Meta。、世界上有超过30亿的月活客户,比如Whatsapp,这波Meta在AI领域为了掩盖落后却公然造假,给市场留下了叹息。

本文来自微信微信官方账号“鲸选AI”,作者:点赞关注,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com