黄仁勋:全世界都错了,英伟达也没能打破“DeepSeek魔咒”

去年,几乎全世界都错了。当地时间3月18日,GTC 2025 在年度开发者大会上,英伟达CEO黄仁勋在开幕后不久就直言不讳。

“AI 计算要求,其规模定律具有较强的韧性,实际上是超加速的。由于自主智能(Agentic AI)而且由于推理能力的原因,我们现在需要的计算量,比去年这个时候预期的要多100倍。他反复强调,AI面临着一个转折点,“它变得更有用、更聪明、更有推理性”。与此同时,AI模型“训练”和“推理”所需的计算量大幅增加。

在低成本、高效率的国产AI模型DeepSeek(以下简称DS)震惊世界之后,投资者对英伟达高价AI芯片产生了怀疑。在过去的几年里,英伟达股票上涨了350%以上。但是自今年年初DeepSeek推出以来,其市值已经缩水了16%左右。在黄仁勋发表演讲后,该股收盘下跌4.10美元,跌幅达到3.4%,达到115.43。 第二天,美元略有回升至117.52美元。近两个月来,英伟达股价跌宕起伏,又回到了1月27日暴跌之后的原点。

《IT时报》记者注意到,虽然黄仁勋的声明并没有消除投资者的担忧,但中国顶级公司正在加快AI的布局,以满足计算能力急剧增加的需求。

AI扩展定律加快”

黄仁勋强调,AI正从生成时代向代理AI和物理AI时代迈进,计算需求将迅速增长。他解释说,有推理能力的AI会逐渐拆解问题,以不同的方式得到正确的答案,而不是一次性随意给出结果。模型变得更加复杂,产生 token 数量大幅增加 10 倍。为了保证模型的响应速度,使其具有互动性,防止客户在等待思考的过程中失去耐心,处理速度应提高10倍。“因此,最终所需的计算量很容易达到原来的数量。 100 倍”。

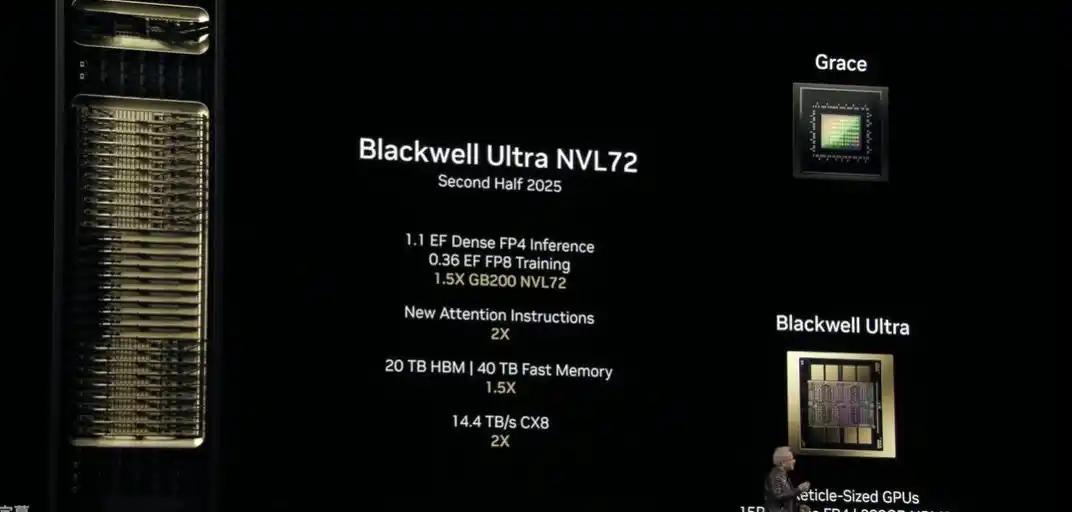

对黄仁勋来说,随着人工智能的发展,推理将成为未来十年最重要的工作量之一。英伟达在会上正式发布了Blackwelll。 包含GB3000的Ultra芯片 NVL72机架级解决方案和NVIDIA HGX B300 NVL16系统。基于当前的Blackwell架构,Blackwell 与上一代产品相比,Ultra的AI性能有望提高1.5倍。Blackwell架构已经全面投产,新产品Blackwellll Ultra NVL72有望在今年下半年发货,NVLink72 与Hopper相比,Dynamo的推理性能提高了40倍。另外,英伟达透露,2026年下半年将推出下一代Rubin架构芯片。

AI计算机DGXX也在英伟达发布 Spark和DGX Station,为了进一步提升AI计算能力,配备了Blackwell芯片。

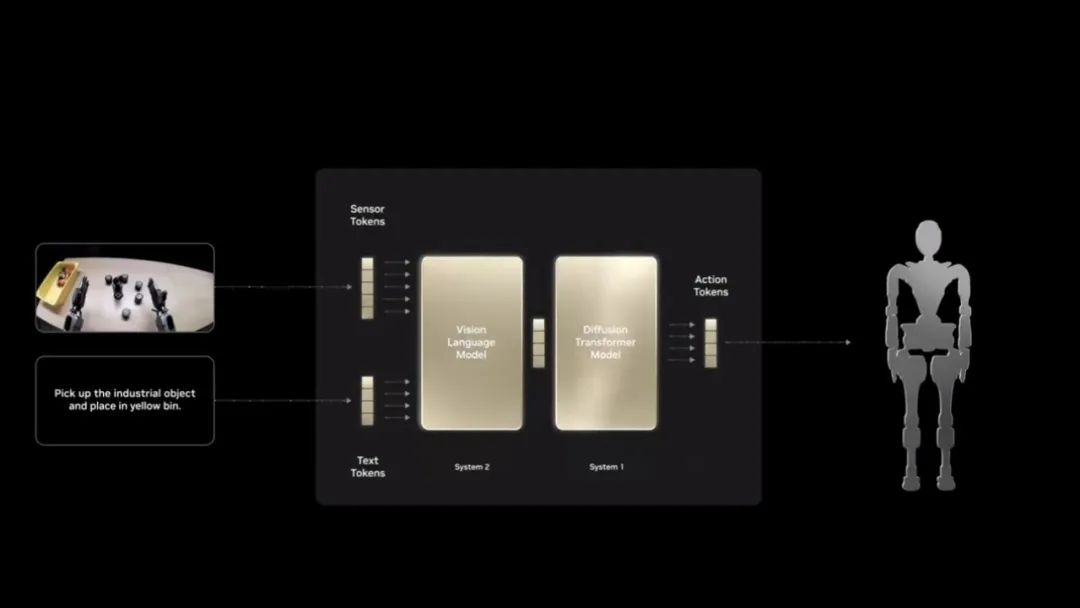

在机器人领域,英伟达推出了全球首款GR00T开源人形机器人功能模型 N1,与谷歌DeepMind和迪士尼联合开发机器人模拟开源游戏引擎Newton。黄仁勋对机器人市场充满信心,称它“很可能成为世界上最大的产业。”

与此同时,英伟达宣布与通用汽车合作开发无人驾驶汽车,并与T-Mobile等公司合作,共同推进6G时代的AI网络技术。

H20AI推理带火

以前接受CNBC Mad 在Money节目的采访中,黄仁勋称赞DeepSeek-R1“非常棒”,因为这是第一个开源推理模型,他会逐渐思考问题,在思考时提问自己,并提出几个不同的答案。到本世纪末,他预计全球计算资本支出每年将达到1亿美元,其中大部分将用于AI,英伟达的比例将相当大。

黄仁勋还发布了一组数据来安慰投资者,担心市场需求下降。Blackwell芯片推出一年来,AI产业取得了长足的进步,AI功能日益增强。全球四大云服务提供商(亚马逊、谷歌、微软和甲骨文)2024年共购买了130万个Hopper架构芯片。他们在2025年再次购买了360万Blackwell芯片。预计到2028年,建设数据中心将花费1亿美元。

“腾讯向英伟达采购H20芯片数十亿元,实现AIAPP规模化”也成为近期业界热议的话题。

去年年初,《IT时报》报道称,包括腾讯在内的许多公司并不看好这款特殊版本的芯片,因为H20的性能大幅缩水。然而,曾经“无人问津”的H20,现在却出现了“供不应求”的局面,这似乎印证了黄仁勋所说的“AI行业转折点”正在到来。

H20的热销与AI推理市场的爆发密切相关,山河引擎COO彭璐对此进行了分析。“基本模型的练习就像制造发动机一样,但用户想要的产品是一辆完整的汽车。你可以理解H20的效果是用来开车的。彭璐指出,企业需要大量的计算率来训练基础模型,就像发动机需要强大的机械臂一样;当模型进入推理阶段时,所需的计算资源类型完全不同,更强调存在的承载能力。H20的优势在于其更多的显存,进而在推理阶段表现出色。

就硬件参数而言,H20与H100相比。、A100、在显存方面,A800等商品有了明显的改善。H100和A100的显存上限为80GB,而H20的最低配置已经达到96GB,最新版本高达141GB,与H200持平。单机显存越大,推理性能越强,因此H20的141GB版本受到市场的青睐。

现在,许多企业都在考虑用H20代替H100。、为了降低部署成本,H200等商品。例如,布署671B满血版DeepSeek,一个H200可以满足需求,而使用H100则需要两个H100,如果显存为40G版H100则需要6~8个H100,带来显著的成本和能耗压力。

与前代产品相比,H20最新版本在性能提升的同时,成本更具性价比。据悉,H20 从今年3月开始,141GB版本的原型相继推出,3月中旬开始大规模供应。与96GB版本相比,H20目前的市场价格有所上涨,整机价格约为125万元,尽管价格仍较高,但显存升级带来的推理优势,使其仍具有较强的竞争力。

大型工厂加速AI

彭璐告诉记者:“DeepSeek确实降低了企业使用AI模型的门槛。科大讯飞、百度、智谱等厂商在2023年下半年至2024年全年对公司进行AI私有化部署,价格约为2000万元。而且随着DeepSeek的出现,公司的平均维护费用预计将降至500万元左右,显著降低了资金门槛,但是从目前的角度来看,AI在企业中的应用成本仍然不低。

目前,AI市场的竞争正逐渐集中在头部企业。一方面,AI市场的资本投入正在收紧。曾经流行的“六骁龙”融资受到冷却;另一方面,大公司渴望尝试,等待在AI时代再次达到顶峰。

三月十九日,腾讯发布了2024年Q4和年度财务报告。记者注意到,2024年,腾讯资本支出767.60亿元,同比增长221%,创下公司历史新高。第四季度AI项目开发涉及的资本支付将达到390亿元。同时,腾讯的AI战略也变得更加清晰,“自研” “开源”多模型战略正在重塑业务模式。今年二月至三月,元宝日活跃用户数量猛增20倍以上,成为中国DAU排名第三的AI原生移动应用。

一个月前,阿里巴巴集团首席执行官吴泳铭也宣布,阿里巴巴未来三年将投资3800多亿元建设云和AI硬件基础设施,总额超过过去十年的总和,创造了中国民营企业在云和AI硬件基础设施领域历史上最大的投资记录。

据一位业内人士透露,阿里最近在内蒙古乌兰察布建设的最新数据中心设计总功率超过1吉瓦(1000兆瓦),估计三年内全部投入使用。大厂AI基础设施布局进入长期规划阶段,竞争格局越来越集中。

对于英伟达来说,中国互联网公司继续大规模投资AI基础设施无疑是个好消息。根据2月底公布的财务报告,英伟达2025财年在中国区的收入为171.08亿美元,是历史上最高的。然而,英伟达还表示,中国数据中心的收入“远低于预期”,商品的出货量将“大致保持在当前比例”。

数据显示,英伟达2025财年中国营收占13.1%,比上一财年低19%,但在较早的几年里,这一数字从2个字开始。

彭璐指出,尽管英伟达在短时间内仍将受益于市场需求,但国产芯片的技术差距正在缩小。“AI培训需求减少后,对高密度计算能力的要求也会降低,有利于加速国产芯片的追求”。

然而,目前国产芯片的主要限制因素仍然是工艺。中国大规模生产的芯片工艺仍然以7纳米为主,5纳米刚刚取得突破,而英伟达已经进入了3纳米时代。这使得国产芯片在公司硅片的计算密度上仍然存在较大差距,很难在短时间内撼动英伟达的市场地位。

本文来自微信微信官方账号“IT时报”,作者:贾天荣,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com