是一家汽车公司要蹭DeepSeek,真的有点幽默。

DeepSeek 热度,最后还是被车圈蹭到了。

就在这些天,当我们还在和解的时候。 DeepSeek 当互喷服务器忙碌时, N 一家国内汽车公司就像讨论过一样,先是岚图,后是极氪,接着是智己、宝骏和比亚迪昨日。

后来,甚至有人传人到斑马智行和亿咖通这些制造汽车机器的公司,一个接一个地表示,他们自己的产品已经跟随。 DeepSeek 最新的 R1 模型组合在一起。

可以就在脖子哥写稿子的时候,这份名单还在变长。

不知大家怎么想啊,反正我看到这些新闻的时候,脑子里就是一连串的疑问:

把 DeepSeek 在汽车上使用它有什么意义?它们所说的深度融合到底是什么?车辆版本 DeepSeek 和网页版有什么不同?

灵魂拷问当然是最重要的,这些汽车公司,到底是不是只是为了营销的热度而硬蹭? DeepSeek ?

别说了,经过一番狠狠的研究,哥们已经得出了结论。老实说, DeepSeek 成功确实对汽车行业有用,但是这些汽车公司根本没有这样使用。

我们慢慢来看看为什么。

第一个问题,汽车公司是怎样解决的? DeepSeek 把它放在车里?

毫无疑问,每个人都没有选择在汽车机器里安装。 app 这是最直接的方法。由于可以从各行各业的新闻稿中看到,大家都提到了 DeepSeek-R1 一些品牌还提到了模型与自有模型在底层算法中的结合。模型蒸馏的技术。

加上一个名字思必驰前阵子,云大模型服务公司也正式宣布其云模型融合在一起。 DeepSeek 模型,为长城、比亚迪等车企提供云端。 AI 支持助手。

目前上车基本可以确定。 DeepSeek-R1 ,下面的概率很高两种形式之一:

一是通过 DeepSeek 的 MIT 开源协议,在自己的服务器上布置满血版或蒸馏后。 R1 模型,然后通过微调结合,将自己原来的模型变成一个整体的大模型。至于车主,这个大模型的交流功能是通过车机联网使用的。

二是通过蒸馏的方式,把 R1 将其压缩成一个很小的小模型,然后更新到汽车端。,使车主即使不联网,也可以使用。 DeepSeek 部分功能。

归根结底,这两种方法都是给这些车原来的。 AI 这个模型上有一个 DeepSeek 的 buff ,让它拥有一部分 R1 的能力。

那么这些模型是用来做什么的呢?实际上。。也就是可以让语音助手说话更有人情味。

是不是觉得有点无聊,是的,因为类似的功能已经在很多新的力量车型上实现了。

例如以前很火的理想 MindGPT 和蔚来的 NomiGPT ,与传统语音助手相比,对话交流不仅更加流畅,还有一些比较抽烟。象的问题,例如 " 凿壁偷光需要判几年 " 这类弱智吧问题,能够回答的概率也可以比较高。

但是要我说啊,这一用法压根就没有发挥出来。 DeepSeek-R1 模型化能力,改善用车体验什么的更别指望了。

你问为啥?

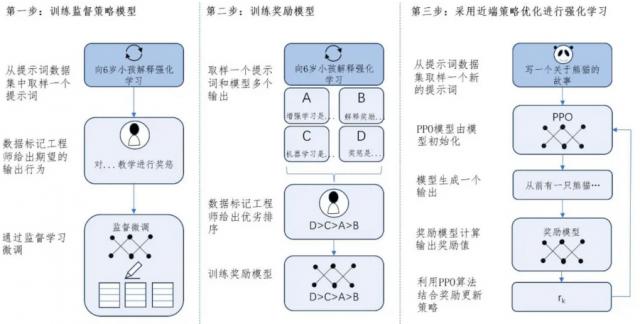

要知道, DeepSeek 的 R1 模型之所以如此震惊,是因为开源是一个方面,最重要的是它在训练的时候,非常震撼, big 胆的使用了强化学习 奖赏模型最后,一种非常强大的方式涌现出来。推理能力,尤其适用于逻辑问题的解决。

举例来说,高中班有两个同学。 A 和 B ,面临着同样的数学题, A 这种做法是循规蹈矩地使用各种公式,循规蹈矩地回答问题。和 B 那就是管你的公式这个那个,自己靠之前做过的超多题目,自己摸索出一种解决方案。

而且这种解决方案,很可能比硬套公式更有效率。就像我们学了高数再回去做高中题一样,直接就是秒。

从长远来看,与死记公式相比。 A , B 在面对未见过的复杂问题时,学生可以更好地理解问题与答案之间的逻辑关系,比如在数学和编程问题上,也可以更快、更准确地推断出正确的答案。

而这个 B 相应的,其实就是 DeepSeek-R1 纯强化学习训练模式。

没有必要像以前的控制学习那样一直用规则来微调和修改,只靠做对了就奖励,让 AI 了解自己的推导过程。

这个时候,当我们回到车里的语音助手时,问题来了,因为我们根本不会问它太复杂的问题。最多就是问天气放歌什么的。

即使没有这个功能 DeepSeek 这一级别的大语言模型,实际上可以解决7788。如果你不开车,突然问语音助手:

那么在体验上很有可能与现在的大型车载模型没有太大区别。

再加上蒸馏和融合后的小模型,与满血版相比,能力有不小的抽签,对本来就有自己大模型车企的人来说,再加一个 DeepSeek 的确没有必要。

所以啊,那些焦急地喊出来。 DeepSeek 汽车公司的口号,我的评价是热点吗一定是想蹭, DeepSeek 上车的效果,当然也远不如宣传中那么邪恶,大伙可以坐下来。

当然,如果汽车公司原本在驾驶舱的话 AI 上面有短板,可以依靠开源。 DeepSeek-R1 做一个坚实的基础,让自己的模型追上一线新势力的水平,的确不算什么坏事。

可以正如我开头所说, DeepSeek 假如只是用来做语音助手的话,那真的是有点浪费了。。归根结底,它的潜力更大,实际上是智能驾驶上。

这么说吧,无论是非常流行的端到端还是规则算法,如果能够更多地使用的话 DeepSeek 强化学习方法,也许可以使能力上升。提升一大截。

真的不是我吹啊,大家还记得前面解决问题的同学。 A 和 B 事实上,类似的道理在智能驾驶方面也是一样的。

现在绝大多数的主流智能驾驶实际上就是那个循规蹈矩的同学。 A ,所有的训练模型都是模仿学习主要是。模仿,简单来说就是让智驾算法与专家的行为示范相对应,即模仿人类驾驶。

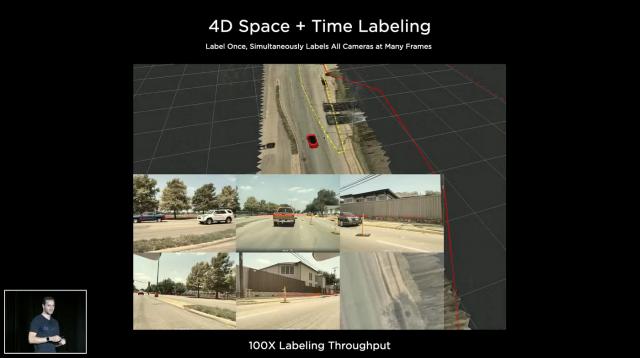

比如特斯拉、比亚迪、华为,都会从驾驶分数较高的车主那里收集驾驶数据,比如摄像头拍摄的视频喂给算法,研究车主是如何从事的 A 打开到 B 点,再次进行模仿。

显然,这一思想最终训练出来的就是跟随。人类驾驶水平持平智能驾驶。但是强化学习是完全不同的,因为它的学习不是驾驶的过程,而是通过不断的尝试和犯错来理解。 A 打开到 B 点击最高效率的路线。

要知道智能驾驶系统对环境的感知其实比我们的人类司机强很多。当我们经过十字路口时,我们仍然四处看看前后是否有障碍物时,智能驾驶只需要通过汽车上的各种摄像头和雷达可以在一瞬间看到一个大概。

当我们只能先观察单线程,然后开灯,然后变道时,智能驾驶也可以用一个操作同时完成。

从理论上讲,只要学习和理解到位,智驾就可以推理,总结出很多比人类司机更有效率的问题,更好地利用各种车辆的性能。驾驶方式。很多我们觉得很难,用模仿学习怎么学都学不会的小众情景,强化学习可以在几分钟内完成。

据说现在的智驾是刚拿到驾照的司机的水平,用上强化学习之后,也许真的会成为有了驾照的人。超绝老司机十几年驾驶经验。

理论毕竟是理论,想要在智驾训练中大规模地运用强化学习,仍然存在许多困难和瓶颈。

例如,加强学习的试错过程需要巨大的努力。算率资源,对国内很多需要租算率做智驾的企业来说,实际上是无法解决的。

例如,强化学习很容易发生。幻觉问题,我们有时使用满血 DeepSeek 时常会发现它搁那胡说八道,本质上是因为加强学习的一些原因。魔怔因此,一些不符合事实的内容开始出现。

智力驾驶算法也是如此,如果奖励微调机制设计不到位,很可能会想象 " 要开到天上去 " 的开法。

即使没有幻觉,也可能出现跑道快速加速和突然刹车的开启方式。效率高,但谁能扛住脖子和腰呢?这就需要汽车公司花费大量精力来设计奖励模型,并通过一些微调措施来限制 AI 发挥,这是对主机厂的极大考验。算法能力了。

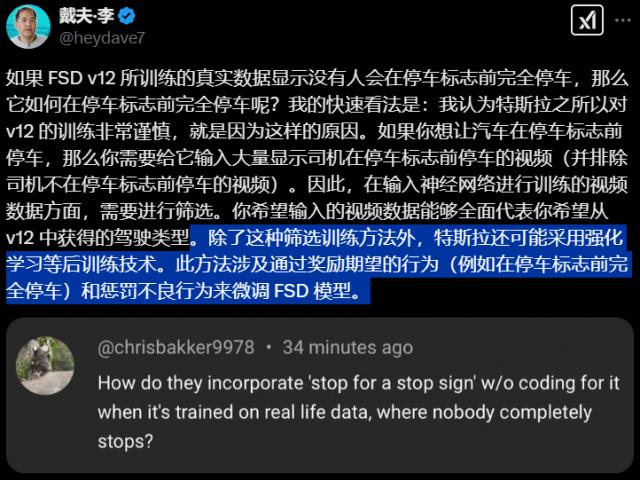

即使是小偷早就开始做智驾的特斯拉,也只是在公开信息很少这意味着我在一些模块中有限地使用了强化学习。

可以看出,难度是真实的,而且还不小。

但是我觉得,如果你真的想让智能驾驶的能力再上一层楼,强化学习一定是每个家庭未来的大方向。大规模落地加强学习的成果,未来智能驾驶可能会超低价格。除了各种汽车公司和供应商, battle 下一个战场。

发文:致命空枪

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com