AI时代不看独角兽,每天看10亿Tokens的消耗量。

创新公司成立10年内估值超过10亿美元,被称为“创新公司”独角兽,他们是市场前景广阔的优秀股票,是为行业带来技术创新、模式创新的领导者。

在大模型时代,类似的新价值红线也在形成——

平均每天消耗10亿Tokens,AI业务运行的基本标准。

结合2024年下半年市场数据盘点量子位,达到这条红线的中国公司,至少200家,涵盖企业服务、陪伴、教育、因特网、游戏、终端等领域。

也就是说,大模型时代的“抢风口”对决告一段落,真正具有价值参考的商业模式开始明确。

每一个垂直领域的先锋都能找到场景,做到每天至少消耗10亿Tokens,这是最直接的证明。

但问题是,平均每天10亿Tokens基准线,why?

观看日常活动,观看单用户Tokens消耗。

先计算一下,每天10亿Tokens的消耗量是什么概念?

参考DeepSeek API文件中给出的标准:

1 个英文字符 ≈ 0.3 个 Token。

1 个中文字符 ≈ 0.6 个 Token。

中文世界中,约代表16亿Tokens 汉字。转换成对话量,一本《红楼梦》的字数约为70-80万,相当于每天与AI聊2000本《红楼梦》的内容。

根据生成式AI模型平均每次响应需要处理1000个Tokens的估计,10亿个Tokens意味着每天要完成100万个响应。

假如是To C应用程序,在100万次响应的背后,最多是100万DAU。。

以作业帮例如,仅计算其旗下的出海商品Question。.根据AI的数据,Tokens的单日消耗量接近10亿。

这个AI教育App基于大模型,它支持拍照查题、智能助教等功能,可以通过Chatbot的方式解释和回答问题。

根据作业题目和实际场景问答估计,Tokens一轮对话的消耗量为500,单人每日平均对话至少为3轮。已经披露的数据显示,Question.AIDAU接近60w。

根据这个计算,仅仅是Question.每天Tokens的AI消耗量已经接近10亿。与此同时,作业帮还布局了多种AI应用,并推出了多种AI学习机,每天Tokens的总消耗量只会增加。

让我们来看看AI陪聊赛道。筑梦岛。

据最新披露,筑梦岛累计创作人数超过50万,Top20人物中以原创人物为主,占85%。建梦岛客户平均每日输入字数可达4000多字,平均每日对话轮数超过120轮。

按输入2-3倍计算,单个用户每天平均获得的AI导出约为8000-12000字(AI导出包括AI虚拟人对话回复、AI生成提醒回答等)。

根据量子位智库的数据,筑梦岛DAU目前处于10万水平。因此,建梦岛单日Tokens的消耗量超过10亿。

当你来到终端时,Tokens的消费方式会变得更加多样化。

除了智能助手,AI手机还有各种渗透到系统中的AI功能,比如一键路人清除、通话总结、一键识别屏幕等等。根据OPPO 根据2024年10月的数据,小布助手月活突破1.5亿。

此外,云厂商公布的Tokens调用量和合作客户状况也为此标准提供了参考。。

腾讯混元于2024年7月披露,每天调用量达到1000亿Tokens(包括自己的业务)。

2024年8月,百度披露文心大模型日均调用量超过6亿个,Tokens文本日均处理量超过1万亿个;截至11月初,文心大模型日均调用量超过- 15 十亿美元。这一数据在一年前是5000万次,每年增加30倍。

2024年7月,每个企业客户平均每天使用Tokens的豆包模型增加了22倍。最近12月字节透露,每天使用Tokens的豆包通用模型超过4万亿。

这种消耗,来自谁?

参考火山引擎官网公布的客户名单,汽车、金融、互联网、消费者零售、智能终端、游戏、医疗健康赛道的头部厂商非常突出,也是大家熟悉的品牌。

同时,这群“10亿Tokens俱乐部成员”在2024年的生活方式,也为这条价值红线提供了有力的参考。

AI业务成为拉动增长的关键贡献。

第一,在国外异军突起。作业帮。

2023年9月,作业帮推出银河大模型,结合多年的教育数据和AI算法积累。它专门为教育行业打造,涵盖多学科、多学科、多场景。

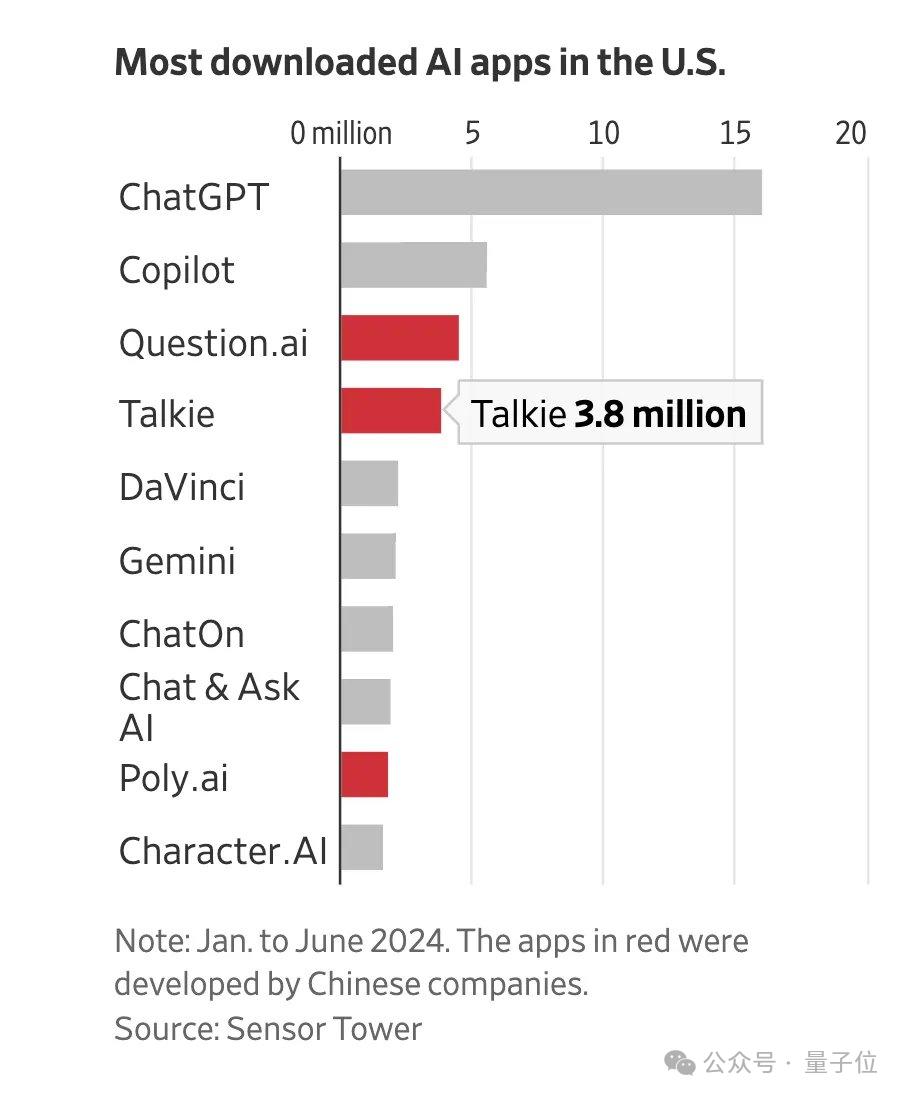

根据Sensor的说法 Tower监控2024年上半年的数据,其出海产品Question.AI杀入美国AI类应用下载量前三名,并获胜百万MAU。另一个对话AI产品Poly.AI也进入了下载前30名。

另外一方面,在更能带来直接收益的情况下AI学习机方面。

2024年7月,沙利文调研认证作业帮在上半年获得中国全网学习机销量第一名。根据洛图科技的数据,2024年第三季度,作业帮助学习机产品以20.6%的市场份额位居线上市场销量第一。

企业经营领域,金山云根据2024年第一季度财务报告,本季度总收入环比稳步增长3.1%,主要来自AI相关客户。

公共云收入为11.87亿元,较上季度增长12.9%,主要由AI客户提供。与2023年同季度相比,这部分增长带动了公共云整体收入的增长率为2.9%,而CDN服务规模正在积极缩小。

这一趋势在第二季度、第三季度持续,AI客户仍然致力于公共云业务和整体收入的主要增长。

再次看看AI手机,离大家的日常生活很近。

模型趋势开启后,OPPO旗帜鲜明拥抱潮流,将生成式AI功能引入ColorOS和整个产品类型,并于2024年发布。OPPO客户接近5000万配备GenAI功能的手机。

根据Counterpoint的数据,2024年全球四大智能手机制造商分别是三星、苹果、小米、OPPO。

但是根据Canalys的数据,2024年,全球16%的智能手机出货量为AI手机。据预测,到2028年,这一比例将激增至54%。AI手机行业预计,从2023年到2028年,年均复合增长率将达到63%。(CAGR)成长。这种变化将首先出现在高端型号中。

比如最新发布的OPPOFind X8系列,人工智能的味道更浓。通过引入普通豆包模型Pro、普通豆包模型LiteLite、豆包・角色扮演模型和更强的大模型即时联网搜索能力,OPPO Find X8系列可以提供更细致的AI服务体验。

这一趋势反映在云计算领域,而Tokens的消耗量更大。

在采访中,火山发动机谭待表示:

五年后,公司每天使用的Tokens可能达到数百万亿,特别是在推出多模式大模式后,Agent助手会跟随每一个场景,带来很大的消耗。

得到这样的数据估计的背后,是对算率基础设施、Agent开发、AI应用开发以及整体大模型落地变化的一个小洞察。

Agent AI Infra,数百万亿的Tokens消耗不是梦

首先,从应用落地的角度来看,Agent的趋势越来越明显,AI原生应用开始发力。

OpenAI 在年终盘点中,CEO奥特曼指出:

在这里,我们相信 2025 2008年,我们可能会看到第一批人工智能代理。 加入劳动力大军,实质性地改变企业产出。

接着,OpenAI以身作则,推出Agent能力,ChatGPT开始具备执行能力,可以为人们完成各种任务。

在落地方面,量子位智库观察到AI原生应用开始发力。

AI智能助手APP随着底层模型能力的不断提升,在过去一年中有了明显的增长。

AI智能助手APP端2024年新增用户数量超过3.5亿。与2024年初相比,12月新增用户超过5000万,增长近200倍。

以豆包为例。九月份豆包变成了首个AI应用程序,国内用户数量超过1亿。后,目前以超50%做实的市场份额“国民AI原生应用”和AI智能助手APP No.1”。

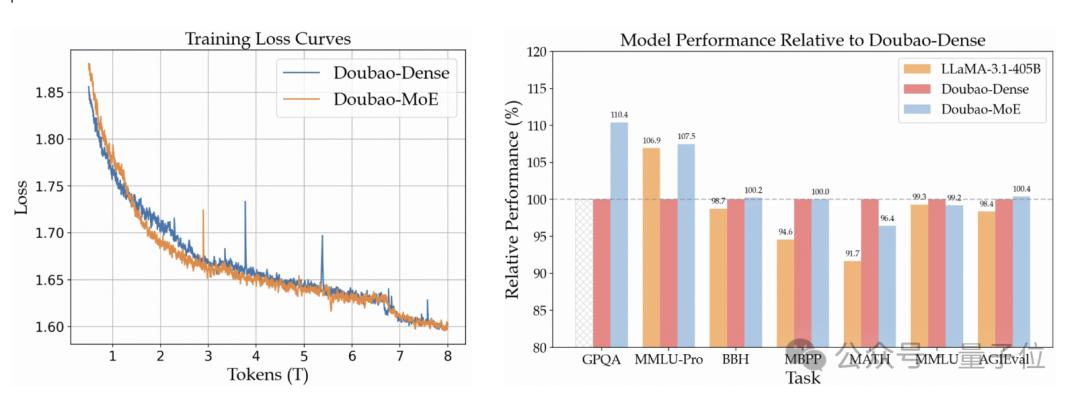

就在今天,大型豆包1.5 Pro最近推出,能力全面提升。通过优化MoE架构,使用1/7的参数超过了密模的性能。

在多模态能力方面,视觉能力支持动态分辨率,可处理百万级分辨率照片,在多个基准测试中表现出色;在语音创新方面,提出了Speech2Speech端到端框架,使语音与文本模式紧密结合,提高语音对话的理解和表现力。

与此同时,模型推理能力也通过RL方法得到了极大的提升,Doubao-1.5-Pro-在AIME上,AS1-Preview已超过o1。-preview、O1等推理模式。

更加强大的底层模型无疑为AI原生应用提供了更加坚实的底座。

专注于公司方面,实际增长发生得更早。Agent开发平台已成为云厂商增长最快的企业服务产品之一。

比如火山引擎推出的HiAgent,已经签约7个月了。 客户。

其定位是公司专属的AI应用创新平台,旨在帮助企业以零代码或低代码的方式完成从模型到应用的“最后十公里”。

HiAgent可以向下兼容各种模型。它还适合第三方的闭源或开源模型,并通过提示工程、知识库、插件和工作流程安排四个要素,帮助轻松构建智能体,预设丰富的模板和插件,并给出自定义的自由空间。

现在HiAgent已经为中国飞鹤、美宜佳、华泰证券等500强企业提供了服务,落地场景2000 ,创建Agent 500 款。

纽扣AI原生应用开发服务平台也帮助苏泊尔、招商银行、和府捞面、中和农信等打造企业级Agent开发上线。

与HiAgent相比,它面向AI应用开发人员不足、对服务稳定性要求较高的企业,降低了大型应用开发门槛。纽扣作为AI应用开发平台,提供一系列工具,如链接插件、工作流、图像流、知识库、数据库等。它还与豆包大模型家族和企业的精调模型和开源模型无缝衔接,为企业客户提供丰富的应用模板和全周期的调测、发布、集成和观察服务。例如使用新闻插件,可以快速打造一位AI主播,在网上播出最新的时事新闻。

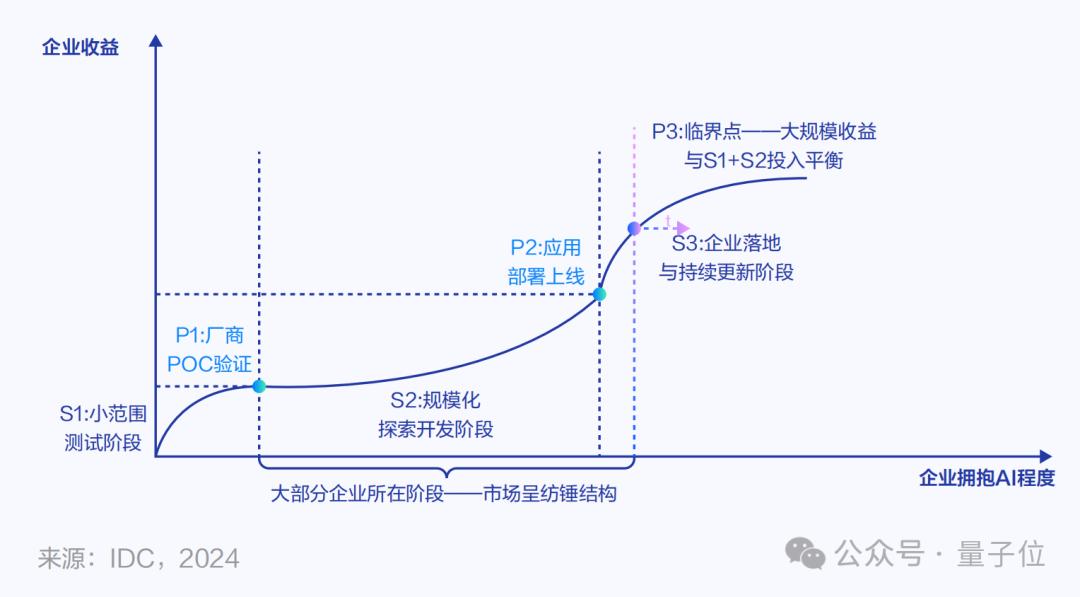

通过这些实际的落地进展,不难看出,当AI应用/Agent的开发门槛大大降低时,各行各业都进入了大规模探索开发阶段,龙头企业的步伐更快。他们更早地使用大模型来改变自己的业务,并首先解锁大模型的收入。

随着行业先锋案例的出现,未来AI应用的落地规模将进一步扩大。同时,像HiAgent这样的平台也会不断进化,其能力将进一步发展成AI能力中台,而不是局限于智能体的开发。

让我们来看看供应。2024年云计算领域的“价格战”更为明显。事实上,这背后的是,计算率成本仍在进一步优化,云制造商可以继续“以价换量”,推动AI应用的落地趋势。

行业承认,未来的计算范式需要以GPU为核心。

到2024年,云厂商不断加强AI 为了满足正在爆发的大规模推理需求,Infra能力。

比如火山发动机推出了AI云原生方案。它支持大规模GPU集群的弹性调度管理,计算产品和网络优化都是专门为AI推理设计的。在过去一年多的大型应用落地战中,火山发动机为美图秀秀、化妆品隐形眼镜技术、深圳科技等提供了坚实的计算基础。

不久前,以GPU为核心的AI在火山引擎Force冬季会议上进一步升级。 通过vRDMA网络支持大规模并行计算和P/D分离推理架构,Infra分布式业务系统可以提高实践和推理效率,降低企业维护成本;EIC弹性极快缓存解决方案,实现GPU直接连接,将大型推理延迟降至50分之一,降低20%。

随着技术门槛/模型价格的不断降低和计算率成本的不断优化,平均每天几百万亿美元的消费几乎触手可及,而不是随便说说。

因此,每个企业每天消耗10亿Tokens成为一条非常有价值的参考线。

第一,它代表着大模型应用落地的新趋势,公司拥抱大模型收益,要朝着这个数字前进;

第二,这已经成为大型应用落地新阶段的门槛,AI业务真的跑通了吗?需求真的存在吗?可以为参考系找到答案。

第三,平均每天花费10亿Tokens也只是大模型落地的“入门级水平”,单个客户花费百万亿、千万亿Tokens是更值得期待的浩瀚星辰。

只是随着这种新的价值标准的形成,谁能成为大模型落地的“独角兽”,可以更加清晰地判断。

本文来自微信微信官方账号 “量子位”(ID:QbitAI),作者:明敏,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com