AI要进步,居然要先学会玩游戏?

我睁开眼睛。上周编辑部还在说下半年感觉。 AI 这个领域没有什么大工作,结果没多久就发现话放早了。

宁猜怎么样,原本以为 AI 仍然停留在输入文本中,然后在这些层面上绘制视频,结果这两天突然有几天? AI 公司,都开始宣布他人能够产生世界。

我勒乖乖,这不是 AI “世界做梦都想搞出来”世界模型"嗯:能够像人类一样理解这个真实的世界。 AI !

首先是前几天 World Labs ,虽然每个人都可能没有听说过,但其他创始人却是著名的。 AI 科学家,斯坦福大学教授,美国科学院教授,机器学习奠基人之一, AI 教母美誉美籍华裔科学家。李飞飞。

World 在官网上,Labs提到,这是世界上第一个可以直接直接使用的。AI渲染了完整的3D场景,超越了传统生成模型的简单像素预测,而且这个场景还具有互动性和自由性。

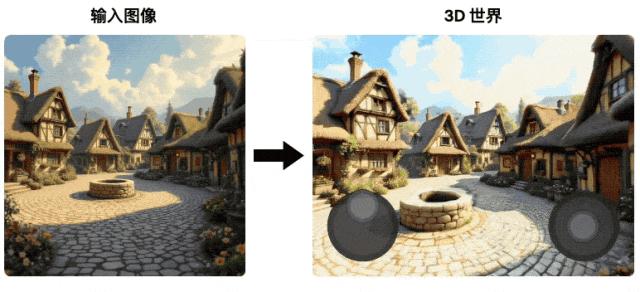

说实话,这个东西和之前的生图视频模型不一样。只要给它一张图片,别人就能给出一套空间建模,还能在里面移动。

虽然现在我们还不能用,但是人家官网还是发布了一些案例给大家看。

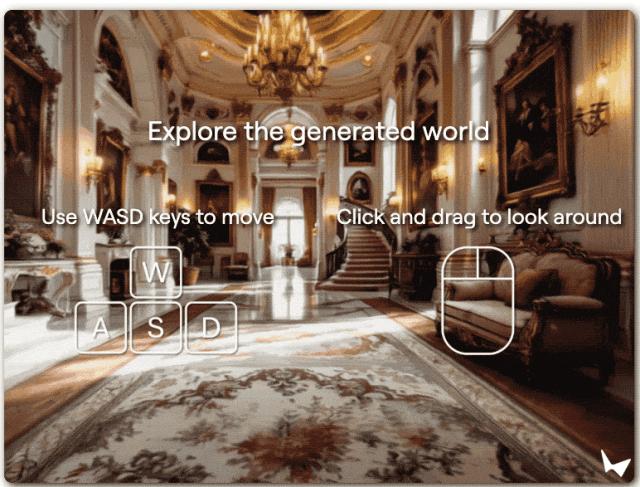

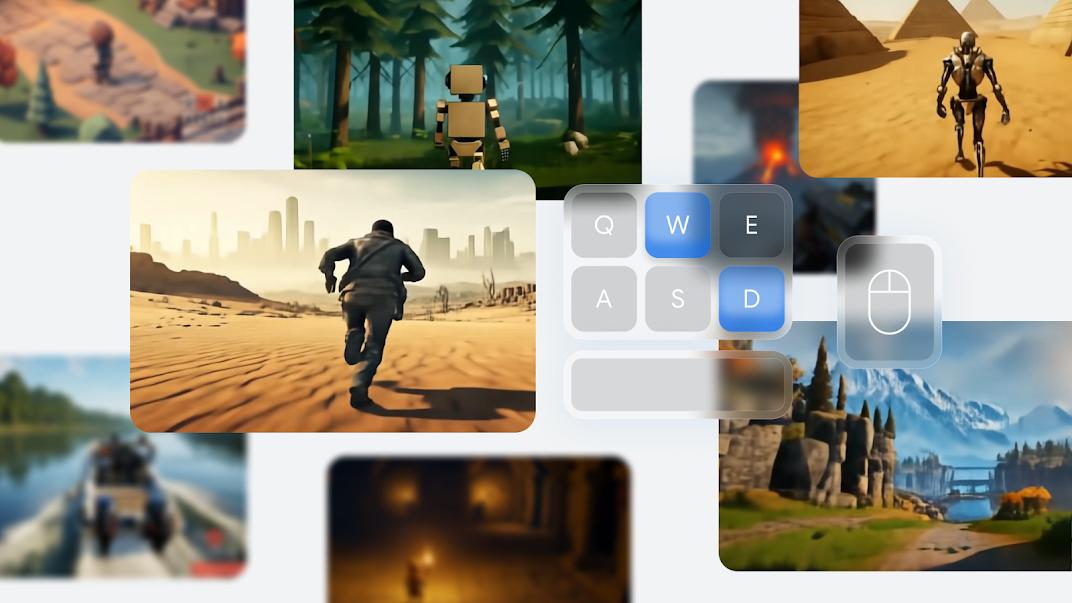

每个人一眼就能发现,这个演示图中怎么会有一个键盘和鼠标。

事实上,是别人为了展示这个产生的场景是有自由度的,您可以自行使用键鼠操作,并在网页上进行尝试。

但是世超并不推荐大家去尝试,因为真的超卡,活动空间也不大,还容易晕倒。

但是作为行业内的首发,我们也能理解万岁一波。

但是好巧不巧,李飞飞这个东西发布才过了一天,还有高手。

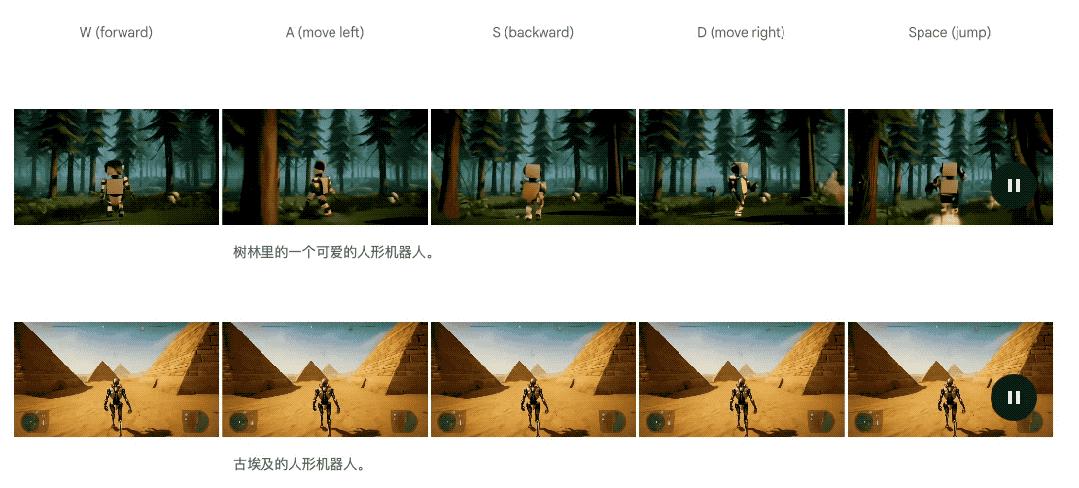

谷歌 DeepMind 还有一个“世界模型”,也是第二代,声称能够理解现实世界的运行规律。世超也去官网看了一圈,看看这个。 Genie 2 ,真正的法律到底是什么?

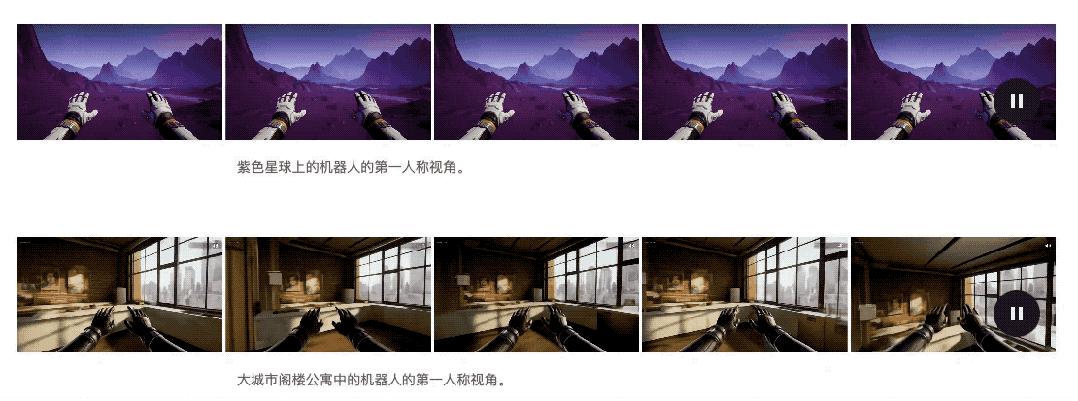

首先看看别人的演示,输入一个提示词后产生的效果。

该说不说,这看着的确挺逼真的,有两次子。

但是如果跟上面的话 World Labs 的 AI 对比一下,估计大家一眼就能发现,这似乎是更流畅,自由度更高。

其实官网也说过,这是一个类似游戏的基本世界模型。在这种情况下,你也可以使用WASD、空格和鼠标来控制屏幕中的角色。

也可以生成第一人称视角版!

但是根据操作所产生的场景,都是由 AI 即时计算,甚至可以持续近一分钟。

而且已经生成的场景和建模,如果你操纵键盘往回走,就会发现以前是什么样子,现在还是什么样子。

那是非常离谱的,相当于生成了这个新世界,每一秒都是什么样子? AI 全部都可以记住。

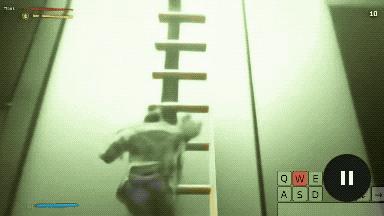

此外,这里面的角色和互动也很有意思。

光是锻炼,就不止常规的步行,你能跑能跳,还能爬梯子。

即使能开车,也能开枪射击。

而且里边的AI生npc也是可以互动的。

尽管这种互动效果有点不尽如人意,但是仍然可以看到动了。

但是在整个场景中,还可以制作出与自然相关的运动场景。.

例如水面:

还有烟雾:

还包括重力和光反射效果:

即使你给出了真实的照片,它也可以模拟周围的环境,看着谷歌地图上的街景。

虽然视觉效果确实很棒,但是,和李飞飞一样, DeepMind 新的模型也没有给出让大家去尝试,只是在官网上发布了他们的检测版本。

但是按照世超通常测试这些测试。 AI 嗯,无论是大厂还是新力量,官方演示那一定是精心挑选的一个漂亮的例子,如果真的要用的话,估计还得降低一级期望值。

但这次更有趣的是, DeepMind 说实话,他们这个还是初始版本,自己测试的时候也是一个初始版本。还会出现一些翻车案例。

比如下面这个,本来是让画面里的小哥哥滑雪,结果, AI 把他变成了跑酷。

还有一个花园场景,玩家还没有操作,什么也没有动,结果花园里突然飞过一个幽灵。

尽管仍然存在缺陷,但从他们给出的这些演示来看,世超感到这一点。确实是在 AI 了解世界这一方面,取得了较为成功的进步。

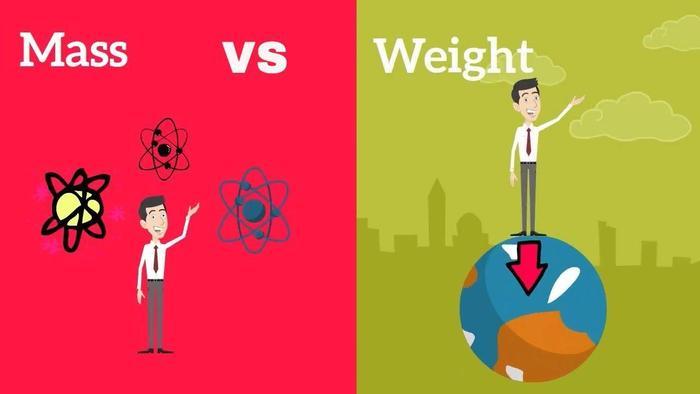

这个时候可能会有聪明的差友问,这种跟随主体运动的场景,以前的场景, Sora 类似的视频模型不也可以做到嘛,为什么这个更接近世界模型?

实际上还是跟着训练走 AI 方向有关。

Sora 虽然刚出来的时候被称为世界模型,但实际上这些视频模型穿模的情况还是很多的,幻觉也不太好处理。

本质上他们所学的资料都是视频,靠前面的视频场景来推后面,并不能真正理解视频中的物品是如何互动的,如何有效。

就比如,让 AI 通过观看视频学习对象的重量是相当困难的。

而要让 AI 要意识到现实世界中的这些参数,首先要知道环境是一回事,环境中的人和事是另一回事。所以大家都是从文生图模型一步步走向地理环境,然后在环境中呈现人的动作。

李飞飞就是这样 World Labs 模型的效果,相当于先让 AI 学习建模,然后展示看到的场景。

但相比上边 World Labs , DeepMind 更糟糕的是,这实际上与他们的技术路线不同有关。如果前者打算用照片还原更真实的场景,后者用照片。 AI 为您创造一个游戏世界。

当然,他们之所以能搞出来,在训练过程中,主要家庭是根据游戏资料来学习的。.

与视频模板相比,游戏的优势在于 ai 它不仅可以学习角色和图片的动态变化,还可以观察角色动作的键盘操作是如何影响图片和动作的变化的,从而更全面地理解物体和环境之间的互动。

实际上,早在今年三月, Genie 一个版本的团队已经出来了,但是他们当时做的还是 2d 画面的横屏 AI 游戏。

结果到了 2.0版本,别人给 3d 整理出来,实际效果看起来也很接近我们平时玩的这些东西。 3d 这款游戏,甚至比某些游戏的画面质量要好一些。

但是呢,我也不是说 DeepMind 就发现了 AGI 通用解,演示中表现的还行也不等于 AI 真正理解现实。

最为明显的原因是, AI 依靠游戏来学习,而游戏是人类根据现实来做的。依靠人类的二手资料学得再好,也绝不等于对现实世界的理解。

对于 AGI 什么时候真的来了,我们还是要说一句,等一下。

本文来自微信微信官方账号“差评X.PIN作者:纳西,编辑:江江&面线,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com