OpenAI语音转录工具翻车,盲信AI不可取。

OpenAI作为一个在AI领域深耕多年的独角兽,在2022年秋季首次进入公众视野发布了ChatGPT,但这并不意味着OpenAI在ChatGPT之前没有取得任何成就。事实上,在推出ChatGPT之前,OpenAI已经制作了AI程序OpenAI,这是一个打DOTA2的AI程序。 Five,以及Whisper开源AI语音转文字工具。

假设OpenAI Five是一个小测试,所以Whisper当然是当时OpenAI方面希望以技术著称的作品。因此,在Whisper发布四年后的今天,OpenAI仍然在DevDa活动日推出Whisper large-语音转录模型v3-turbo。不幸的是,Whisper这次翻车了。根据相关报道,Whisper编造内容的问题在采访工程师、开发人员和学术研究人员后被曝光。

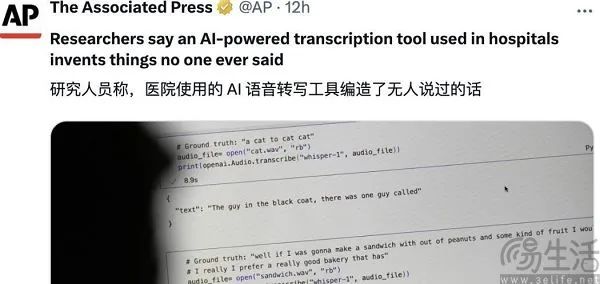

据报道,Whisper很容易编写大段文本,甚至整句话。这些幻觉包括种族评论、暴力言论,甚至医生和病人之间的对话。一些开发者透露,他用Whisper创建的26000个转录样本中的几乎每一个都有幻觉。甚至有开发者在分析了100多个小时的Whisper转录样本后发现,大约一半的内容都有幻觉。

AI会因为幻觉而产生幻觉(AI Hallucinations)而且胡说八道,其实早已被公认为现实,无论国内文心一言,Kimi、ChatGPT还是海外混合元。、Gemini,目前还不能拍胸脯,保证AI不会回答无关紧要的问题和编辑。AI模型之所以会有幻觉,就像人类会做梦一样,在这个阶段还是不可避免的。

虽然AI会有正常的幻觉,但是Whisper这么频繁的幻觉有点不正常,“生病”的概率太高是相关报道受到广泛关注的基础。而且不仅随意转录会出现问题,即使录制了好的短音频,转录幻觉的问题还是很常见的。一些研究人员在他们检查的13000多个清晰的音频片段中有187个幻觉。

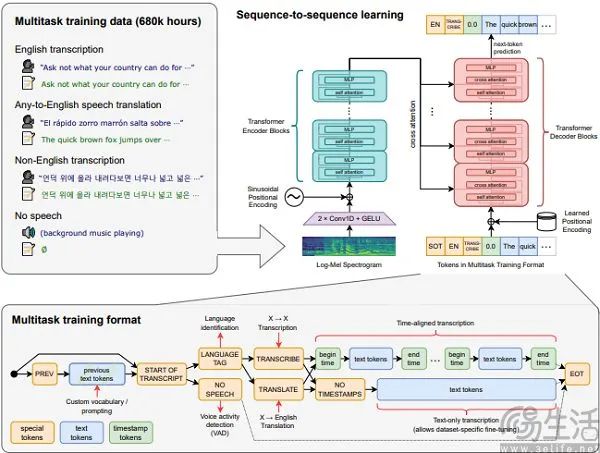

AI幻想的原因其实很简单,因为大模型是基于概率的黑盒产品,它的预训练机制是从训练数据中泛化出来的,从而获得类似人类的推理能力。但是,当模型过度调整训练数据时,会出现过度拟合,高效记住集合的特定输入输出,从而影响其有效处理样本以外数据的能力。

为了解决AI幻觉,在不影响当前大模型训练机制的情况下,只有一种解决方案,将世界上所有的知识都填满到一个数据库中。不幸的是,没有一家制造商有勇气声称拥有一个完全覆盖所有知识的“图书馆”。然而,不可避免的幻觉导致的结果是,AI表面上会导出合理的、合乎逻辑的内容,但实际上却存在事实错误或根本不存在的内容。

人工智能的幻觉是它看起来像人类的关键。毕竟人不是圣贤,AI也是如此。问题是各行各业的AI厂商和媒体为了创造AI热潮,放大了AI的能力,夸大了AI的上限。以至于在宣传口径上,基于大模型的AI已经是《终结者》中无所不能的“天网”,从而放大了AI幻觉的负面性。

目前不可忽视的情况是,勇于尝试ChatGPT等AI产品的人会成为AI幻觉的受害者,而不是对AI保持警惕的人。因为当AI以令人信服和可信的方式呈现错误时,习惯使用AI的人会忽略事实测试的情况,收到错误的信息。老祖宗的话也并非没有道理,“善游者溺,善骑者堕,各以所好反自为祸”。

事实上,目前AI普及最大的难题,就是宣传调门过高与实际应用的局限性产生矛盾。Whisper作为一种语音转录产品,为了提高医生的工作效率,已经被许多海外医疗机构使用。此外,在后续的诊断和治疗过程中,医务人员很可能会基于Whisper转录的内容。此时Whisper出现了凭空编造医患对话的情况,又怎能不让海外网友感到恐惧呢?

尽管AI大模型、AIGC确实是个好东西,但在相关厂商的宣传中,幻觉带来的一系列问题却被有意无意地忽略了。在客户简单的认知中,AI可以掌握更强的大数据和计算率,所以它的结果一定更值得借鉴,这也是AI购物助手目前市场上诞生的土壤。但是一旦AI购物助手产生幻觉,顾客就会失去金钱,Whisper产生幻觉,病人可能会被错诊。

在权力和责任的边缘徘徊的AI,不仅带来了很大的效率提升,还隐藏了不可忽视的风险。对于这样一把双刃剑,如果只听“卖剑”的AI厂商的话,如何用好显然是不够的。

本文来自微信微信官方账号“三易生活”(ID:IT-作者:三易菌,36氪经授权发布,3eLife)。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com