Obsidian中最强的笔记软件也可以使用LLM,让它成为你智慧的第二大脑。

知识管理软件,也是大模型。

如果工人想做好他们的工作,他们想做好他们的工作。使用好的工具可以大大提高我们的生产和学习效果和质量。今天,我将介绍一套基于此的工具。 Obsdian 的 AI 工具组合,包括部署地方部署 LLM 的 Ollama 和两个 Obsdian 插件(BMO Chatbot 和 Ollama)。

这个工具不仅可以帮助我们分析笔记,做总结,思考标题,敲击代码,还可以帮助我们打开大脑,给我们继续写作的内容和建议。

Obsidian 简介

Obsidian 它是目前最受欢迎的笔记工具之一,但它的能力远不止于此。你不仅可以把它当成笔记本,还可以把它当成你的个人知识库和你的文档生产工具!很多人甚至称之为自己的「第二大脑」。

其优点包括:支持 Markdown、插件生态丰富,支持自定义主题元素,支持主题元素, Wiki 文档链接,内置关系图谱,基本功能完全免费,完全支持本地存储…

这些优点有很多帮助 Obsidian 大量的用户在全球范围内获得。你可以在网上看到很多人用这个工具分享学习知识、写论文、写小说、规划时间表甚至管理生活中的一切的经验,以至于这个工具已经形成了一个相当大的利基市场。 —— 模板、课程和预设的数据库(vault)一切都可以成为商品。它还从另一个角度证明了这一点 Obsidian 非凡的能力。

Obsidian 哔哩哔哩和 YouTube 这是一个很受欢迎的话题。

总而言之,如果你正在寻找一种有用的学习和生产设备,或想为自己建立一个第二个大脑,Obsidian 绝对值得一试!

为什么要在 Obsidian 中应用 LLM?

毫无疑问,我们现在正处于一个大模型时代。它们不仅可以帮助我们提高效率和生产力,还可以帮助我们创新和探索更多的可能性。

同时,人们也发展起来了 LLM 很多神奇的用途,在这里我们简单地展示一些你可以在这里 Obsidian 得到的用法,帮助你看到微知,去探索和发现更多有趣或有用的用法。

第一个例子是作者在前一段忘记了。「见微知着」在这个成语中,我不需要额外使用搜索引擎或打电话求助。我只需要咨询一下旁边待命的聊天机器人,很快就会得到我想要的结果。

这里用到了 BMO Chatbot 这款插件,它可以以聊天机器人的形式使用 LLM 整合进你的 Obsidian。这个插件也可以让你根据当前的文件进行聊天。下面详细介绍一下, LLM 这篇英语报道是用中文总结出来的,并提出了一些标题:

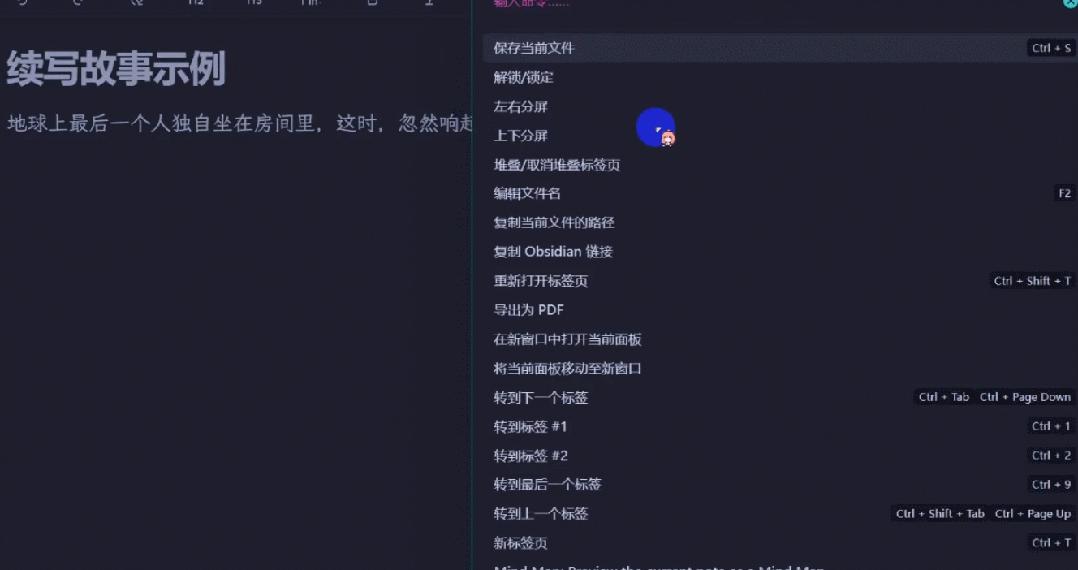

当然,帮你继续写故事自然也不在话下。接下来让我们 LLM 帮助继写弗雷德里克・世界上最短的布朗小说:

「最后一个人独自坐在地球上的房间里,这时,敲门声突然响起…」

另一个插件在这里使用 Ollama 以及预设指令,其提词如下:「继续写这篇文章的故事。要求继续写。 200 文字,人物风格保持一致,同时给后文留下悬念。」

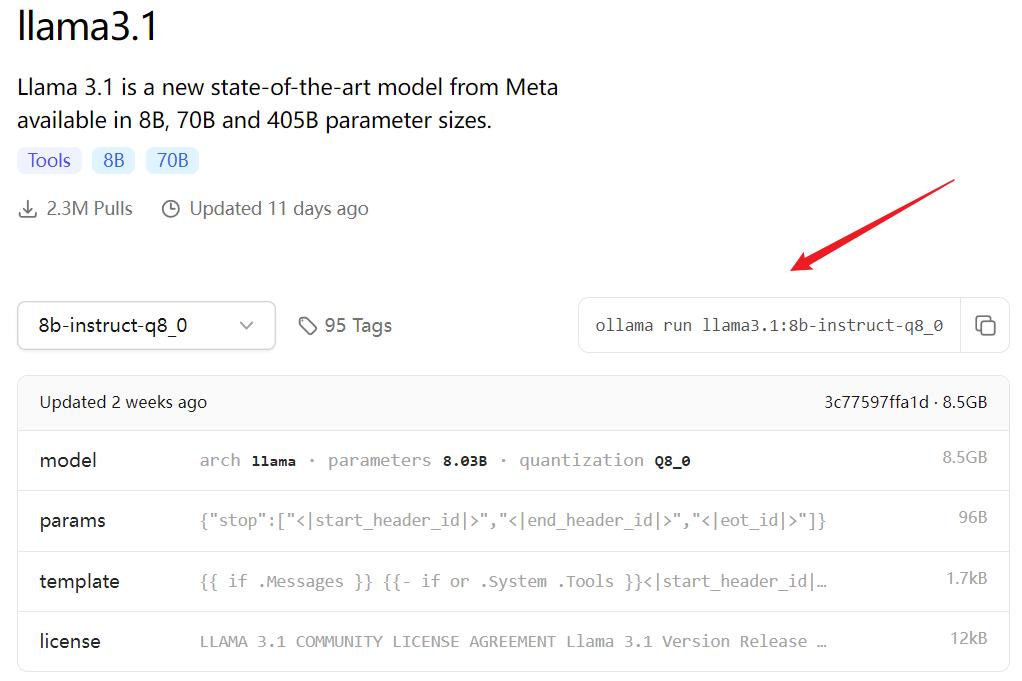

另外,很明显这个插件的启动速度比较慢。这是因为这里使用了本地安装。 LLM—— 一个 8B 版本的 llama3.1 该模型的启动速度受到当前硬件的限制。

好了,例子就到这里。让我们来看看如何安装和使用这些插件。 LLM 吧。

安装当地 LLM

对于我们大多数人来说,当地的计算机是可以运行的。 LLM 性能自然无法与之相匹配 OpenAI 与其他大型企业提供的在线服务相比, LLM 最大的优点是数据的隐私和安全性 —— 使用当地 LLM,您的所有计算都是在自己的计算机上完成的,不必担心您的数据被传输给服务提供商。

当然,如果你不在乎自己的笔记隐私,那么使用在线服务也可以很好地完成你的任务,这一步完全可以忽略。

为了方便当地使用 LLM,我们需要一个名字 Ollama 的工具。Ollama 这是一个很好的地方部署。 LLM 适合任何人使用的工具,可以下载安装,地址:https://github.com/ollama/ollama/releases

以后,进入 Ollama 支持模型库:https://ollama.com/library ,根据自己的需要和计算机硬件选择模型,以后可以运行相应的代码。例如,如果你想安装一个 8B 指令微调和了参数 Q8_0 量化的 Llama 3.1 模型,运行:ollama run llama3.1:8b-instruct-q8_0

当然,您还可以根据不同的任务(如编程)安装多个不同规模或微调模型,以便在不同需求的情况下衡量速度和生成效果的选择。

安装及配备 BMO ChatBot 和 Ollama 插件

两个插件都已经上线了 Obsidian 社区插件市场,搜索,下载,启用即可。

配备 BMO Chatbot 插件

你可以进入选项 General 在设置中选择您已安装的本地模型或配备的在线模型。如图所示,我在这里安装了一个地方。 Llama 3.1 和一个 Llama 三是同时配备 OpenRouter 的 API(可以访问大量模型)和智谱在线语言模型 GLM-4-Flash。以下是最大的设置 token 数、温度(0-1 在这些文本中,值越大,文本就越有创意),以及是否检索当前的笔记。

Prompts 系统提词可以通过笔记设置。

但是在更下面 API Connections 区域内,您可以配置在线模型。

装备完成后,便可通过。 Obsidian 使用右栏或使用 Ctrl P/Cmd P 使用这些快捷键 LLM 了。

除了使用 BMO 聊天机器人,这个插件也支持使用 LLM 重新命名当前文档并使用选定文本作为提词生成内容。

配备 Ollama 插件

Ollama 插件只支持通过前面 Ollama 本地模型安装,但其优点是可以预先配备常用提词指令,然后通过 Ctrl P/Cmd P 可以方便调用。

以下是代码生成的例子:

结语

Obsidian 结合 LLM 工具可以给我们的学习和生产带来极大的方便。Obsidian 作为一种强大的笔记工具,它不仅支持丰富的插件生态,而且可以通过当地部署 LLM 提高我们的效率和创新能力。

安装和使用 BMO Chatbot 和 Ollama 插件,让我们能很快快速地把它 LLM 融入 Obsidian,从而实现笔记分析、总结、标题生成、内容继写等多种功能。它不但可以节省我们的时间和精力,而且可以激发我们的创造力。

当然,在使用这些工具的同时,我们也应该注意数据的隐私和安全。当地部署 LLM 可以确保我们的数据不离开个人设备,从而降低数据泄露的风险。

总之,Obsidian LLM 在信息爆炸的时代,我们可以更好地利用科技力量,提升自己,为我们打开一扇新的大门。

本文来自微信微信官方账号“机器之心”(ID:编辑:almosthuman2014):Panda,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com