解决AI“胡说八道”,该公司要为大型模型投喂好原材料。|商品观察

作者|黄楠

编辑|袁斯来

今天大模型展示的强大能力来自于背后的海量数据,为它注入了丰富的人类知识。如果把大模型当成飞驰的科技列车,数据语料就是宝贵的“燃料”。其中,语料质量的提高对于模型性能的阶段性突破尤为重要。

但是,一个现实是,高质量的语料材料正在迅速消耗。国内大型模型制造商面临的语料短缺问题非常严重。

以中国语言材料为例。中国工程院教授高文指出,目前全球50亿大模型数据训练集中,中国语言材料占比仅为1.3%,与英语等其他语言相比,质量和数量明显不足。由于其复杂的布局结构,报告、论文、报纸等文档中的大量高价值语言材料数据限制了大模型训练语言材料的处理量,不能轻易分析和提取。

处理中文数据不足和质量问题,处理多样化数据,仍然是各个厂商面临的一大挑战。

为帮助企业应对数据限制问题,近日,WAIC中的合合信息 “加速器”产品-TextIn智能文档处理平台在2024上发布,用于大型语料训练。

在练习初期,利用“加速器”文档分析引擎,破解书籍、论文、研究报告等文档中的布局分析障碍,运输纯“燃料”进行模型训练和应用。;与此同时,“加速器”配备了文本向量化模型,以缓解大模型“已读乱回”的幻觉问题。

合并信息的思路是从“炼药”源头的燃料出发,通过标准化平台结构化语料,提高数据预训练效率,帮助大型厂商提高和迭代有效的模型性能。

处理复杂语料

TextIn智能文档处理平台,合合信息此次发布的大模型“加速器”,由TextIn文档分析,TextIn Embedding(文本向量数据模型)和OpenKIE三大工具组成。

当前,无线表、跨页表、公式等复杂元素的处理,仍然是大型语料清晰的“绊脚石”。

以银行常见的基金对账单托管业务为例。市场上有很多基金企业,每个企业的账单风格都不一样。此外,复杂的表格呈现形式需要从非结构化的图形信息中提取数据,并将其整理成模型训练所需的方式,这通常消耗大量的人力和时间。

一个单元格的理解可能会导致表格的整体识别结果出现很大的偏差。同时,表格的恢复准确性也直接影响模型问答的效果。

在文本、表格、图像等非结构化数据的表现上,TextIn文档分析最早可以在1.5秒内完成100页长文档的分析;它不仅速度快,而且具有理解能力,能够智能地恢复文档的阅读顺序。

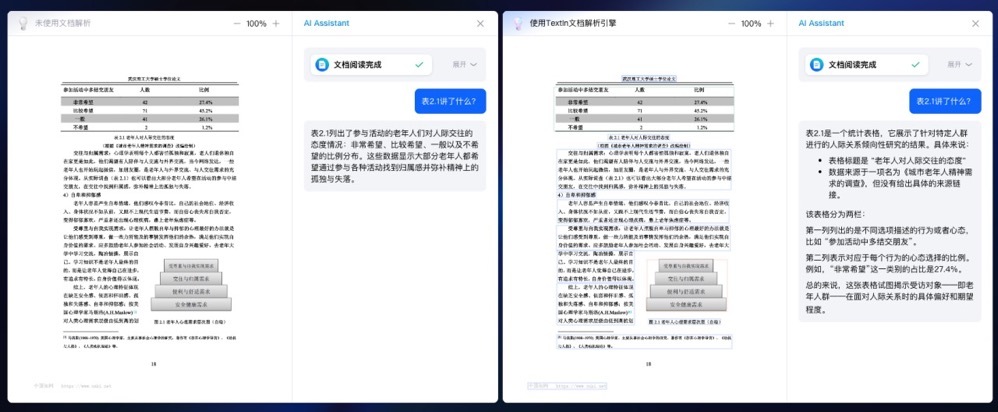

大模型使用文档分析引擎前(左)和后(右)的效果进行比较。结果表明,使用后,大模型具有分析文档元素和识别表格内容的更快、更优秀的能力。

在TextIn文档分析的算法阶段,面对多种类型的样本问题,合合信息非常重视图表数据的训练。目前,TextIn文档分析工具可以将十多种常见的图表,如柱形图、折线图、饼图、雷达图等,以及随机格式文件 将Json(轻量级数据交换格式)或Markdown(轻量级标注语言)格式拆解为“恢复”。

拆解后的数据语料清晰易懂,可以让大模型更好的了解图表数据,从而学习商业研究报告、学术论文等相关文档中的论证逻辑。同时,TextIn文档分析只能根据坐标轴区间估算具体值,而不会显示具体值。

基于坐标轴区间的文档分析引擎对不显示具体数据的图表进行数值估算。

另一方面,大模型在一般问答中可能表现不错,但就目前而言,面对行业问题,大模型仍然存在局限性,容易产生“一本正经地胡说八道”的错觉。如果不注意,可能会带来严重的影响。

TextIn采用合合信息进行测试。 在Embedding模型(文本向量数据模型)之后,可以提高大模型信息检索和问答的质量、效率和准确性。

TextIn Embedding模型是acge_text_embedding模型(以下简称acge模型)。就像“指南针”一样,acge模型可以通过加强大量中文语料的学习,快速查找全文,找到目标信息定位,提取有效的文本特征,准确完成分类和聚类任务。

acge模型与其它开源模型相比,体积小,占用资源少,1024输入文本长度可以满足大多数场景的需要。

虽然大型模型支持的token数量在增加,这使得它具备了“短暂记忆”的能力,但仍然存在毁灭性遗忘的问题。针对这个问题,acge模型引入了持续的学习和训练方法。

相比之下,acge模型支持可变导出层次,使企业能够根据具体情况合理分配资源,从而提高模型系统的性能和体验。

以大型厂商的实际引用情况为例。如果厂商在没有引入向量数据库的情况下使用分布式架构的开源方案,缺点是随着语料材料的增加到一定规模,分布式存储很快就会遇到瓶颈;同时,按照传统的单线程序,每天数亿的数据处理速度有限。引入acge模型后,可以显著提高其文档的整体处理速度。同时,在数据齐全的情况下,还可以消除一些幻觉、多文档元素识别、布局分析等问题。

OpenKIE是一种可以用于图像文档的信息提取工具,它包括三种模式:字段提取、目录提取和元素提取。

OpenKIE可以自动提取文档中所需的信息,并直接应用或导入到其他系统中,客户只需要建立文档类型,设置需要提取的字段并上传文件即可。

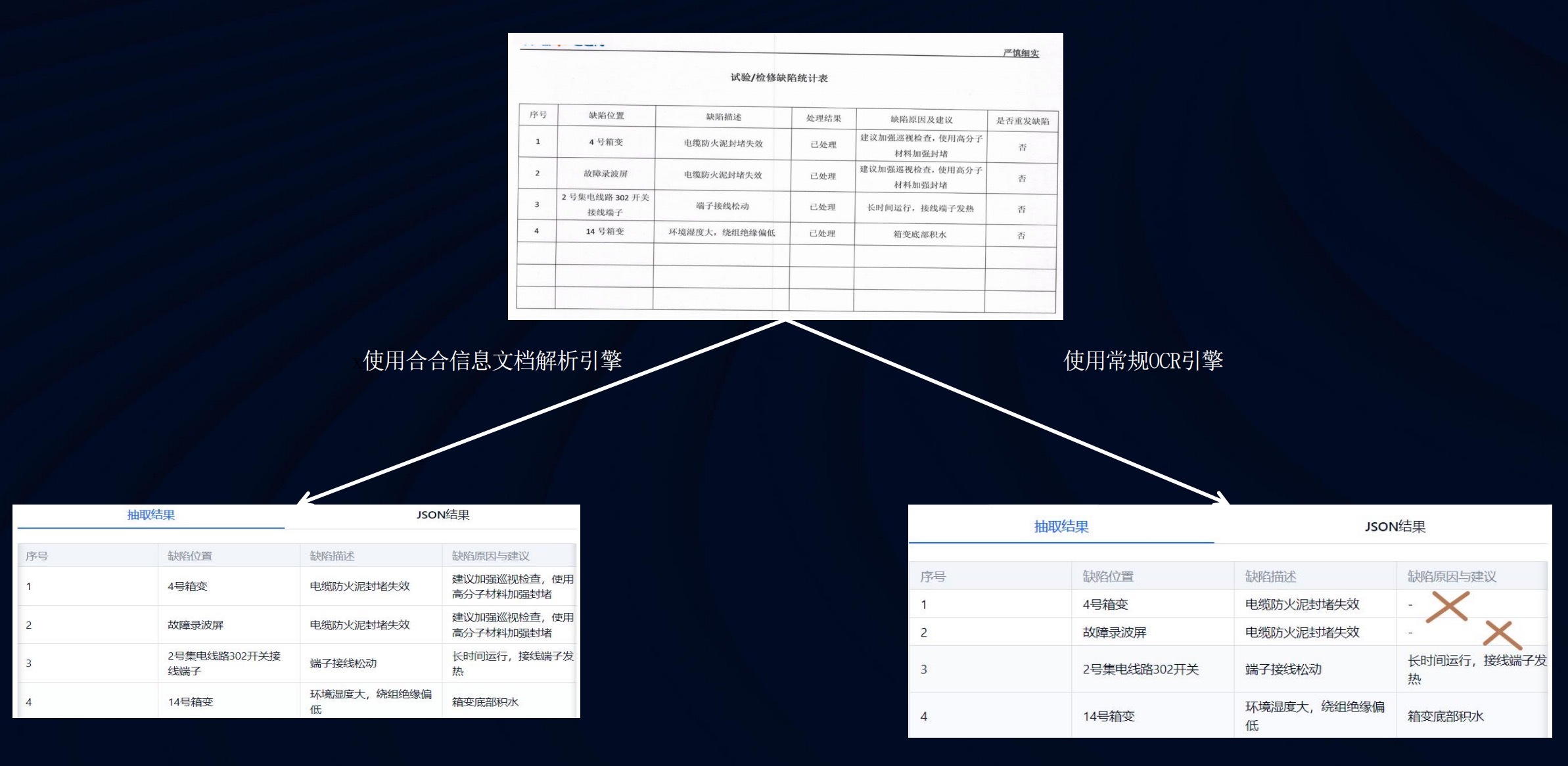

适用于合合信息文档分析引擎和常规OCR引擎。

比如在模型文档处理场景中,合作信息与百川智能合作,共同解决长期困扰大模型行业的多文档元素识别和布局分析问题,将使百页文档的整体处理速度提高10倍以上。

合和信息智能创新事业部总经理唐琪告诉硬氪,目前,TextIn智能文档处理平台可以覆盖金融、医学、金融、媒体等47个场景,共有3200多种文档;它已经被用于百川智能等多家大型头型制造商的预训练过程,同时也积累了小批量的开发者客户。

泛情景,通用工程化能力

就目前而言,几乎每一个大模型的技能提升,其预训练数据的总数、语料质量、领域类型等多个维度都起着关键作用。

在数据处理方面,国内大部分厂商选择的方案主要有两种:一种是提供基础设施服务的第三方公司,比如TextIn智能文档处理平台,配合信息,Amazon Textract文本提取服务;另一类是以银行、券商等垂直跑道公司为代表,在以往OCR算法的基础上,对内部模型进行叠加训练。

唐琪告诉硬氪,“根据调查,公司选择供应商的标准只有三个维度——快、稳、准。”

快速,也就是说,文档分析引擎的速度要快;按合合信息计算, TextIn智能文档处理平台保持在1.5秒内的分析时间,而目前市场上一些同类型工具的速度是3-5倍。稳定性是指PDF文档、表格等大量复杂的格式语料材料是否能够适应并进行高精度的分析。准确性,即文档信息是否能准确还原为表格。

目前,高质量、经过整理的语料短缺是个大问题,“尤其是中文数据更是稀缺,”唐琪提到。

国内外的大模型数据集主要是英语,它们都来自许多开源数据集,例如Common。 Crawl、RedPajama、BooksCorpus、The Pile、ROOT等。虽然这部分数据数量众多,但质量参差不齐。一个高质量的中文材料数据沉睡在报告、论文、报纸等文档中。

预训练阶段语料处理从获取海量数据到高价值数据至关重要。这意味着,作为一个基于平台的产品,向大型厂商和开发商“递铁铲”的基本工具能力是否足够扎实,关系到种子用户的购买意向。

唐琪经历了这样一件事。一位从事二手奢侈品贸易的商家手中积累了大量发票。为了计算利润,他每次都需要手动降低原价,然后将最终结果输入后台。整个过程涉及的公式转换非常复杂,包括金额差价和各种类型的库存。传统的OCR模型无法应用。找到唐琪后,对方在加速器平台上调整了小参数,需求很快就解决了。

这只是细分场景中极其精细的一个小问题。在模型时代,平台工具的实质性形态不同于单层的私有化部署逻辑,更强调面向广泛场景和通用工程的能力。

基于这个想法,合和信息在产品设计阶段提前做了一些事情。首先,场景是外置的,Know在没有个性化阶段的情况下提前为模型补充了大量高质量的垂直领域-how,比如金融、法律、教育等。,关注特定行业的普遍问题,根据用户需求在产品设计中提供解决方案,从而提高大型加速器在核心应用场景中的表现能力。

第二,注重实用性,不仅为用户提供通用场景的API,还为传统行业、中小创业公司或技术资源薄弱的个人开发者提供更多的工具产品,降低应用门槛,实现开箱即用。

在大模型变革的浪潮中,以数据为核心,成为业内人士从事大模型研发和应用的共识。具体来说,在实践中,在文本分析、逻辑布局、文档问答等方面,大模型的上游阶段仍然有很多改进工作要做。

未来,合并信息将重点关注金融、医疗等领域的垂直产品,同时为开发者推进内部测试计划,吸引更多用户参与产品创新和优化。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com