AI芯片是历史上最快的「Sohu」,速度是B200的10倍,哈佛辍学生建造。

生成式 AI 推理的性价比是 GPU 的 140 倍。

大型时代,全球都缺乏计算率,买铁铲的英伟达市值被炒上天。

现在,终于有一家公司带着自己。 AI 芯片叫嚣着。

今早,科技界迎来了一个重要新闻。美国芯片创业公司 Etched 推出自己的第一块 AI 芯片 Sohu,与英伟达达相比,它运行大模型的速度 H100 要快 20 倍,比今年 3 月份推出的顶配芯片 B200 还要迅速超越 10 倍。

一台 Sohu 服务器运行 Llama 70B 每一秒都可以导出超过 50 万只 token,比 H100 服务器(23,000 个 token / 秒)多 20 倍,比 B200 服务器(约 45,000 个 token / 秒)多 10 倍。

Sohu 这是世界上第一款专用的 Transformer 制作计算芯片需要两年时间。

作为一块 ASIC(专用集成电路),Sohu 把对于 transformer 芯片中架构的提升硬化,不能运行大部分。「传统」的 AI 模型:若为 Instagram 支持广告 DLRM、AlphaFold 2 等待蛋白质折叠模型 Stable Diffusion 2 等待较旧的图像生成模型。而且我们也不能运转 CNN、RNN 或 LSTM。

但是另一方面,对 transformer 而言,Sohu 就是迄今为止最快的芯片,与其它产品的数量水平不同。今天的每一款主流产品 AI 产品如 ChatGPT、Claude、Gemini 和 Sora 均是由 transformer 驱动的。

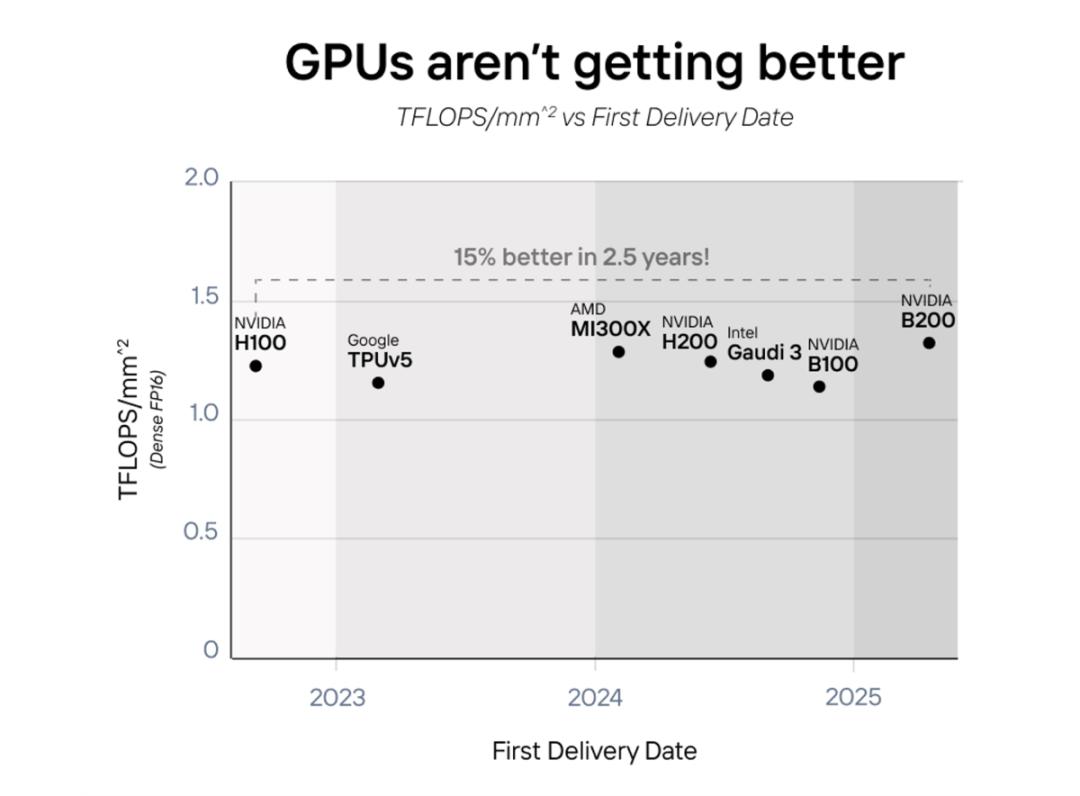

最近由于摩尔定律放缓,GPU 在很大程度上,性能的提高取决于芯片面积和功耗的增加。无论是英伟达 B200、AMD MI300X 还是 Intel Gaudi 三、都不约而同地使用。「二合一」提高性能的方法,功耗也翻了一番。

从 2022 年至 2025 年,AI 芯片的性能并没有真正变得更好,而是变得更大。

但是,如果大模型被广泛使用 Transformer 结构化,追求系统化或许是提高性能的好方向。

这是一个新兴领域,AI 过去模型的结构发生了很大的变化。但是自己 GPT-2 到目前为止,几乎所有最先进的模型都在使用。 Transformer,从 OpenAI 的 GPT 这个系列,谷歌 PaLM、Facebook 的 LLaMa,再到特斯拉 FSD 自动化驾驶所需的模型。

Etched 为我们算了一笔账:芯片项目的成本是 5000 万至 1 1亿美元,投入生产需要几年时间。另一方面,当模型训练费用超过 10 十亿美元,推理费用超过 100 在1亿美元的时候,使用专用芯片是不可避免的。1%的行业规模 改进可以撬动硬件架构的更新。

速率超 H100 20 倍,FLOPS 利用率超 90%

这是世界上第一款 transformer ASIC(应用专用集成电路)芯片,一台集成电路 8 块 Sohu 服务器可以与之匹敌 160 块 H100 GPU。也即,Sohu 启动速度是 H100 的 20 几倍。

具体而言,通过专业化,Sohu 具有前所未有的性能。一个集成 8 块 Sohu 每秒都能处理芯片服务器。 50 万的 Llama 7B tokens。

针对 Llama 3 70B 的 FP8 精确度基准测试显示:无稀疏性,8 2048年,双模并行, 输入或 128 导出长度。

此外,对于 Llama、Stable Diffusion 3,Sohu 仅支持 transformer 推理。Sohu 支持现在的谷歌,Meta、微软、OpenAI、Anthropic 等待各个家庭的模型,将来还会适应模型调整。

因为 Sohu 只有一个算法可以运行,因此可以删除大多数控制流逻辑,然后允许拥有更多的数学块。因此,Sohu 完成了 90% 以上的 FLOPS 利用率,而采用 TRT-LLM 的 GPU 约为 30%。

Sohu 为什么可以导出更多? FLOPS?

英伟达 H200 支持 989 TFLOPS 的 FP16/BF16 计算能力,无稀疏性。它是目前最先进的芯片, 2025 年推出的 GB200 这将提高计算能力 25%,支持 1250 TFLOPS。

因为 GPU 绝大多数地区都是可编程的,所以致力于 transformer 它可以容纳更多的计算。它可以从第一原理中证实:

构建单个 FP16/BF16/FP8 需要乘加电路 10000 一个晶体管,这是所有矩阵数学的基石。H100 SXM 拥有 528 每一个核心都有张量核心, 4× 8 × 16 FMA 电路。乘法告诉我们:H100 有 27 在张量核心使用亿次晶体管。

可是,H100 却有 800 一亿次晶体管。这意味着 H100 GPU 上只有 3.3% 用于矩阵乘法的晶体管。这是英伟达和其他芯片制造商经过深思熟虑的设计决定。如果你想支持所有类型的模型(CNN、LSTM、SSM 等等,所以没有什么比这更好的了。

而且只是通过运行 transformer,Etched 能让 Sohu 更多的芯片输出 FLOPS,并且需要降低精度或稀疏性。

内存带宽也不是瓶颈

实际上,对于像 Llama 3 这种模型,情况并非如此。

我们使用英伟达和 AMD 标准为例:2048 个输入 token 和 128 个导出 token。大部分 AI 产品的 prompt 比如最新的更长时间 Claude 系统中的聊天机器人 prompt 中拥有 1000 tokens。

在 Sohu 上面,推理就是分 batch 运行的。每个 batch 所有模型权重都需要载入一次,并且在 batch 的每个 token 中间重复使用。一般而言,LLM 输入是计算密集型的, LLM 内存密集型导出。在我们输入输出的时候 token 与持续 batch 结合起来,工作负荷就变成了高度计算密集型。

以下是 LLM 持续 batching 处理的例子,这里有四个输入。 token 和四个导出 token 序列。每一种颜色代表不同的序列。

在运行过程中,我们可以扩展相同的技能。 2048 个输入 token 和 128 个导出 token 的 Llama 3 70B。每个 batch 其中包含用于一个序列的内容 2048 个输入 token,以及用于 127 一个不同的序列 127 个导出 token。

假如这样做了,那么每一个。 batch 需要大约 (2048 127)×70B 参数 × 每个参数 2 字节 = 304 TFLOP,而且只需载入即可 70B 参数 × 每个参数 2 字节 = 140 GB 模型权重和大概 127× 64 × 8 × 128 × (2048 127) × 2 × 2 = 72GB 的 KV 缓存权重。这个计算比内存带宽要多得多:H200 需要 6.8 PFLOPS 可以最大限度地发挥其内存带宽。这个计算比内存带宽要多得多:H200 需要 6.8 PFLOPS 计算可以最大限度地提高其内存带宽。或者利用率是 100% 在这种情况下,如果利用率只是 30%,就需要 3 内存倍数以上。

Sohu 具有较高的计算能力和应用率, 因此,在没有内存带宽瓶颈的情况下,可以运行巨大的吞吐量。

怎样工作软件?

在 GPU 和 TPU 事实上,软件是个噩梦。随意处理 CUDA 和 PyTorch 代码需要极其复杂的编译器。第三方 AI 芯片(如 AMD、Intel、AWS 等等)在软件上总共花费了几十亿美元,但是收效甚微。

而 Sohu 只运行 transformer,因此只需为 transformer 编写软件。

大多数运营开源或内部模型公司都采用特定的方式。 transformer 推理库,比如 TensorRT-LLM、vLLM 或 HuggingFace 的 TGI。

这些框架非常僵化,虽然你可以优化模型的超参数,但实际上你不支持更改底层模型代码。但没关系,因为都是。 transformer 模型非常相似(甚至是文字) / 图像 / 视频模型),所以超参数调优才是你真正需要的。

尽管 95% 的 AI 企业就是这样,但是有些最大的 AI 实验选择定制方法。它们拥有工程师团队手动调整 GPU 为了实现更高的利用率,进行逆向工程,最大限度地减少寄存器对每个张量核心的延迟。

Etched 让我们停止逆向工程,他们的软件(从驱动软件、核心到服务堆栈)将是开源的。如果你想实现定制 transformer 层,那么核心指导就可以自由地这样做。

创业团队:哈佛辍学生领导

Etched 的 CEO Gavin Uberti 告诉记者:「如果未来 Transformer 不再是主流,那么我们就会消亡。但是如果它继续存在,我们将成为历史上最大的公司。」

打造 Sohu 芯片 Etched 公司成立仅两年,位于加州库比蒂诺,目前只有一个团队。 35 人,创始人是一对哈佛辍学生。 Gavin Uberti(前 OctoML 和前 Xnor.ai 员工)和 Chris Zhu,他们和 Robert Wachen 前赛普拉斯半导体公司首席技术官员 Mark Ross 共同努力,一直致力于打造专门用途。 AI 大型芯片。

在 Sohu 在发布芯片的同时,Etched 还宣布已经完成 1.2 亿美元 A 轮融资,由 Primary Venture Partners 和 Positive Sum Ventures 共同领投。Etched 总融资额已经达到 1.2536 亿美元,本轮融资的重要投资者包括 Peter Thiel、GitHub CEO Thomas Dohmke、Cruise 创始人 Kyle Vogt 和 Quora 创始人 Charlie Cheever。

但对占有超过了 80% AI 英伟达的芯片市场份额为1.2。 一亿美元只相当于它半天的收入。

「为什么我们如此兴奋,为什么我们选择辍学,为什么我们集结团队,为什么我们加入芯片项目? —— 它是最重要的工作,」Etched 运营主管 Robert Wachen 说道。「未来的整体技术将取决于计算基础设施是否能够实现大规模。」

Uberti 声称到目前为止,匿名客户已经预订了。「数千万美元」预计今年第三季度的硬件,Sohu 把市场推向市场。

将来真的如 Uberti 所说,只有在那里 Sohu 这类芯片上,视频生成、音频生成、具体智能等技术能否真正落地?

参照内容:

https://www.etched.com/announcing-etched

https://twitter.com/Etched/status/1805625693113663834

https://www.cnbc.com/2024/06/25/etched-raises-120-million-to-build-chip-to-take-on-nvidia-in-ai.html

https://techcrunch.com/2024/06/25/etched-is-building-an-ai-chip-that-only-runs-transformer-models/

本文来自微信微信官方账号“机器之心”(ID:作者:机器之心,编辑:泽南,杜伟,36氪经授权发布,almosthuman2014)。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com