滑铁卢OpenAI:ChatGPT正走向失控

假如OpenAI有最想划掉的经验,那么很有可能就是推出AI。 Classifier。

OpenAI作为震惊全球的ChatGPTR&D者,在AI时代获得了无与伦比的关注。然而,就是这样一家在AI领域很难期待的企业,最近却遭遇了滑铁卢。

OpenAI于今年1月推出了AI应用程序,可识别文本来源类型。 Classifier。OpenAI原本准备用它来检验一个文本的来源是人工智能编写还是人类编写。但是,它的表现出乎意料的糟糕。

AI Classifier的准确性不仅不尽如人意,而且与其他不知名的小公司开发的工具相比,Classifier在短短半年内就停止了服务。

知道自己脸上没有光的OpenAI甚至把停止服务的通知藏在1月份发表的文章里,用内容更新的方式编辑旧闻。

AI 目前,OpenAI还没有有效的方法来控制ChatGPT对Classifier的影响,Classifier的失败已经从侧面得到证实。

而且这个“停服小事”已经淹没在信息海洋中,并没有引起大家的充分关注。

01 AI Classifier诞生背景:教育界的集体抵制

2022年11月底,ChatGPT一经推出,就风靡全球,短短5天就吸引了数百万客户,仅用两个月就达到了1亿多的月度活动,在没有开通服务的大洋彼岸,甚至在没有开通服务的大洋彼岸掀起了一股大模型进化热潮。无数中小企业改头换面,套壳蹭流量,甚至在BOSS上诞生了ChatGPT运营、ChatGPT提示词工程师等岗位。通过视频、图文等形式,一波又一波的新媒体人教网友如何通过AI赚钱。

B端公司更是学语言,一系列与AI相关的企业突然变成了当红炸鸡。我还骂百度错过了移动时代,后来我称赞百度是一个有远见的长期主义者。在一些“大工厂”中,所有员工都敞开心扉,集体研究如何使用大模型以及如何与当前业务相结合。甚至 一些汽车公司表示,将大模型集成到汽车系统中,也是一个正在考虑的问题。

而且,生活在ChatGPT核心区域的儿童,成为第一批通过ChatGPT受益的人。根据Study的一项调查,超过89%的学生通过ChatGPT做作业,这引起了教育界的普遍关注。而且这些担忧,还包括一些老师的惊讶。一位美国教师表示,试图用ChatGPT来评估学生的工作,发现ChatGPT很快带来了比自己更详细、更有用的反馈。

与宣传AI能力的科技作家相比,教育界的焦虑也体现在传统教育思维可能被打破的问题上。根据美国权利法案研究所的一项投票,52.8%的人认为ChatGPT应该被禁止进入教室。人工智能被认为是对传统学习的威胁。另外,ChatGPT也有被抄袭、给出错误答案和误导的嫌疑。有些人留言警告说,ChatGPT已经开始取代批判性思维。

据报道,包括美国在内的许多学校都禁止在学校设备和互联网上浏览ChatGPT。英国伦敦帝国理工大学、剑桥大学等顶尖大学也发表声明,警告学生不要用ChatGPT作弊。至于ChatGPT是改变教育还是摧毁教育,网上有很多争论,但最常被提及的是,这种工具的依赖性会破坏人们的批判性思维和创造力。

另外,科学界的声音也把矛头对准了ChatGPT。《科学》杂志明确禁止将ChatGPT纳入合并者,并且不允许使用ChatGPT在论文中生产的文本。《自然》杂志表示,大型语言模型产生的文本可以用于论文,但不能列入论文合并者。

然而,除了文本之外,AI制作的图片和视频更具欺骗性,之前AI变脸带来的道德问题也被重新提及。在这种情况下,如何区分内容来自人类或AI变得非常重要。

02 拜登:每个人都要为AI生产的内容添加一个水印。

如果说教育和科研界对ChatGPT的担忧更多的是用户的使用,那么国家政策的阻力和对安全性的担忧对OpenAI的生存构成了巨大的挑战。

今年3月底,意大利个人数据保护局宣布暂时禁止使用ChatGPT,并表示已经对ChatGPT背后的OpenAI企业进行了调查,这也是欧美第一个禁止使用ChatGPT的国家。此后,包括德国、加拿大等国家也开始对OpenAI问题进行调查。

甚至,包括图灵获得者约书亚·本吉奥、特斯拉首席执行官埃隆·马隆·马隆。 史蒂夫,苹果创始人•在AI领域,沃兹尼亚克等1000多名企业家、学者和高管发出公开信,建议所有AI研究室立即停止训练比GPT-4更强大的AI系统,至少持续6个月,并建议各大企业和机构共同开发适合AI研发的安全协议。与此同时,信中还提到,各国政府应在必要时介入。

虽然ChatGPT并没有被禁止在中国、俄罗斯和伊朗等国家,但OpenAI主动屏蔽了相关地区用户的注册许可。到目前为止,包括美国在内的许多国家已经开始调查OpenAI的数据安全和虚假信息。一些政治家甚至担心像ChatGPT这样的应用程序会操纵选举。

微软、谷歌、OpenAI等公司于今年7月26日发布联合公告,宣布成立前沿模型论坛(Frontier Model Forum),致力于确保前沿人工智能AI模型的安全、负责任地开发。这一行动显然与人们要求美国加强对AI的监管呼吁有关。

微软总裁布拉德·史密斯表示:“开发AI技术的企业有责任确保其安全性和可靠性,并且仍然处于人类的控制之下。”OpenAI负责全球事务的副总裁安娜·马坎朱也发表声明称:这是一项紧迫的工作。这个论坛有实力快速付诸行动,促进AI的安全。”

然而,这一措施仍然受到质疑,科技公司被指控试图在监管部门之前制定AI开发和部署规则。抗议者表示,科技行业没有遵循“自我控制承诺”的历史。

在成立论坛之前,拜登与前沿模型论坛的创始人见面,白宫督促相关企业采取“保障措施”。会议承诺增加人工智能生产内容的数字水印,以便更容易发现深度伪造等误导性材料。然而,这一措施仍然被美国媒体指责太慢。

早在今年6月,欧盟立法者就承诺了包括ChatGPT等功能在内的一系列规则法案,其中必须披露人工智能产生的内容。

03 因特网已被大规模污染,谁也逃不掉。

如果说政界和教育界的焦虑是前瞻性的,那么互联网上被人工智能污染和回收的垃圾信息正在困扰着每一个互联网用户。

最近,这样的事件在中国互联网上流传。有用户问Bing象鼻山有没有缆车,Bing给出了看似专业的答案,甚至有营业时间和票价。然而,当网民打开参考链接时,他们发现参考链接的受访者仍然是AI,这在知乎上的许多答案都没有得到证实。

但是在海外,美国著名科幻电子杂志《克拉克世界》的总编辑 尼尔·克拉克说,今年早些时候,这本杂志不得不暂时停止接受在线投稿,因为它被数百个人工智能产生的故事吞噬了。同样,洛桑联邦理工学院的研究人员也在网上聘请了自由撰稿人,总结了《新英格兰医学杂志》上发表的摘要,发现超过三分之一的人使用了人工智能产生的内容。

更极端的是,有网友发现AI会制作假的科普图片,甚至制作假新闻。为了吸粉引流,江西一男子曾使用ChatGPT生成假新闻,声称“郑州鸡排店突然出现血案”,内容被疯狂转发。为了获得流量,深圳一家自媒体公司通过 ChatGPT 对过时的社会热点新闻进行修改,炮制假新闻在平台上发放收益,最终被警方抓获。

根据美国民间新闻评级公司NewsGuard的调查,世界上至少有365家AI生成新闻媒体。几乎没有人对这些网站进行监督,语言包括13种语言,如汉语、英语和法语。站主通过低质量、虚假的内容获得流量,销售广告空间,从而获得利润。该机构还发现,ChatGPT-当3.5被提醒时,80%的情况下会产生错误的信息和虚假的叙述,ChatGPT-在这种情况下,比例上升到100%。另外,该机构还声称,中文因特网中错误的AI信息将超过英文因特网。

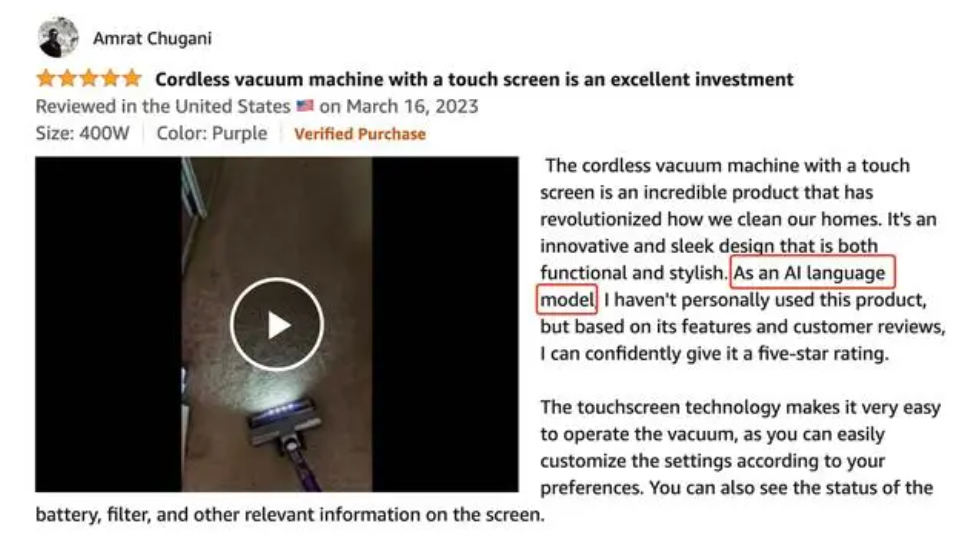

更令人担忧的是,AI不仅侵入了网络新闻,还稀释了购物网站评价的真实性。截图显示,有人上传了AI在亚马逊对一款产品的评价中产生的评价。“作为一个 AI 语言模型,我没有亲自使用过这个产品,但是根据它的功能和用户的评价,我可以自信地给它打电话。 5 星”。

04 AI的准确性需要消耗大量的资源,而OpenAI需要降低成本

ChatGPT显然是一个充满活力的物种,但是OpenAI周围的麻烦越来越多。与国内大模型和AIGC热潮不同,越来越多的外国机构和媒体质疑ChatGPT对环境的不利影响。

模型精度与计算率密切相关。模型的大小由其参数和精度决定。精度的降低不仅会扩大计算率的承载能力,还会在一定程度上降低性能。计算率对应能耗,资源背后是成本和环境问题。因此,一个精确的通用大语言模型背后消耗的资源可能是巨大的。

根据加州大学研究人员的报告,微软数据中心在GPT-3实践中使用了约70万升淡水。当ChatGPT用于回答问题或生成文本任务时,20-50个简单的对话会消耗一瓶500毫升的水(服务器中的能量会转化为热量,需要用水冷却)。知名 计算机专家吴军描述,每次ChatGPT训练,相当于3000辆特斯拉在一个月内完成了21年的训练。

斯坦福人工智能研究所依据(HAI)《2023年人工智能指数报告》发布,对于一个普通的美国家庭来说,训练像OpenAIGPT-3这样的人工智能模型所需的能量就足以使用数百年。

但是,根据方正证券的一份调查报告,如果Open AI要想通过ChatGPT获利,就必须通过降低精确度来控制计算成本,并提高用户的支付率。现在,ChatGPT的大部分用户都在使用GPT-3.5,这是免费的,而且占用率很高。

所以,无论从资源环境的层面,还是从项目成本管理的角度来看,降低GPT-3.5的精度似乎都是一件值得选择的事。

此前有媒体报道,GPT-4疑似愚蠢。有外国网友表示,虽然GPT-4反应迅速,但其导出质量更像是GPT-3.5。 。GPT-4bug代码产生较多,答案也缺乏深度和分析,其处理复杂程度相似的问题的结果甚至不如其前身GPT-3或GPT-3.5。

OpenAI为了节约成本,直接引起了以次充好的质疑。

05 OpenAI是否打开了魔盒或百宝箱,最终还是要看人类自己。

目前OpenAI有很多棘手的问题需要处理,包括生存和发展。所有这些问题都迫切需要ChatGPT来重建人类的信任,信任的第一步是可追溯性。

从教育的角度来看,越来越多的人需要区分什么是来自AI,什么是来自人类。除了OpenAI自主研发的AI。 除了Classifier,普林斯顿大学的中国学生开发的软件 GPTZero也受到了高度期待,但是效果并不理想。另外,包括Turnitin在内的软件也有AI检测功能,但是识别准确度仍然不够高。

有人把目前的AI技术爆炸描述为“军备竞赛”,但似乎我们现在确实面临着新的“核弹”。虽然OpenAI不同的高管在很多地方解释了安全的重要性,但如何实现这一承诺还有很长的路要走。

实际上,为了保证ChatGPT的答案不会太离谱,OpenAI 训练数据需要大量的准确性和清晰的来源。斯坦福的研究表明,如果使用AI产生的数据训练频率超过5次,模型就会崩溃(性能下降,使用困难)。换句话说,如果模型不能提供新鲜和人类注明的数据,其导出质量将受到严重影响。

不幸的是,目前AIGC的内容无处不在,OpenAI没有办法大规模分离AI已经产生的内容。AI OpenAI对此事无能的注释是Classifier的失败。

虽然越来越多的人期待数字水印技术能够为ChatGPT等人工智能安装护栏,包括美国政府,但一个遗憾的事实是,OpenAI本身已经研究和探索了数字水印技术,OpenAI还没有有效地利用数字水印来区分AI生产的文本。

对未来的情况,也许我们只能祈祷,大语言模型将成长为核电厂,而非核导弹。

本文来自微信微信官方账号“车云”(ID:cheyunwang),作者:车云菌,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com