竖置“眼睛”背后的突破:宸境科技发布会揭秘机器人感知新范式

2026年1月28日,宸境科技于杭州召开新品发布会。这场发布会未呈现大众期待的机器人“炫技”表演,如花哨的后空翻或精密的穿针引线,反而更像一场具身智能“基础设施”的亮相。

宸境科技跳出单一功能展示的框架,向行业推出一套经工业级验证的标准化感知方案,重磅发布“LooperRobotics”品牌体系及全栈技术矩阵:Insight自主空间智能相机、TinyNav神经导航算法库与RoboSpatial空间感知软件平台。

随着具身智能融合进入深水区,感知能力的上限决定机器人的天花板。宸境科技力求突破空间智能技术边界,推动机器人感知技术从“定制化”迈向“通用化”。此刻,机器人的“眼”与“脑”不再是简单零部件,而是赋能千行百业、驱动物理世界变革的核心基座。

一、硬件解构:反常识的工程美学

传统摄像头与传感器设计有个约定俗成的习惯——水平优先,即“眼睛”横向排列。这看似合理,因人类双眼横向分布,习惯关注宽广地平线,自动驾驶汽车也需横向视野监测宽阔马路。

但宸境科技此次发布的Insight自主空间智能相机偏要“反其道而行”。研发团队打破行业常规,将三个摄像头“竖置”,使镜头最大视场角达到188°。

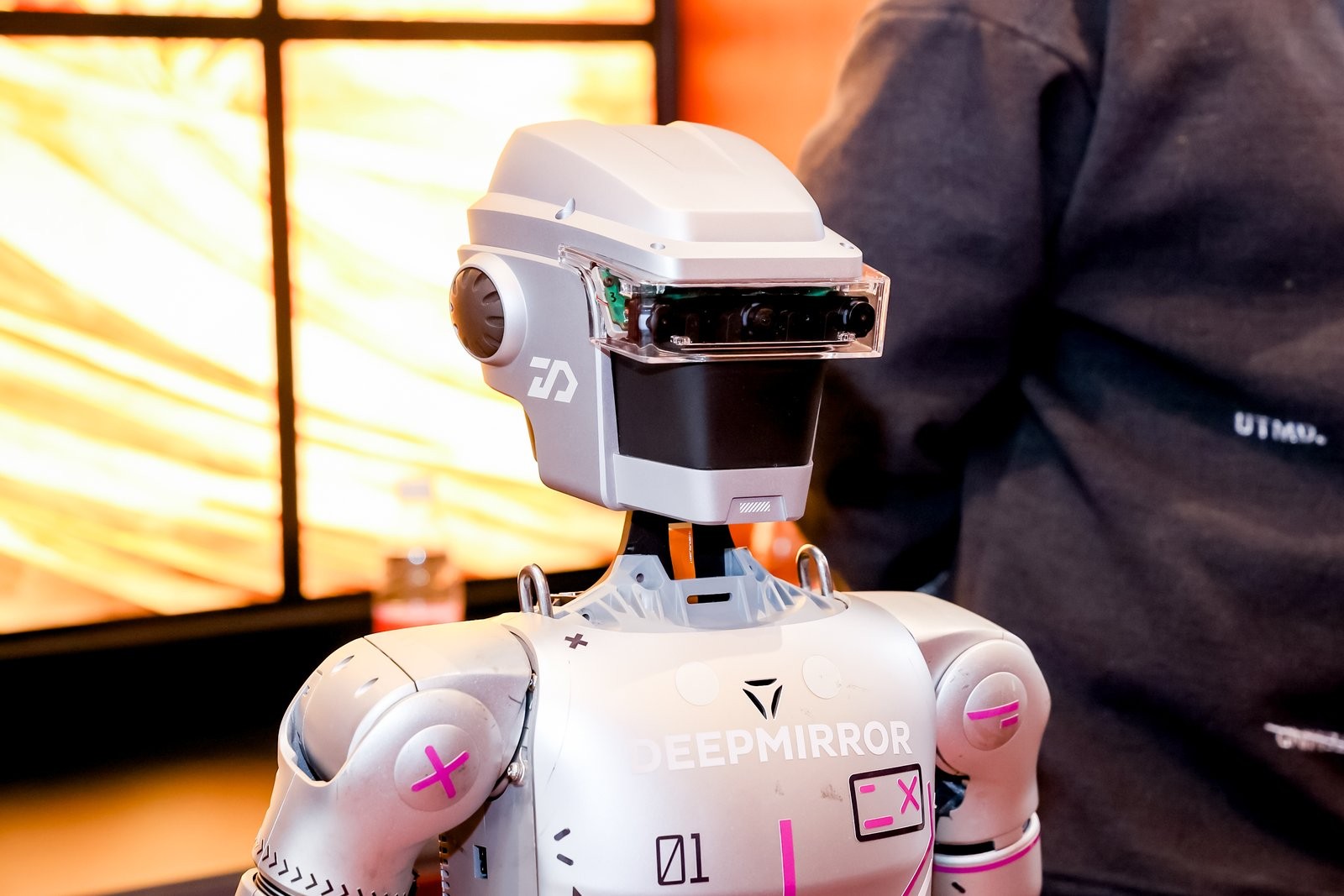

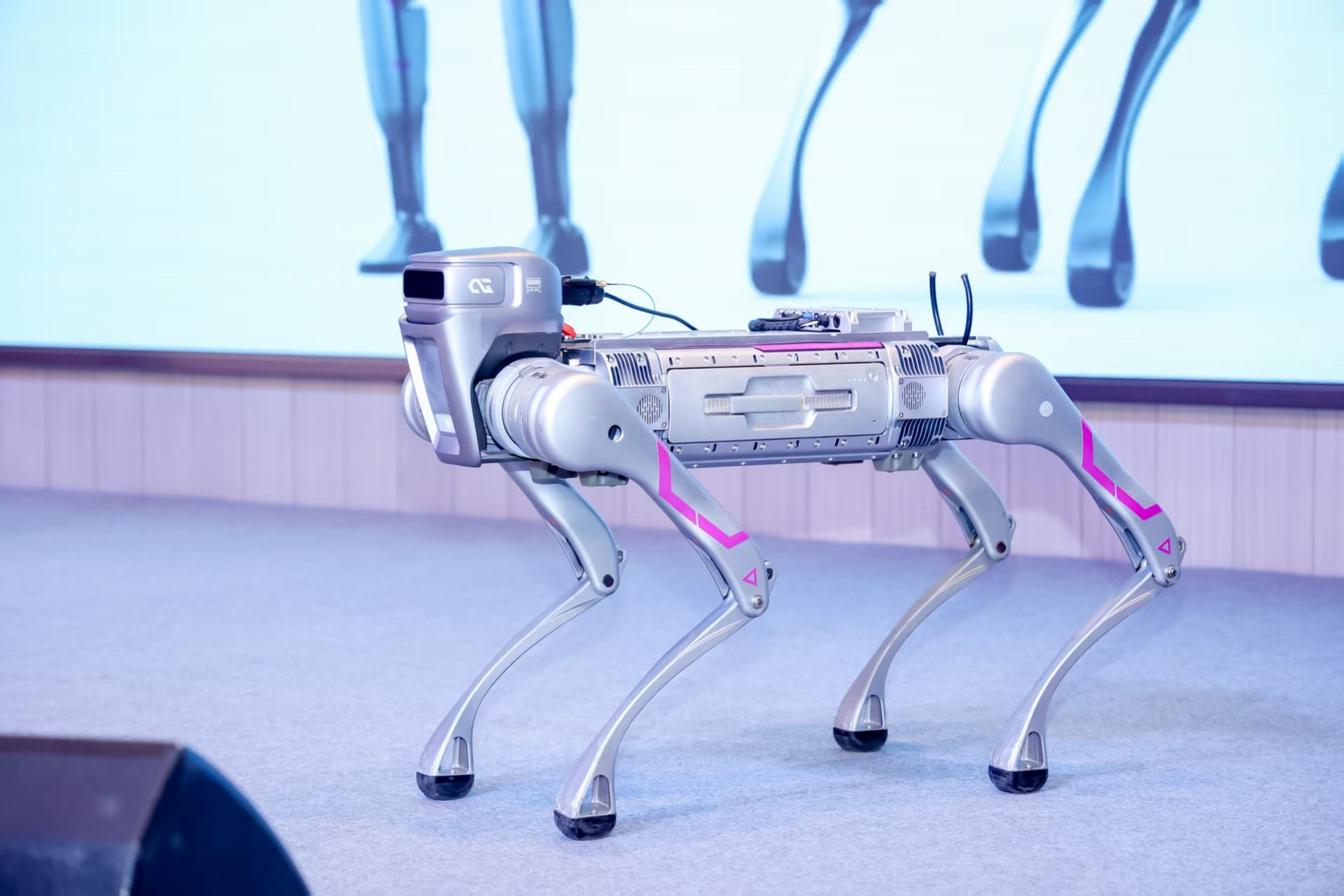

这一设计并非标新立异,而是源于对具身智能落地痛点的深刻洞察。宸境科技联合创始人兼COO颜沁睿分享了一个真实案例:与合作伙伴交流时发现,明星级机器狗或人形机器人参加WAIC等大型展会,若被观众围得水泄不通便会“失明”。原因在于传统横向摄像头视野中满是晃动的人腿与人群,机器人难以获取有效环境信息。

对机器人感知系统而言,这是巨大考验,如同人被蒙眼扔进闹市,找不到固定参照物(如路牌、大楼),瞬间陷入“信息孤岛”,迷失方向甚至撞人。

宸境科技的解法巧妙:借鉴无人机技术经验,既然四周视野受限,便转向头顶与脚下。通过纵向放置的188°超大广角镜头,即便机器人被人群包围,Insight相机仍能从人头缝隙中捕捉天花板纹理与地板结构——这些相对固定的环境特征,让机器人在复杂人群中也能稳定定位。

Insight相机的另一硬核突破是可承受24g剧烈震动。当前常用机器人相机设备通常仅能承受8g以内加速度,满足平地慢速轮式机器人或扫地机需求。但在宇树机器狗开发过程中,团队发现足式机器人高动态运动(跑酷、跳跃、摔倒爬起)时,瞬间颠簸冲击力易突破8g,导致传感器失灵、机器人姿态感知异常。

因此,Insight相机将抗震能力提升至24g,为未来人形机器人从事重体力、复杂环境作业提供支撑,让机器人的“眼睛”从“温室花朵”进化为“工业器官”。

二、算力内移:端侧集成“黑科技”

在数据处理方式上,Insight相机研发团队做出大胆决策:将“大脑”嵌入“眼睛”。在仅30mm宽(不及饼干大小)的电路板上,集成了一颗具备10TOPS AI算力的地瓜机器人智能计算芯片。为何要为摄像头配备强算力“微型电脑”?

首先是解决传统机器视觉的“白墙恐惧症”。传统双目视觉依赖左右眼图像差异计算距离,对物体表面纹理要求高,面对白墙、透明玻璃或黑暗环境时,因缺乏纹理差异导致距离计算失效、数据漏洞。

Insight相机采用神经网络深度计算,不仅“看”,更能“脑补”。借助强大芯片算力,算法通过学习大量环境数据,即便面对白墙也能精准计算距离——这需大量算力支撑,仅靠机器人主机难以承载。

更深层意义在于为机器人构建快速“反射弧”。机器人运行数据量大,若所有计算集中在主机,不仅挤占逻辑运算资源,还可能引发传输延迟。几十毫秒的延迟就可能导致高速运动的机器人失衡或碰撞。

因此,宸境科技让Insight相机在端侧完成复杂计算,直接向主机反馈“自身位置”“前方距离”等关键信息,实现“感知-行动”闭环在毫秒级完成,确保机器人动作敏捷、响应精准。

此外,宸境科技试图推动VSLAM技术“平权”。长期以来,VSLAM(视觉定位与建图)技术被巨头垄断,中小机器人企业自研需投入2-3年时间与数千万资金,还可能因技术门槛无法达标而转向激光雷达方案。

宸境科技将这套经过严苛验证的复杂系统转化为“开箱即用”的标准件,让开发者无需重复造轮子,可专注于机器人应用场景开发。

三、认知进化:TinyNav的“生物本能”

Insight相机解决了机器人“看得见”的问题,TinyNav神经导航算法库则聚焦“认得路”——这不仅是技术升级,更是让机器人从“量尺寸”进化到“懂环境”。

TinyNav项目发起人杨振飞介绍:“目标是打造一套开源高性能机器人导航库。”传统导航技术本质是“几何测量”,在长走廊或家具变动场景中易产生累积误差导致机器人“迷路”。为解决特殊场景问题,开发者需引入大量人工规则代码,如常用的ros nav2导航库代码量达14万行。

TinyNav选择仿生学路径,借鉴诺贝尔奖级发现——生物大脑中的“网格细胞”与“位置细胞”。人类认路并非靠步数计数,而是通过环境特征(如红沙发、电视等)识别场景。

为实现这一目标,TinyNav充分利用生成式世界模型成果:只需少量真实场景数据,就能生成大量高保真虚拟场景,提升导航系统泛化能力。为此,TinyNav将核心代码目标行数限制在3000行。

颜沁睿解释:“团队成员曾参与自动驾驶、无人机量产,亲历过为适配不同场景写规则调参数的繁琐过程。随着AI大模型发展,我们认为TinyNav这种轻规则重数据的架构才是原生AI方案,能与Insight相机的端侧算力高效协同,且随数据与算力提升适配更通用场景,实现自我进化。”

发布会上,宸境科技首席机器人科学家左星星首次公开亮相,介绍了公司在多模态感知、场景理解、视觉语言导航(VLN)、视觉语言动作(VLA)、人形机器人动作生成、双臂灵巧手操作等前沿技术研究。左星星是具身智能领域新星,现任阿联酋穆罕默德·本·扎耶德人工智能大学(MBZUAI)机器人系助理教授,领导机器人认知与学习实验室。

他曾任加州理工学院博士后、Google研究科学家、苏黎世联邦理工学院客座学者,研究方向包括移动机器人感知、3D计算机视觉、具身智能、多传感器融合等。因在机器人感知领域的突出贡献,左星星当选机器人顶刊T-RO、RA-L编委,及顶会RSS、IROS、ICRA编委,其加盟为宸境科技提供坚实技术支撑。

为降低系统使用门槛,宸境科技开发了RoboSpatial空间编辑平台。这如同开发者的“积木游戏”——通过可视化界面,像搭积木一样标注“禁行区”“减速区”“充电桩”等区域即可完成路径规划。不懂高深算法的运营人员也能在几小时内为港口、园区部署机器人作业流程,大幅降低具身智能落地难度。

四、具身智能的“基建狂魔”

从算法与软件见长的空间计算公司,拓展至推出硬核传感器硬件,宸境科技的转型看似突然,实则必然。

“算法公司为何做硬件?因空间智能技术并非纯粹软件,而是软硬件深度协同的系统工程。”颜沁睿直言,“优秀的SLAM工程师需是全栈人才,懂算法、相机光学特性、结构强度影响、嵌入式驱动逻辑。软硬一体是打破落地障碍、保证工业级稳定性的唯一路径。”

发布会上,宸境科技联合创始人兼CEO胡闻提出“空间智能即服务”理念。他认为,具身智能已形成全球“超级共识”,市场规模将比肩汽车与手机,达万亿美金级别。在产业链中,宸境科技不造机器人,而是做具身智能的“基建狂魔”,立志成为机器人时代的一级供应商。

“若汽车是移动基础设施,手机是信息基础设施,机器人将是未来物理任务基础设施。”胡闻表示,无论是B端“类劳动力”补充,还是G端公共服务,都需要统一、标准、高可用的感知底座。

当LooperRobotics为机器人配备工业级“眼睛”、生物级“大脑”与标准化“前庭系统”,具身智能才算真正走出实验室,具备进入千行百业、应对真实物理世界挑战的能力。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com