华盛顿大学:大模型成无损文本压缩器,超越ZIP

当大语言模型生成海量数据时,数据存储难题也随之而来。华盛顿大学(UW)SyFI实验室的研究者们提出创新解决方案——LLMc,即利用大型语言模型自身进行无损文本压缩的引擎。

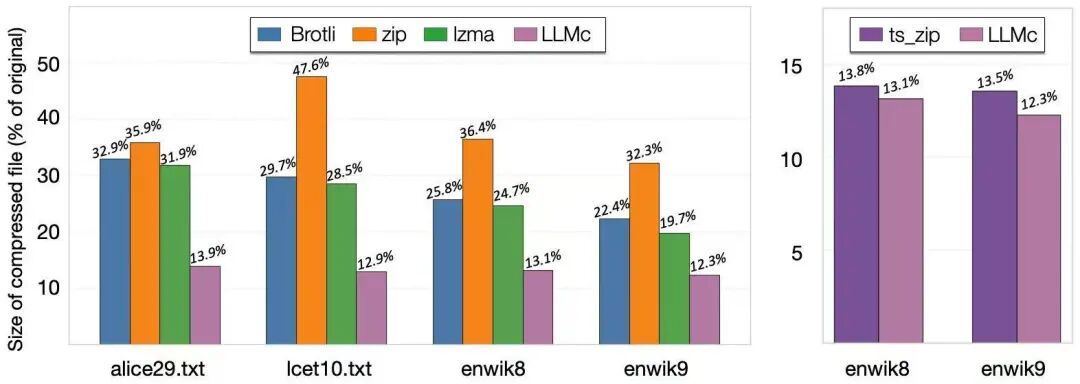

基准测试结果显示,在维基百科、小说文本、科学摘要等多种数据集上,LLMc的压缩率优于传统压缩工具(如ZIP和LZMA)。与其他以LLM为基础的闭源压缩系统相比,LLMc也表现出同等甚至更优的性能。

值得一提的是,该项目已开源,主要作者是来自上海交通大学ACM班的本科生Yi Pan,目前正在华盛顿大学实习。

LLMc的压缩机制

LLMc的灵感源于实验室一年前的内部讨论。当时,研究者们面临核心挑战:LLM推理中涉及的内核操作具有高度非确定性,这让精确、可复现的压缩和解压变得困难。不过,随着业界在确定性LLM推理方面取得突破,问题得到解决,也为新引擎的诞生铺平了道路。研究团队顺势快速构建了LLMc的原型,并成功证明用LLM进行高效压缩的可行性。

LLM与数据压缩之间的联系基于信息论的基本原理。香农的信源编码定理指出,一个符号的最优编码长度与其负对数似然成正比,即一个事件的概率越高,编码它所需的信息量就越少。由于LLM的核心任务是预测下一个词元,一个优秀的LLM能够为真实序列中的下一个词元赋予极高的概率。这意味着,LLM本质上是一个强大的概率预测引擎,而这正是实现高效压缩的关键。LLMc利用这一原理,将自然语言的高维分布转换为结构化的概率信息,实现前所未有的压缩效果。

LLMc的核心思想是“基于排序的编码”方法。在压缩过程中,LLM会根据当前上下文预测下一个可能出现的词元,并生成完整的概率分布列表。大多数情况下,真实出现的词元总在这个预测列表的前几位。LLMc不直接存储词元本身,而是存储该词元在概率排序列表中的“排名”,这些排名通常是很小的整数,占用存储空间极小。在解压时,系统使用相同的LLM和上下文重现当时的概率分布,读取之前存储的“排名”,就能准确从列表中选择对应词元,无损恢复原始文本。在这个过程中,LLM就像压缩器和解压器之间共享的“密码本”或参考系统。

挑战与局限性

尽管LLMc取得突破性成果,但研究团队也指出当前版本存在的一些挑战和局限性。

效率问题:LLM推理的计算复杂度与序列长度成二次方关系,长序列推理受内存带宽限制。为缓解这一问题,LLMc采用分块处理文本的策略,提高GPU利用率并降低计算开销。

吞吐量:由于严重依赖大规模模型推理,LLMc目前的处理速度远低于传统压缩算法。

数值稳定性:为保证解压过程的确定性,系统需使用特殊内核,并对词元排名进行整数编码,而非直接使用对数概率。

应用范围:当前实现主要针对自然语言。如何将其扩展到图像、视频或二进制数据等其他模态,是未来值得探索的方向。

参考链接:

https://syfi.cs.washington.edu/blog/2025-10-03-llmc-compression/Github

网址:

https://github.com/uw-syfi/LLMc

本文来自微信公众号“量子位”,作者:朔风,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com