MIT华人博士团队:机器人实现纯视觉控制,成果登Nature主刊

电子发烧友网报道(文 / 梁浩斌)近年来,“纯视觉”概念在智能驾驶领域频繁被提及。特斯拉、小鹏,还有传闻准备重组的极越,都全力投入到“纯视觉”智能驾驶技术中。一些智驾方案商为推动产品落地,也在加速推出纯视觉方案以降低系统成本。

在机器人领域,传感器应用一直是业界研究核心。像3D ToF相机、激光雷达、毫米波雷达、触觉传感器和各种力矩传感器等,在当前主流机器人领域都广泛应用。

不过,近期发表在Nature主刊上的一篇论文,展示了机器人的“纯视觉”方案。

传统机器人控制方案

传统机器人由高刚度材料精密加工部件构成,结构上通过低公差关节连接,可简化为理想化的刚性连杆运动学链。为让系统了解机器人状态,需用多种传感器监测,如在每个关节配备高精度传感器(像角度编码器),实时测量关节状态变化,这些数据用于完整重建机器人的3D位姿,再通过基于动力学模型设计的控制算法(如PID、MPC),将期望运动轨迹转换为执行器指令。

论文指出,传统机器人控制方案存在局限性。其一,依赖机器人预设结构和传感器,要求机器人有离散关节和嵌入式传感器,不适用于缺乏传感器的软体或混合材料机器人。

其二,在使用柔性结构的机器人中,要解决大变形、粘弹性、材料疲劳等复杂问题,传统基于连续介质力学的模型计算成本高,难以实现实时控制。而且,传统模型无法处理关节间隙或制造公差导致的非线性动态。

此外,模型对机器人公差要求极高,依赖精密制造和高性能材料,成本高、开发周期长,不利于机器人普及。

“纯视觉”机器人控制方案有什么优势?

该论文由麻省理工学院(MIT)多位研究人员合作完成,论文前三作李思哲、张安南和陈博远,都在MIT计算机科学与人工智能实验室(CSAIL)攻读博士学位。

为何会想用“纯视觉”构建机器人控制系统?论文团队表示,灵感源于人类感知。人类用游戏控制器控制机器人,几分钟就能学会拾取和放置物体,而唯一用到的传感器就是眼睛。

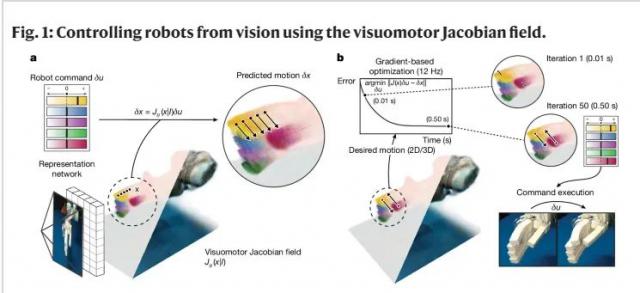

论文中的“纯视觉”机器人控制方案采用了名为Visuomotor Jacobian Field(视觉运动雅可比场)的技术,这是一种机器学习方法,可利用单个视频摄像头的数据控制机器人。

首先,团队用12个消费级RGB - D视频摄像头捕获的、执行随机生成命令的多视图视频训练框架,无需人工注释或专家定制就能学习控制新机器人。训练后,该方法仅用单个视频摄像头就能控制机器人执行期望动作。

视觉运动雅可比场框架主要有两个关键部分。一是基于深度学习的状态评估模型,它能仅通过单一视频流推断机器人三维状态,编码其三维几何形状和微分运动学,可确认在任何可能指令下,机器人在三维空间中任何点的移动方式。

二是逆动力学控制器,在二维图像空间或三维空间中以密集方式将期望运动参数化,实时计算并输出机器人控制指令。研究团队发现,将演示轨迹参数化为密集的点运动是控制各类机器人系统的关键,因为可变形和灵巧机器人的运动不能被单个三维框架上指定的刚性变换很好约束,参数化使广泛系统能模仿基于视频的演示。

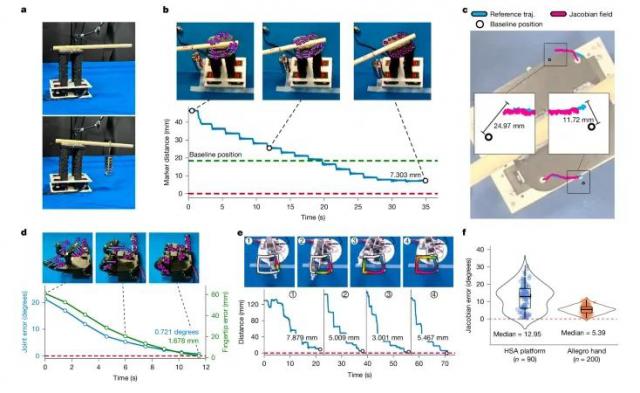

最终,该方法让团队获得跨平台的机器人控制能力。在使用16自由度的商用Allegro灵巧手测试时,关节角度误差小于3 °,指尖位置误差小于4mm;用3D打印的15气动通道软体手,能精准抓取工具且具备抗遮挡能力;在采用剪切拉胀材料的HSA柔性腕平台上应用,附加350g负重后仍有7.3 mm精度;用3D打印的Poppy教育机械臂,零部件公差较大时,误差小于6 mm。

此外,该方案能实现无专家干预和机器人的泛化能力,可自动发现机器人运动学结构,无需标注执行器与部件对应关系。而且训练数据虽仅含随机命令,却能泛化到未训练的运动。

采用该方案进行机器人控制,可显著降低机器人自动化门槛和控制成本。其关键创新是将传统机器人控制的建模问题转化为基于视觉的自监督学习问题,为生物启发式机器人的实际部署开辟了新路径。

更多热点文章阅读

点击关注 星标我们

将我们设为星标,不错过每一次更新!

喜欢就奖励一个“在看”吧!

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com