GPT-5R&D内幕首次曝光,OpenAI首席研究员:AGI指日可待

近来,GPT-关键人物4.1揭示了GPT-5的进展,挑战在于平衡推理和聊天能力。与此同时,OpenAI首席研究官在新的采访中谈到了通往AGI的关键因素。

GPT-5到哪个步骤?

近期,GPT-Michellellell4.1核心研究员 Pokrass透露,构建GPT-5的挑战在于在推理和聊天之间找到适当的平衡。

她坦言,「o3会认真思考,但不适合随意聊天。GPT-4.1通过牺牲一些闲聊质量来提高编码能力」。

「现在,目标是训练一个知道什么时候认真思考,什么时候谈话的模型。」。

Michelle首次介绍了GPT-4.1背后的开发过程,以及RFT在商品中所扮演的关键角色,这是最近50分钟的最新对话。

OpenAI首席研究官表示,面对AGI的最终目标,「AGI不仅仅是ChatGPT,还包含许多物品。」。

目前,OpenAI不仅要面对技术挑战,还要在信任和伦理上找到平衡。

GPT-4.1研发背后

Michelle Pokers表示,GPT 4.1的目的是让开发者在使用时感到快乐。

有时候,为了优化基准测试而调整模型,结果看起来不错,但是在实际应用中发现了一些问题,比如模型不遵循指令,格式怪异,或者前后文字太短。

团队花费大量精力与用户沟通,收集他们的意见,然后将这些反馈转化为研究过程中真正可以使用的信息。

研究者会观察反馈中反复出现的主题,例如指令遵循能力。

这些模型也用在OpenAI内部,所以可以感觉到模型在哪里表现不佳。

通过各种因素,团队可以确定哪些评估指标是用户真正需要优化的。

OpenAI有一个电子邮件产品,在处理邮件时可以获得免费的推理服务。公司可以利用这些信息作为交换。

Michelle真的很喜欢看到大家搭建的各种华丽的操作界面。

在模型开发的最后阶段,团队悄然加入了一个改进,即UI和编码能力的大幅提升。

同时,她还看到喜欢人们使用Nano的情况,它小巧、便宜、快捷。

Nano背后的假设是,AI的普及能否通过廉价快捷的模型大大推动?当然可以。人们需要各种地方的支出延迟曲线。

就提高模型性能而言,GPT 4.1聚焦长前后文和指令跟随。

长期前后文处理量是检验模型在复杂任务中所表现出来的一个重要指标,但是生成有效的长期前后文评估内容是非常具有挑战性的。

为了提高模型在实际应用中的性能,OpenAI致力于获取更多真实世界的长前后文评估数据。

抽象处理是模型应用中的一大难题。

要求开发者能够灵活地调整模型的策略,是进一步询问用户信息,还是根据现有信息进行假设推理。

GPT 4.1在这方面做了改进,提高了模型的可操作性,减少了抽象带来的麻烦。

当API出现错误时,模型可能会卡住,影响使用体验。

通过改进训练算法和数据处理方法,OpenAI可以使模型在面对错误和异常现象时持续稳定运行。

GPT 4.1显著提高了代码编写能力,在修改局部代码任务时表现出色,但在涉及全局前后文和复杂代码推理时,仍需提高。

例如,在处理文件之间传达复杂技术细节的任务后,需要提高模型的理解和处理能力。

对于前端编码,团队不仅要求功能正确,而且注重美观和规范,符合工程师的专业审美。

新的RFT突破

GPT中的微调技术 4.1起着重要作用,RFT(加强微调)的出现,给模型能力拓展带来了新的可能性。

与传统SFT相比,RFT在特定领域具有很强的优势。

RFT的微调过程数据在ic设计、生物学和药物研发等领域都非常有效,只需几百个样本就能取得良好的效果。

通过RFT,可以使用独特的、可验证的数据,使模型更加精确地模拟药物的作用机制,加快研发进程。

在ic设计领域,RFT可以帮助模型更好地理解和处理复杂的设计规则,优化设计方案。

这一领域的共同特点是,尽管需要不断探索,但是实验结论很容易验证,与RFT的优势高度兼容。

OpenAI首席研究员:通往AGI的道路

通过采访OpenAI模型背后的人,国外媒体TechINAsia的最新文章再次向大众展示了OpenAI可预见的AGI未来。

Mark Chen,这个中国研究科学家,在内部模型研发中发挥着重要作用。

在OpenAI的七年里,他逐渐从研究科学家晋升为首席研究官,负责模型开发和公司的整体研究。

他领导了许多里程碑项目-o1推理模型、文本到图像模型Dalllll。-E,GPT-4与视觉感知融为一体。

从金融到AI,事故职业转折点

Mark 在Chen的职业生涯中,AI并没有从一开始就被锁定。

在MIT获得数学和计算机科学双学位后,他最初的计划是继续攻读博士学位,成为一名教授。

但是,命运的转折点出现了。

当计划合作的教授创立了一个对冲基金之后,他改变了方向,加入了金融行业。

这样一个高频交易的世界,Mark Chen度过了6年。

他坦言,「这份工作在很多方面都很令人满意,但在其他方面却很不令人满意。当你面对同一个竞争对手时,每个人都在追求更快,但你感觉不到你在改变世界。」。

谷歌AlphaGo在2016年的一场历史性比赛中击败了九位棋手李世石,他的人类水平甚至震惊了AI专家。

受此启发,Mark 通过Deep-Q神经网络,Chen复制了AlphaGo。正是这种尝试,使他完全沉迷于AI。

虽然没有博士学位,但幸运的是,他很幸运地通过OpenAI的停留计划进入了这个领域。

找出AGI的最佳平衡

谈到AGI,Mark Chen说,「这是一个非常广泛的定义,它不仅是ChatGPT,还包括其它东西。」。

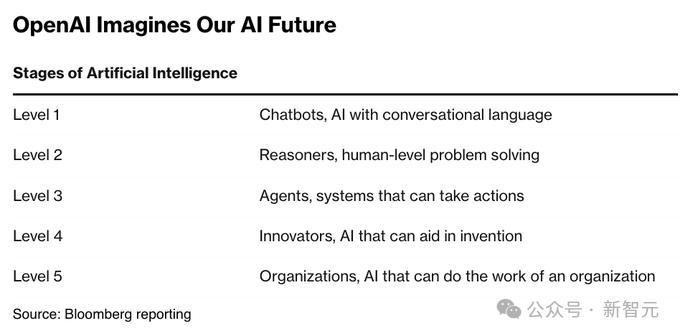

OpenAI一直把AGI当作AI的圣杯,并且制定了五级框架来实现这个目标。

而且现在,他们已达到第三级,智能体AI(Agentic AI)——可以独立执行复杂的任务和计划。

Mark 据Chen介绍,OpenAI最近推出了两款AI智能体商品,Deep Research和Operator还处于起步阶段。

在未来,Operator的速度可以更快,轨迹可以更长,这种产品代表了OpenAI对智能体AI的野心。

他还强调,在OpenAI的整个项目组合中,平衡短期产品发布和长期研究是他工作的核心,最终确保OpenAI在商业化和科学探索之间找到最佳平衡。

Mark 对于OpenAI内部算法的提高,Chen充满信心。

在训练过程中,他指出自己的推理模型所使用的数据远远低于预训练模型,但是通过更多的计算资源来实现高效率。

因此,OpenAI在效率上并不逊色于谷歌Gemini。 竞争者如2.5。

回应开源

几天前,奥特曼在一次会议上表示,估计今年夏天开源的第一个推理模式。

在采访中,Mark Chen还透露,该公司计划发布GPT-2至今的第一个开源语言模型。

在他看来,开源模型的优势在于推理能力和开发者的提高,但由于安全措施较少,也存在滥用风险。

Chen面临着AI模型如DeepSeek的强势崛起,显得镇定自若。

在AI领域,他指出,过度反应是最大的危险。OpenAI坚信自己的路线图,专注于长期目标而非短期市场噪声。

最终,Mark 对于想要进入AI领域的年轻人,Chen也提出了建议:「熟悉所有的工具,始终保持好奇心。」。

你们玩的工具越多,越好奇,就越能理解别人试图推动的领域,以及未来的方向。您必须保持领先地位。

它是一个快速变化的行业。您所看到的许多被探索的东西,都是未来的看法。

参考资料:

https://www.techinasia.com/man-models-openais-research-chief-road-agi

https://www.youtube.com/watch?v=NNGBaiN1L77Y

https://x.com/slow_developer/status/1921248876687999153

https://x.com/jacobeffron/status/1920849638166315104

本文来自微信微信官方账号“新智元”,作者:新智元,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com