刚才,智谱一口气开源6个模型,200 tokens/秒解锁商业速率最高

就在刚刚,智谱一口气上线,开源三大类最新GLM模型:

- GLM-Z1-思维模型-Rumination

- GLM-Z1-推理模型-Air

- GLM-4底座模型-Air-0414

如果按模型尺寸(9B和32B)进行划分,则可分为六款。

第一种是2个9B大小模型:

GLM-4-9B-0414:主攻对话,序列长度在32K到128K之间。

GLM-Z1-9B-0414:主攻推理,序列长度在32K到128K之间。

还有四个32B大小模型,分别是:

GLM-4-32B-Base-0414:在32K到128K之间,底座模型的序列长度

GLM-4-32B-0414:主攻对话,序列长度在32K到128K之间。

GLM-Z1-32B-0414:主攻推理,序列长度在32K到128K之间。

GLM-Z1-32B-Rumination-0414:主攻推理,序列长度为128K

随着一系列模型的开源,智谱也解锁了一个行业中最好的——

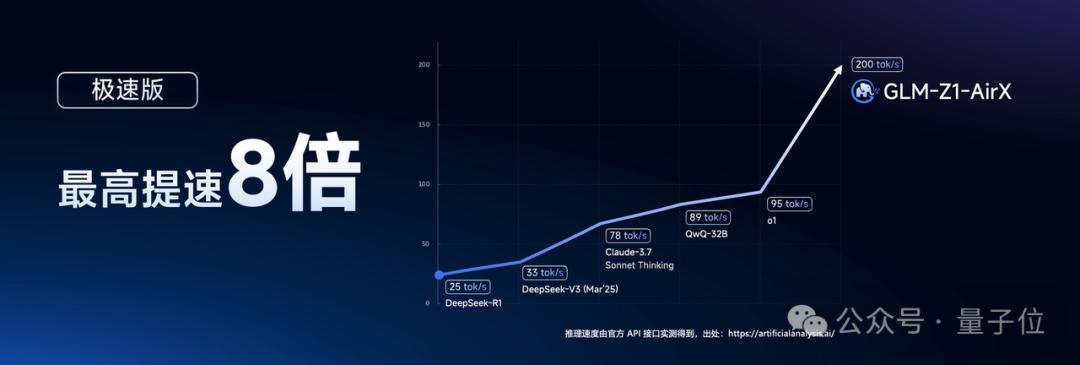

GLM-Z1-32B-0414推理模型实现了与DeepSeek-R1等顶级模型相媲美的性能,同时实测推理速度也可以达到。200 tokens/秒。

这样的速度,已经是国内商业模式中最快的了,而且性价比高的版本价格而且只有DeepSeek-R11/30。

值得注意的是,这次开源的所有模型都采用了宽松的MIT许可协议。

这就意味着上面提到的所有模型都可以免费适用于商业行为,自由分配,为开发者提供了极大的使用和开发自由。

那么这些开源模型的效果如何?

先看性能

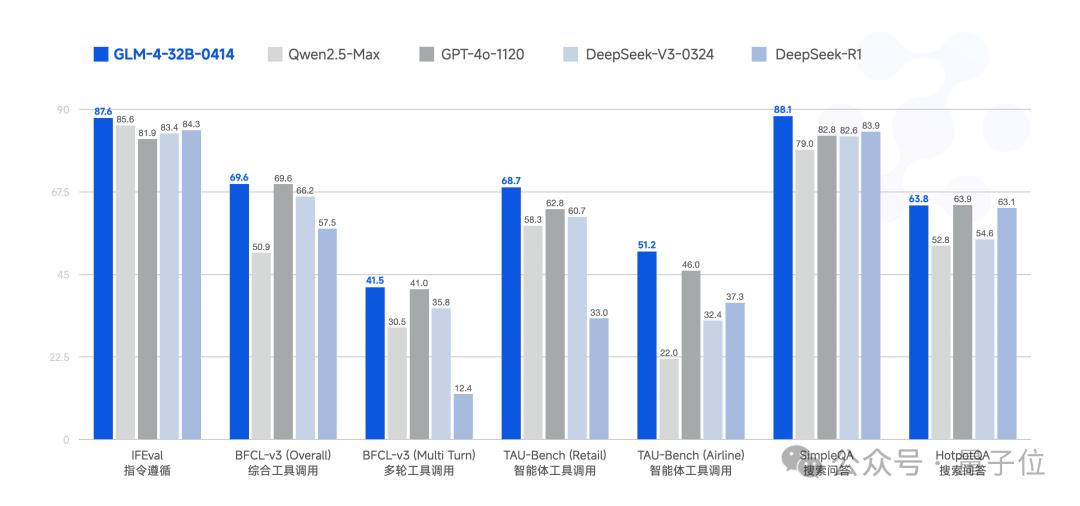

首先来看下GLM-4-32B-0414。

这是一个拥有320亿参数底座的大型模型,其性能与国内外规模相当。

据了解,该模型基于15T优质信息进行预训练,其中大量推理生成数据特别融入其中,为后续强化学习拓展提供了坚实的基础。

在后期培训阶段,智谱团队不仅完成了对话场景中人类偏好的对齐,还运用了拒绝采样、强化学习等先进技术,重点提高了模型在指令理解、工程代码生成、函数调用等关键任务上的能力,显著提高了智能体执行任务的核心素养。

实际测试表明,GLM-在项目代码编写、Artifacts生成、函数调用、搜索问答和报告撰写等多个应用领域,4-32B-0414都表现出色。

已经达到或超越部分基准测试指标。 GPT-4o、DeepSeek-更大的模型水平,如V3-0324(671B)。

就实测效果而言,GLM-4-32B-0414进一步提高了代码生成能力,可以处理和生成更复杂的单文件代码。

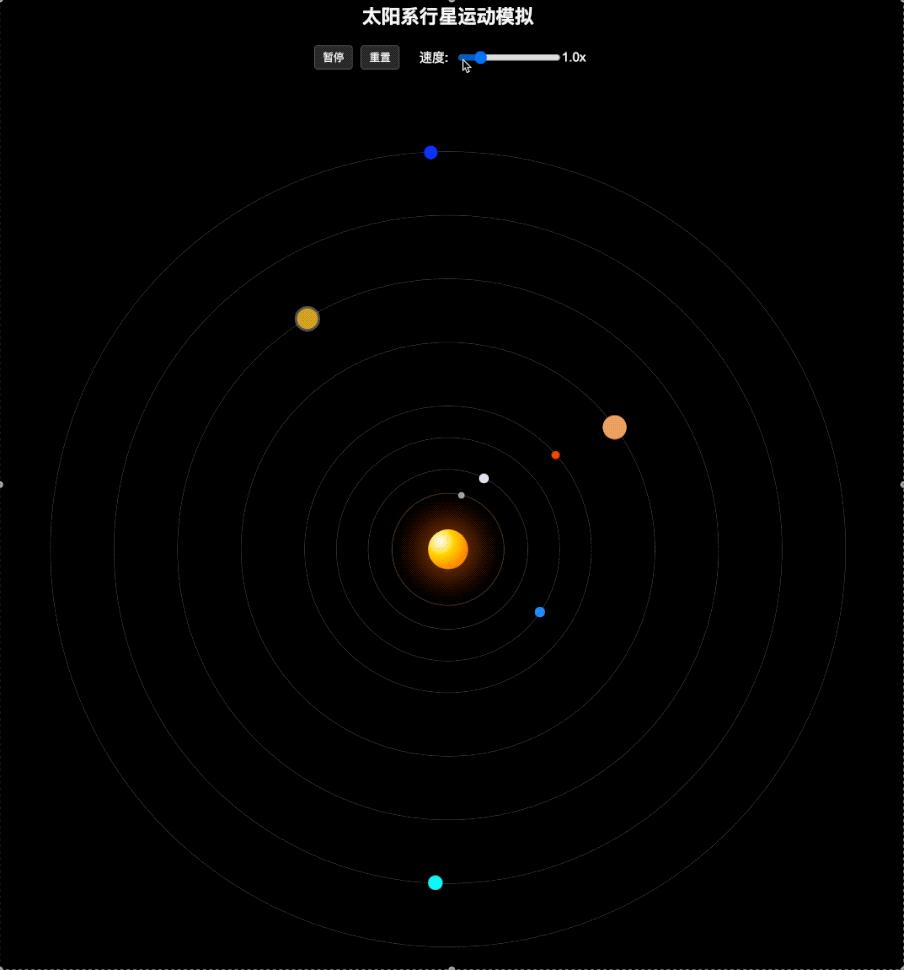

例如,整个Prompt段是这样的。:

利用HTML模拟太阳系的行星运动。

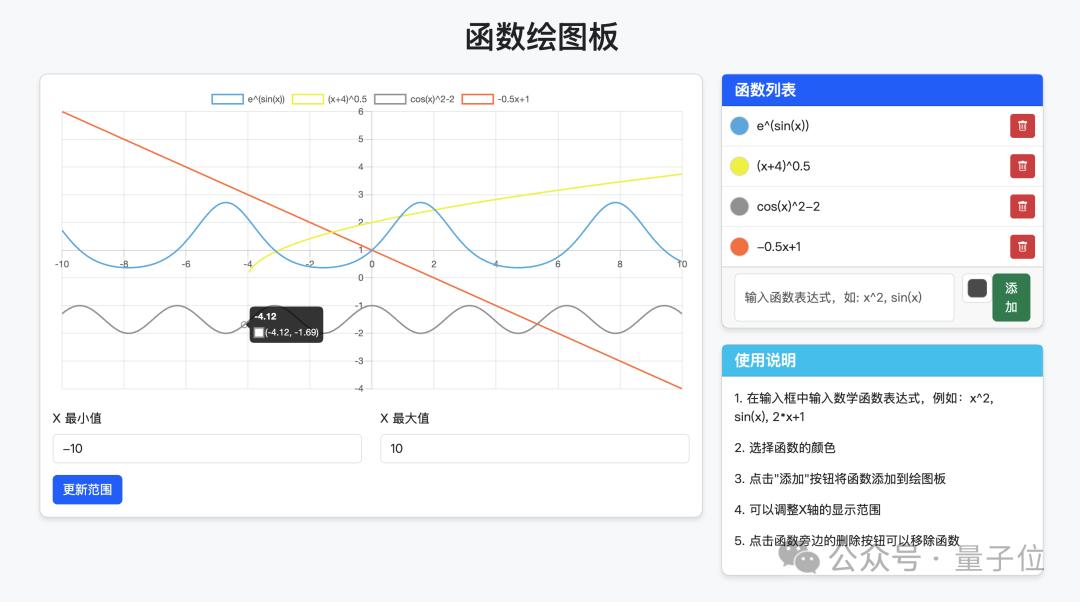

再如:

设计一个绘图板,支持定制函数绘制,可以添加和删除定制函数,并指定函数的颜色。

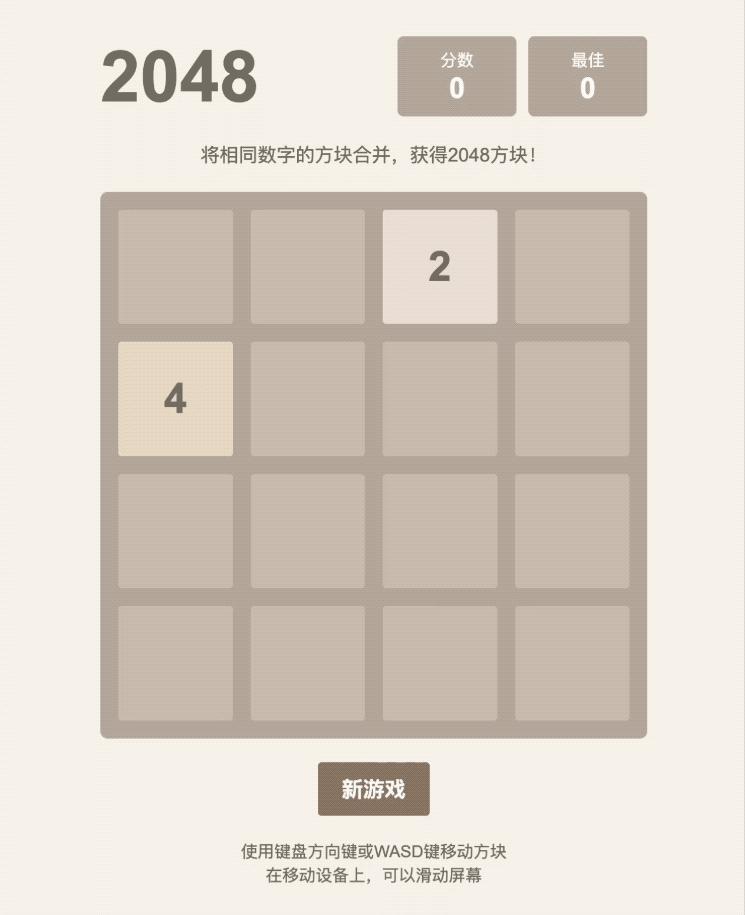

还有一个小游戏的设计也不在话下:

实现HTML网页2048游戏。

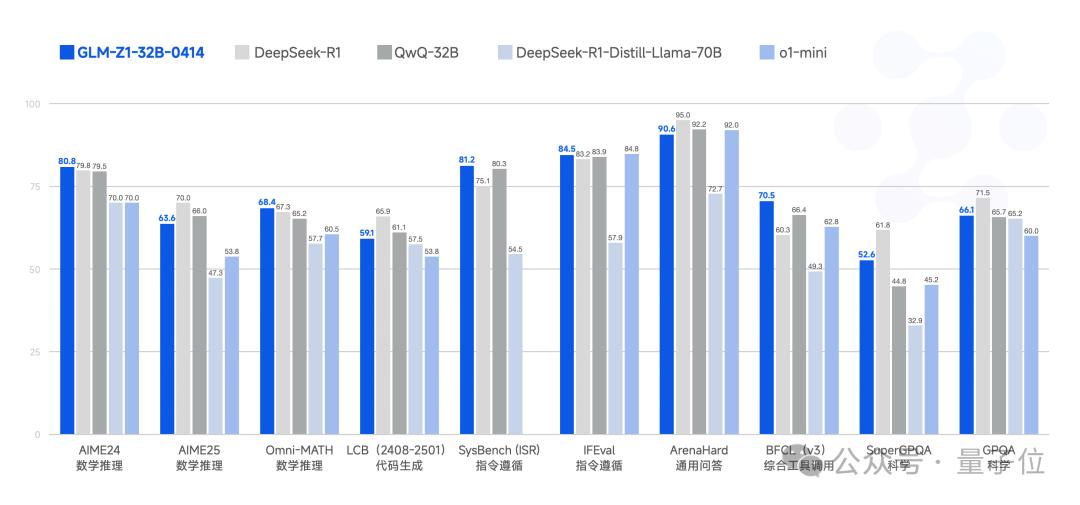

再来看下GLM-Z1-32B-0414性能,一个专门为深度推理而设计的模型。

在GLM-4-32B-0414的基础上,该模型采用了冷启动结合扩展加强学习的策略,并对数学推导、代码生成、逻辑判断等高难度任务进行了专项提升,显著提高了解决复杂问题的能力。

另外,它还通过引入基于对战排序反馈的通用强化学习。(RLHF),进一步强化了模型泛化能力。

尽管只有32B参数,GLM-在某些任务中,Z1-32B-0414的表现堪比 671B DeepSeek-R1参数。

在AIME 24/25、LiveCodeBench、在GPQA等权威基准测试中,该模型具有优异的数学推理能力,能有效地应对更广泛、更具挑战性的复杂任务。

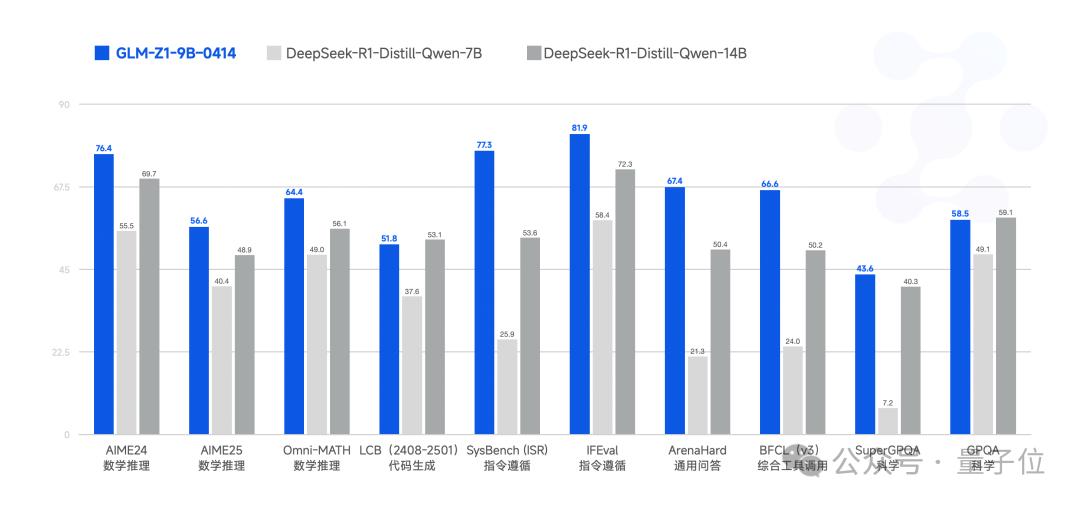

下一步,是小规模的。GLM-Z1-9B-0414,上述模型方法在技术上是沿用的。

虽然只有9B大小,但在数学推理和通用任务上表现出超越参数规模的卓越性能,综合性能稳居同量级开源模型前列。

特别值得注意的是,该模型可以在资源有限的应用场景中高效平衡计算效率和推理质量,为轻量级AI部署提供了有竞争力的解决方案。

最后,再来看看思考模型。GLM-Z1-Rumination-32B-0414。

这一模型可以算是智谱对未来AGI形态的探索。

通过多步深入的思维机制,思维模式选择与传统推理模式完全不同的工作范式,有效地应对高度开放和复杂的问题。

其核心突破体现在三个方面:

智能调用搜索工具在深度推理过程中处理复杂子任务;

创新引入多维度规则奖励系统,实现端到端强化学习的精确引导和拓展;

发现“完全支持”的问题→信息检索→逻辑分析→研究闭环系统的任务处理。

在学术写作、深度研究等需要复杂思维能力的任务中,这些技术创新显示出显著的优势。

例如,使其回答一个科学的假设推演问题:

假如人类在火星地下发现液体湖中有类似地球古菌的微生物,请推断:(1) 这种微生物可能如何适应极端环境?(2) 这个发现有哪些支持/反驳‘生命起源泛种论’的证据?(3) 设计一个可以验证这些假设的空间实验方案(预算仅限5亿美元)。

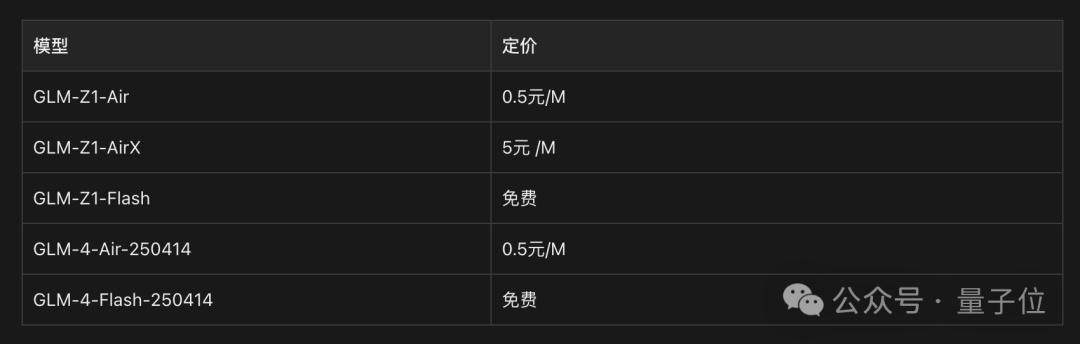

再看价格

除了模型开源,底座和推理模型也同步推出了MaaS开放平台。(bigmodel.cn),为企业和开发者提供API服务。

这次推出的底座模型提供了两个版本:GLM-4-Air-250414和GLM-4-Flash-GLM-44,250414-Flash-250414完全免费。

在线推理模型分为三个版本,各自满足不同场景的需要:

GLM-Z1-AirX(极速版):定位国内最快的推理模式,推理速度可以达到 200 tokens秒,比常规快 8 倍;

GLM-Z1-Air(性价比版):价格仅为 DeepSeek-R1 的 适用于高频调用场景的1/30;

GLM-Z1-Flash(免费版):为进一步降低模型使用门槛,支持免费使用。

为更一目了然,价目表如下:

对于配备对32B基本模型、32B推理模型、32B思维模型(裸体模型)的要求如下:

1张H100 / NVIDIA旗舰显卡A100或更先进。

4张4090/5090/3090

One More Thing

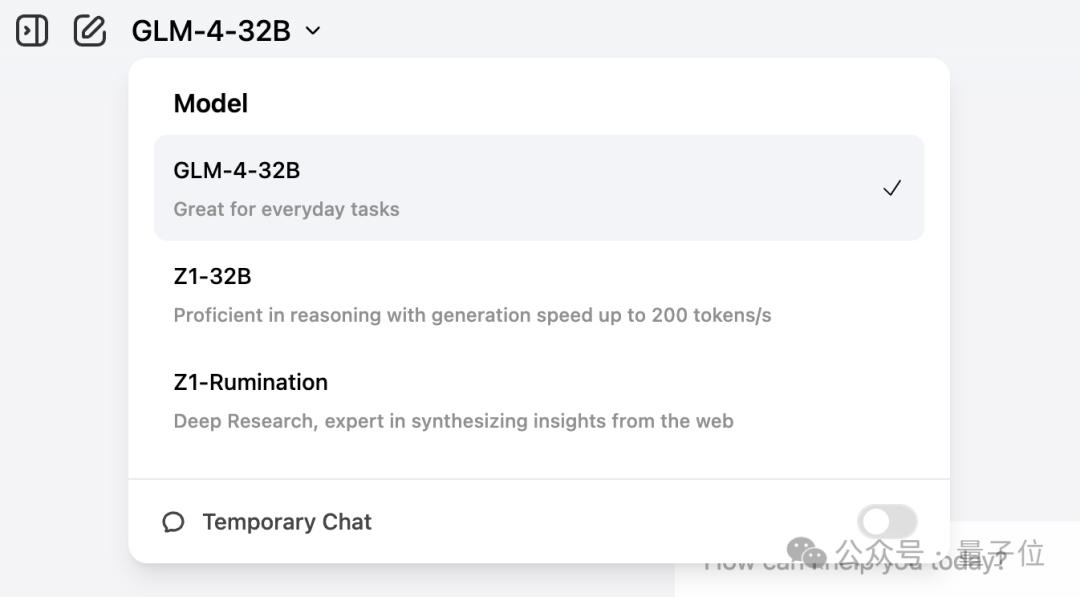

除上述内容外,智谱这次还有一个亮点动作。——

获得顶级域名Z.ai!

以下三种模式已上线:

而且官方还展示了一个更有趣的slogan。:

最后,纵观模型时代智谱的发展,不得不感受其更新迭代和开源速度。

怪不得它能成为第一个正式启动IPO流程的“大模型六骁龙”。

感受地址:z.ai

本文来自微信微信官方账号“量子位”,作者:金磊,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com