传输DeepSeek自研芯片,制造商应该降低AI成本。

电子爱好者网报道(文章 / 日前业内报道称,黄晶晶),DeepSeek ic设计人才正在被广泛招募,自主研发芯片的布局正在加快。其芯片在端侧或云侧的应用尚不清楚。许多科技巨头已经采取了自主研发芯片的行动。一方面,自主研发芯片可以节省购买芯片的成本,掌握供应链的主导权;另一方面, AI 推理应用爆发,AI 有机会重新定义推理芯片。

DeepSeek 或者不完全依赖英伟达

去年 12 月底发布的 DeepSeek-V3 模型,整个训练使用 2048 块英伟达 H800 GPU。H800 与其旗舰芯片相比,英伟达专门用于中国显卡。 H100 降低部分性能。换言之, DeepSeek-V3 模型训练不需要追求使用最尖端的训练。 GPU。

DeepSeek 多种方法用于优化硬件在训练过程中的利用效率。例如,通过绕开 CUDA 编程框架,直接使用英伟达中间指令集框架 Parallel Thread Execution ( PTX ) ,DeepSeek 能更有效地利用硬件资源,提供更粗粒度的实时控制,从而避免因为 CUDA 训练灵活性的实用性损失。这样的行为促使 DeepSeek 能在五天内完成其它模型需要十天的训练任务,大大提高了训练效率。

DeepSeek 的 V3 和 R1 许多芯片制造商都适应了大型模型。如 1 月 25 日 AMD 宣布将 DeepSeek-V3 将模型集成到其中 Instinct MI300X GPU 上。而适配 DeepSeek-R1 大型制造商包括英伟达、英特尔和国内制造商升腾、龙芯、摩尔线程、海光信息等。并且使用这些芯片获得的 DeepSeek-R1 模型推理性能不亚于英伟达达 GPU 的效果。

DeepSeek 对结构有更深的理解。如果自己开发芯片,发挥软硬件结合的能力,那么开发更划算的练习或推理芯片,进一步降低成本,可能会更大程度上促进端侧。 AI 应用爆发,推动应用爆发, AI 芯片多样化发展。

OpenAI 3nm 推理芯片

去年,OpenAI 为了提高计算资源和降低成本,进行硬件战略调整。OpenAI 将引入 AMD 的 MI300 英伟达的系列芯片,正常使用 GPU。而且自研芯片也提上了日程。去年 10 月,OpenAI 与芯片制造商博通合作开发了第一款致力于推理的人工智能芯片。为了推进这个项目,双方还在与台积电进行磋商。

根据国外媒体最新报道 OpenAI 它的第一个内部芯片设计将在未来几个月内进行,并计划将其送到台积电制造,台积电将被使用。 3nm 技术制造 OpenAI 芯片,这个芯片有望存在 2025 年底进行检测和现在 2026 2008年开始大规模生产,预计该芯片将具有“高带宽内存”和“广泛的网络功能”。

按机构计算,到达 2028 预计每年人工智能推理负荷的比例将达到 85%,考虑到云端和边缘侧的巨大推理需求,未来推理芯片的预期市场规模将是培训芯片。 4~6 倍。OpenAI 自我研究推理芯片正好赶上这波人工智能推理应用的全面爆发。

亚马逊 3nm 制程 Trainium3 芯片

实际上,为了摆脱对英伟达 GPU 依赖,亚马逊,微软和微软 Meta 等待科技巨头也逐步自主研发芯片。

去年 12 月,亚马逊 AWS 宣布,基于其内部团队的发展 AI 训练芯片 Trainium2 的 Trn2 案例普遍可用,并推出。 Trn2 UltraServer 大型 AI 训练系统,同时也发布了下一代更先进的训练系统 3nm 制程 Trainium3 芯片。

单个 Trn2 案例包括 16 颗 Trainium2 芯片,每个芯片之间选择快速高带宽低延迟 NeuronLink 互联网,可以提供 20.8 petaflops 峰值算率,适用数 B 练习和布署参数模型。

而亚马逊 AWS 下代 Trainium3 AI 训练芯片,是的 AWS 首款选用 3nm 工艺芯片产品。亚马逊表示,基于这一点。 Trainium3 的 UltraServer 性能可达 Trn2 UltraServer 的 4 倍,第一批是基于 Trainium3 这个案子有望在这里 2025 年末推出。

LPU 语言处理单元

在 AI 在推理大潮下,Groq 公司开发的语言处理单元(Language Processing Unit,即 LPU),其独特的结构,带来了极高的推理特性。

Groq 的芯片选用 14nm 工艺,搭载 230MB SRAM 为了保证内存带宽,片上内存带宽达到 80TB/s。计算率方面,芯片整形(8 位置)运算速度为 750TOPs,浮点(16 位置)运算速度为 188TFLOPs。

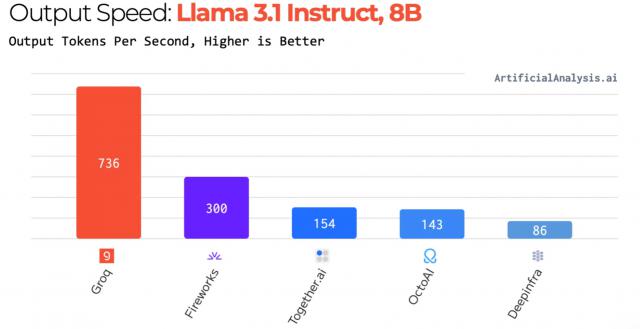

在 Llama 2-70B 在在推理任务时,LPU 该系统每秒都在进行 300 token 与英伟达达相比,吞吐量 H100 实现 10 倍性能提升,单位推理成本降低 80%。在 Llama 3.1-8B 在在推理任务时,LPU 该系统每秒进行一次 736 token 的吞吐量。

公开数据显示,LPU 运行模式和运行模式 GPU 不一样,它使用时序指令集计算机(Temporal Instruction Set Computer)架构,与 GPU 使用的 SIMD(单指令,多数据)不同。这样的设计可以让芯片不像 GPU 如此频繁地从事 HBM 内存轻载数据。并避免了 HBM 短缺问题,从而降低成本。

就能效而言,LPU 通过减少多线程管理的成本,避免核心资源的不充分利用,完成了更高的每瓦特计算性能。推理任务实施后,从外部内存读取的数据较少,耗电量低于英伟达。 GPU。

LPU 的推出为 AI 推理芯片带来了新的想法,但是必须说,Groq LPU 芯片费用比较高,主要是购卡费用和运营费用。如果用大型运行吞吐量来计算,在相同的数据环境下,Groq LPU 硬件费用昂贵。尽管这个芯片的性能很突出,但是对于成本优化还是需要付出很多努力。但愿随着硬件技术、制造和规模效应的逐步成熟,其应用成本有望提高。

DeepSeek 公司的出现,以低成本为特征,降低了公司的准入条件,使更多的企业能够进行。 AI 项目,推理端需求急剧上升。但是这还不够,要做 AI 进一步探索训练或推理成本,不再局限于选择某个家庭。 GPU,而是 SoC、ASIC、FPGA 等待芯片可以,一些新的技术架构,不依赖先进技术的芯片等等,有更多的发展空间,从而促进 AI 芯片多元化发展。

阅读更多热门文章

加关注 星标我们

把我们设为星标,不要错过每一次更新!

喜欢就奖励一个“在看”!

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com