人工智能热潮催生了“GPU即服务”

神译局是36氪旗下的编译团队,重点介绍海外新技术、新观点、新趋势,重点介绍科技、商业、职场、生活等领域。

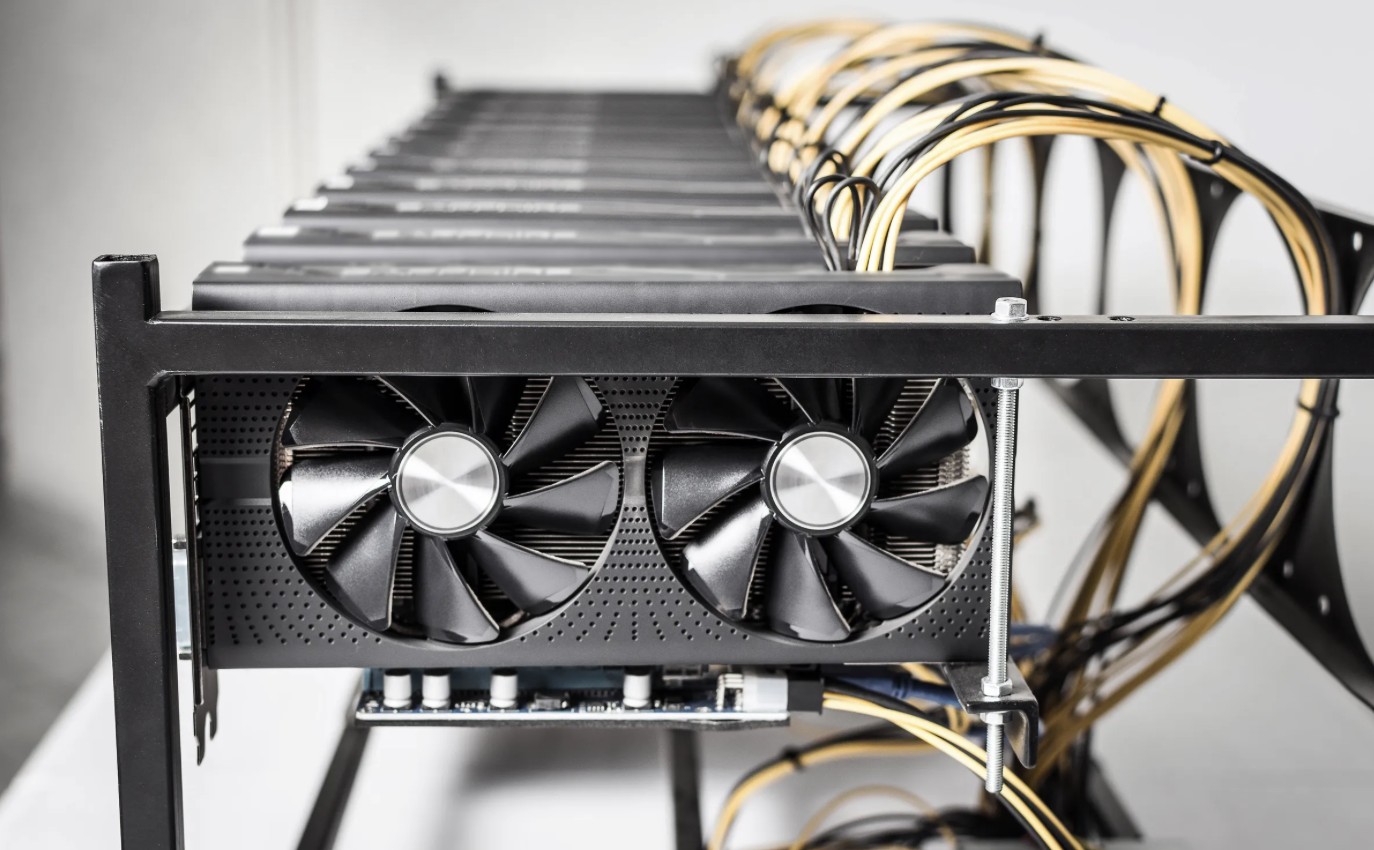

编者按:运行人工智能模型对GPU的需求很大。一批新公司正在利用现有服务器上闲置的GPU为那些需要计算能力的企业提供服务。本文来自编译,希望能启发你。

因为对运行 AI 模型需求激增,计算能力需求激增。世界各地的企业都在努力寻找更先进的运营。 AI 模型所需的 GPU。尽管 GPU 并非运行 AI 模型是唯一的选择,但它们已经成为硬件的首选,因为它们可以同时有效地处理多个操作,这是开发深度学习模型的一个关键特征。

但是并非每一家人工智能创业公司都有足够的资金投入到运行尖端模型所需的大量GPU。对于一些企业来说,外包是更好的选择。这样就引发了一种新的商业模式:GPU 即服务 (GPUaaS)。近年来,像 Hyperbolic、Kinesis、Runpod 和 Vast.ai 这类企业层出不穷,为需要计算能力的客户提供远程服务。

尽管亚马逊(Amazon)或微软(Microsoft)提供云计算服务的科技巨头有自己的基础设施,但像Kinesis这样的小型创业公司也开发了充分利用现有闲置计算的技术。

Kinesis创始人比娜•希马尼(Bina Khimani)表示。

结果表明,目前超过一半的GPU还没有使用任何给定时间。不管是个人计算机还是庞大的服务器群,都没有充分利用大量的处理能力。Kinesis所做的就是在全球服务器中识别空闲计算率(包括GPU和CPU),并将其编译成单一的计算源供公司使用。Kinesis 通过安装在其服务器上的特殊软件,与愿意销售其未使用计算能力的大学、数据中心、企业和个人合作,检查闲置的控制部件,并为客户提供临时使用。

比娜•希马尼说:“在Kinesis中,我们开发了一种技术,它可以将零散的闲置计算率集中在一起,并将其再次用于无服务器、自动管理的计算平台。”Kineesis的用户甚至可以选择他们想要的GPU或者 CPU从哪里来?

人工智能的发展速度超过了服务器的发展速度。

GPUaaS正在填补人工智能产业日益扩大的空白。由于学习模式越来越复杂,它们需要更多的功能和基础设施来更快地处理数据。也就是说,没有足够数量的GPU,大型人工智能模型就无法运行,更不用说改进了。OpenAI的首席执行官萨姆·奥特曼去年十月承认,他们面临着计算能力的限制,因此无法按预期速度发布商品。

同样,10月,微软首席财务官艾米·伍兹在一次电话会议上告诉企业投资者,对人工智能的需求“持续高于”他们的“可用容量”。

GPUaS最大的优点是经济性。通过消除物理基础设施的购买和维护需求,公司可以利用资源改善自身的深度学习、大型语言和大型视觉模型,而不是投资服务器和IT管理。客户可以支付尽可能多的GPU,从而节省了部署自己服务器产生的闲置会计成本。

像Kinesis这样的无服务器创业公司也声称对环境比传统云计算公司更友好。该公司表示,与额外的服务器供电相比,使用现有的、未使用的控制部件可以大大降低能耗。近五年来,由于人工智能消耗了大量的能源,苹果、微软等大型科技公司的碳排放量飙升。为了给他们的服务器提供可持续的动力,一些公司已经转向核能。Kinesis和其他新的创业公司提供了第三种方式,在这种方式下,不需要插入更多的服务器。

希马尼说:“所有的行业领导者都致力于可持续发展。他们可以通过关注创新和质量来优化现有的计算能力。毕竟这些计算能力已经处于活跃状态,正在消耗能量。”

随着机器学习需求的不断增加和数据消耗的不断增加,GPUaaS正在成为一个非常有利可图的技术领域。到2023年,该行业的市场规模将达到32.3亿美元;到2024年,这个数字将增加到43.1亿美元。预计到2032年,这个数字将增加到498亿美元。

希马尼说:“人工智能产业正在快速发展到下一个阶段,重点是从建立和培训模式到优化效率。越来越多的客户提出这样的问题,‘当我们训练一个新的模型时,如何才能在不消耗大量计算能源的情况下实现更有针对性的数据?’"

译者:Teresa

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com