DeepSeek再次受到攻击,本地化部署是否合适?

最近国产推理大模型DeepSeek在今年春节期间 R1非常火爆,我们经过实际测量,推理效果很好,可以算是阶段性的技术突破。

然而,每一次中国优秀的明星产品或企业崛起,总会遭到一些海外非法势力的暗中阻击。上一次《黑神话:悟空》全球上线后,遭遇了海外60个僵尸网络的大规模攻击。自DeepSeek推出以来,它也遭受了包括僵尸网络在内的多轮攻击,攻击模式一直在进化和复杂化。

由于网络有被攻击的风险,许多人都希望本地化部署DeepSeek,那么,本地化部署DeepSeek是否简单?安全问题可以在部署结束后避免吗?

DeepSeek本地化部署

随着人工智能技术的不断发展,大型模型在自然语言理解和图像识别方面取得了显著进展。传统的大型模型需要将大量数据上传到云中进行练习和inference,而本地化的部署可以通过在系统端运行预训练模型来避免敏感数据的远程传输,从而提高数据隐私保护能力。

但是,许多人对本地化部署的大模型还是比较陌生的,实际上使用起来并不复杂。

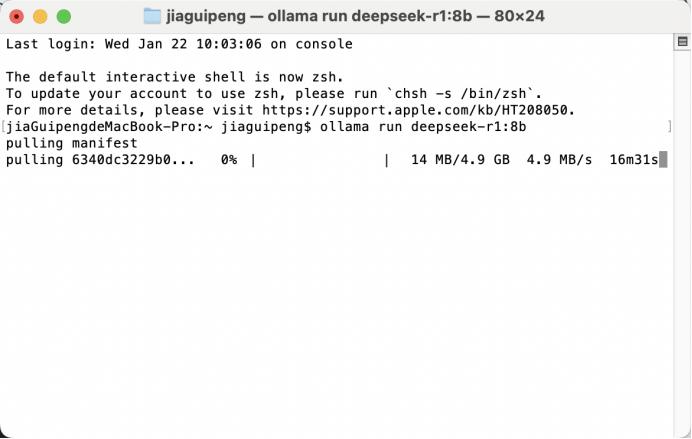

以DeepSeek为例,首先,一键下载并安装Ollama软件。网站地址https://ollama.com国内可以直接访问,支持Windows、MacOS和Linux;

第二,运行命令ollamama run deepseek-r1:8b 可以完成8BR1模型部署(自动下载,国内可以正常下载);

除了8b模型,下面的截图可以确定,不知道怎么假装理解。注意:只要看看你的显卡显示的大小,如果显示的大小足够,就可以运行。显卡的性能不是很重要,即使是老显卡1080。、2080等都有很好的效果。

弄清楚用户可以使用多少参数模型,然后再布局。浏览Ollama官方网站,搜索deepseek,找到R1模型。可选择参数较大的R1模型,我们上面的指令是运行的8B大小模型。模型参数越大,效果越好。

从那以后,Windows可以使用CMD、ollama指令Powershell运行。iTermma可以使用MacOS、Terminal。

部署结束后,客户可以在当地与DeepSeek进行交流。

另外,如果客户需要面对一些隐私场景,数据不方便上传到外部网络。通过向量数据库 RAG,建立个人知识库。支持本地和远程向量数据库,agent工具等。

就拿paper来说,上传个人知识库后,会自动embedding并存到向量数据库中,然后就可以打开聊天,查看资料等等。

值得注意的是,大模型本地化部署通常包括以下几个重要环节:

1. 模型压缩和量化:为了适应边缘设备的计算资源限制,一般采用模型压缩和量化技术。模型压缩通过删除冗余参数或优化算法来减小模型尺寸;量化通过将模型权重表示为有限的精度浮点来减少存储和计算需求。

例如,常见的压缩算法包括修剪(去除不重要的神经元连接)和知识蒸馏(将大型模型的知识转移到小型模型中),而量化方法,如 INT8 模型权重的量化可以从 32 位置浮点数量化为 8 位置整数,显著降低模型存储空间和计算量。

2. 模型固件加密:在本地化部署中,模型的核心逻辑应嵌入硬件固件,以避免恶意篡改或逆向工程。这涉及到封闭硬件开发,严格进行安全审计。

例如,使用专用指令执行环境或安全Cpu,确保程序正常执行,避免注入恶意程序。

3. 数据预处理和特征提取:本地化部署需要在设备端完成数据预处理和特征提取,这可能会暴露一些数据信息。因此,如何在保证数据隐私的前提下提取特征是一个重要的挑战。

例如,可以采用差异化隐私技术,在不影响模型性能的情况下,在数据中加入噪音,保护用户隐私。

虽然本地化部署降低了计算成本,提高了服务响应速度,但另一方面也引发了一系列新的安全问题。如何在本地化部署中保证模型的安全性和用户信息的隐私保护,已经成为当前AI研究中的一个重要课题。

大型本地化部署也存在安全问题?

如今,随着大型项目需求的不断增加,各种开源框架层出不穷。这些框架大大提高了开发效率,降低了建立AI应用的门槛,同时也打开了新的攻击面。在AI场景中,为了使大型模型能够满足各种业务需求,它通常会赋予包括代码执行在内的许多能力,这不仅带来了便利,也提供了更多攻击系统的概率。

第一,数据泄露的风险,在本地化部署中,用户信息直接暴露在设备端。如果设备没有得到充分保护,攻击者可以通过物理或网络获取用户信息。例如,攻击者可以通过网络入侵设备,利用设备的漏洞或弱密码窃取存储在本地的数据。

二是模型权重盗窃,模型的核心权重是其特性的关键。如何避免在边缘设备中盗窃或篡改权重已经成为一个重要问题。一旦权重泄露,攻击者可以轻松复制模型并恶意使用。例如,攻击者可以通过反向工程或侧信道攻击获得模型权重。

再一次是逆向工程风险,大模型的开放使得结构和参数难以完全理解。攻击者可能会通过观察模型的输出来找到潜在的漏洞或弱点,而不是引入模型的内部逻辑。例如,攻击者可以通过分析模型的输出结果来推断其内部结构和基本参数,从而找到攻击切入点。

最终是授权绑定的问题,本地化部署需要保证只允许用户或设备浏览和使用特定的模型,这涉及到如何有效地绑定模型权限和身份验证。例如,攻击者可以伪造身份认证信息,非法访问和使用模型。

我们是否无法解决上述问题?可从以下几个方面提出解决方案:

加密算法的应用:在数据预处理阶段,加密用户输入的数据,以确保数据泄露时无法有效解密。同时,加密算法应用于模型权重传输,如基于密钥的一致性加法(PAKE),保护模型权重不被盗。

例如,选择对称加密算法(例如 AES)对数据进行加密,确保数据在传输和存储过程中的安全。

安全性硬件开发:通过特殊指令执行环境或安全Cpu保护模型运行过程,将安全功能集成到硬件层面。这类硬件可以保证程序的正常执行,避免注入恶意程序。

比如,选用 Intel SGX(Software Guard Extensions)等待安全硬件技术,为模型运行提供安全的执行环境。

分离数据和模型:使用者无法接触到原始数据,即使模型权重泄露,也无法获得实际的数据信息,通过抽象和符号化数据处理。

例如,在联邦学习中选择数据分离策略,分离数据和模型,确保数据隐私。

设置分层权限:使用基于角色的密钥管理(RBAC)或者基于属性隐私保护技术,确保不同用户或设备只能浏览其授权范围内的模型和数据。

例如,通过身份认证和授权机制,为不同用户分配不同的权限,限制用户访问模型和数据。

一直以来,学术界和工业界都在积极探索本地化部署大模型的安全性。一些有代表性的技术包括基于零知识证明的量子随机数生成器用于加密和联邦学习的模型联邦和差异化方法,以及新的认证方案。

写在最后

作为人工智能发展的重要方向,本地化部署面临着许多安全挑战,但这些问题可以通过技术创新和协同研究得到有效解决。未来的研究可能会更加关注如何在模型复杂性和安全性之间找到平衡点,以及如何更好地将先进的加密算法与AI算法结合起来。

总之,本地化的部署,包括DeepSeek,给大型模型带来了更多的概率,我们需要更加努力,以确保其安全性和隐私保护能力。通过多维技术创新和严格的安全设计,我们有望在未来使本地化部署不仅安全可靠,而且充分发挥其优势。

本文来自微信微信官方账号“科技漩涡”,作者:贾桂鹏,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com