显卡可能没那么重要?中国公司给硅谷上了一堂好课。

我万万没想到,就在西方还沉浸在圣诞假期,疯狂“过年”的时候,我们中国公司在新年第二天给别人踢了一脚,让他们的头崩溃了。

上面有宇树科技的机器狗视频让大家惊呼,还有什么波士顿动力。

接着又来了一个国产大模型 DeepSeek,甚至有一股做空英伟达的味道。

具体怎么回事,我给你唠叨一下。

01

日前,DeepSeek刚刚发布了V3的最新版本,注意,自称与大洋彼岸 Open ,却越来越 Close 不同的企业产品,这个 V3 是开源的。

但开源并非他最重要的标签,DeepSeek-V3(以下简称V3)也是兼具的性能世界一流,技术实力强,价格穿透地心。三大特点,这一套不解释连招打的行业大模型厂商都有些晕头转向。

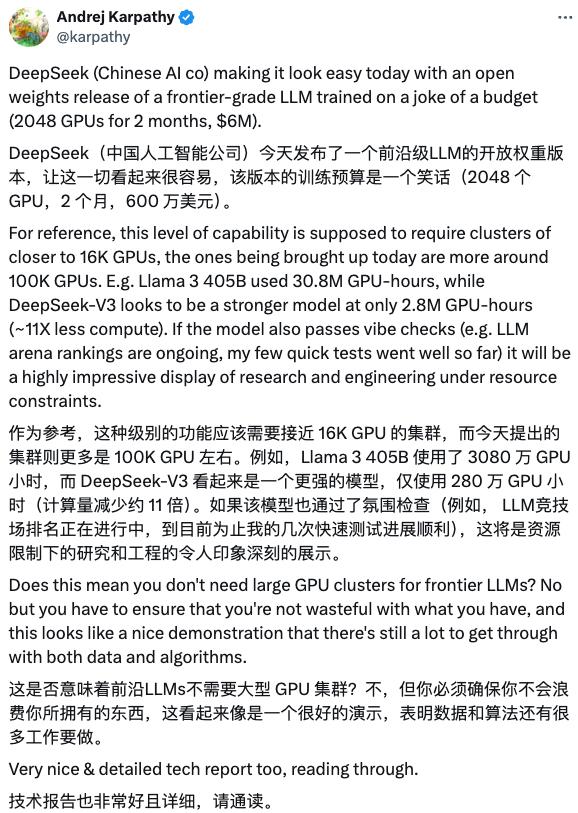

V3 一发布, OpenAI 创始成员 Karpathy 直接看嗨,甚至发出灵魂问题,大型模型不需要大型显卡集群吗??

看到这个头皮,我估计老黄会麻木的。

同时, Meta 的 AI 这位技术人员也大喊大叫DeepSeek 的成效杰出。

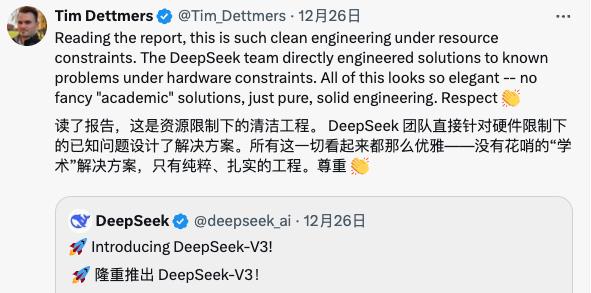

知名 AI 评测博主 Tim Dettmers ,直接吹起来,表示 DeepSeek 处理优雅”elegant”。

而且有这些技术背景的人,看着 V3 当成绩被送去表扬时,也有人着急。

比如奥特曼就搁那说,复制相对简单,很难不让人感觉到他的内涵。 DeepSeek 。

更有意思的是,做到这一点的企业既不是大工厂,也不是纯血 AI 厂商。

DeepSeek 公司的中文名字叫深度追求,它们原本和 AI 没有关系。

就在大模型爆红之前,他们事实上,私募股权机构幻方量化了一个团队。。

而且深度追求能实现弯道超车,既有点必然,又似乎有点运气。

早在 2019 2008年,幻方投资 2 1亿元搭建了自研深度学习训练平台“萤火虫一号”,到达 2021 每年都有整整一年的购买 1 万丈英伟达 A100显卡的算率储备。

要知道,此时大模型没有火,万卡集群的概念更是没有出现。

而且正是有了这部分硬件储备,幻方才得到了。 AI 大型门票,最后一卷出现。 V3 。

你们说一个好的量化投资领域的大厂,为什么要来做呢? AI 呢?

深层追寻的 CEO 在一次采访中,梁文锋与大家交谈,并非什么看中的东西。 AI 前景。

但在他们看来,“通用人工智能也许是下一件最困难的事情之一。”,对于他们来说,“这是一个怎样做的问题,而非为什么。”

正是抱着这样一股“莽”劲,深度追寻才造出了这个大新闻,下面给大家具体讲一下。 V3 还有什么特别的地方。

02

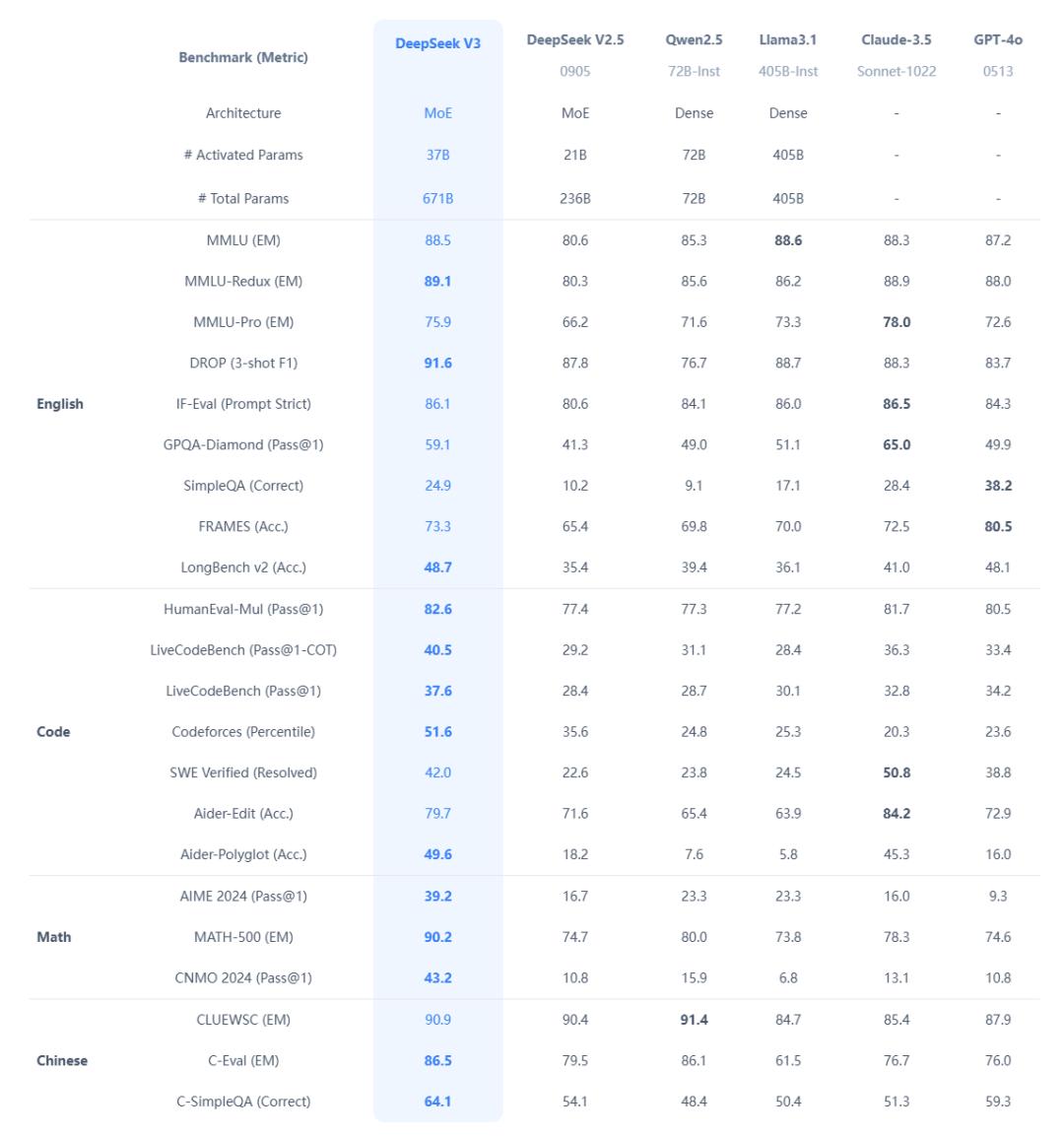

第一,性能强,现在看来, V3 在开源模型面前,几乎没有一个可以打。

还记得去年年中,小扎的Meta推出了Llama模型。 3.1,当时由于性能优异,开源,一度被捧上神坛,结果在V3手中,基本上,是全面落败。

但是在各大厂商手中的闭源模型,那些大家耳熟能详的是什么? GPT-4o 、 Claude 3.5 Sonnet 啥的, V3 还可以打得有来有回。

看着这个,也许觉得没有什么比这更好的了,也就是赶上国际领先水平,值得这样吹吗?

残忍还在后面。

大家大概都知道,现在的大模型是一个炼药过程,可以通过大量的计算率,让模型服用各种数据。

这一炼药期间,需要大量的计算能力和时间才能进入。

所以在圈子里有了一个新的计量单位“GPU “时间”,也就是用了多少块? GPU 训练需要多少小时?

GPU 时间越高,花费的时间、金钱成本就越高,反而物美价廉。

之前提到的开源模型之王, Llama 3.1 405B ,训练周期已经耗尽 3080万 GPU 时。

可以更好的性能 V3 ,只花了不到 280万 GPU 时。

以金钱换算, DeepSeek 搞出 V3 这个版本,大概只花了 超过4000万人民币。

而 Llama 3.1 405B 训练期间, Meta 只是在老黄那里买的 16000多个 GPU ,保守性估计至少要花费十几亿人民币。

对其他几个闭源模型来说,往往都是几十亿、几百亿的大撒币。

你别以为 DeepSeek 靠什么旁门左道,人家是正儿八经,有技术接近身体。

为了弄清楚 DeepSeek 技术如何?我们特意联系了语核科技创始人兼创始人。 CTO 池光辉,他们的主要发展公司。 agent 数字人,早就是 DeepSeek 的铁粉了。

池光辉告诉我们,这次V3更新主要是三个方面的改进,通讯与显存提升、平衡推理专家的负载以及混合精度FP8训练。

关于如何实现各个部分,我就不多说了。一般来说,大的整体结构没有变化,更像是我们从事基础设施建设的传统艺术能力,使项目更加高效合理。

第一,V3通过通信和显存大幅度提高,降低资源空闲率,提高使用效率。

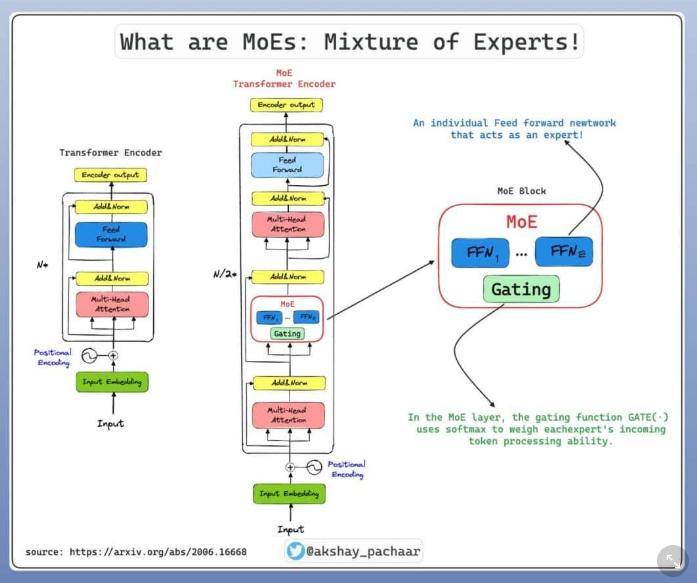

而且推理专家(有推理能力的) AI 或者系统算法,可以用大数据得出结论)的负载平衡就更巧妙了。对于一般的大模型,每次启动,所有专家都必须等比例地放入过程中(存储)。但是,在真正回答客户问题的时候,十几个专家中只使用了一两个,剩下的专家占用过程(存储)钓鱼,其他的事情都做不到。

而且DeepSeek将专家分为热门和冷门两类,热门专家,复制一份存储,处理热门问题;不受欢迎的专家不钓鱼,总能分配到问题上。。

FP8 混合精度训练是许多团队在之前尝试失败的方向上扩大的新一步。通过降低训练精度,可以降低训练时的计算费用,但答案质量基本保持不变,这是神奇的。

同时,正是这些技术创新,才得到了大模型圈的一致好评。

通过一直以来的技术更新迭代, DeepSeek 所获得的收益也相当惊人。

他们 V3 这个版本推出后,他们的价格已经是了。从几毛钱到几百万次,几块钱。

在明年之前,他们甚至开展了新的产品营销活动 2 月 8 在号码之前,在原来低价的基础上再打折。

而且一开始提到了同样的开源 Claude 3.5 Sonnet ,每个百万输入输出,至少要花费几十块钱。

更加致命的是,这一对 DeepSeek 现在已经是常规的套路了。

早在去年年初,DeepSeek V2模型发布后,靠一手低价,被人们称为AI界拼多多。

它们还在进一步发展引发了国内大型企业的价格战,比如智谱、字节、阿里、百度、腾讯等大厂商纷纷降价。

池光辉还告诉我们,他们的公司早在去年。 6 、 7 从月份开始使用 DeepSeek ,那时国内还有一些其它大型厂商来找他们。

但是价格和DeepSeek差不多,模型“又太笨了,与DeepSeek不在一个层次上。”;假如模型能力和 DeepSeek 差不多,那个价格”基本上是10倍以上”。

根据他们的创始人梁文峰所说,更夸张的是,即使DeepSeek卖得这么便宜,因为技术“遥遥领先”带来的成本降低,她们公司仍然赚钱。。。是不是有一种比亚迪在隔壁搞? 998 ,财务报告仍有红色的味道。

03

但对普通用户来说, DeepSeek 看起来也有点冷门。

由于他的优势主要在于推理、数学、代码方向,而多模式和一些娱乐领域并非他们的优势。

而且现在,虽然 DeepSeek 他们说自己还是赚钱的,但是他们的团队上下都有极客的味道,所以他们的商业化比其他厂商要弱一些。

但是无论如何, DeepSeek 成功也证明了,现在 AI 这条赛道还有更多的可能性。

按照以前的理解,想玩玩。 AI 后面没有一个金主爸爸烧钱买显卡,压根就玩不了。

但是现在看起来,掌握了算率并不一定意味着掌握了一切。

每个人都可以期待未来,更多的提升出现,让更多的小企业、初创企业都能进入。 AI 领域,差评君总觉得,那才是真正的。 AI 浪潮才对。

本文来自微信微信官方账号“差评X.PIN作者:差评君,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com