国产大模型 DeepSeek-V3 开源:6710 亿参数自研 MoE

IT 世家 12 月 27 日消息,官方微信官方账号“深度求索”昨日(12日 月 26 日本)发布博文,宣布上线并同步开源 DeepSeek-V3 模型,使用者可登录网站 chat.deepseek.com,与最新版 V3 模型对话。

IT 世家援引博文介绍,DeepSeek-V3 是一个 6710 十亿参数专家混合(MoE,利用多个专家网络将问题空间划分为同质区)模型,激活参数 370 亿,在 14.8 万亿 token 上面进行了预训练。

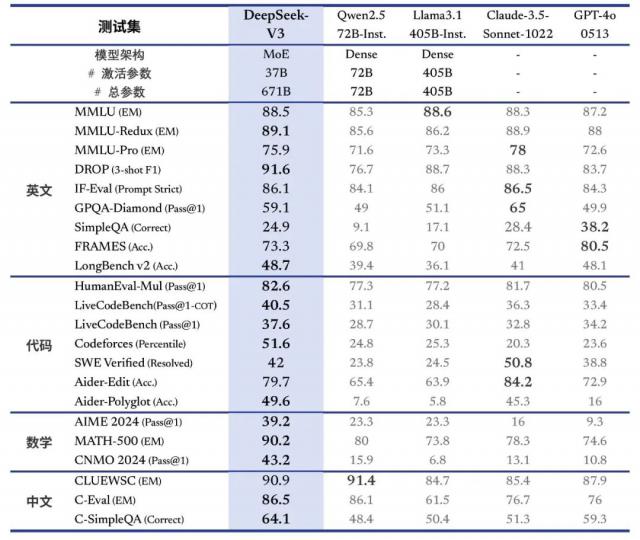

超越了多项评估结果 Qwen2.5-72B 和 Llama-3.1-405B 等待开源模型,性能比肩 GPT-4o 和 Claude-3.5-Sonnet 等待世界顶级闭源模式。

该模型在知识、长文本、代码、数学和中文方面都取得了显著的进步,尤其是在算法代码和数学方面,生成速度提高到 60 TPS,相比 V2.5 提高了 3 倍。

官方开源原生 FP8 权重,并提供 BF16 转换剧本,方便社区适应和应用。SGLang、LMDeploy、TensorRT-LLM 和 MindIE 已支持 V3 模型推理。

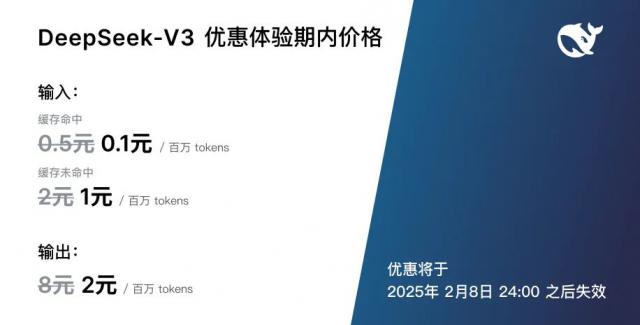

DeepSeek-V3 在更新上线的同时,DeepSeek 还调整了 API 服务价格,模型 API 服务定价也将调整到每百万输入 tokens 0.5 元(缓存命中)/ 2 元(缓存未命中),每百万导出。 tokens 8 元。

官方也决定为新模型设置接近新模型 45 天优惠价格感受期:即日起至 2025 年 2 月 8 日,DeepSeek-V3 的 API 每百万输入的服务价格仍然是大家熟悉的。 tokens 0.1 元(缓存命中)/ 1 元(缓存未命中),每百万导出。 tokens 2 元,在此期间注册的老用户和新用户均可享受上述优惠价格。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com