亿美元AI市场还能成功吗?这是12位业内人士的看法。

大型模型的发展是否已陷入瓶颈?

最近几个星期,关于这件事的争论越来越激烈。

市场信心非常重要,首席执行官迅速回应。

领导者OpenAI最早发声,Altman明确表示:没有什么事情。

接着,Anthropic的CEO Dario Amodei和英伟达的老黄,也站出来向大家保证。

然而,包括硅谷风险投资巨头Marc 有些人认为,Andreessen,这么长时间了,也没有看到什么明显的进步,表现最好的几款车型,性能也大不相同。

花儿谢了,冬天来了,又过了一年,GPT-5呢?

如果Scaling烧钱了,这关系到未来价值万亿美元的AI市场。 已经证明,Law的收益越来越少,也会影响到当前的投资周期。

包括新的创业公司,新的数据中心,新的产品,甚至新的核电厂。

因此,Business Insider采访了包括创业公司创始人、投资者、谷歌DeepMind和OpenAI在内的12位前沿人士, 探讨了追求超智能人工智能的探讨(superintelligent AI)挑战和机遇在这个过程中面临。

内幕AGI

预训难题

研究人员指出, 在人工智能开发初期(即预训练阶段),企业可能会遇到两个关键障碍。

第一个障碍是获得计算能力,具体来说就是购买显卡。

这一市场主要由芯片巨头英伟达主导, 而且英伟达在持续的高需求下面临着艰难的数钱供应挑战。

法国风险投资公司Singular的合作伙伴Henrii Tilloy说,也许你可以花5000万美元购买GPU,但是你很可能会在英伟达的供应名单上排在最后-等不起。

另外一个供应问题是训练数据。尽管每年都有更多的数据和GPU投入到大型模型中,可以可靠地生成更智能的模型, 但是企业已经耗尽了网络上公开可用的数据。

Epoch研究公司 AI预测, 到2028年,可用的文本数据可能会完全耗尽。

Clarifai的创始人兼首席执行官Matthewhew Zeiler说,因特网的规模是有限的。

多模式和私有数据

Ericcord创始人数据创始公司 Landau认为,当公共数据陷入瓶颈时,它需要其它信息来源的力量。

一个例子是多模态数据,视觉和音频信息(例如照片或播客音频) 在AI系统中输入。

「这只是增加数据的一种方式(增加更多的数据模式)。虽然实验室和公司已经开始使用,但并不是充分利用它。」。

联合创始人和CEOLamini平台 Sharon Zhou,另外一个尚未开发的领域:个人数据。

为了获得巨大的信息资源,许多公司已经与出版商签订了许可协议。

例如OpenAI和Vox Media、Stack 组织如Overflow建立了合作关系, 在自己的模型中引入受版权保护的数据。

Sharon Zhou说,「个人信息中包含了许多对模型非常有用的信号,这些信号与我们的企业用户和初创客户合作说明。」

数据质量

现在,许多研究工作都集中在提高LLM训练数据的质量上,而不仅仅是数量。

Sharon Zhou说,研究人员可以在预训练阶段进行预训练。「相对懒散的数据」,只要输入尽可能多的数据模型,看看哪些是有效的。

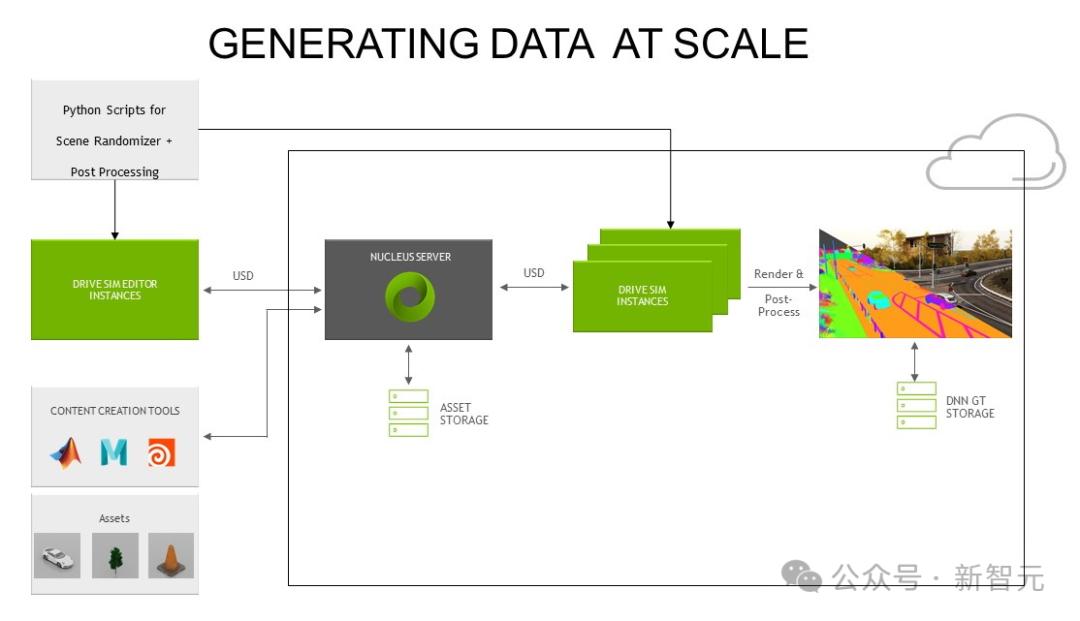

「现在这一行为已经不再完全适用,企业正在探索的解决方案之一就是生成数据。」

Aindo,初创公司 Danieleleleai的首席执行官 Panfilo也认为,生成数据可能是「强大的提高数据质量的工具」,因为它可以「协助研究人员建立符合其详细信息需求的数据集」,这个阶段是AI开发的后训练阶段(post-training)特别有用。

一位前谷歌DeepMind员工透露,Gemini已经改变了战略,从追求规模到追求效率。

「在我看来,他们意识到这样一个庞大的服务模式实际上是非常昂贵的,所以通过后面的训练来适应下游的专业任务是更正确的选择。」 从理论上讲,生成数据是提高模型认知水平的有效途径, 使其更简洁、更高效。

但是,在实际应用中,对于生成数据在提高模型智能方面的有效性,并没有达成共识。

Hugging ThomassFace的创始人 Wolf说,「通过生成数据Cosmopedia,我们发现它在很多方面确实有帮助,但它不是处理数据问题的神丹妙药。」。

首席AI科学家Jonathannathanabricks Frankle还认为,在生成数据方面没有什么?「免费午餐」,并指出 「如果没有人类的监督,没有过滤和判断最相关的生成数据的过程,那么模型所做的就是重复他们的行为。」。

建立推理模型

仅仅关注训练部分是不够的。

Ilya,前OpenAI首席科学家,表达了Scaling的预训练模型。 Law已停滞不前的担忧,「每个人都在寻找下一个突破。」

当前,业界越来越关注转变为推理模型。(reasoning model)。这个月的微软Ignite活动,CEOSatya Nadella宣布,

Scaling Law没有遇到瓶颈,新的范式已经出现,那就是test。-time compute。

——在面对复杂的客户提醒时,允许模型花费更长的时间来做出反应。

比如Copilot推出的新功能:「think harder」,更难的问题可以通过延长时间来解决。

Ai创业公司Agemo创始人Aymeric Zhuo说,推理(reasoning) 「它一直是一个积极的研究领域。」,特别是在「行业面临数据壁垒」的情况下。

Sivesh来自投资公司Balderton。 Sukumar还说,「考虑到人脑的工作方式,即使是最聪明的人也需要时间来找出解决问题的办法。」

OpenAI于9月发布了新的推理模式o1。

「按照第一个原则进行推理」这并不是LLM的强项,因为它是基于LLM的。「下一个单词的统计概率」来工作吧。但是,如果我们希望LLM能够思考和解决新的问题,我们必须让他们进行推理。

OpenAI研究员Noam 上个月的TEDBrown AI演讲指出:「结果表明,让一个机器人在扑克游戏中思考20秒的效果,与同时将模型规模和训练时间扩大100,000倍相同。」

将来预期

前DeepMind员工表示,「行业可能需要适应缓慢的进步步伐。我们经历了一个疯狂的阶段,模型进步很快。这种情况是基于 以前从来没有出现过。今年的进步速度没有那么快,但是这并不意味着瓶颈。」

LaminiSharon Zhou同意这一点。她指出,规模法则是基于对数尺度而非线性尺度。也就是说,AI的进步应该被视为一条曲线, 并非图表上的一条直线。它使开发成本远远高于我们对这项技术下一次实质性进展的预期。

「这就是为什么我们的期望在我们想要的时间框架下无法实现,也是为什么当我们的能力真正出现时,我们会感到惊讶。」 所以,投资者和客户是否愿意等待?

参考资料:

https://www.businessinsider.com/generative-ai-wall-scaling-laws-training-data-chatgpt-gemini-claude-2024-11

本文来自微信公众号“新智元”,作者:新智元,编辑:alan,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com