让AGI惠及全人类的愿景是谎言?OpenAI核心人员再次辞职

政策研究部门的核心人员辞职!

Rosie Campbell-OpenAI政策研究员,Miles也是原研究科学家,政策研究负责人 亲密合作伙伴Brundage。

再一次呼吁人工智能企业重视AGI造福人类的愿景!

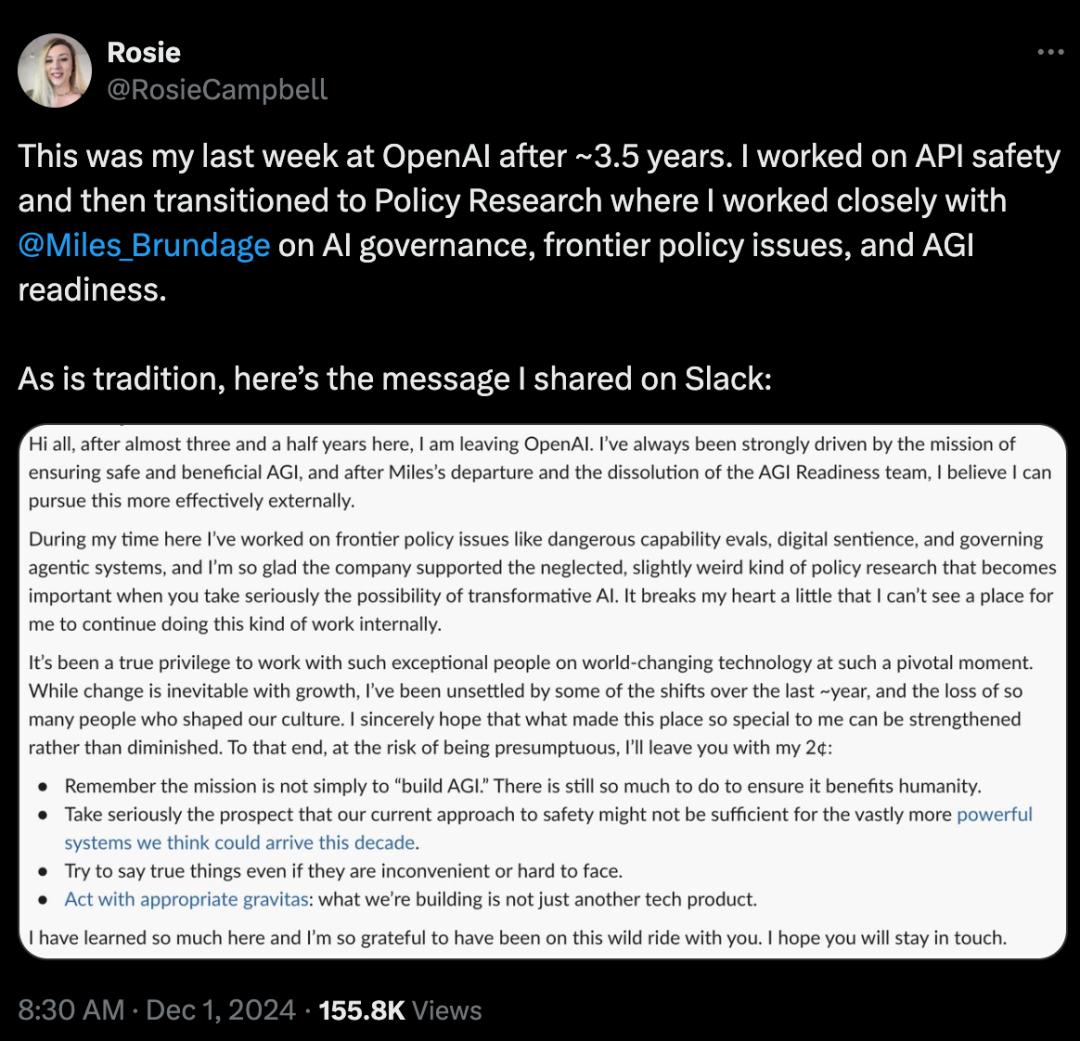

在X上,她说:“这是我在OpenAI工作了大约3.5年后的最后一个星期。首先,我API安全工作工作,然后转向政策研究部门,在那里我和@Miles与Brundage密切合作,共同研究人工智能治理、前沿政策和通用人工智能(AGI)准备工作。”

全文翻译:

大家好,在这里工作了将近三年半之后,我就要离开OpenAI了。

我一直深受通用人工智能确保安全和有益。(AGI)使命驱动,但是在Miles辞职和AGI准备团队解散之后,我相信我能更有效地追求这个目标。

在这里工作的时候,我处理了一些前沿的政策问题,比如危险的能力评估、数字概念和管理代理系统。我很高兴企业支持那些被忽视的、有点奇怪的政策研究,这些研究在仔细考虑变化AI的概率时变得重要。

有一点让我心碎的是,我看不到一个地方让我在内部继续做这种工作。

在这样一个关键时刻,与这样一位杰出的人一起从事改变世界的技术工作,真是我的荣幸。

在成长过程中,变化是不可避免的,但是过去一年左右的一些变化让我感到不安,许多塑造我们文化的人离开了。

对于我来说,我真诚地希望这个地方这么特别的东西能被加强而不是被削弱。

所以,面对冒昧的危险,我想留下我的建议:

请记住,我们的使命不仅仅是“构建AGI”。还有许多事情要做,以确保它对人类有益。仔细考虑我们现在的安全方法可能不足以应对我们认为这十年可能会出现的系统,而且能力要大得多。

尽量说实话,即使这些话不方便或难以面对。

以适当的严肃态度做事:我们正在建立的不只是另一种技术产品。

我在这里学到了很多,我很感激能够和你一起经历这段疯狂的旅程。但愿你们能保持联系。

回首10月至11月,OpenAI两名安全相关人员辞职。

Miles 2018年,Brundage加入OpenAI,担任研究科学家、政策研究负责人、高级AGI顾问等关键职位,并于今年10月底离开OpenAI。

在OpenAI工作中,MilesBrundage主要集中在保证OpenAI的商品上。可以安全、可靠地安排使用。

Red领导了外部红队计划 teaming,检测OpenAI AI系统的安全性和鲁棒性,促进了“系统卡”报告的创建。

还积极参与AI进度评估、AI安全管理、AI经济影响、加快AI应用推进等相关研究。,并提出了“AI战略”的概念。

当他离开OpenAI时,他说,作为一名非营利部门的研究人员和倡导者,他将有更多的自由发布能力。

在离职后,MilesBrundage发表了一篇长文,表示对此。“全球高效管理人工智能和AGI能力的准备状态(包括管控 OpenAI “与其它企业)”非常重要,并希望在这个领域发挥更大的作用。

Lilian Weng,十一月十五日离开OpenAI,担任OpenAI安全研究副总裁和后来的安全系统团队负责人。

在OpenAI工作的7年里,LilianWeng负责与领导者建立一个安全系统团队,致力于处理人工智能安全的关键问题,包括避免当前AI模型使用不当等挑战。

对于OpenAI未来的安全战略,她的辞职被业界观察者视为一种潜在的考验。

她曾提及,自GPT-4发布以来,她被指定重新评估OpenAI安全系统的任务,但是为了有更多的时间写技术博客,她选择辞职,并且可以更有效地促进公司外部AI安全与伦理的研究。

这一决定也引起了业界对OpenAI内部战略方向和安全文化建设的广泛讨论。

而且就在昨天(美东时间星期五),与OpenAI诉讼纠纷不断的马斯克,也再次提出了新的要求。

XAI法律团队马斯克及其人工智能公司再次向美国联邦法院提交申请,要求法院发布初步禁令,以防止法院发布初步禁令。OpenAI已经从一个非营利组织转变为一个完全盈利的公司。

此外,他们还要求法院禁止OpenAI限制其投资者向包括xAI在内的竞争对手提供资金支持

不难看出,就像从业者一样,对人工智能的安全担忧丛丛,对商业和技术难以平衡感到不安。

通用人工智能安全有益。(AGI)?

所有人工智能相关机构、公司、公司都在谈论AGI。

"会从用户价值出发... 将推动AGI…以普惠为使命…以人类进步、科技发展为愿景…

因此,除了技术追求,有多少公司真正面对问题:保证安全和有益的通用人工智能?(AGI)发展”呢?

让我们简单解释一下为什么一般人工智能需要直接面对和坚持安全和有益。(AGI)。

第一,技术失控问题,AGI可能具有超出人类控制能力的风险和不可预测的后果。

二是应考虑人工智能的发展。伦理道德问题,比如决策的透明度、偏见和歧视,以及对隐私的影响。

三是责任问题,人工智能系统的复杂性增加,到那时再来确定谁对人工智能的行为和决策负责变得更加困难。

第四,人工智能可能对就业环境、社会结构和经济产生深远的影响,包括职业自动化和收入不平等的加剧。

五是要制定和实施有效的政策和法规来管理人工智能的发展,以确保其对社会的积极影响。

第六人类福祉和可持续发展,核心目标必须是确保人工智能的发展能提高人类的福祉,而不仅仅是追求技术进步。

第七……

随着越来越多的人离开OpenAI,他们被抛出。人工智能安全警告而且越来越多。

作为一家在科技发展中发挥重要作用的公司,特别是在人工智能等前沿领域,每一步的发展都需要格外谨慎。

最初的愿景还在吗?

技术的发展和如何平衡你所在世界带来的风险?

值得每个人思考。

本文来自微信公众号“亿欧网”(ID:i-yiou),作家:不寒而栗,编辑:刘欢,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com