OpenAI大逃亡,AGI安全团队半数离开,奥特曼:熙熙攘攘之外必须先安内。

尽管不断地招贤纳士,但仍然无法阻止OpenAI的安全团队。「集体出走」。一半的员工已经离职,公司处于舆论漩涡之中,而奥特曼则选择在这个时候对内部人员进行安全监控。

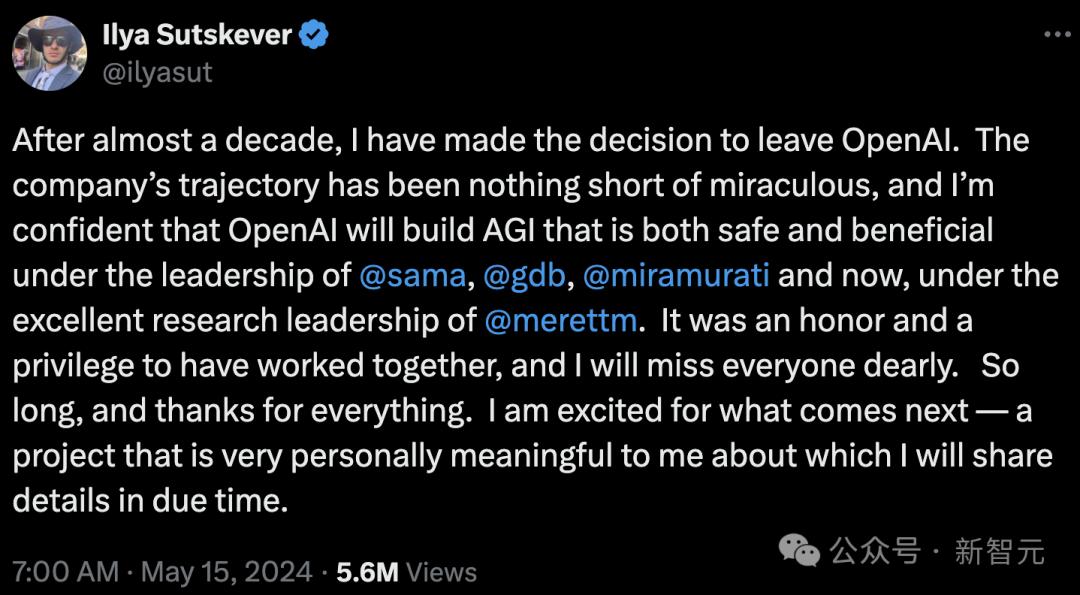

安全团队负责人Ilya今年5月发布会后 Kever和SutsJan Leike曾经前后脚在推特上宣布辞职。

Jannthropic的加入 Leike公开指责OpenAI对AI安全没有足够的重视。 ,「安全性文化和流程已经让位于闪亮之中的商品」。

奥特曼曾承诺的20%的计算资源迟迟不到位,使他的团队始终保持在原地。「逆风出航」。

Ilya和Jan OpenAI宣布了Leike的辞职。「非常对齐」正式解散团队。

在过去的几个月里,关于OpenAI安全团队的人事新闻一直在持续,包括雇佣前陆军上的Paul。 M. Nakasone,ZicooCMU教授 在董事会新成立的安全保障委员会担任Kolter,以及新成立的安全保障委员会「打包」挖掘AI安全公司Indent。

各种招贤纳士的举动,令人好奇,奥特曼是否真的真的?「良心未泯」、仍然关注AI安全,或者只是为了平息两位大佬离职后全网的指责。

在如此多的「大动作」下面,OpenAI安全团队的现状到底是什么?

最近,前OpenAI研究员Daniel Kokotajlo接受了《财富》杂志的独家采访。他指出,情况并不乐观,近一半的原AGI安全团队员工已经辞职。

由于一些研究人员担心AGI可能会逃离人类的控制,威胁人类的生存,自成立以来,OpenAI雇佣了大量的研究人员,致力于「AI安全」领域。

据Kokotajlo介绍,这支队伍最近因为离职而急剧下降,包括OpenAI联合创始人、ChatGPT架构师John Schulman和Scaling Jeffrey是Law共同作者之一。 Wu。

John Anthropic已经加入了Schulman。 ,Jeff Wu的领英显示,他七月份已经离职,目前还没有透露去向。

另外,离职者还包括下列员工:

- Jonathan Uesato,GPT-在DeepMinddind中,4o的关键推动者之一 Gemini团队工作

- Jan Hendrik Kirchner,GPT-四是技术报告的共同作者之一,已于8月加入Anthropic。

- Yuri Burda,已经在OpenAI工作了8年,今年7月之后辞职并加入了Anthropic。

- Todor Markov,GPT-OpenAI已经在OpenAI工作了将近6年,今年6月辞职。

- Steven Bills,曾经参与ChatGPT的研发,已经加入了Anthropic

Kokotajlo本人是一名哲学博士生,2022年加入OpenAI担任治理研究员,并于4月离职,因为他在公司。「建立一个通用人工智能系统的负责任行为失去了信心。」

在一次采访中,他说,2024年出现了缓慢而稳定的离职浪潮。大约有30名AI安全员工,现在只剩下大约16名员工。

「(离职潮)并非一件协调的事,我认为只是大家从个人角度放弃而已。」

辞职背后的意义可能不仅仅是科技公司常见的跳槽。这可能表明,OpenAI对技术风险的谨慎程度正在逐渐下降,奥特曼主导的盈利动机可能会导致危险行为。

根据The 根据Information之前的披露,OpenAI还没有实现收入支出,2024年净亏损可能达到50亿美元。所以,奥特曼强大的盈利动机也是情有可原的。

在今年六月的一份报告中,纽约时报还提到,Kokotajlo认为科技巨头开发AGI的竞争是鲁莽的。

他担心,「OpenAI将不顾一切地向前推进,合理化我们的行动。」,但「这个世界还没准备好,我们还没准备好。」。

OpenAI是什么时候开始改变的?对Kokotajlo来说,事情也可以追溯到去年11月的那个时候。「宫斗」。

奥特曼作为首席执行官被解雇后迅速复工;随后,股东大会上三名致力于AGI安全的成员被替换。

「这件事就是落下帷幕。之后就没有回头路了。」

Kokotajlo还补充说,虽然他无法接触到背后发生的事情,但他觉得从那以后,奥特曼和Greg总裁最近请了长假休息。 一直以来,Brockman「巩固权力」。

「关注AGI安全和准备工作的人越来越边缘化...从某种意义上说,这背叛了我们在2022年制定的计划。」

即便如此,Kokotajlo也不后悔第一次加入OpenAI,只是后悔自己走得太晚:「在那儿我学到了许多有用的东西,我觉得自己可能会产生积极的影响。」

现在,Kokotajlo也有朋友留在OpenAI继续从事与AGI安全相关的工作。

但是对那些留在公司的人来说,Kokotajlo警告说,在科技巨头竞相开发AGI的过程中,应该避免「群体思维」,即所谓的「合理」这一观点取决于大多数人的观点和公司高层建立的激励机制。

正因为如此,大多数科技公司都会认为,获得AGI比赛会让人类受益。它看起来很荒谬,但却是激励机制的结果。

OpenAI正在招聘内部人员进行调查。

就在「离职潮」在进行过程中,Business 为了应对内部人员,Insider又爆出了一条猛料-OpenAI开始对内部人员进行监控。「内部安全威胁」。

近日,他们发布了一条招聘信息,寻找一名技术内部风险调查员,以便在技术上进行内部风险调查。「加强组织对内部安全威胁的防御」。

根据招聘信息,工作职责包括分析异常活动、检测和减少内部威胁,并与人力资源局法律部门合作「调查异常活动」。

如今,OpenAI正处于AI安全的风口浪尖,内部人员和立法者都表示担忧,质疑公司是否采取了足够的措施,以确保其技术不会受到伤害。

与此同时,OpenAI表示,发现一些国家的相关行为者试图使用自己的AI模型进行恶意行为。OpenAI表示,这些行为已经中断,相关方的账户已经终止。

据《纽约时报》2023年报道,一些黑客攻击了OpenAI内部的新闻系统,并窃取了关于AI技术设计的保密信息。该公司的高管在去年4月的所有会议上都向员工透露了这件事。

除了黑客组织,这个招聘信息似乎说明OpenAI也担心内部人员的威胁,虽然不清楚这是什么形式的威胁。

有一种可能,OpenAI只是为了保护与技术相关的商业秘密。

根据招聘信息,内部风险调查员是OpenAI向白宫制作的。「自愿承诺AI安全」一部分,也就是投资「内部威胁保护措施,确保模型专有权和未发布权重。」

在去年6月的一封公开信中,现任和前任OpenAI员工表示,他们在表达对AI安全的担忧时感到受到阻碍。信中呼吁 OpenAI保证了公众对其商品的危险性「警告权」。

风险调查人员负责实施尚不清楚。「防护控制内容丢失」这种类型的员工告密行为是否包含在内。

参考资料

https://fortune.com/2024/08/26/openai-agi-safety-researchers-exodus/

https://www.businessinsider.com/openai-is-hiring-someone-to-investigate-its-own-employees-2024-8

本文来自微信微信官方账号“新智元”,作者:新智元,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com