Meta的Llama 三是合成数据训练?数据荒了解一下

如今,一场席卷人工智能圈的“石油危机”已经出现。几乎每个AI厂商都在努力寻找新的语料来源,但无论数据多少,似乎都无法满足AI大模型的胃口。此外,越来越多的内容平台意识到手中数据的价值,并开始珍惜自己。因此,“生成数据”已经成为整个AI行业探索的新方向。

然而,在相当长的一段时间内,生成数据是否可用还不得而知,直到最近Meta的AI研究员Thomas 根据他的说法,Scialom博士给出了这个问题的答案。Llama 3开源模型在训练中并不依赖于任何人类写的答案,而是完全基于Llama。 二是合成数据的生成。

Thomas Llamamamam介绍了Scialom 3在练习细节中,提到了生成数据在模型中不同场景的应用,如代码执行反馈、编程语言翻译、文档反向翻译、长文本问答、长文档摘要、代码库推理等。而且,这也解释了今年春天Meta推出的Llama。 3个模型的规模如何超过4000亿参数,并且是Llamama的7倍 练习信息量2。

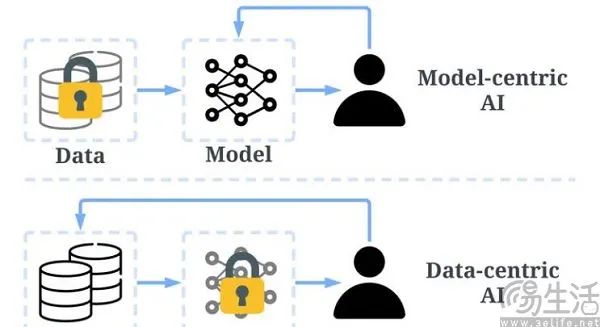

一般来说,生成数据是指通过算法模仿真实世界数据的特征来产生新的数据。那么如何实现这种“左脚踩右脚上天”的操作呢?Meta和微软相关团队公布的两篇论文,可以揭示使用生成数据训练大模型的秘密。其中,Meta将使用生成数据练习的大模型称为“自我奖励语言模型”,即大模型本身生成训练数据,并对这些数据的质量进行评估,然后使用这些信息来训练自己。

事实上,自我奖励语言模型就是所谓的AI反馈强化学习。(RLAIF)对于应用程序,Meta的具体操作首先要根据少量的人工标注数据训练一个初始模型,然后让初始模型根据问题生成多个替代回复,并使用吴恩达博士提出的LLM。-as-a-Judge方法,让大语言模型对自己产生的回应分数进行评分,并根据分数生成新的训练数据,然后继续训练模型。

在这个过程中,最重要的是让大模型能够按照例子生成和评估新的指令,然后添加到自己的训练集中。由于计算机使用的二进制语言不同于人类语言,研究人员需要将人类语言转化为计算机可以理解的方式,这就是所谓的“文本嵌入”。举例来说,微软的研究小组通过定义一系列的文本嵌入任务,并为这些任务提供特定的提示,从而引导大语言模型生成特定的数据。

研究人员建立的具体提醒将包括两个核心要素,即问题和角色,然后进行排列和组合。比如中小学的题目可以通过司机和数学题目的结合来生成,引导大语言模型从相应的角度生成数据,这就是自我奖励语言模型的秘诀。然后研究人员只需要清理和格式化生成的数据,去除重复的内容和调整的格式错误,以确保它们符合训练的需要。

生成数据的优点是可以在数学和物理意义上反映真实数据的属性,而且由于不需要人工标注,数据收集的运行过程和人为标准不一致造成的人为偏差也大大减少。那么问题来了。既然生成的数据可以成为处理训练数据稀缺和衍生的高成本问题,为什么大量的AI厂商还是专注于挖掘或购买人类生成的数据?

最重要的原因是,虽然使用了精心设计的prompt和监督训练,但大语言模型中固有的误差和幻觉仍然可能引入数据噪音,但基于生成数据的错误、幻觉或偏见训练的大语言模型将无法泛化到现实世界。基于生成数据的大语言模型需要避免被机器学习“污染”,而培训数据中生成数据的比例越大,自然语言理解能力就越难提高。

比如斯坦福教授Percy Liang指出,生成数据缺乏宝贵的“人性”,以至于基于生成数据训练的大模型不足以达到AGI。更重要的是,生成数据可以用来验证或扩展人类已经存在的行业,但很难揭示初始数据集中不存在的领域。它的边界是初始数据集的边界。

所以,Meta是基于Llama Llamamama生成的合成数据训练 理论上有一定的可能性,但他们没有告诉你这个过程需要多少人力和时间。虽然生成数据确实比真实数据便宜,但不合格的生成数据需要投入多少成本还不得而知。

如果生成的数据在各个方面真的比真实的数据便宜,即使出现幻觉和AI伦理的问题,各大AI厂商也没有理由继续关注人类生成的数据。

本文来自微信微信官方账号“三易生活”(ID:IT-作者:三易菌,36氪经授权发布,3eLife)。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com