苹果开源7B大模型,训练过程数据一口气全部给出,网友:不像苹果那样开放。

一水 发自 凹非寺

量子位 | 公众号 QbitAI

与其他公司相比,苹果最近进入了开源大模型战场。

推出7B模型,不仅有Llama的效果 3 相当于8B,所有的训练过程和资源都是一次性开源的。

要知道,不久前Nature杂志编辑Elizabeth Gibney还发表了一份指责:

许多声称开源的AI模型,实际上在数据和训练方法上并不透明,无法满足真正的科学研究需要。

而且苹果这次居然来了!!

甚至NLP科学家、AutoAWQ创建者也惊叹不已:

一个战胜Mistrale的Apple发布了 7B模型,但更好的是它们完全开源了所有的内容,包括预训练数据集!

还吸引了网友在线调侃:

一些热心的网友也帮助总结了这次开源的意义:

对任何想要重新开始训练模型或微调当前模型的人来说,都必须探索数据管理过程。

上个星期,除了OpenAI和苹果,Mistral AI联合英伟达还发布了12B参数小模型。

HuggingFace创始人说,「小模型周」来了!

卷起来!继续卷起来!所以苹果这次发布的小模型究竟有多少可以玩?

效果直追Llama 3 8B

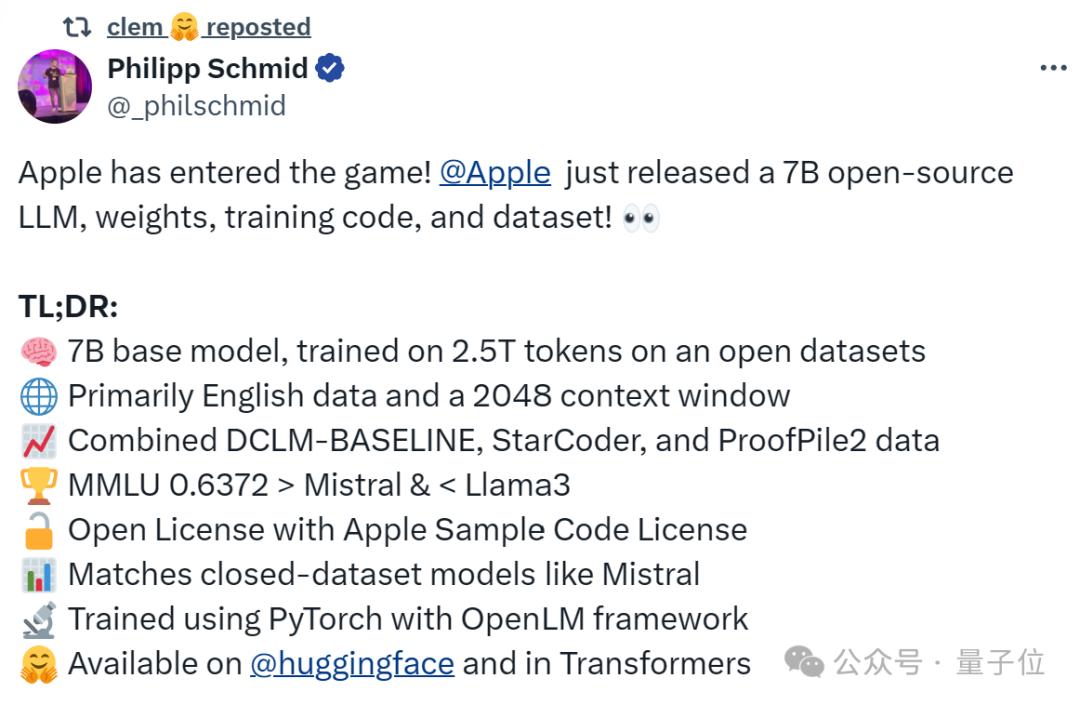

先不说能打多少,先来看看Hugging。 Face技术总监刚刚“拆箱”模型的基本设备。

总而言之就是:

开放数据集中使用7B基础模型2.5T 练习tokens练习

以英语数据为主,有2048tokens前后文窗口。

包含DCLM在内的数据-BASELINE、ProofPile2StarCoder和Proof

LlamamaMMLU评分接近 3 8B

练习使用PyTorch和OpenLM框架

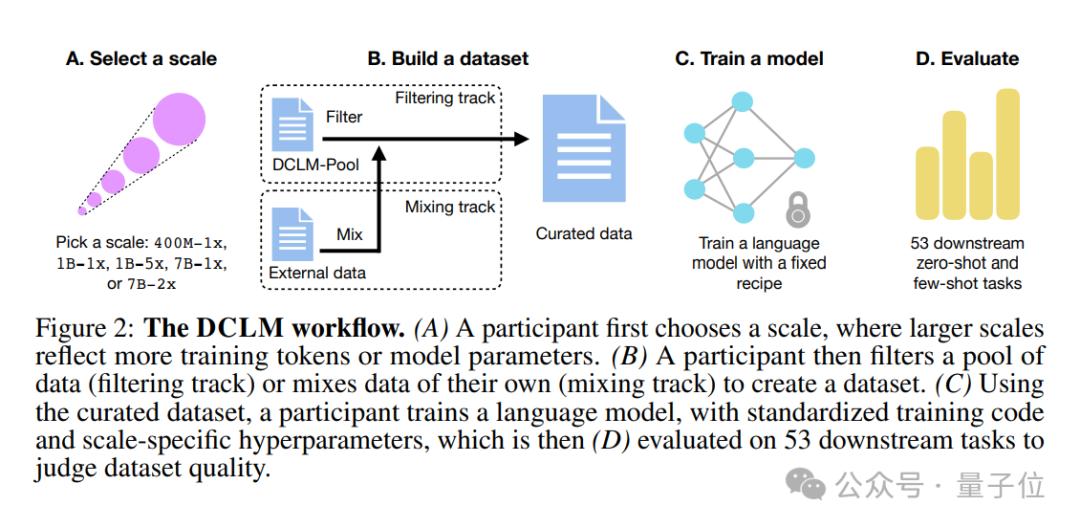

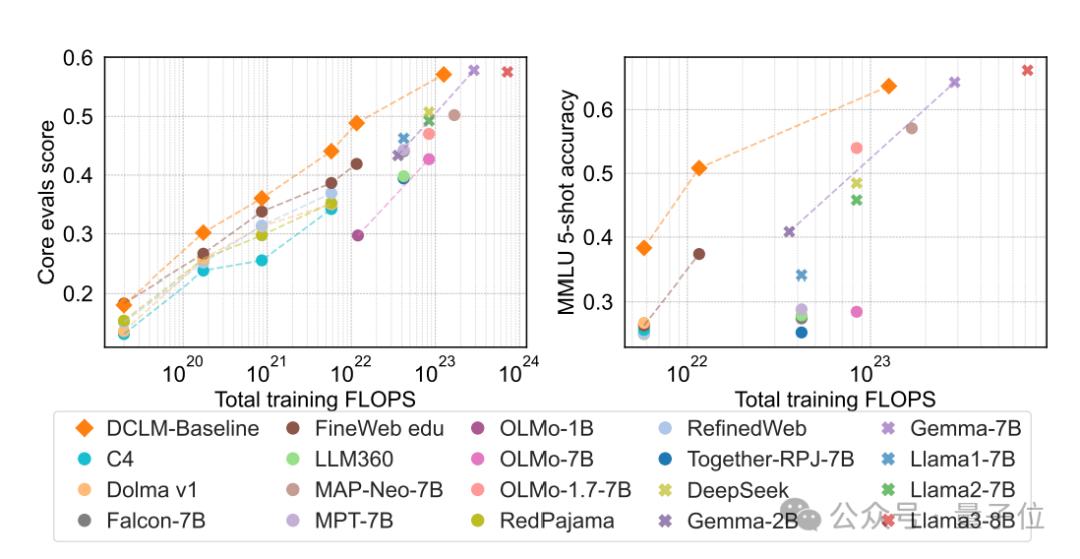

具体而言,研究小组首先提出了一项新的语言模型数据比较标准。 ——DCLM。

之所以提出这个标准,是因为团队发现:

由机器学习 (ML) 建立高质量训练集的关键在于模型从更大的数据集中自动过滤和选择高质量的数据。

所以,团队利用DCLM来设计高质量的数据,尤其是在多模态领域,从而提高模型性能。

它的思路很简单:用一个标准化的框架进行实验,包括固定模型架构、训练代码、超参数和评估,最后找出哪种数据整理策略最适合训练高性能模型。

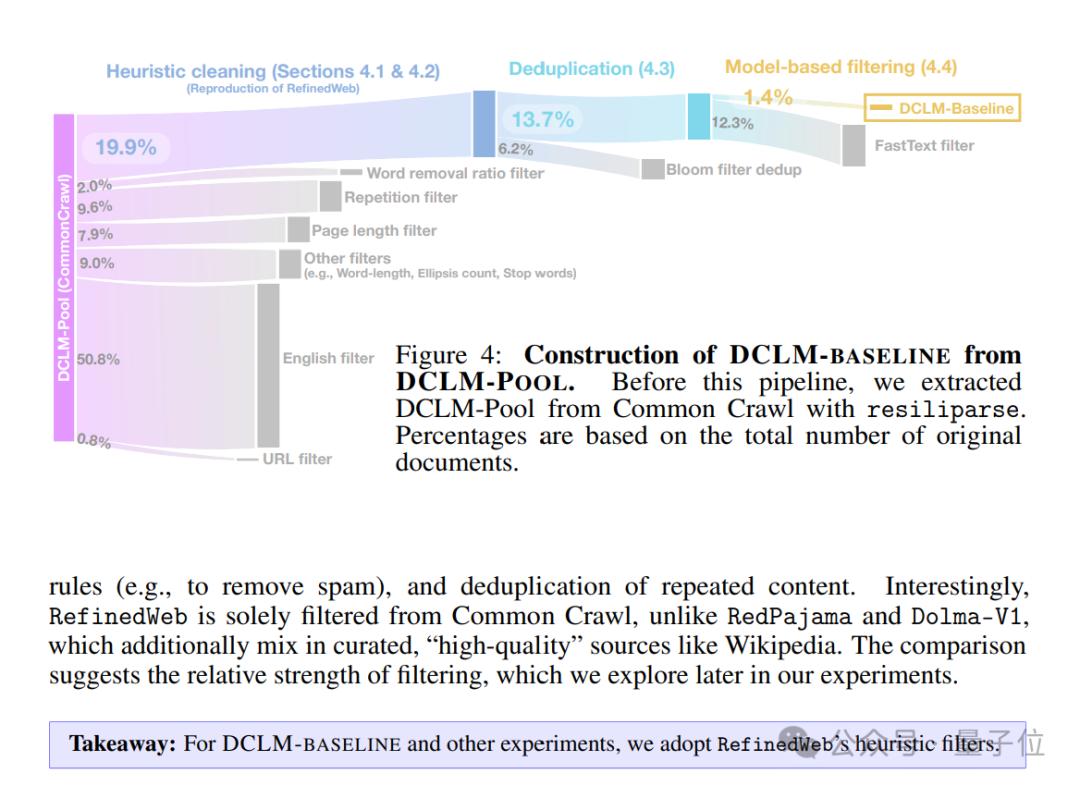

基于以上思路,团队建立了高质量的数据DCLM-BASELINE,并且用它从一开始就训练了一个7B参数模型——DCLM-7B。

DCLM-7B的主要表现如何?

数据显示,它在MMLU标准上的5-shot精度可以达到64%,可以和Mistral-7B-v0.Llamamama(63%) 3 8B(66%)可与Llamamama相媲美;而且在53个自然语言理解任务中的平均表现。 3 与8B相比,所需的计算量只有后者的1/6。

相对于其它同样大小的模型,DCLM-MMLU7B的评分超过Mistral-7B,接近Llamama。 3 8B。

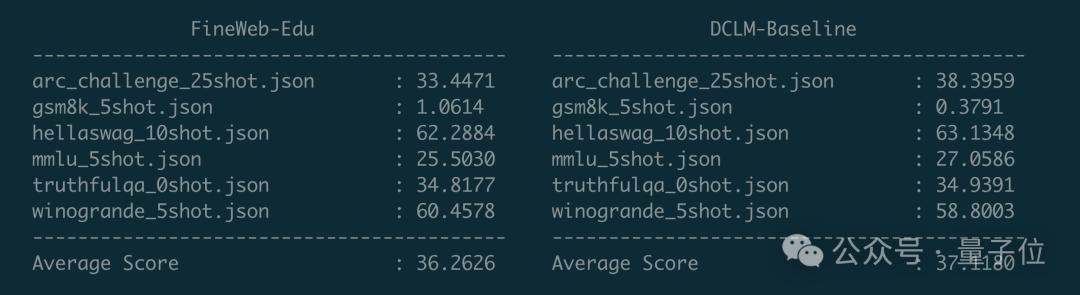

最后,为了测试新的数据效果,有业内人士使用卡帕西的llm.C训练GPT-2 1.5B,对比DCLM-Baseline和FineWeb-这两个数据Edu。

数据显示,DCLM-Baseline在ARC(小学生科学问题推理)中获得了更高的平均分。、HellaSwag(常识推理)、在MMLU等任务中表现更好。

“小”模型成为一种新的趋势

回到开头,“小”模型最近已经成为一种新的趋势。

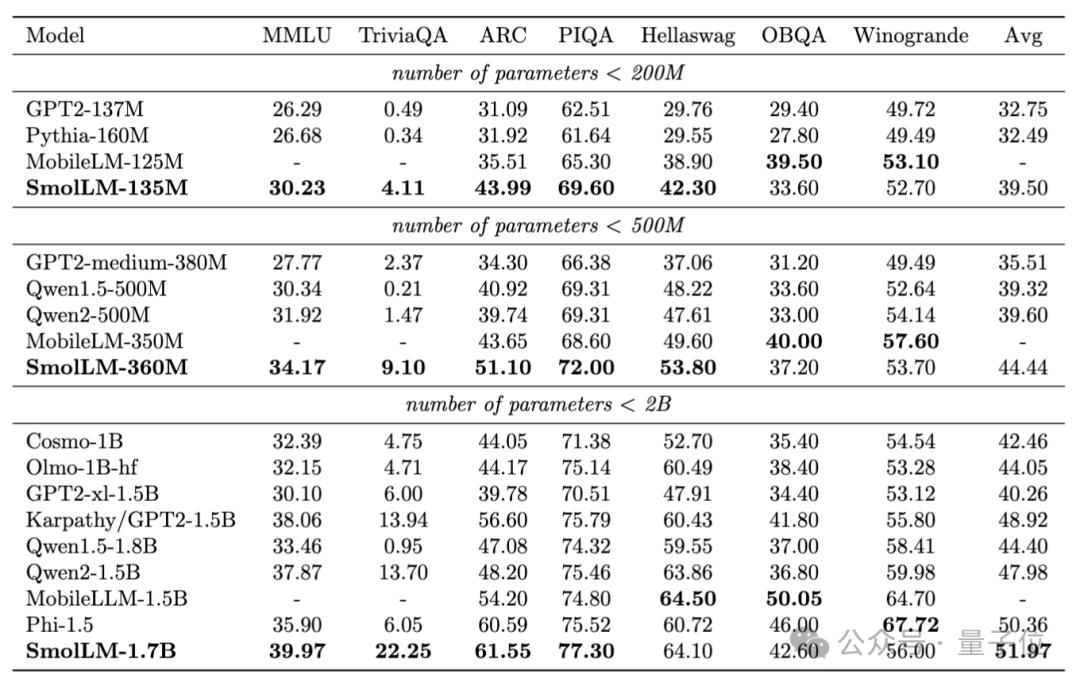

首先,HuggingFace推出了“小模型家族”SmolLM”,包含135M、模型360M和1.7B。

在广泛的推理和常识标准上,他们优于类似的大小模型。

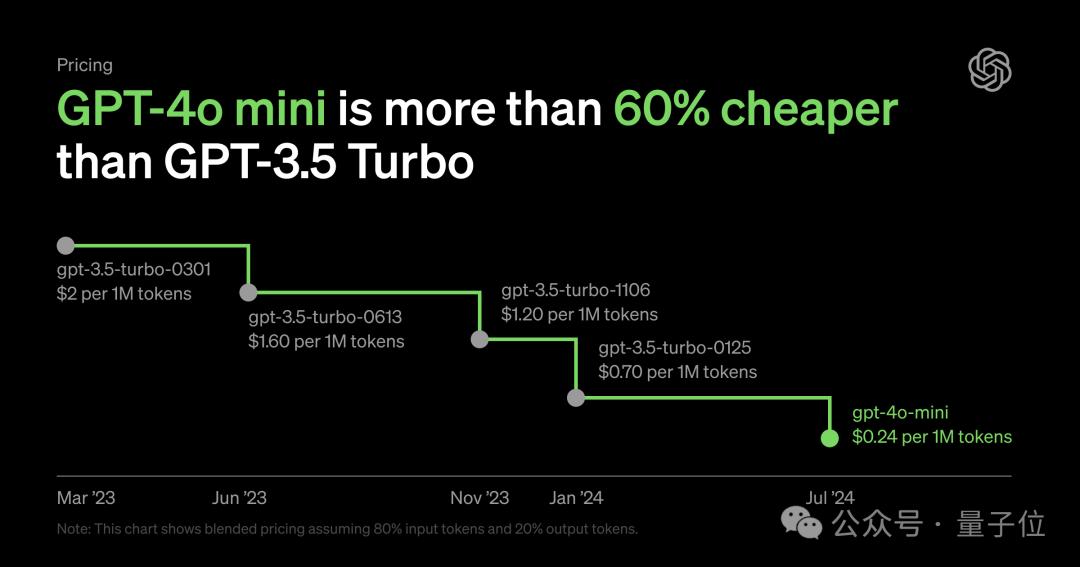

接着OpenAI突然发布了GPT-4o mini,不但能力接近GPT-4,而且价格大幅下降。

GPT-4o就在这里 同一天,mini发布,Mistral AI联合英伟达发布了12B参数小模型——Mistral NeMo。

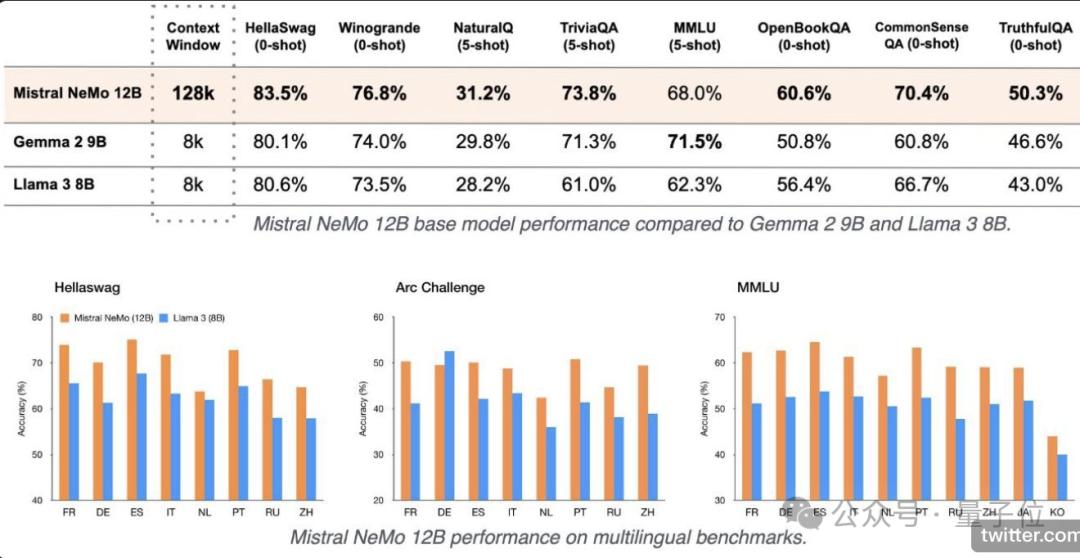

就综合性能而言,Mistral 在多个基准测试中,NeMo击败了Gemma 2 9B和Llama 3 8B。

所以,为什么每个人都开始卷小模型?

也许原因就像smol一样。 AI创始人提醒,虽然模型变小了,但是在能力相近的情况下,小模型大大降低了成本。

正如他提供的这张图片,GPT-4o 以mini为代表的小型号整体价格低于右边。

对于这一点,我等着吃瓜群众be。 like:

所以,你更喜欢哪一个?(欢迎在评论区讨论留言)

模型地址:

https://huggingface.co/apple/DCLM-7B

GitHub:

https://github.com/mlfoundations/dclm

数据地址:

https://huggingface.co/datasets/mlfoundations/dclm-baseline-1.0

参考链接:

[1]https://x.com/Yuchenj_UW/status/1813260100192334108

[2]https://x.com/casper_hansen_/status/1814269340100751382

[3]https://x.com/_philschmid/status/1814274909775995087

[4]https://x.com/LoubnaBenAllal1/status/1813252390692303069

— 完 —

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com