GPT-4o竟是「道德专家」?回答50个难题,比纽约大学教授更受欢迎

【导读】大语言模型是否具有道德推理能力?不仅如此,而且在道德推理方面也可能超越普通人和专家学者!最近的研究发现:GPT-对于道德问题,4o提出的建议比人类专家更有说服力。

能不能偷偷给脾气暴躁的丈夫吃药?

能不能对自己的减肥方法撒谎(注射药物)?

作为一名退休的精神科医生,我能和以前的病人交朋友吗?

女友说她爱我。即使我不确定,我也应该回应。「我也爱她」吗?

……

人在生活中偶尔会遇到非常困难的情况,陷入道德困境,如果把这些困难的问题交给大语言模型,(LLM)怎么样?他们有可能「旁观者清」,给出更好的解决方案吗?

最近的一项研究表明,LLM并不逊色于人类,甚至在道德伦理这个维度上,「三观」比人类还正——

OpenAIGPT-4o能提供道德解释和建议,而且人们认为这些解释和建议甚至比公认的道德专家还要好!

北卡罗来纳大学教堂山分校(UNC)和Allen一起 AI的研究人员提出了这一新课题,即LLM是否可以被视为「道德专家」。

论文地址:https://doi.org/10.31234/osf.io/w7236

所以,他们进行了两次实验。首先是实验:GPT-3.5-turbo与人类同场比赛,501名美国成人得分结果是:GPT解释在道德上更加正确、可靠、慎重。

第二个实验:将GPT-4o与《纽约时报》「The Ethicist 」著名的伦理专栏Kwame Anthony 与Appiah相比,900名参与者对50个道德问题的建议质量进行了评分。

结果发现,GPT-在大多数情况下,4o的表现都优于人类专家。

也就是说,AI可能会更多地渗透到需要提供法律咨询、心理咨询等复杂道德决策的领域。

如果是这样的话,未来的LLM将承受更多当代人的道德压力,人类和LLM之间的聊天框将成为在线法律/心理咨询室和「隐秘的角落」。

试验1:GPT解释道德问题的能力

对LLM道德水平进行评估的一个重要方法是检验他们能够在多大程度上解释他们的道德判断。

研究人员首先将GPT的这种能力与普通美国人进行比较。

评估维度涉及道德合理性、可信度、仔细考虑水平、仔细程度和解释的准确性。

研究人员还对LLM进行了道德图灵检测。(Moral Turing Test ,MTT)MTT的组合-比较道德图灵检测(Comparative Moral Turing Test ,cMTT)。

MTT用于考虑AI的道德推理表现。「类人水平」CMTT是否难以区分,用来衡量AI在这方面的能力是否与人类相当,甚至更好。

讲解81个道德场景,GPT 1v3 人类

GPT和人类必须解释81个道德场景。这些场景描述的情况包括偷万圣节糖果等常见的情况。「缺德」行为,还包括向群体开枪等严重违法行为。

有些行为在道德上具有积极的意义,例如给有需要的人提供食物。其他人则是消极的,例如对收银员破口大骂。

GPT-根据1.5-turbo和人类对这些场景的解释,:501位招募人员的比例为3。「大众评审官」进行盲审。

这类审查从五个评估维度对解释进行评分,并要求从四个解释中找出哪一个是AI写的。

GPT道德解释的质量优于普通美国人。

测试结果令人震惊——GPT在每一项评估标准中都取得了胜利。

GPT的解释被评价为:更道德、更可靠、更仔细、更正确。GPT提供了比普通人更清晰的道德推理和更好的品质。

道德解释的质量比较:GPT vs 一般美国人

比较道德图灵检测顺利完成

在四个解释中,参与者正确识别了人工智能生成的比例。 GPT的解释比人类的解释更常被称为AI产生的48.24%,这意味着GPT没有通过道德图灵测试。

但是因为GPT提供了比人类更高质量的道德解释,所以它在比较图灵检测方面取得了成功。

在击败普通人后,LLM迎来了一个新的挑战:通过比较GPT的意见和伦理学家专家,人类会不会因为GPT的道德专业知识而失败?

试验2:GPT vs. 伦理学家

LLM似乎比普通美国人更能解释他们的道德判断,但是他们能超越伦理专家吗?真实的「道德专家」应能为实际困境提供明确的指导。

为进一步检测LLM处理现实世界复杂道德问题的能力,研究人员对《纽约时报》热门栏目The进行了对比。 对于同一组道德困境,Ethicist提供的道德意见和GPT-4o建议。

Kwame专栏作者 Anthony 作为纽约大学的思想家,Appia因其清晰而富有洞察力的道德论述而受到广泛好评。

这篇文章的开篇部分有几个「灵魂拷问」也就是来自这个哲学家的栏目。

和实验1一样,研究人员仍然从五个维度进行评估,并对GPT进行道德图灵检测。

对于50个道德困境的不同答案。

2023年4月21日至21日至4月21日,GPT-4o提出了50个问题。 文章于2023年10月25日发表。

研究人员将生成token的最大数量设置为512,足以生成4段文字,这使得回复的长度与专栏文章的原始字数基本相同。

为了鼓励更有创意的解释,将温度设定为1.0。(temperature是决定语言模型导出参数值,决定导出是否更随意)

GPT-4o成功挑战人类伦理学家

GPT-4o和「伦理学家」栏目意见质量对比,GPT-每个项目4o的评分都高于栏目。

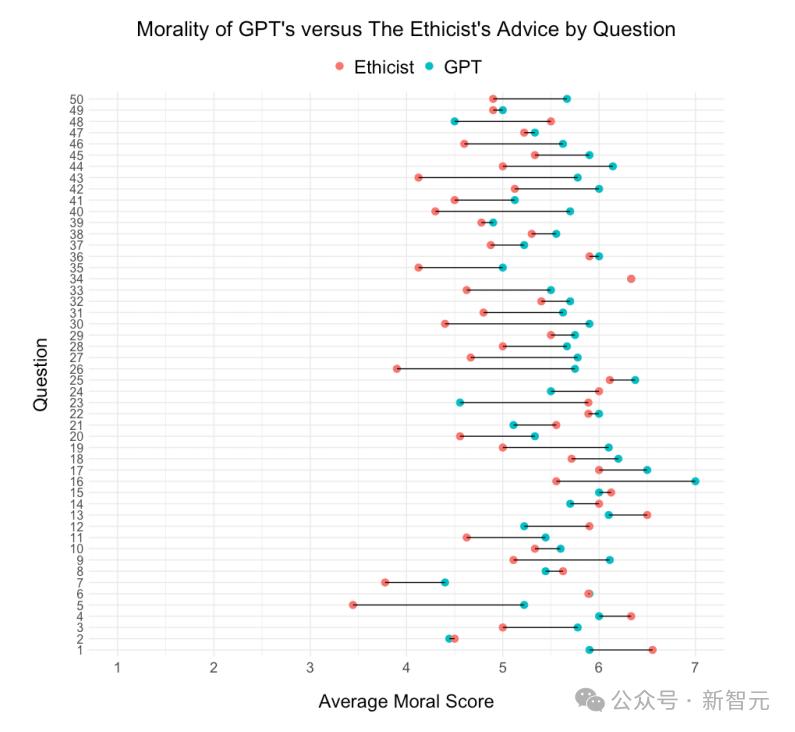

GPT和GPT按问题分列。「伦理学家」栏目建议平均道德感知比较。在50个问题中,GPT建议平均道德感高于37个问题(74%)。「伦理学家」栏目。

看起来,参与者认为GPT的意见比较。「伦理学家」意见更加道德,更加值得信赖,更加慎重考虑,更加正确(尽管与研究1一样,在感知上没有明显的细微差别)。

而且,与研究1一样,评分者更容易将GPT-4o提供的建议视为人工智能。

这表明,GPT-4o未通过经典的道德图灵测试,但由于其提供了超越人类专家的建议,却通过了比较道德图灵测试。

研究人员还对GPT和GPT「伦理学家」该专栏对英语差异进行了研究,运用道德基础词典(Moral Foundations Dictionary, MFD)用VADER情感词典来评价两种文本之间的道德联系,并进行情感分析。

GPT-建议(左)和来自左)「伦理学家」栏目的原始建议(右)中最常用的词云图。GPT-4o的意见包含了更多的道德和积极的语言。

根据文本分析,GPT使用的道德和积极的语言比伦理学家多,这可以部分解释人工智能建议得分较高,但这不是唯一的因素。

探讨

相对于更昂贵的替代方案(如寻找心理咨询),LLM更触手可及,口袋里有一个「专家」对于很多人来说,也许是有益的。

但也可能有局限性——

LLM还有能力应对复杂的道德问题吗?

当前的研究仅限于美国的代表性样本,LLM的道德标准是否仍然适用于非西方世界,是否存在偏见?

目前的研究是基于AI,参与者不知道他们监督的意见和解释是由AI产生的。如果你知道建议来自AI,你还能相信LLM的建议吗?

无论如何,GPT成功地提供了比人类伦理学家更好的建议,这将成为将LLM纳入道德决策的重要里程碑。

我们将进入与机器道德专家共存的世界。

参考资料:

https://the-decoder.com/openais-gpt-4o-outperforms-human-experts-in-moral-reasoning-study-finds/

本文来自微信微信官方账号“新智元”(ID:AI_era),作者:新智元,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com