世界模型概念膨胀:AGI路上的百家争鸣与泡沫

世界模型,已如现实世界般纷乱。

OpenAI称Sora生成的视频是“世界模拟器”;杨立昆(Yann LeCun)则认为Sora是像素幻觉,真正的世界模型应是“预测未来的抽象大脑”;谷歌DeepMind表示Genie3是“可交互的通用世界模型”;李飞飞提出“空间智能”才是正确方向。

现实世界唯一且客观,但AI领域中,似乎人人都在打造自己的“世界模型”。

尽管定义差异巨大,这些争论不休的大佬们在一个基本判断上达成共识:大语言模型终将遇到瓶颈,世界模型是通往AGI的必经之路。

大语言模型在GPT-3.5后经历了参数膨胀,而世界模型在技术路线收敛前,先出现了概念膨胀。

世界模型成筐,万物皆可装入

“世界模型”的混乱,根源在于它是一种目标——让AI具备理解外部世界规律、预测世界变化的能力,而非具体技术路径。

最先混乱的是概念。

世界模型的思想最早可追溯至1943年认知科学家Kenneth Craik提出的“心智模型(Mental Model)”,即大脑通过构建外部世界的微缩模型进行预测,能处理当前信息并预测“若这样做,世界会怎样”。

该理论虽在20世纪90年代被引入强化学习,但真正让它在现代AI领域立足的是Jürgen Schmidhuber等人2018年发表的论文《Recurrent World Models Facilitate Policy Evolution》。这篇论文首次系统定义了神经网络世界模型框架,当时它由视觉组件(VAE)、记忆组件(RNN)和控制器构成,在简单赛车游戏和二维类射击游戏中训练。

七年过去,随着大语言模型爆发,对通用人工智能的渴望让这一概念在近两年快速繁衍。

Yann LeCun在2022年提出以世界模型为核心的“自主智能”,强调通过模块化设计和自监督学习获取抽象表征,并在2023年、2024年先后推出I-JEPA、V-JEPA预测模型。

李飞飞在2024年提出“空间智能”理念,创办World Labs,发布Marble,主张世界模型必须具备生成可交互3D环境的物理一致性能力,“对我而言,空间智能是创造、推理、互动、理解深刻空间世界的能力,无论是二维、三维还是四维,包括动态等所有方面。”

甚至OpenAI前首席科学家Ilya Sutskever提到的“压缩即智能”,本质上也认为只要能无损压缩预测下一个token(无论是文本还是像素),模型内部就构建了世界映射。

一个抽象概念,衍生出更多抽象概念。

若抛开定义争论,从技术方向看,当前世界模型主要分为两大流派,对应两种不同世界观:表征派(Representation)与生成派(Generation)。

Yann LeCun是“表征派”,这是一条不产生画面的极简路线。

类比人脑中的心智模型,我们对世界的预测和行动往往是直觉,而非物理公式或具体画面。基于此,LeCun的世界模型是深藏在系统后端的“大脑”,仅在表征处理后的潜在空间运作,预测“抽象状态”。

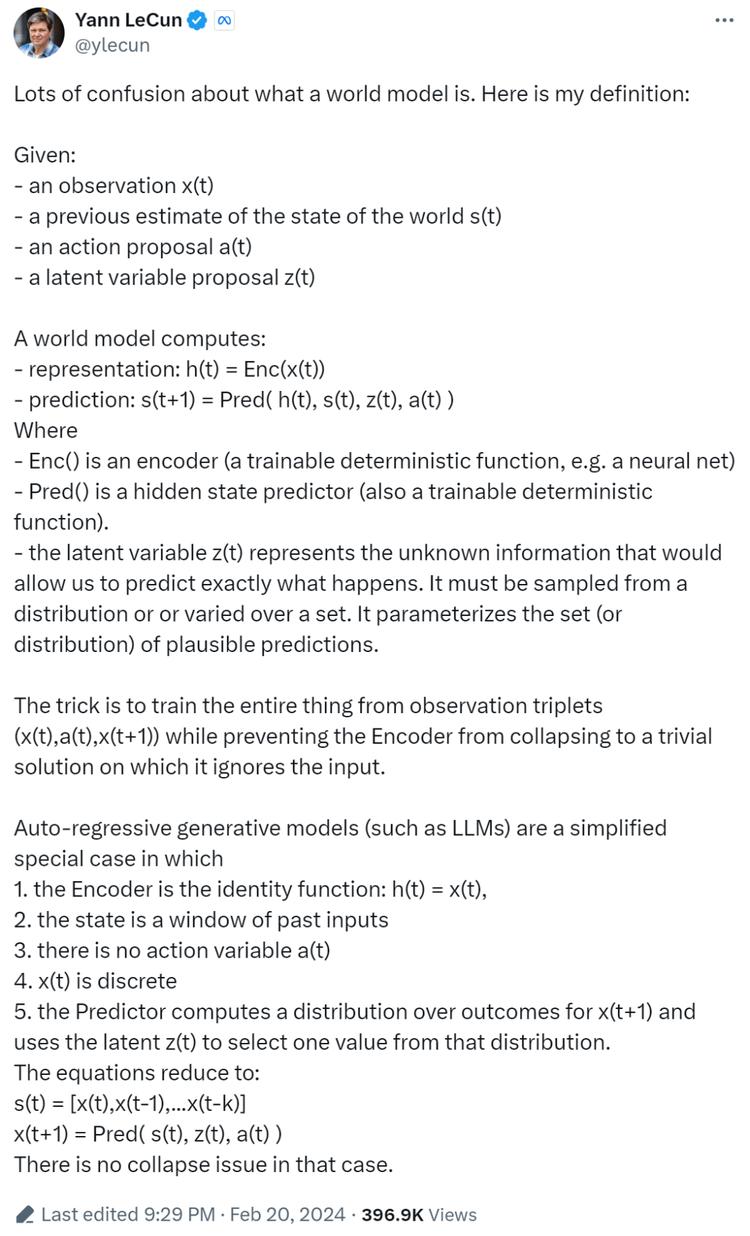

在这条推文中,LeCun明确定义世界模型需同时输入四个变量:对先前世界状态的预估s(t)、当前观察x(t)、当前动作a(t)、潜在变量z(t),结合这四个变量预测下一时刻世界状态s(t+1)。

这个定义有两个关键点:一是世界模型预测下一刻的“状态”而非画面;二是能针对连续动作交互进行因果推断。

比如一辆车开过来,它不会在脑海里画出车牌号和反光,只会计算出“障碍物靠近”这一状态。这种模型不为给人看,只为给机器做决策,追求逻辑上的因果推演,而非视觉逼真。LeCun提出的I-JEPA和V-JEPA,都摒弃了生成式AI“预测每一个像素”的做法,毕竟现实世界充满不可预测的噪音(如树叶纹理),AI不应浪费算力生成这些细节。

第二大流派是目前声量最大的“生成派”,与Yann LeCun最核心的区别在于,他们要重建、模拟视觉世界。

这一派常引用物理学家Richard Feynman的名言:“我若无法创造,便不能理解。”即只要模型能生成正确世界,就证明它懂了世界物理规律。

2024年初,OpenAI介绍Sora时提到它是世界模拟器。OpenAI认为,只要数据量足够大,模型就能通过预测下一帧像素,涌现出对物理规律的理解。通过学习数十亿视频片段,它记住了“人走路时腿会交替”“玻璃杯掉落会破碎”的概率分布。

Sora作为世界模型争议很大,最直接的一点是它无法回应LeCun关于动作与世界状态的因果律——如果模型只能像放电影一样生成视频,而不能回答“如果我踢了这个球,它会怎么飞”这样的动作交互问题,那它可能只是记住了“球飞行的轨迹概率”,而非理解了“力学定律”。

那么,如果视频生成能根据用户动作输入实时预测下一帧呢?

于是,生成派衍生出更进阶的形态:互动式生成视频(Interactive Generative Video),例如Genie3。

和Sora不同,IGV的区别在于实时性、可交互性,即有了动作(Action)。谷歌DeepMind发布的Genie 3,明确定位为「通用目的世界模型」。它允许用户进入场景并互动,支持生成720p分辨率、24fps帧率的实时画面。用户可自由导航,比如以第一人称视角驾驶或探索复杂地形。这意味着模型不仅理解画面,还理解了动作与环境变化的因果关系,尽管目前动作仅限于方向按键的上下左右。

最后是李飞飞主张的“3D空间智能(Spatial Intelligence)”,以World Labs发布的Marble为最新代表。

如果说前两者是处理视频流,那么Marble则试图从底层构建一个持久、可下载的3D环境。

这条路线的技术底座更接近“3D高斯泼溅(3D Gaussian Splatting)”。它不依赖传统网格建模,而是将世界表征为成千上万个漂浮在空间中的彩色模糊小斑点(高斯体)。通过这些微粒聚合,模型能渲染出精美的三维画面,允许用户通过提示词生成、利用内置编辑器自由改造,支持一键导出到Unity等引擎中。

尽管Marble现在离李飞飞提到的空间智能还很远,但能看出她认为达到空间智能的第一步,是先建立一个高精度、物理准确的3D空间。可以总结:区别于Sora,Marble生成的是符合物理规律的3D世界;区别于Genie3,Marble不是实时生成的世界,但精度和还原度更高。

但这些路线的成果,都未达到各自期待的世界模型模样,甚至彼此吵得不可开交,也都有一批拥护者,这导致“世界模型”的概念外延被无限扩大。

如今,凡是涉及环境理解与模拟的上下游工程,不管是具身智能、自动驾驶、游戏视频等结构化垂直领域,还是生成式视频、多模态模型、视频理解、3D模型等技术,甚至做视觉信息压缩的DeepSeek OCR,全都主动或被动地和世界模型挂上了钩。

世界模型越来越像一个筐,啥都能往里装了。

有泡沫也有野心,世界模型是“反LLM中心”叙事

如果仅是技术路线不同,不足以解释为何“世界模型”会在今年井喷。热潮背后,交织着资本焦虑、技术瓶颈以及对AGI的渴望。

我们必须先承认,这里面有巨大泡沫成分。

在创投圈,叙事往往比代码更值钱。当“大语言模型”竞争格局已定,OpenAI、Google等瓜分基础模型天下,后来者和垂直应用开发者急需新故事打动投资人。

“视频生成模型”听起来就是工具软件,天花板有限;但一旦改名叫“世界模型”,瞬间就上升到AGI高度。

这也是当下AI时代一个有趣现象:科研人员大规模下场创办公司,学术与商业发生重叠。

在纯粹科研世界里,所有创新都必须建立在严谨公理之上。若要解决一个问题(如实现AGI),首先必须精准定义这个问题。然而,当Lab变成Company,学术大佬变成CEO,这种原本局限在期刊里的“定义之争”,就被抛到了商业世界。

在科研中,不同路线可以共存;但在创业公司中,资源有限,如果A定义是对的,B公司的几十亿投入可能就打了水漂,一个定义的差异,对应的却是数以亿计的算力投入方向、上下游产业链备货、投资人价值重构。

而当我们抛开定义争夺和炒作,世界模型的兴起,也像是一场“反LLM中心主义”运动。

整个AI行业对大语言模型(LLM)产生了集体性技术焦虑。这种焦虑源于LLM的先天缺陷:它是“离身”(Disembodied)的。LLM在纯文本符号系统中训练,知道“苹果”这个词和“红色”“甜”经常一起出现,但从未真正“看见”过苹果,也无法理解苹果掉在地上的重力加速度,更别提随着数据规模扩大,AI提升的边际效益正在递减。

无论是Ilya Sutskever离职OpenAI后强调的“超越大模型”,还是李飞飞提出的“空间智能”,核心都在于一点:AI需要从学习“人类说的话”,转向学习“世界发生的事”。行业正在从单纯文本处理,转向对物理现实的模拟与交互,因为大家都意识到,通往AGI的最后一块拼图,不在互联网文本数据里,而在真实物理世界中。

只是希望在世界模型真正出现之前,这个词不要先被玩坏了。

本文来自微信公众号“硅星GenAI”,作者:黄小艺,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com