刚刚,DeepSeek开源V3.2-Exp,公开新稀疏注意力机制DSA

2025-09-30

还是熟悉的节奏!在假期前一天,DeepSeek果然搞事了。

DeepSeek Sparse Attention(DSA)稀疏注意力机制

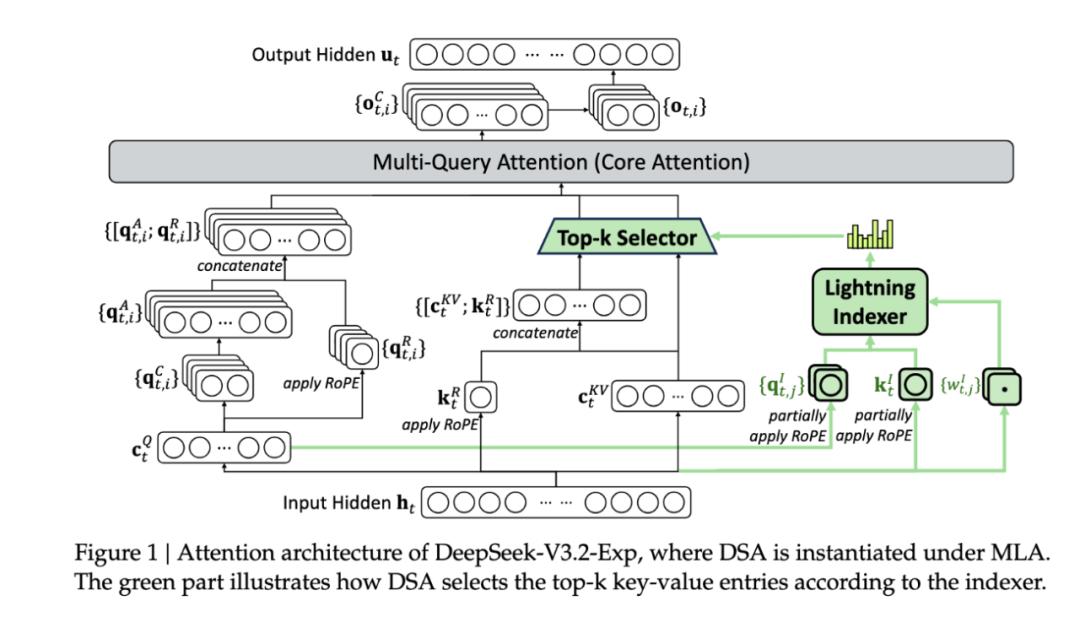

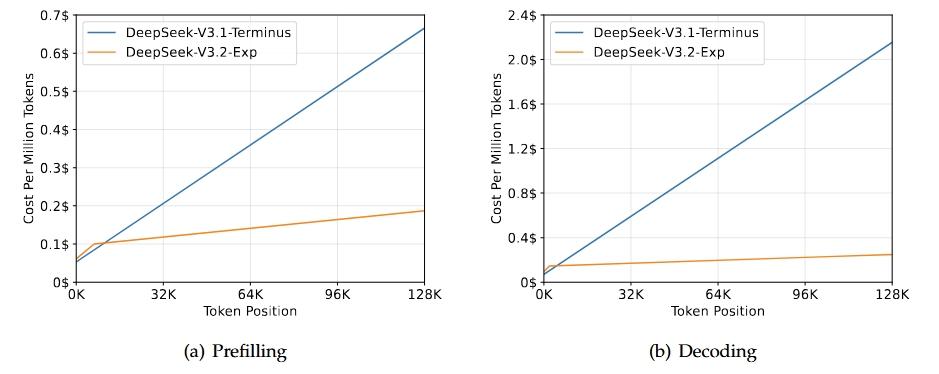

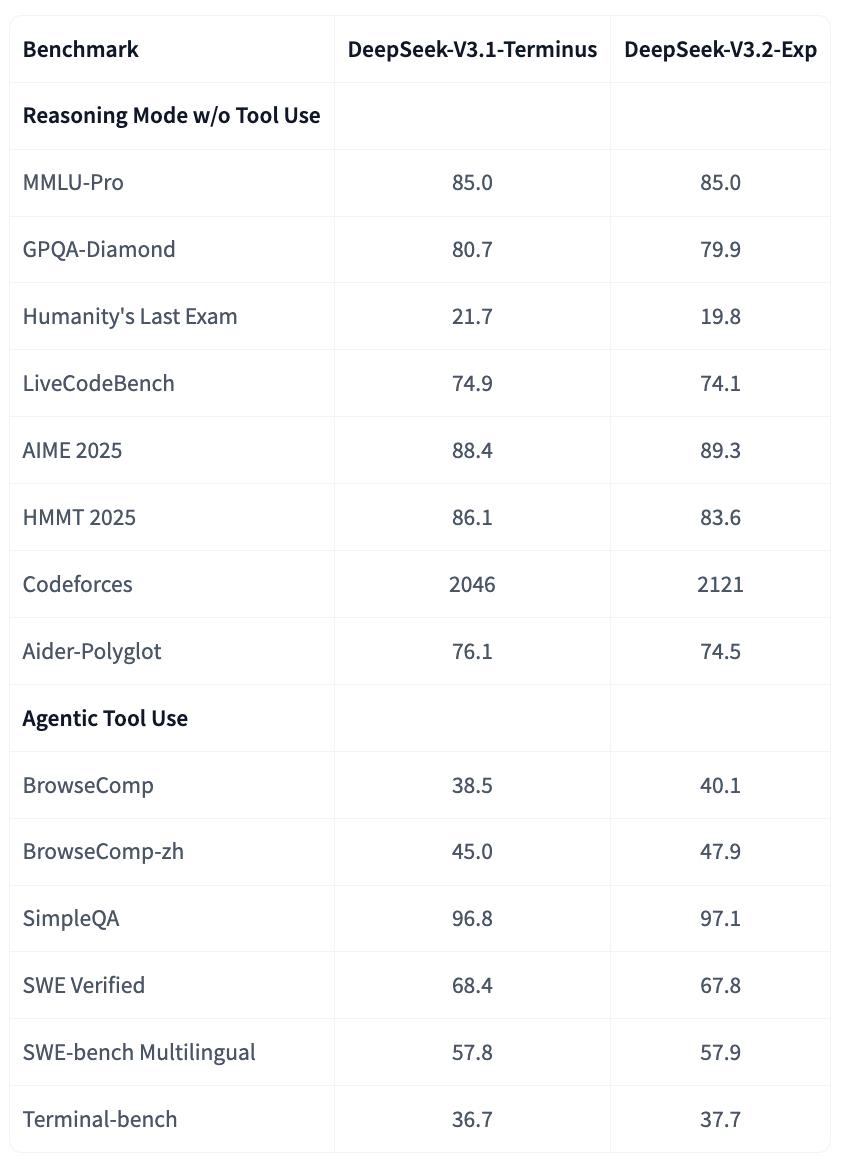

在官方介绍中,DeepSeek表示DeepSeek - V3.2 - Exp是实验版本。作为迈向下一代架构的过渡,V3.2 - Exp在V3.1 - Terminus的基础上引入了DeepSeek稀疏注意力机制(DeepSeek Sparse Attention,DSA)—— 一种旨在探索和验证在长上下文场景下训练和推理效率优化的稀疏注意力机制。DSA也是3.2版本的唯一架构改进。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com